MCP简介

MCP 是一个开放协议,它为应用程序向 LLM 提供上下文的方式进行了标准化。你可以将 MCP 想象成 AI 应用程序的 USB-C 接口。就像 USB-C 为设备连接各种外设和配件提供了标准化的方式一样,MCP 为 AI 模型连接各种数据源和工具提供了标准化的接口。

为什么选择 MCP?

MCP 帮助你在 LLM 的基础上构建代理(agents)和复杂的工作流。LLM 经常需要与数据和工具集成,而 MCP 提供了:

- • 持续增长的预构建集成列表,LLM 可直接使用

- • 灵活切换不同的 LLM 提供商和厂商

- • 在你的基础设施内安全地处理数据的最佳实践

简单来说就是MCP其实就是规范好的function call,并且市面上几乎所有的大模型都支持了mcp协议。可以让开发者自由的调用开发好的mcp协议。

概述

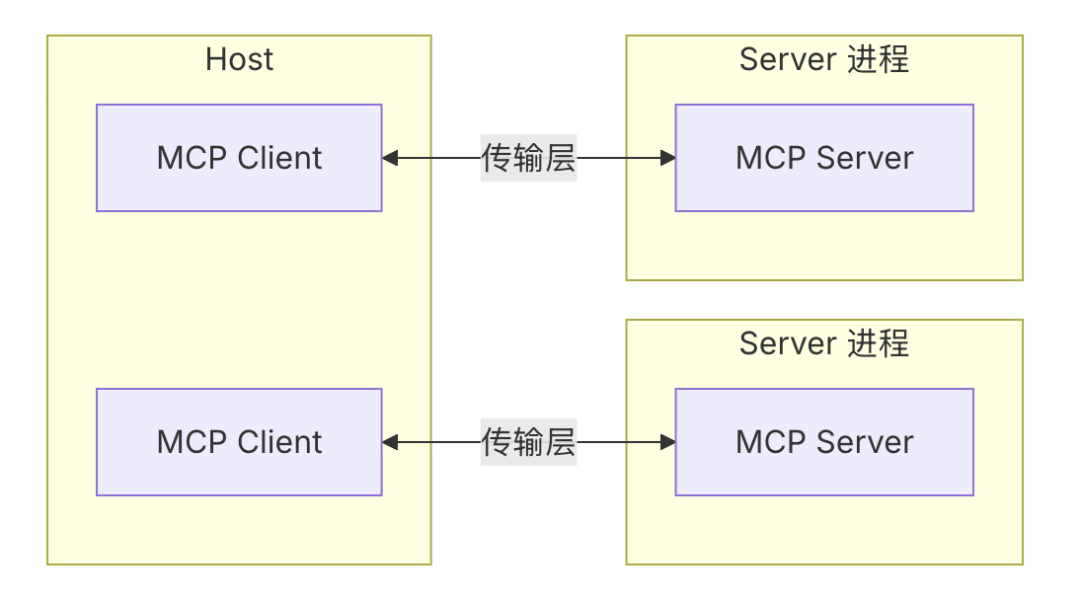

MCP 遵循一个 client-server 架构,其中:

- • Hosts 是 LLM 应用(如 Claude Desktop 或 IDEs),它们发起连接

- • Clients 在 host 应用中与 servers 保持 1:1 的连接

- • Servers 为 clients 提供上下文、tools 和 prompts

概述2

实现

官方提供了python的sdk: https://github.com/modelcontextprotocol/python-sdk

实现步骤:

1、环境

首先我们要安装uv,uv是专门管理python项目的,如果你还没有创建一个uv管理的项目,请创建一个:

我们可以自己创建一个文件夹例如:mcp

uv init mcp-server-demo

cd mcp-server-demo

然后将MCP添加到您的项目依赖关系中:

uv add “mcp[cli]”

或者,对于使用pip作为依赖关系的项目:

pip install “mcp[cli]”

运行独立的MCP开发工具

要使用uv运行mcp命令:

uv run mcp

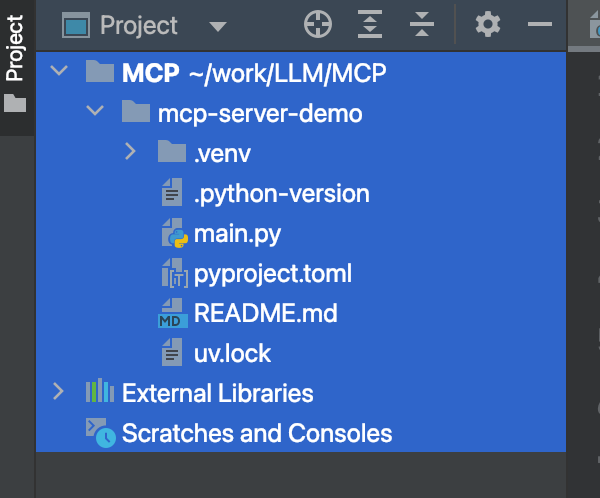

运行完成后你会发现:

目录

目录

它自动创建了这些文件,其中:

python-version :存储你的python版本

main.py 是你的mcp server 主要的实现逻辑

pyproject.toml: 定义项目的基本信息、依赖包、构建方式和执行入口等内容,让 MCP CLI 或构建工具知道“这个项目怎么运行”。

2、快速开始

# server.py

from mcp.server.fastmcp import FastMCP

# Create an MCP server

mcp = FastMCP("Demo")

# Add an addition tool

@mcp.tool()

def add(a: int, b: int) -> int:

"""Add two numbers"""

return a + b

# Add a dynamic greeting resource

@mcp.resource("greeting://{name}")

def get_greeting(name: str) -> str:

"""Get a personalized greeting"""

return f"Hello, {name}!"

if __name__ == '__main__':

mcp.run(transport='stdio')

我们暴露了两个功能 一个是实现 两数相加,另一个是根据你输入的名字,打招呼。

我们将这一段代码覆盖到main.py中。

注:

1、一定需要写main方法,然后根据指定输入通道(stdio)。我们这里用stdio

2、在工具实现的过程中,注释非常重要。LLM就是根据注释来判断是否需要调用这个tool

然后我们需要一个client

client

这里我推荐 cherry client

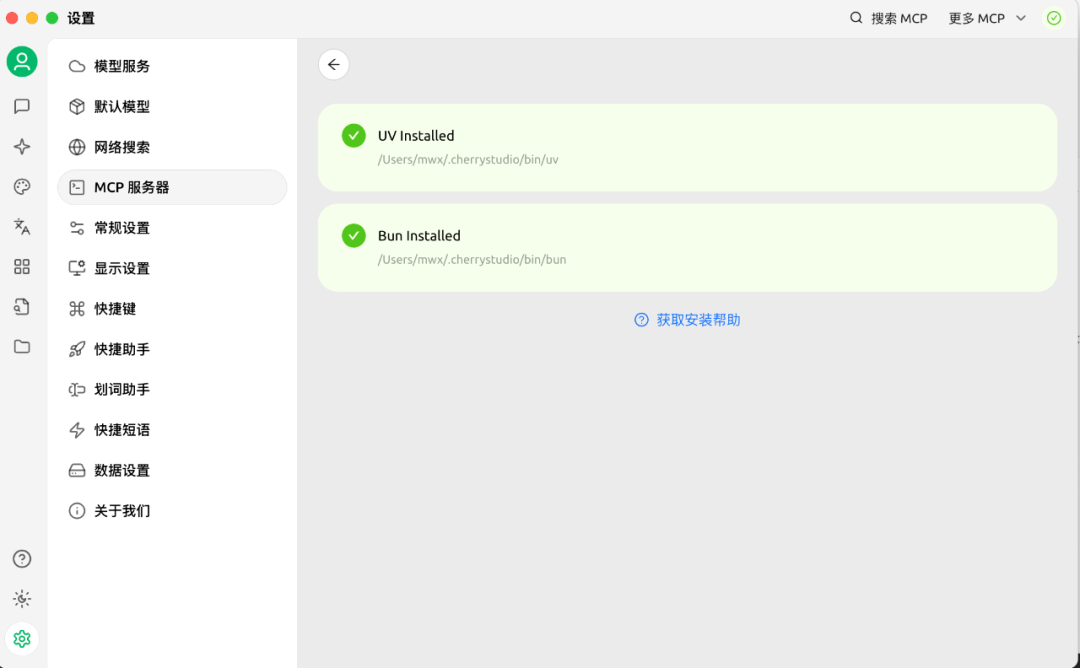

cherry设置1

1、首先我们点开设置中的mcp服务器。右上角有一个红色的三角。让他自动安装,直到变绿为止。

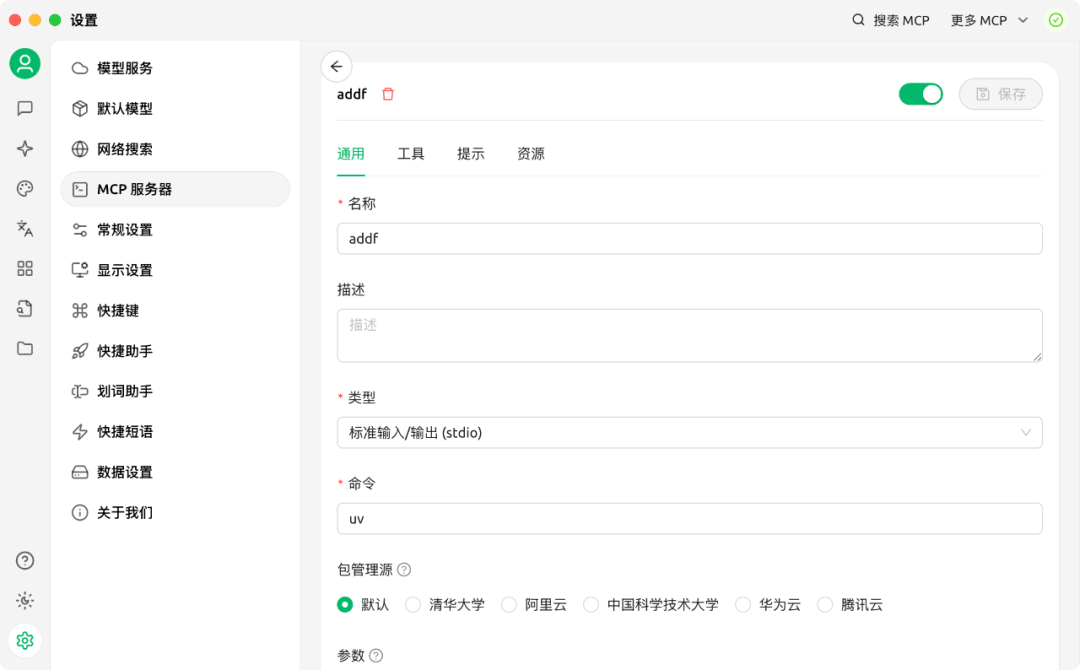

mcp设置2

2、我们新建一个mcp服务,其中

名称: 随便写一个

类型: 需要和代码的匹配上,填写stdio

命令: 这里选择 uv (不要写uvx) uv主要是启动 MCP 服务(server)

uvx是执行 MCP 客户端 / 工具脚本

参数:--directory

/U/PATH

run

main.py

参数需要注意:

每一行都只填写一个单词

window的path一个/就够了

这里的path填写你自己代码的位置

3、最后点击保存,直到右边按钮变绿为止。

验证

cherry会话

我们设置一个新会话,选择我们刚刚建好的内容

行都只填写一个单词

window的path一个/就够了

这里的path填写你自己代码的位置

3、最后点击保存,直到右边按钮变绿为止。

cherry会话

我们设置一个新会话,选择我们刚刚建好的内容

然后在运行过程中,你会发现大模型调用了我们的mcp输出了答案。

大模型岗位需求

大模型时代,企业对人才的需求变了,AIGC相关岗位人才难求,薪资持续走高,AI运营薪资平均值约18457元,AI工程师薪资平均值约37336元,大模型算法薪资平均值约39607元。

掌握大模型技术你还能拥有更多可能性:

• 成为一名全栈大模型工程师,包括Prompt,LangChain,LoRA等技术开发、运营、产品等方向全栈工程;

• 能够拥有模型二次训练和微调能力,带领大家完成智能对话、文生图等热门应用;

• 薪资上浮10%-20%,覆盖更多高薪岗位,这是一个高需求、高待遇的热门方向和领域;

• 更优质的项目可以为未来创新创业提供基石。

可能大家都想学习AI大模型技术,也想通过这项技能真正达到升职加薪,就业或是副业的目的,但是不知道该如何开始学习,因为网上的资料太多太杂乱了,如果不能系统的学习就相当于是白学。为了让大家少走弯路,少碰壁,这里我直接把全套AI技术和大模型入门资料、操作变现玩法都打包整理好,希望能够真正帮助到大家。

读者福利:如果大家对大模型感兴趣,这套大模型学习资料一定对你有用

零基础入门AI大模型

今天贴心为大家准备好了一系列AI大模型资源,包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

有需要的小伙伴,可以点击下方链接免费领取【保证100%免费】

1.学习路线图

如果大家想领取完整的学习路线及大模型学习资料包,可以扫下方二维码获取

👉2.大模型配套视频👈

很多朋友都不喜欢晦涩的文字,我也为大家准备了视频教程,每个章节都是当前板块的精华浓缩。(篇幅有限,仅展示部分)

大模型教程

👉3.大模型经典学习电子书👈

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。(篇幅有限,仅展示部分,公众号内领取)

电子书

👉4.大模型面试题&答案👈

截至目前大模型已经超过200个,在大模型纵横的时代,不仅大模型技术越来越卷,就连大模型相关的岗位和面试也开始越来越卷了。为了让大家更容易上车大模型算法赛道,我总结了大模型常考的面试题。(篇幅有限,仅展示部分,公众号内领取)

大模型面试

**因篇幅有限,仅展示部分资料,**有需要的小伙伴,可以点击下方链接免费领取【保证100%免费】

**或扫描下方二维码领取 **

13万+

13万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?