原作者:归来仍是少年

在大模型技术实际部署时,一个极具实践价值的核心问题在于:当前输出效果未达预期,究竟源于Prompt设计缺陷,还是模型固有能力的局限?

这一判断至关重要,它将直接影响后续技术路线的选择——是聚焦于Prompt优化、采用CoT(思维链)或RAG(检索增强生成)技术,还是需要投入成本进行SFT(监督微调)乃至RLHF(基于人类反馈的强化学习)。

一、先问自己:你的任务真的需要微调吗?

很多人一遇到问题就考虑微调,但实际80%的情况,通过prompt工程结合RAG和CoT技术完全能够应对。微调并非普适方案,其应用范围有严格界定。

行业实践表明,以下任务通常无需微调:

通用问答(如客服FAQ、知识检索):依赖RAG实时获取最新数据即可。

结构化输出(如JSON、表格):设计明确的prompt模板并辅以少量示例即可保证稳定性。

多步推理(如数学推导、逻辑分析):CoT或Self-Consistency等方法效果突出。

风格适配(如邮件撰写、文案生成):少量示例搭配system prompt足以胜任。

而必须微调的场景通常具备以下特征:

专业术语密集(如医疗、法律、金融领域):模型对专业术语的理解易出现偏差。

定制化输出格式(如特定协议、内部DSL):通用模型难以满足格式要求。

严格行为约束(如拒绝特定请求、强制引用来源):仅靠prompt容易失效。

高性能需求(低延迟、高吞吐):RAG或复杂prompt会显著影响响应速度。

因此,首要步骤是明确任务是否属于“必须微调”的范畴。

最近两年,大家都可以看到AI的发展有多快,我国超10亿参数的大模型,在短短一年之内,已经超过了100个,现在还在不断的发掘中,时代在瞬息万变,我们又为何不给自己多一个选择,多一个出路,多一个可能呢?

与其在传统行业里停滞不前,不如尝试一下新兴行业,而AI大模型恰恰是这两年的大风口,整体AI领域2025年预计缺口1000万人,其中算法、工程应用类人才需求最为紧迫!

学习AI大模型是一项系统工程,需要时间和持续的努力。但随着技术的发展和在线资源的丰富,零基础的小白也有很好的机会逐步学习和掌握。【点击蓝字获取】

【2025最新】AI大模型全套学习籽料(可白嫖):LLM面试题+AI大模型学习路线+大模型PDF书籍+640套AI大模型报告等等,从入门到进阶再到精通,超全面存下吧!

二、如何系统评估 prompt 是否还有优化空间?

假设你的任务确实复杂,但还不确定是否该微调。这时候可以做以下几件事:

1. 构建“prompt 梯度测试”

不要只写一个 prompt 就下结论。你应该设计一个prompt 演进序列:

-

Baseline:最简单的指令(如“请回答以下问题”)

-

加 system prompt(如“你是一个严谨的金融分析师”)

-

加 few-shot 示例(2~5 个高质量样例)

-

加 CoT 引导(如“请逐步推理”)

-

加输出约束(如“请用 JSON 格式,字段包括…”)

然后在同一个测试集上跑这 5 个版本,看准确率/一致性是否显著提升。

以"从法律文书中识别核心条款"任务为例,基础prompt的准确率可能仅达到60%,但引入3个典型示例结合推理步骤(CoT)后,准确率可跃升至85%。此时进一步优化模型的收益空间已显著缩小。

2. 检查模型是否“知道但不说”

有时候模型其实具备知识,但没被 prompt 激活。你可以用“探测性提问”验证:

- 先问:“你知道 XX 概念吗?” → 如果回答“知道”,说明知识存在。

- 再问具体任务 → 如果答错,说明是 prompt 引导问题,不是能力问题。

3. 对比不同基座模型的表现

建议使用相同prompt在Qwen、DeepSeek、LongCat-Flash、GPT-4等模型上进行测试。

若所有模型表现不佳,则可能是prompt设计存在问题(例如任务描述不够清晰或缺乏约束条件)。

若仅目标模型表现较差,而GPT-4能完成任务,则表明基础模型能力存在局限,可能需要通过微调或更换更强大的基础模型来提升性能。

对于需要处理复杂指令的任务(如工具调用或多轮交互),LongCat-Flash 这类 MoE 架构模型展现出显著优势。

其总参数规模达 560B(激活参数约 27B),在 IFEval 测试中指令遵循得分高达 89.65%,性能超越 GPT-4.1。建议优先尝试此类强基座模型,而非直接进行微调。

三、RAG 和 CoT 能替代微调吗?

很多人忽略了 RAG 和 CoT 的潜力。

RAG 适合解决“知识缺失”问题:

当业务数据持续动态更新时(如每日新增),模型无法实现全量记忆存储。此时通过向量库检索相关片段并辅助生成,其效果显著优于微调方案(后者会因数据时效性导致性能下降)。

CoT 适合解决“推理链断裂”问题:

面对数学推导、逻辑分析或代码编写等任务,强制模型展示分步思考过程可显著提升结果准确性。研究数据表明,采用CoT微调(基于含推理链的训练数据)的效果优于传统SFT方法。

典型实证案例:AIME数学竞赛题测试中,LongCat-Flash的avg@10指标为61.25,逼近Qwen3 MoE的68.33,并大幅领先GPT-4.1的32.00。

该成绩源于其多阶段训练中对推理能力的专项强化,特别是CoT数据的有效注入。

因此,在实施微调前需明确:

当前问题属于知识不足?推理能力欠缺?还是行为约束缺失?

- 缺知识 → 用 RAG

- 缺推理 → 用 CoT / Self-Ask

- 缺行为约束 → 才考虑微调

四、什么时候微调是不可避免的?

当同时满足以下所有条件时,微调才具备实际投入价值:

任务具有高度专业性

例如医疗诊断、法律条文解析等场景,通用模型极易出现"权威性错误"(即看似专业实则谬误)。

Prompt优化已到瓶颈

即使采用10组few-shot示例、CoT推理链或RAG增强,准确率仍无法突破70%阈值。

有优质标注数据

需准备数百至数千条经过严格清洗的input-output配对数据。

对响应延迟要求严苛

RAG的检索-生成流程耗时过长,无法满足实时业务需求。

此时建议采取以下策略:

监督微调(SFT):高效适配领域知识输出规范

偏好优化(DPO/RLHF):强化人类价值观对齐(如内容安全、表达自然度)

注意:微调可能引发过拟合、知识遗忘、推理延迟增加等风险,必须通过A/B测试验证效果。

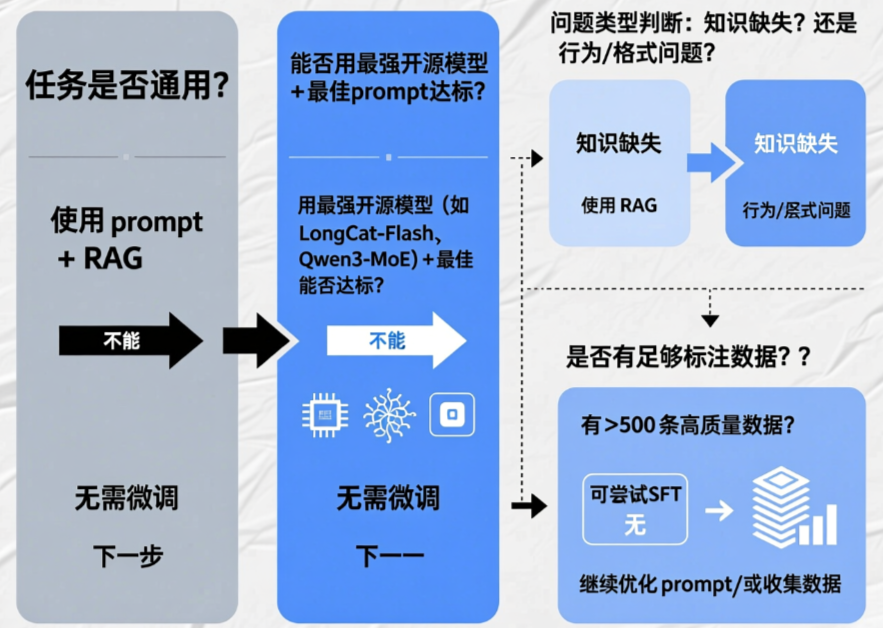

五、一个实用决策流程图(文字版)

六、代码示例:如何自动化评估 prompt 效果

下面是一个简单的 Python 脚本框架,用于批量测试不同 prompt 的效果:

from openai import OpenAI

import json

client = OpenAI(api_key="your-api-key", base_url="https://api.longcat.ai/v1")

test_cases = [

{"input": "从以下合同中提取甲方名称:...", "expected": "XX公司"},

# ... 更多样例

]

prompts = {

"baseline": "请提取甲方名称:{text}",

"cot": "请逐步分析合同内容,然后提取甲方名称:{text}",

"few_shot": """示例1:

合同:甲方为ABC科技,乙方为XYZ集团。

输出:ABC科技

示例2:

合同:本协议由甲方(123有限公司)与乙方签署。

输出:123有限公司

请提取甲方名称:{text}"""

}

def evaluate_prompt(prompt_template):

correct = 0

for case in test_cases:

response = client.chat.completions.create(

model="longcat-flash-chat",

messages=[{"role": "user", "content": prompt_template.format(text=case["input"])}]

)

pred = response.choices[0].message.content.strip()

if case["expected"] in pred: # 简单包含判断,实际可用更严谨的匹配

correct += 1

return correct / len(test_cases)

for name, tmpl in prompts.items():

acc = evaluate_prompt(tmpl)

print(f"{name}: {acc:.2%}")

通过这个脚本,你可以量化不同 prompt 策略的效果,避免“感觉不好就微调”的误区。

结语

当前大模型的性能表现已显著提升,以LongCat-Flash为代表的MoE架构为例,其仅需激活27B参数即可在agentic任务中实现优于GPT-4.1的效果。这一现象揭示了一个关键事实:

多数被视为需要微调的场景,本质上是Prompt设计不当所致。

建议优先充分探索Prompt工程、RAG、CoT等无需训练成本的解决方案。仅当上述方法均无效,且具备充足数据与清晰目标时,微调才是最优解。

毕竟,最好的微调,是不用微调。

最近两年,大家都可以看到AI的发展有多快,我国超10亿参数的大模型,在短短一年之内,已经超过了100个,现在还在不断的发掘中,时代在瞬息万变,我们又为何不给自己多一个选择,多一个出路,多一个可能呢?

与其在传统行业里停滞不前,不如尝试一下新兴行业,而AI大模型恰恰是这两年的大风口,整体AI领域2025年预计缺口1000万人,其中算法、工程应用类人才需求最为紧迫!

学习AI大模型是一项系统工程,需要时间和持续的努力。但随着技术的发展和在线资源的丰富,零基础的小白也有很好的机会逐步学习和掌握。【点击蓝字获取】

【2025最新】AI大模型全套学习籽料(可白嫖):LLM面试题+AI大模型学习路线+大模型PDF书籍+640套AI大模型报告等等,从入门到进阶再到精通,超全面存下吧!

23万+

23万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?