1. 概述

官网:DeepSeek

聊天:DeepSeek - 探索未至之境,有APP。(微信登录)

DeepSeek R1在2025年1月20日发布,并同步开源模型权重。遵循 MIT License,允许用户通过蒸馏技术借助 R1 训练其他模型。上线 API,对用户开放思维链输出,通过设置 model='deepseek-reasoner' 即可调用。

具体可以详见:首次调用 API | DeepSeek API Docs

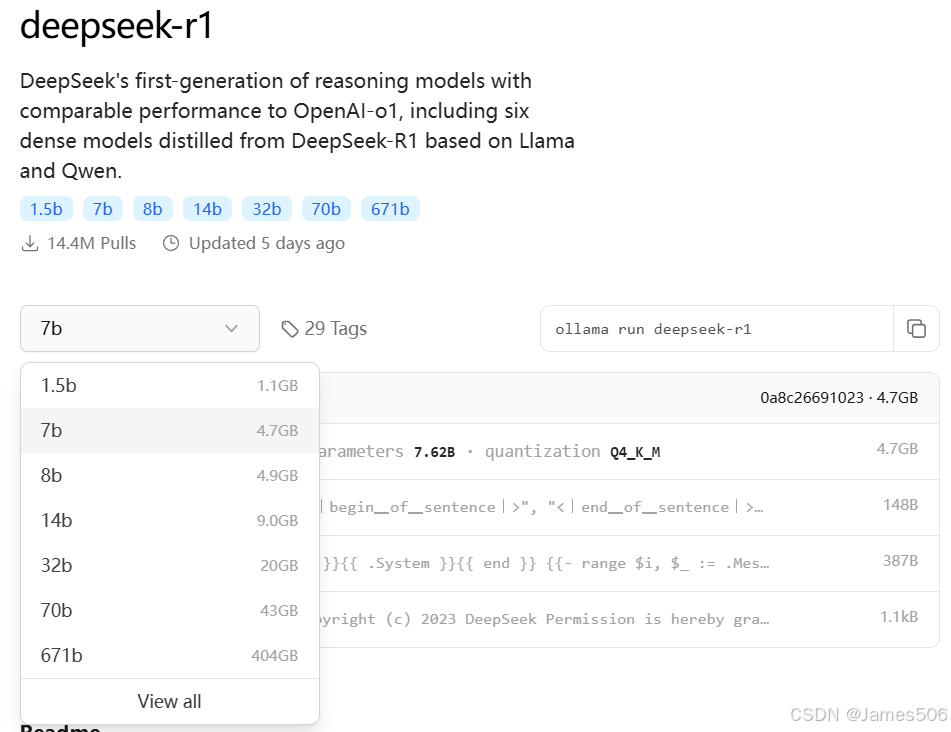

DeepSeek的模型下载,可以在 ollama、modelscope、HF等查找,均可下载。

本文主要以 ollama为例处理。ollama上模型:deepseek-r1

2. 部署实施

2.1 环境安装

具体请参考相关《ollama使用详解_ollama 使用详解-优快云博客》、《OneAPI使用初步_oneapi github-优快云博客》、《Dify使用-优快云博客》等文章。

2.2 模型下载

通过 ollama处理:

选择自己合适的模型:

# DeepSeek-R1-Distill-Qwen-7B

ollama run deepseek-r1:7b等待下载完毕,运行起来,这样就ok了。

2.3 模型配置

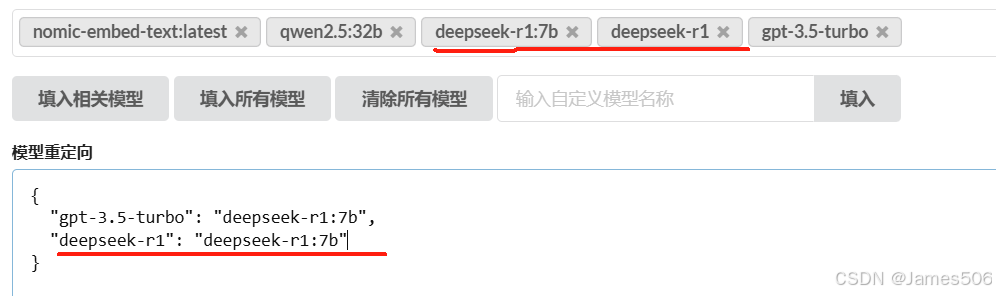

在oneapi中,新建ollama渠道,并输入deepseek模型,并且可以重定向命名。

2.4 模型使用

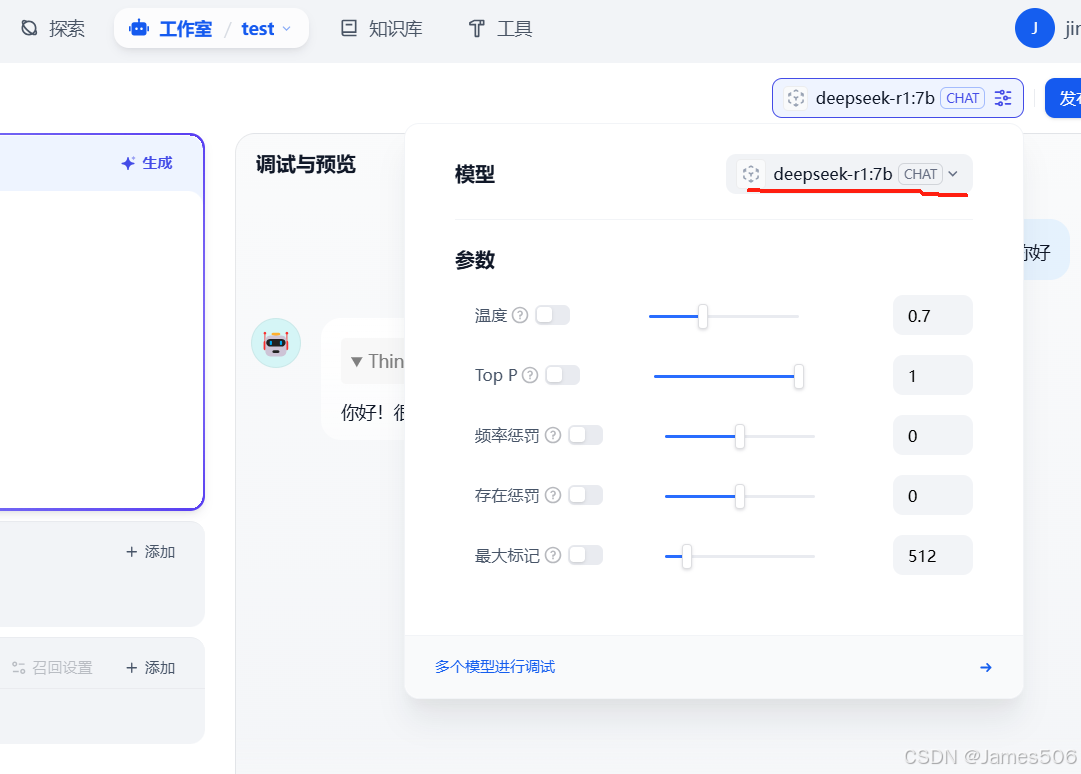

在Dify中,通过设置,在模型供应商中,添加oneAPI的deepseek-r1模型。

然后新建一个聊天助手,选择deepseek-r1模型,可以对相关参数进行设置,这样就可以对话了。

3. 蒸馏模型推理算力需求

影响AI推理(Inference)场景GPU算力需求的主要因素:模型参数规模、计算精度(BF16/FP8/INT8/INT4)、输入出上下文长度、并发用户数、延迟要求(TTFT/TPOT)推理框架的效率等。下面的表格供参考:

(待续,后面会继续更新deepseek的多模态模型处理)

附:《DeepSeek从入门到精通-清华大学》下载:

链接: https://pan.baidu.com/s/1msvBeeQGxNsaiWrxl1UO4g?pwd=nfb5

2944

2944

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?