三、梯度下降

1、步骤

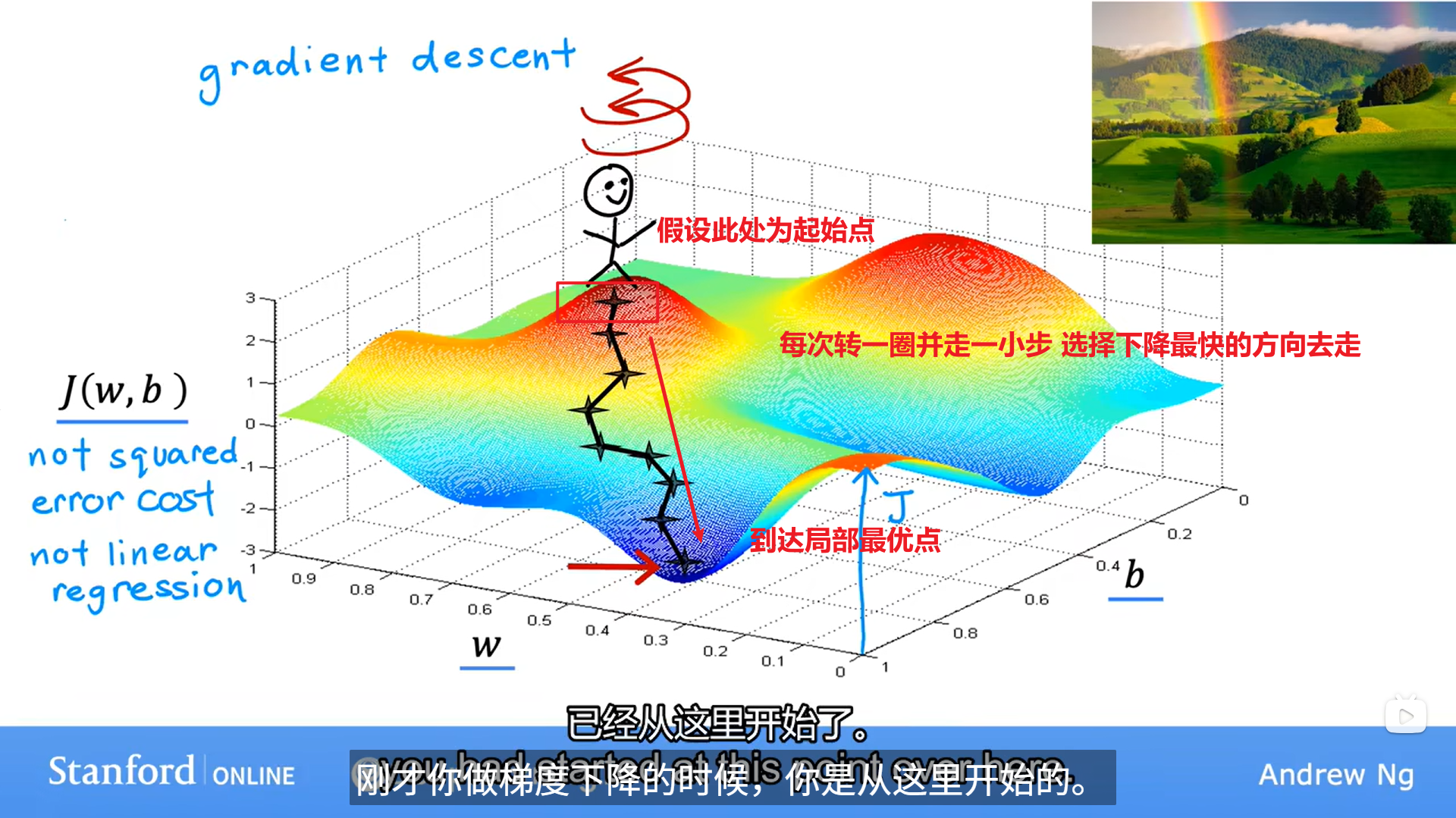

有了J(w,b) ,这个损失函数不只是限于线性回归,对于其他函数也一样,只要是目的是为了寻找最小的J下的w和b即可。

当然有些函数可以不止一个最小值,那怎么办?

那如果起始点不在这里呢

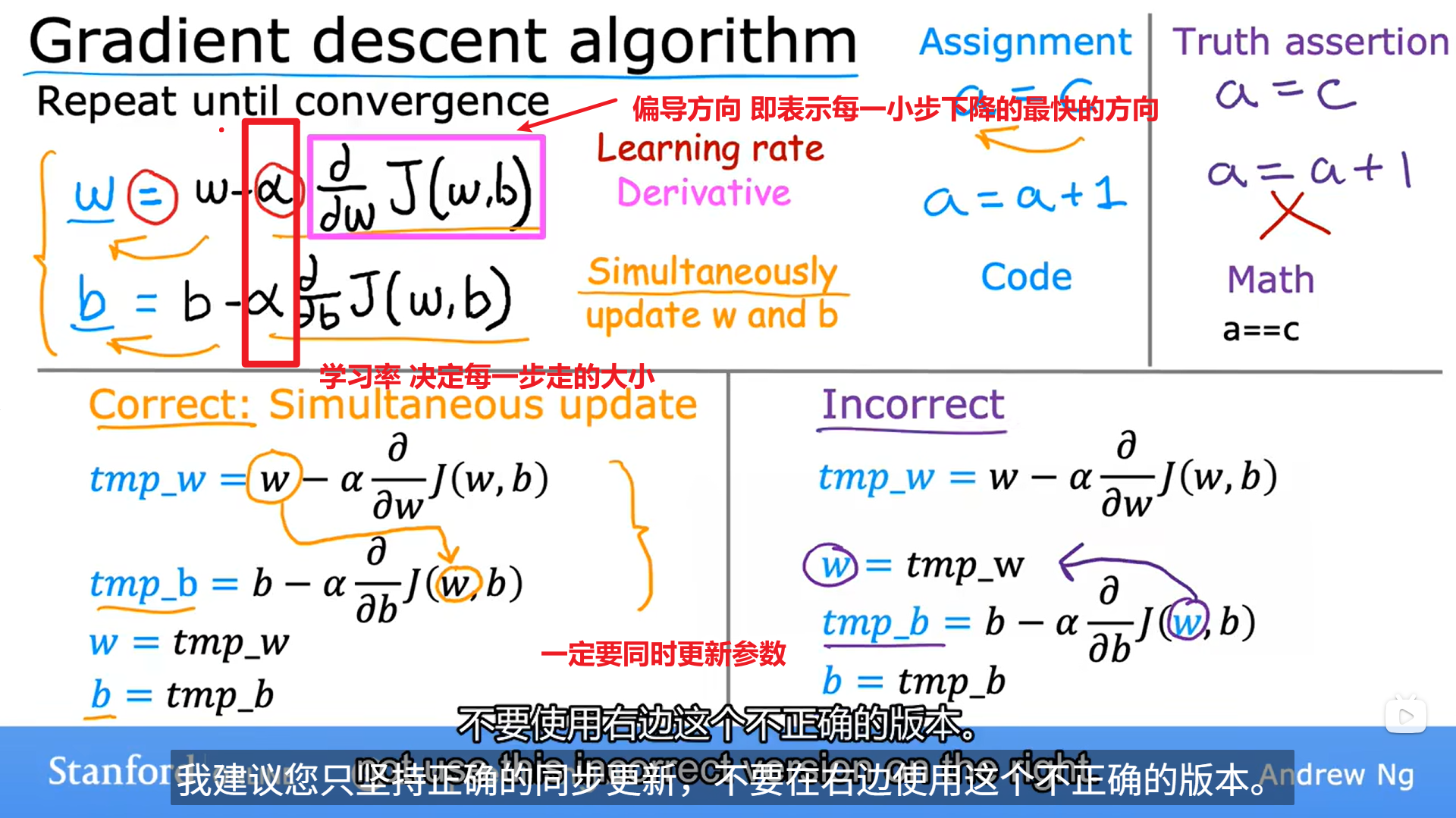

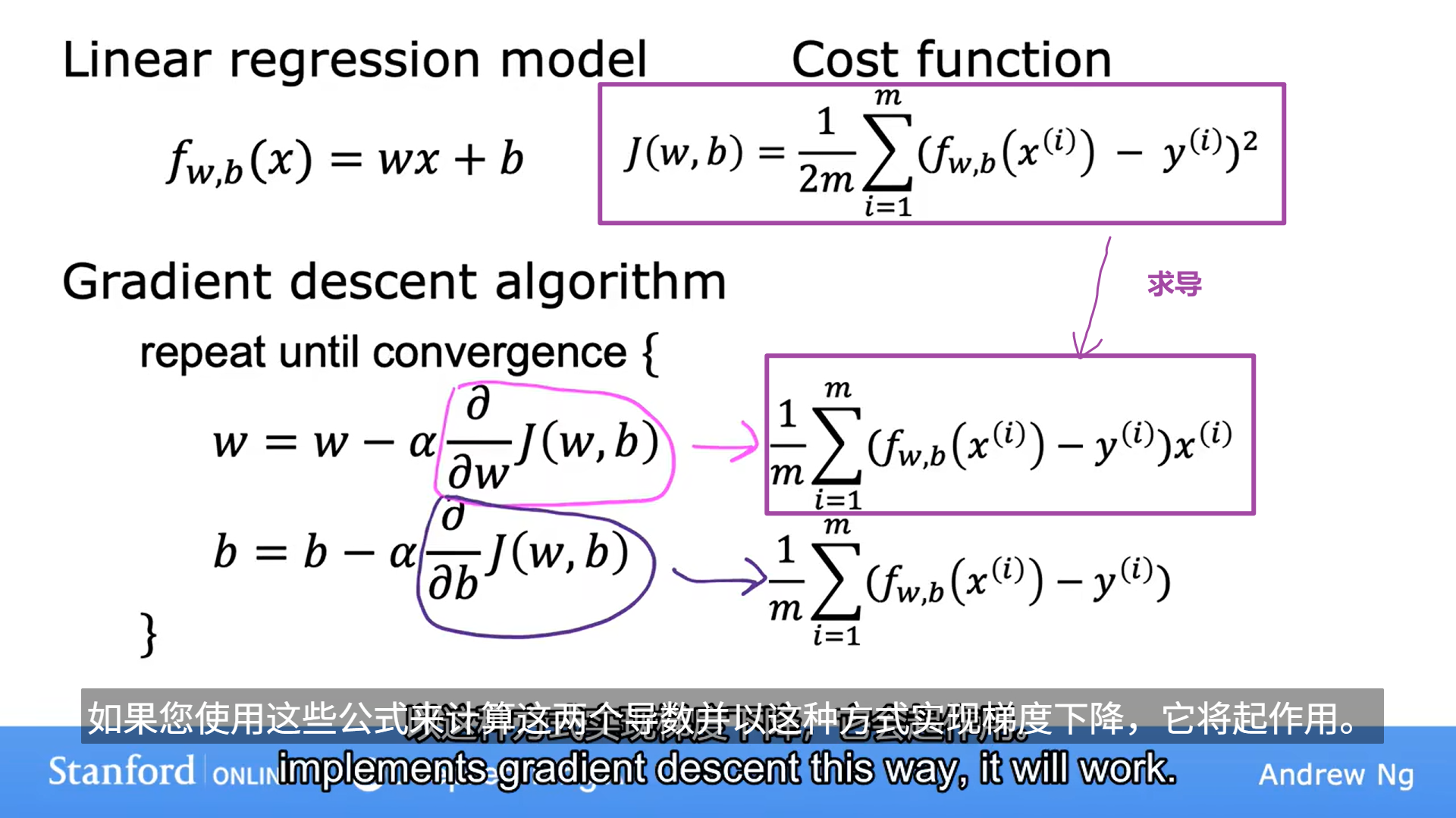

2、如何实现

2、如何实现

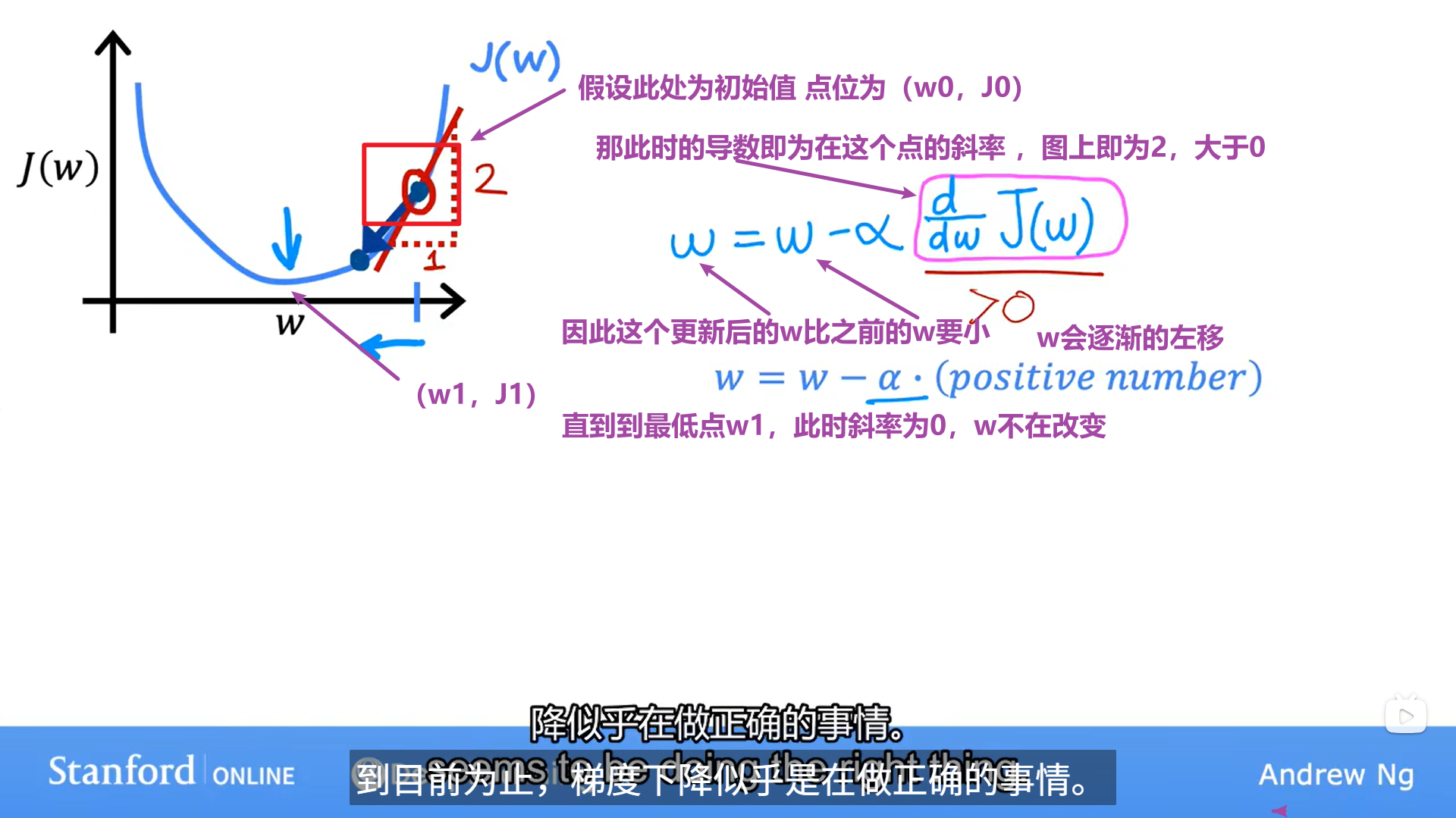

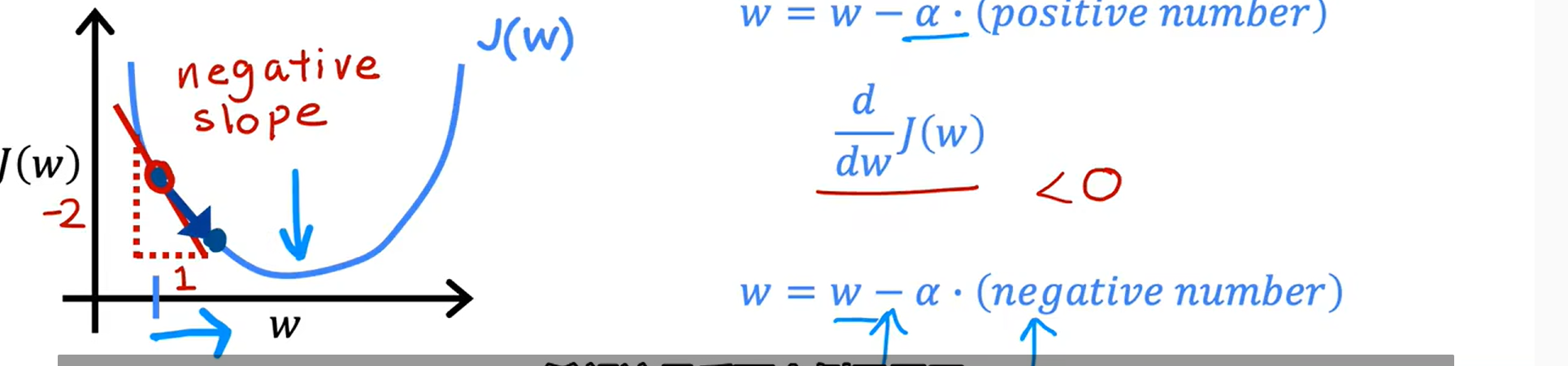

3、理解梯度下降

为了简单理解 这里考虑一个参数的J(w)

同 理在左侧的时候

理在左侧的时候

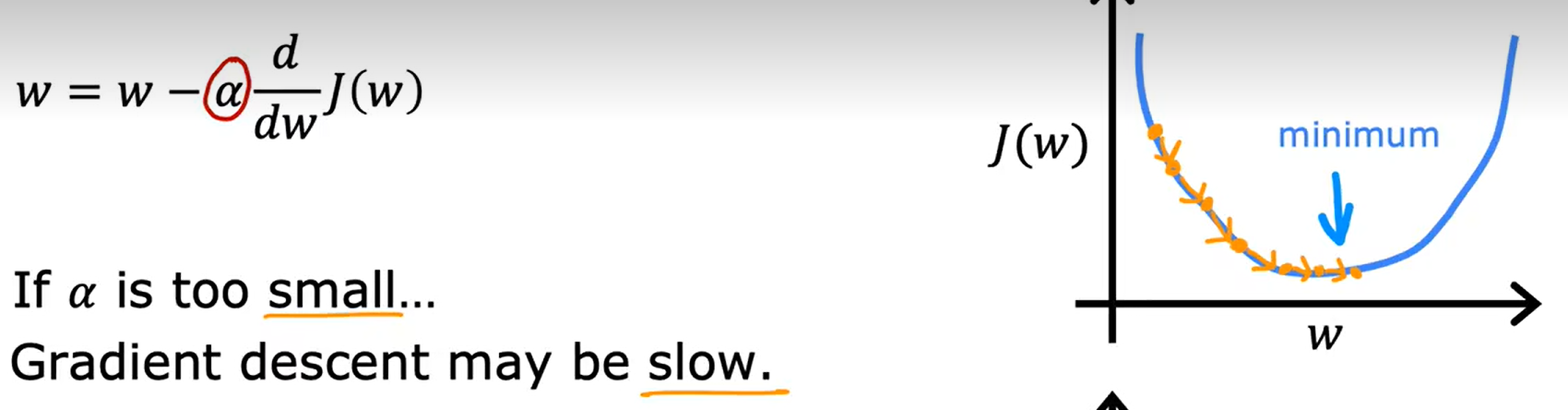

4、 对于学习率的理解

对于学习率的理解

(1) ru如果学习率太小

(2)如果 学习率太大

学习率太大

最 终可能会永远无法达到最小值,或者发散。

终可能会永远无法达到最小值,或者发散。

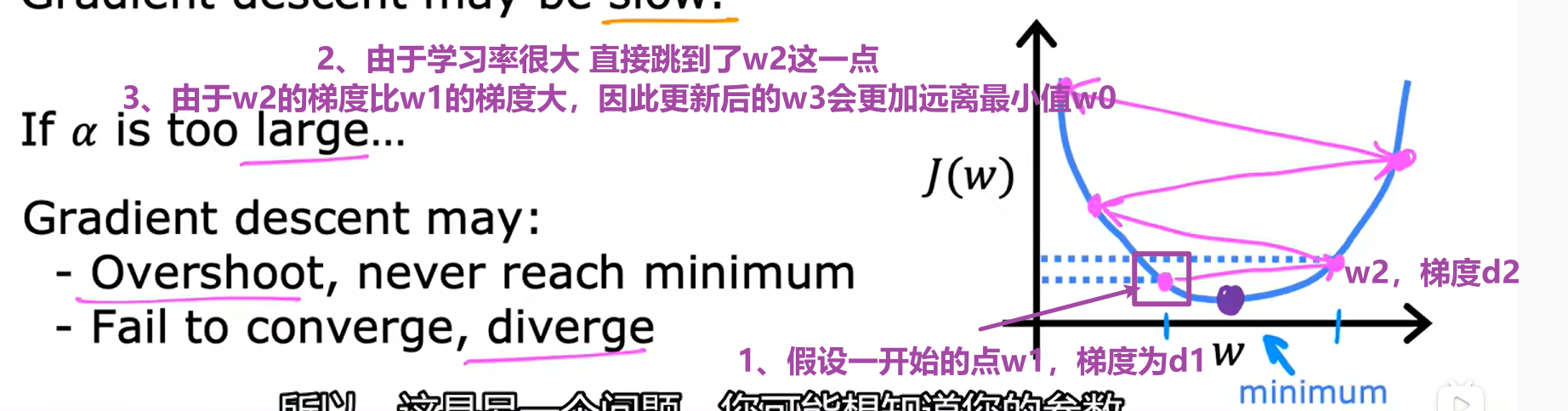

学习率是固定的 会随着梯度的减小自动更新的变小

学习率是固定的 会随着梯度的减小自动更新的变小

5、用于线性回归的梯度下降

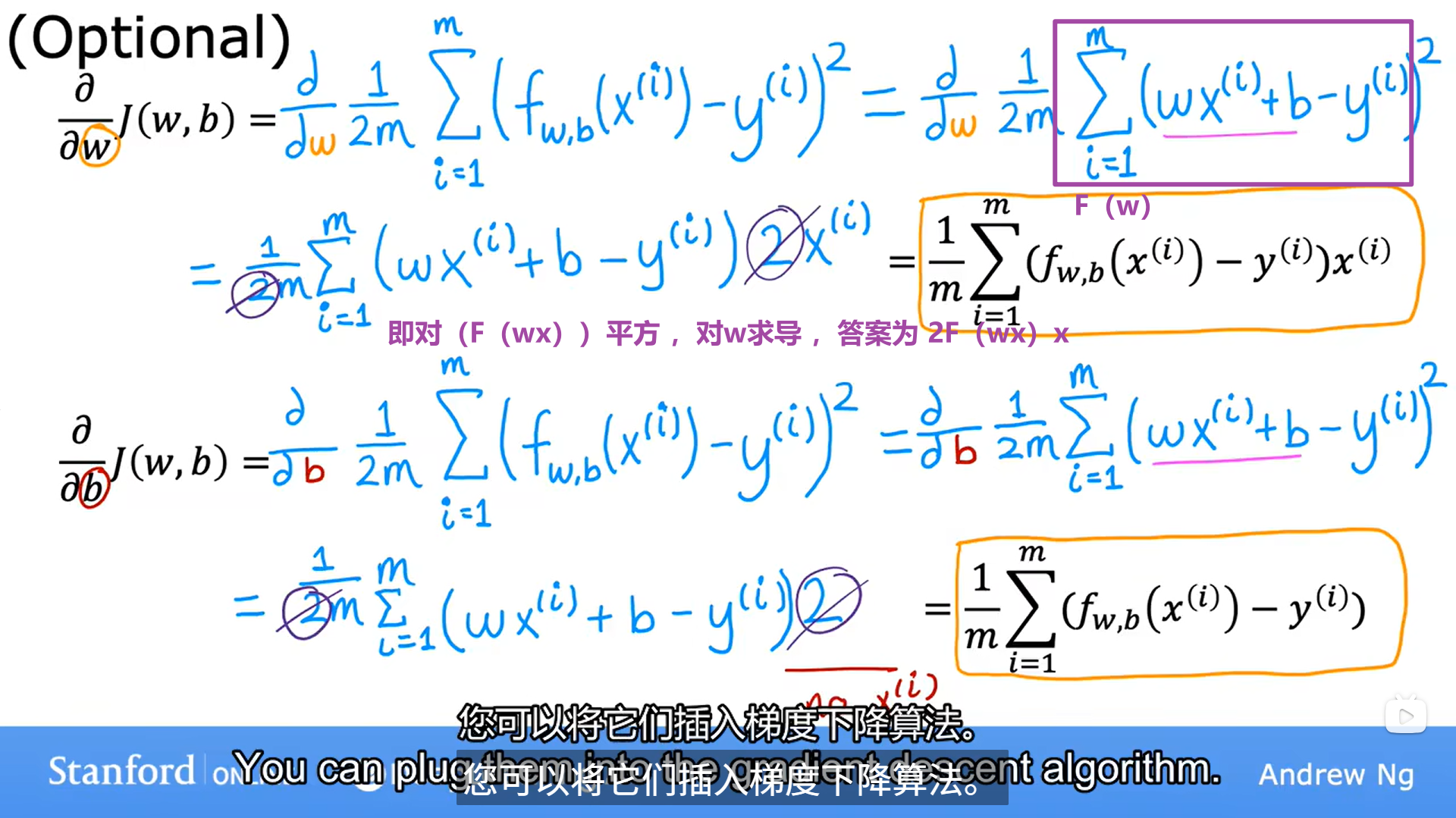

具体的导数实现

具体的导数实现

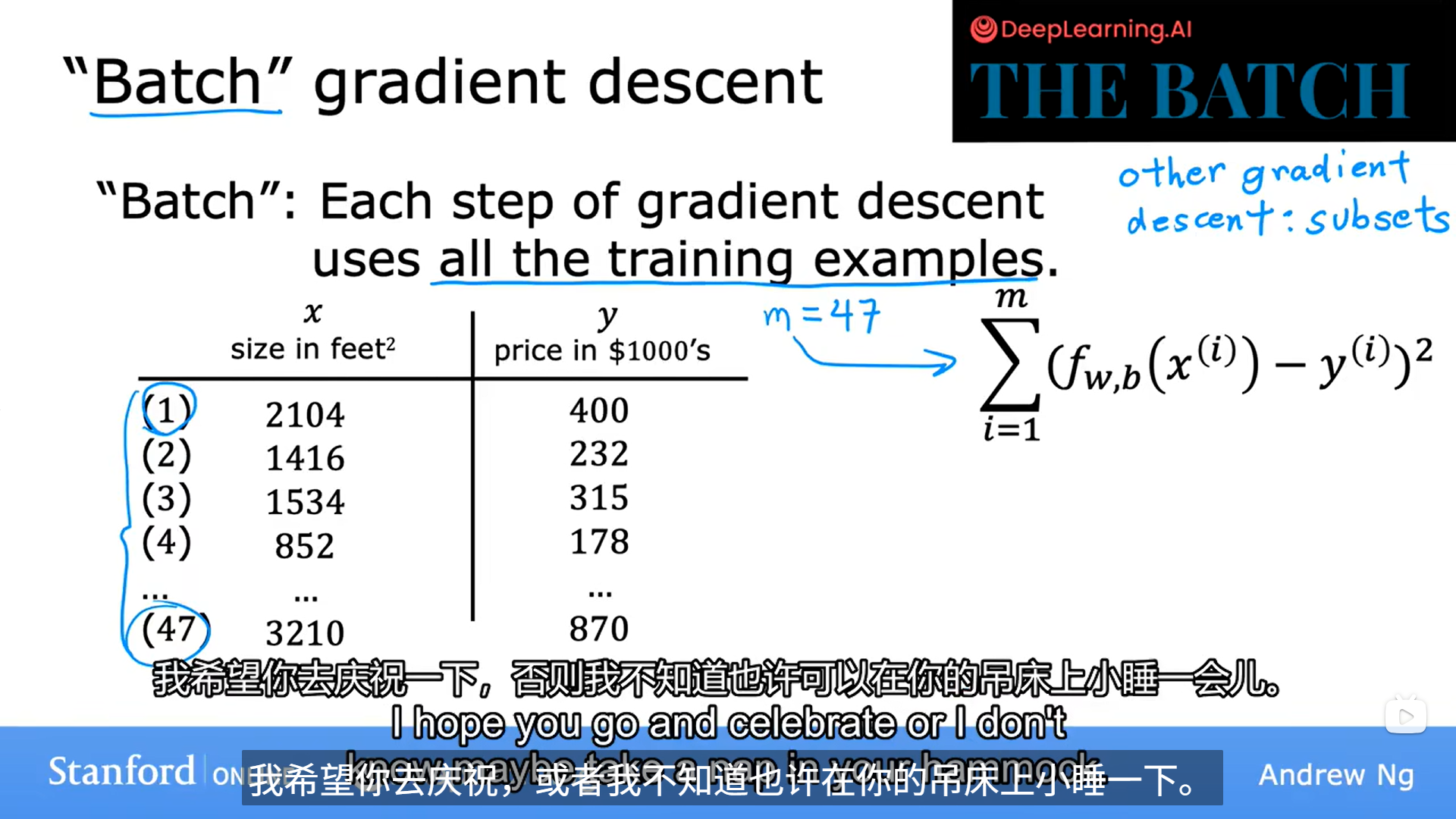

什么是batch

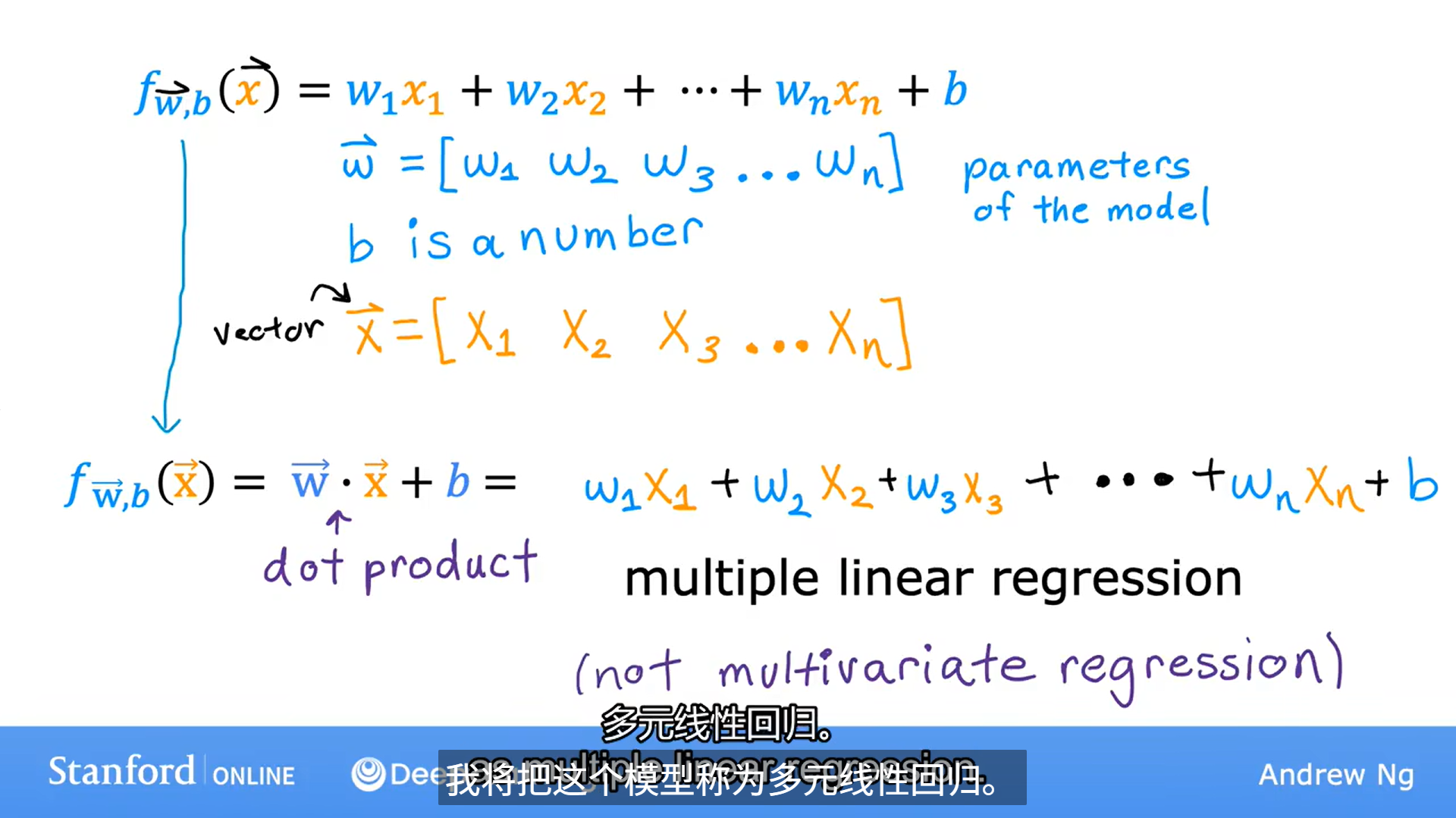

四、多维特征

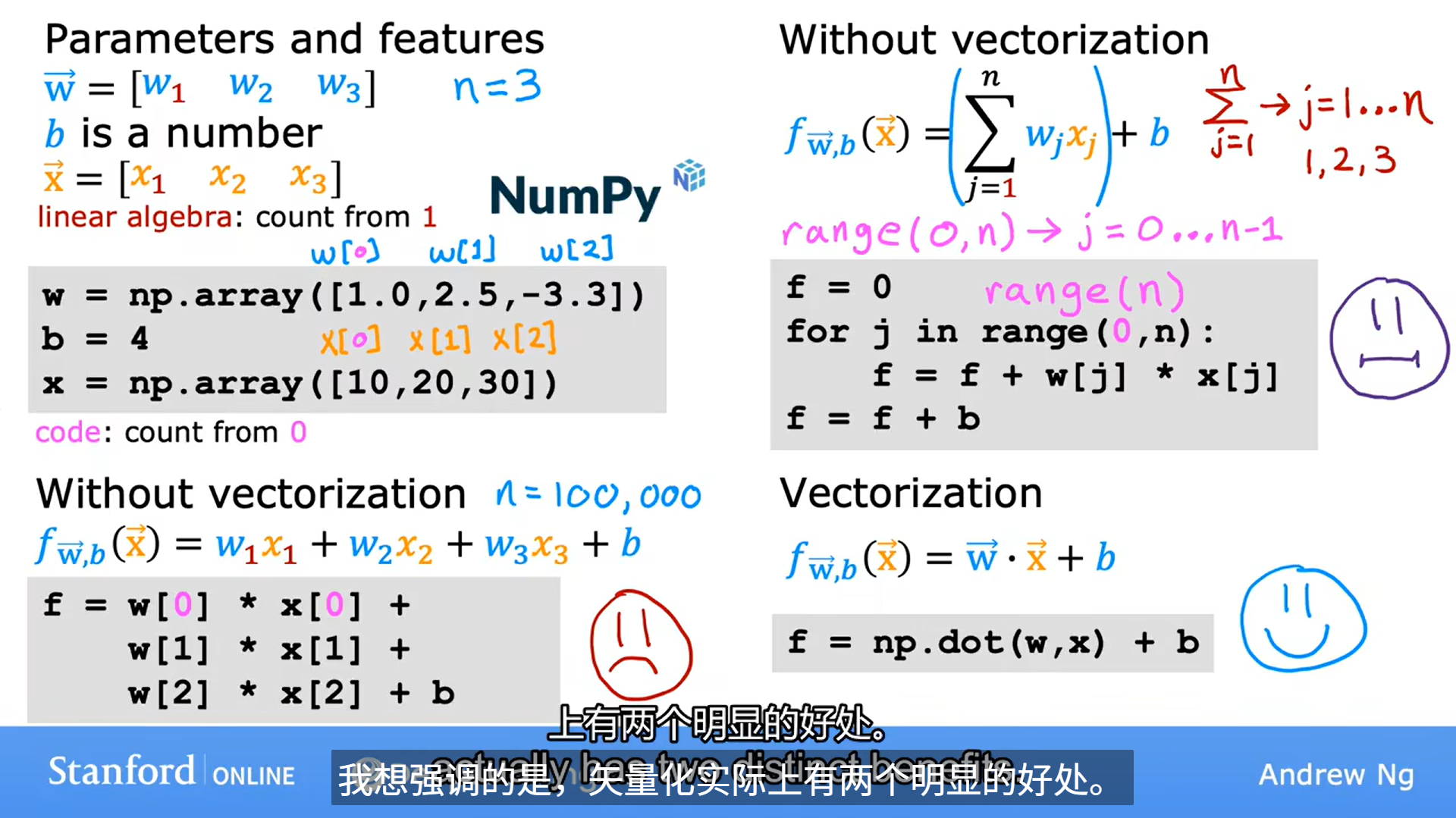

2、向量化

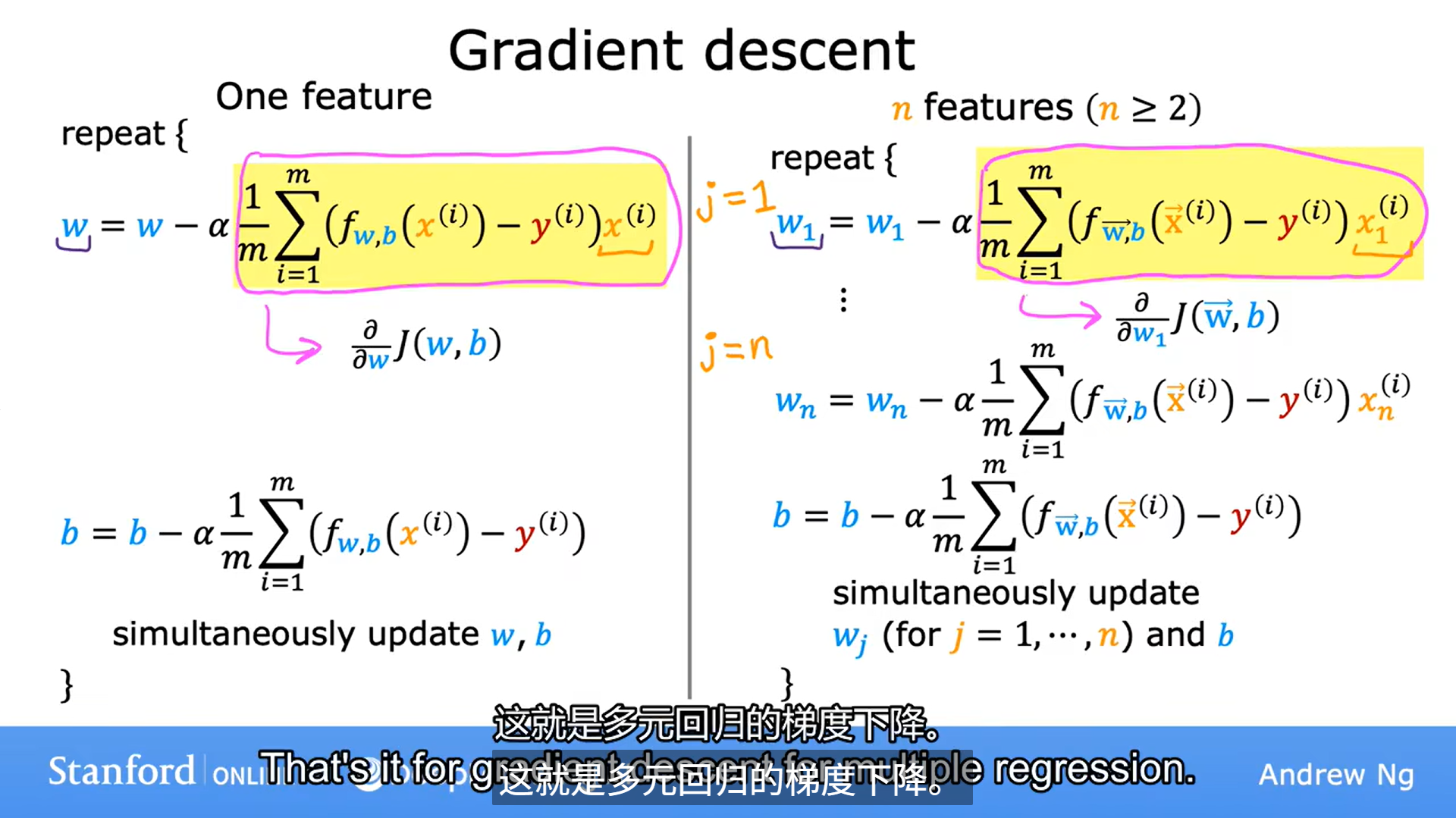

3、多元线性回归的梯度下降

3、多元线性回归的梯度下降

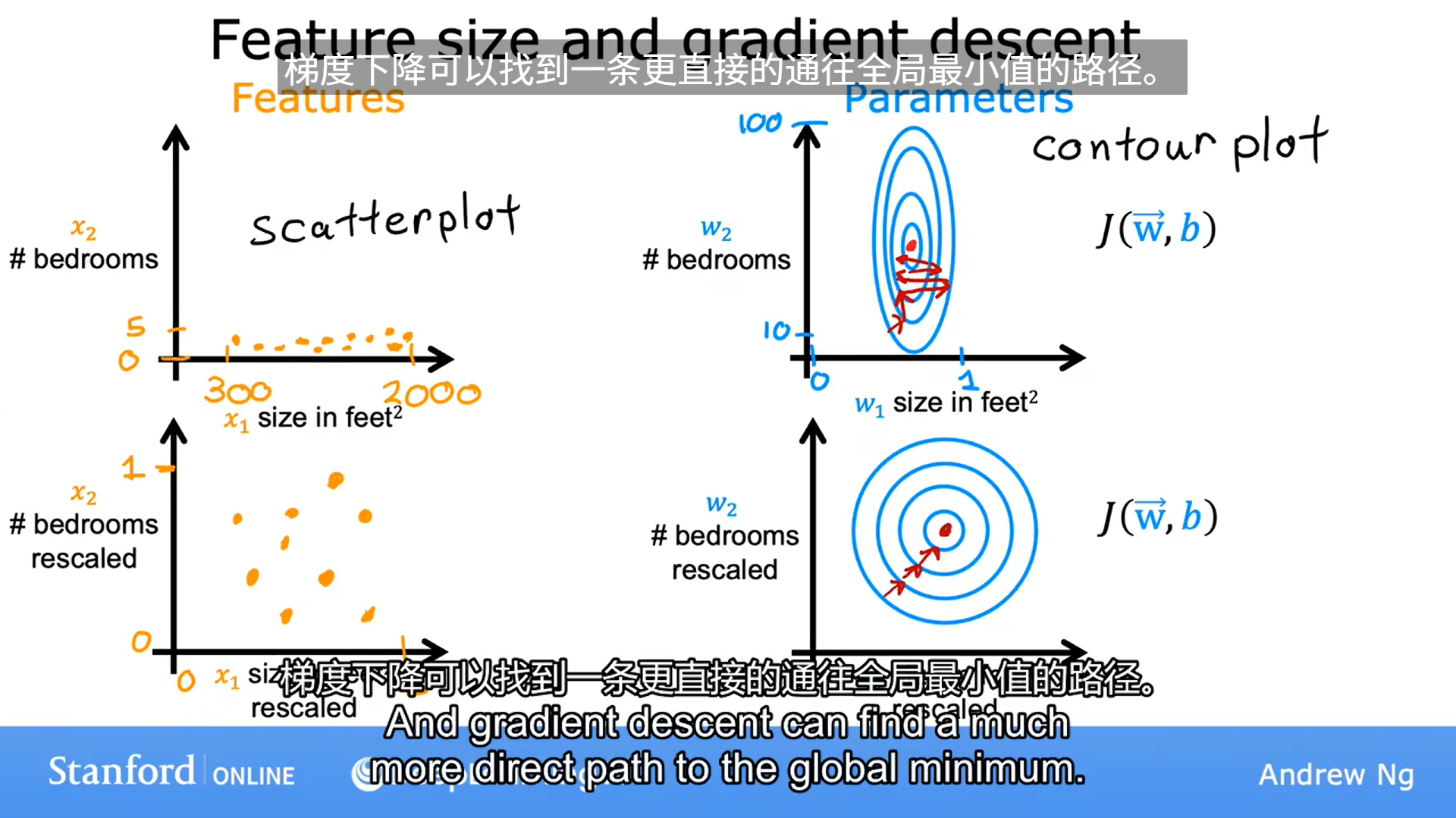

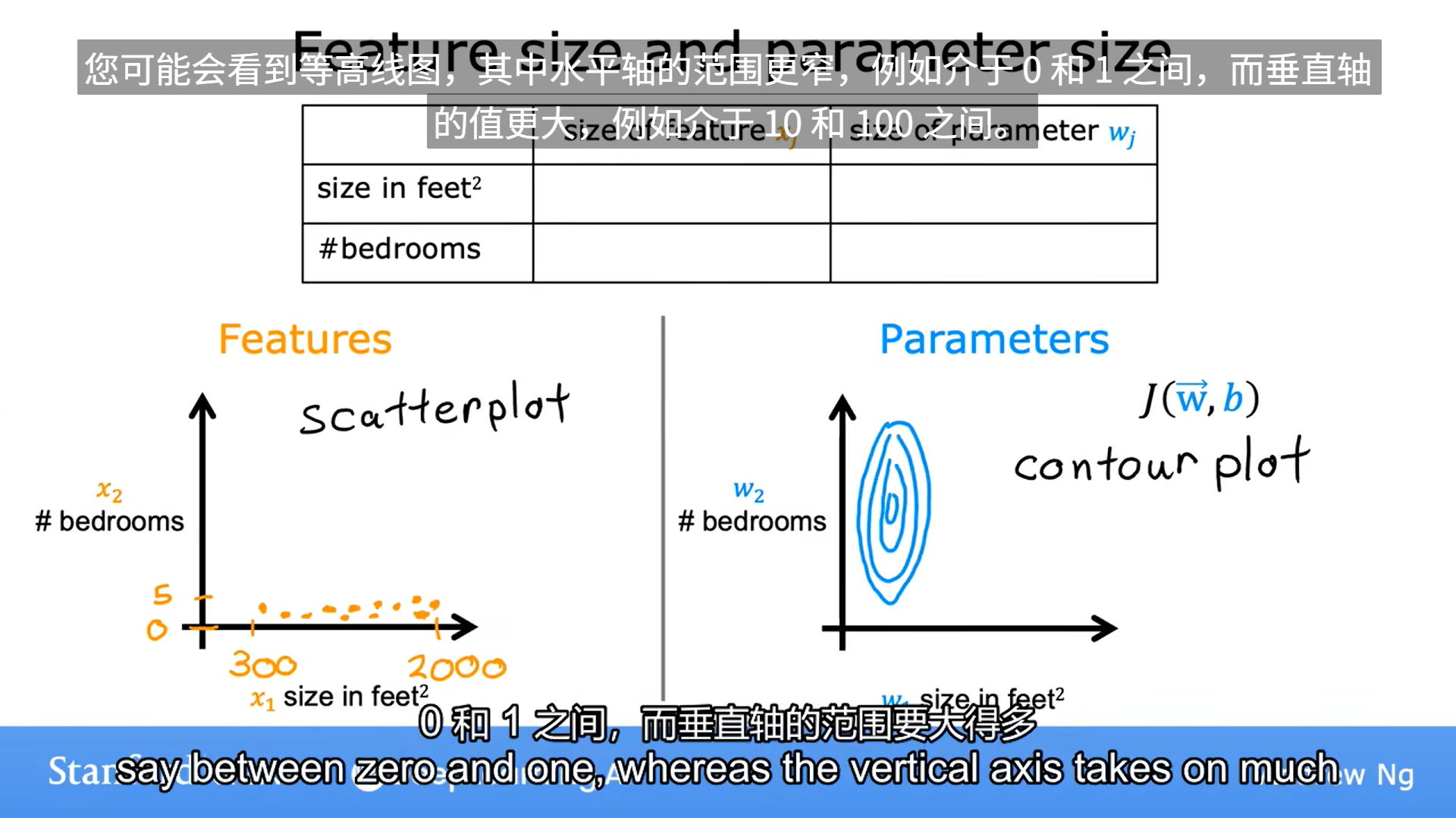

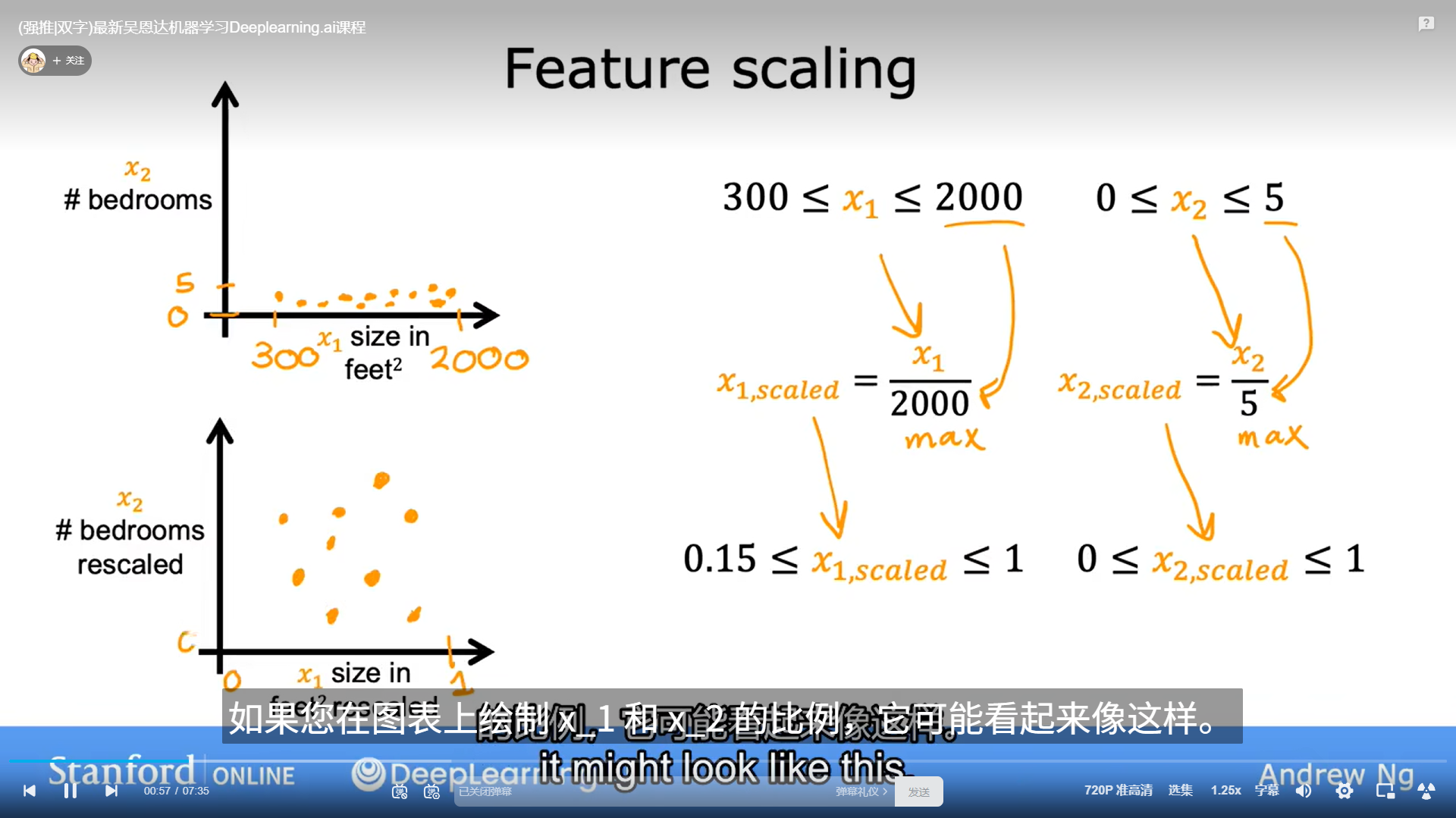

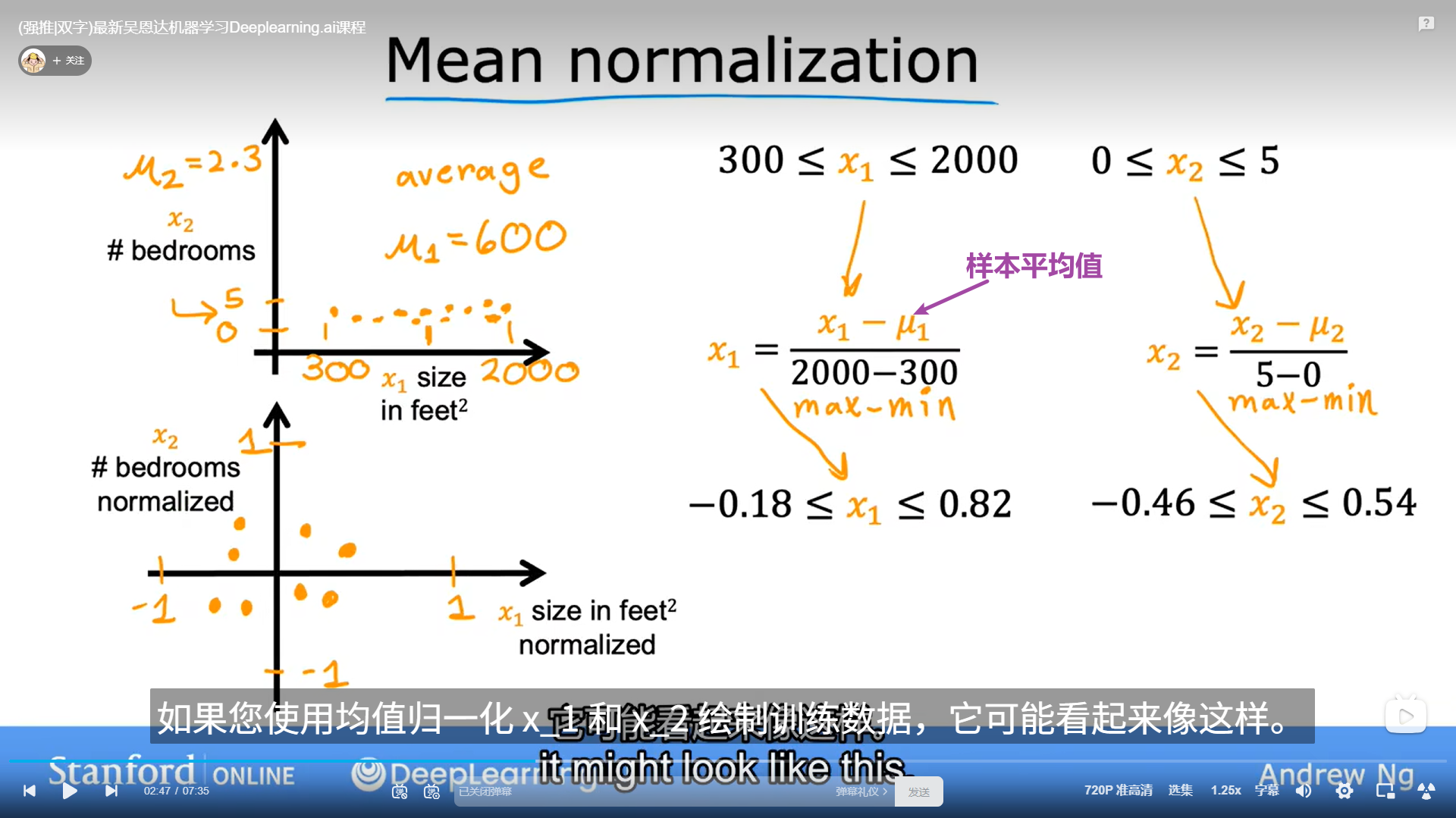

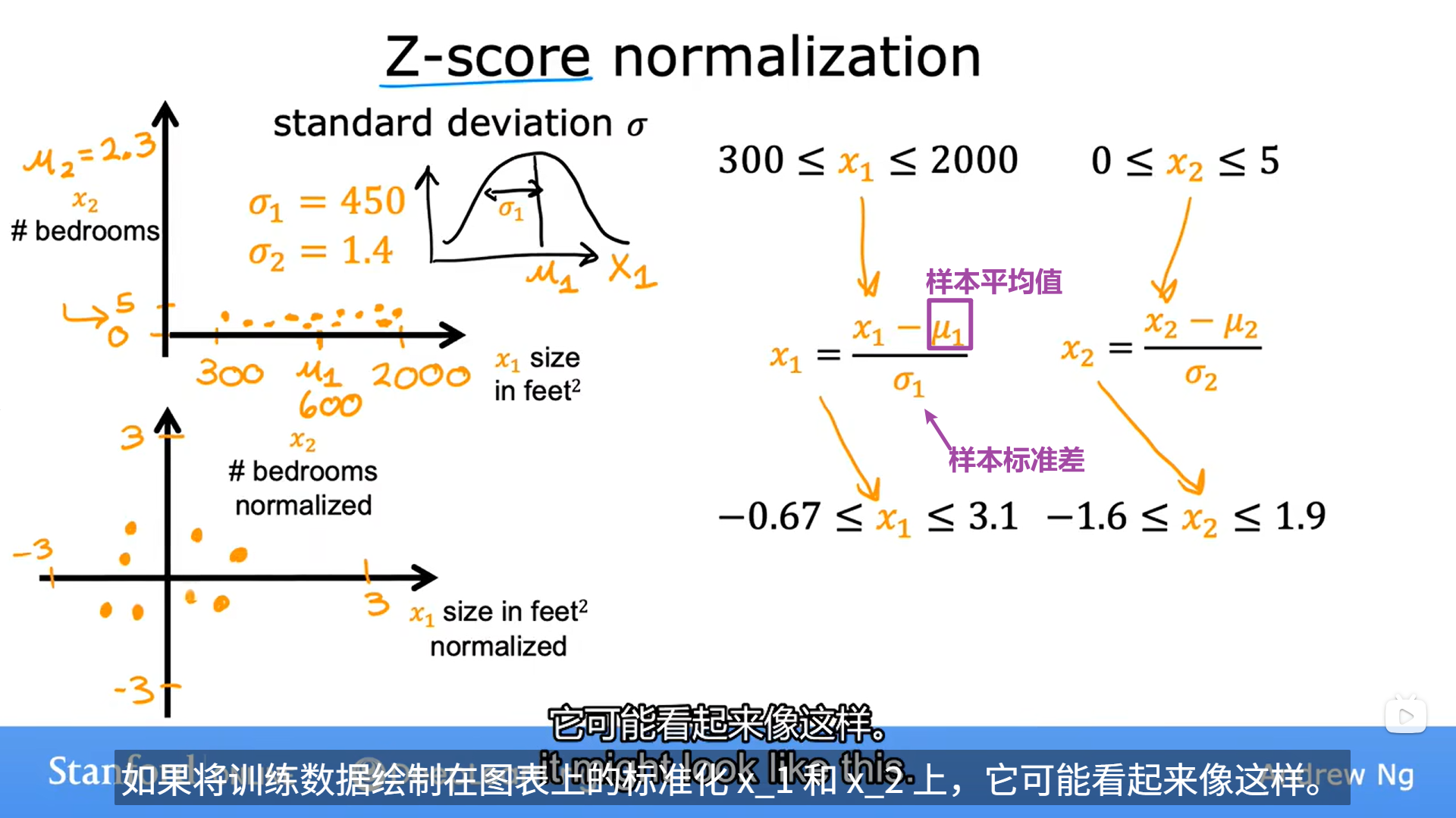

4、特征缩放

当不同特征的范围相差很多的时候 不利于线性回归 这个时候就需要进行特征缩放

如何做到

如何做到

1、除以最大值

2、均值归一化

3、z-score 标准化

1168

1168

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?