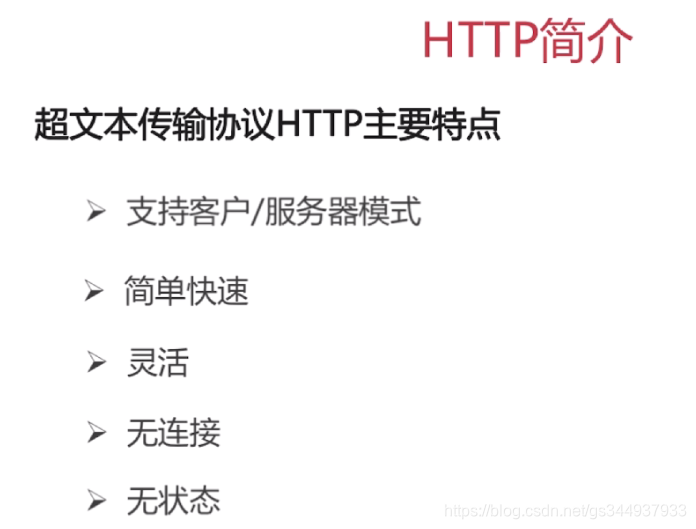

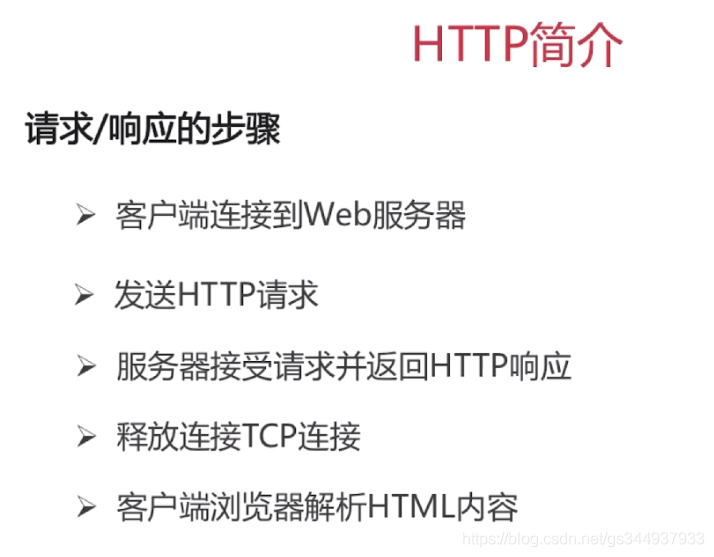

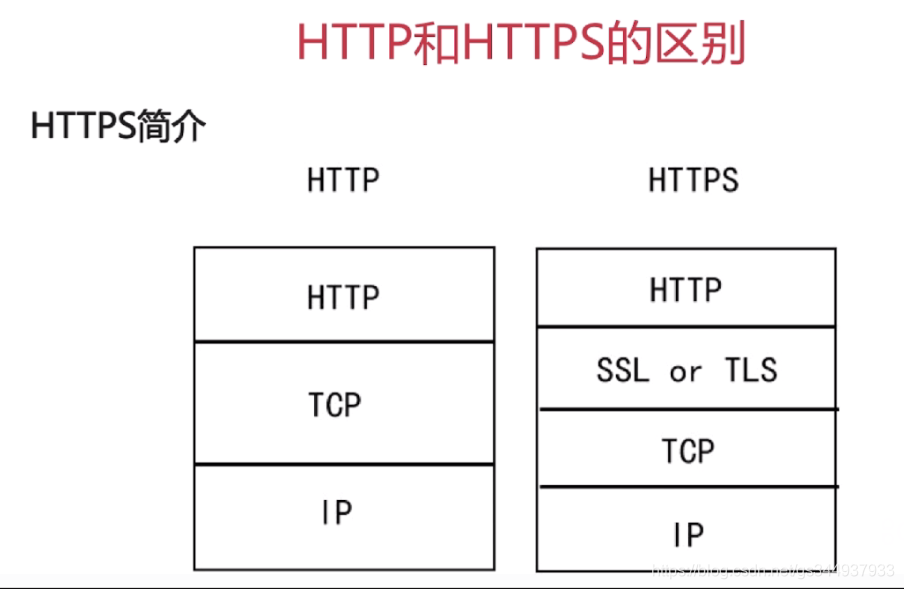

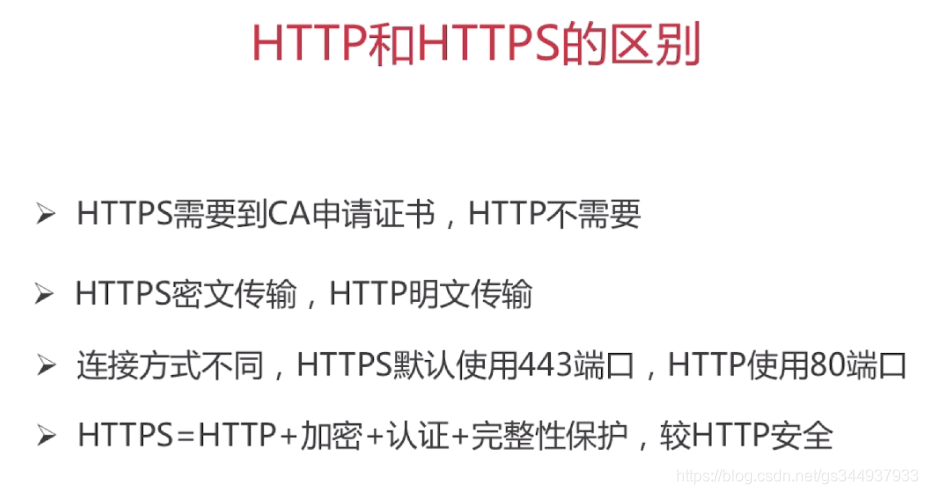

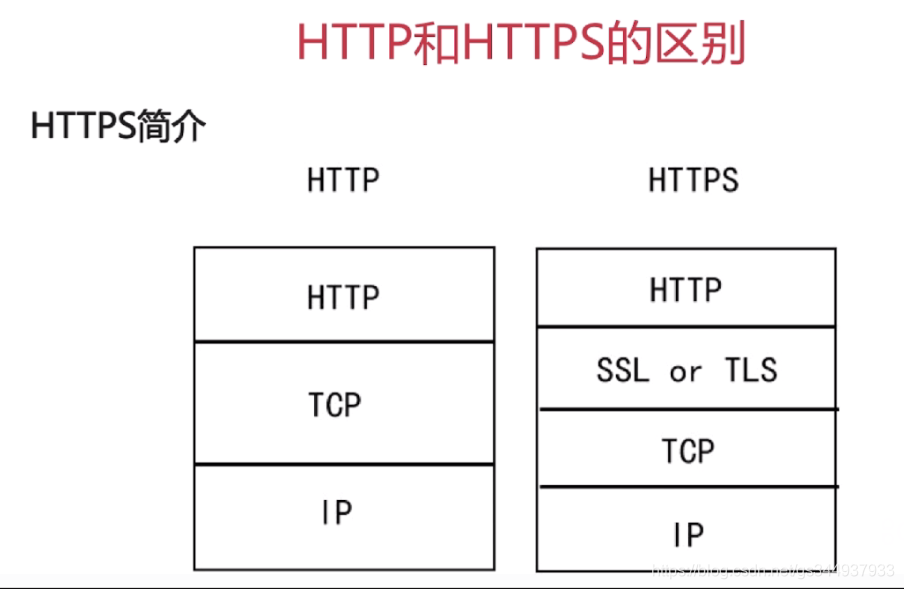

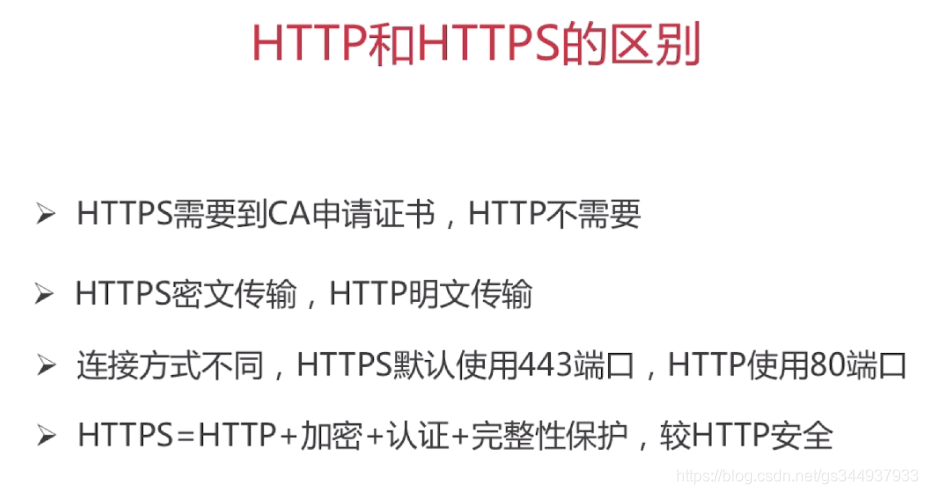

HTTP

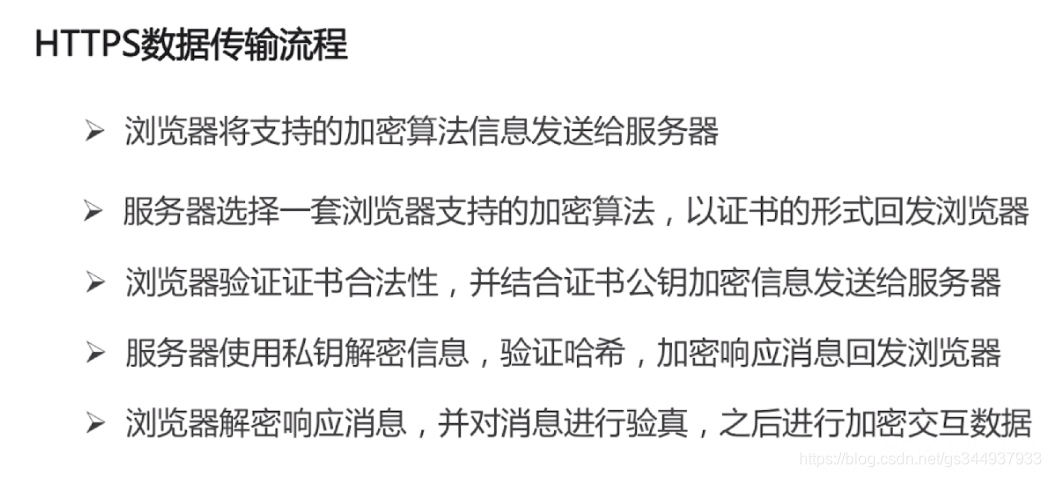

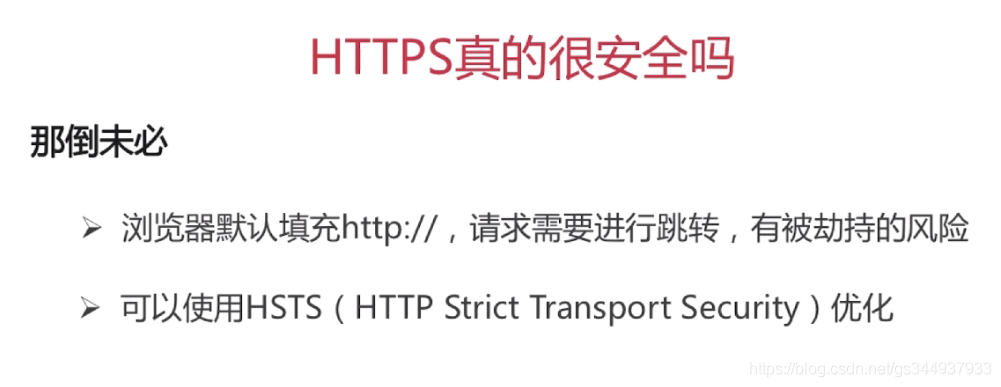

HTTPS

实际操作

参考文章:Http协议报文格式,包括请求头信息,响应吗列表,相应头信息

对于HTTPS协议,参考:[网络]从wireshark抓包看百度的https流程

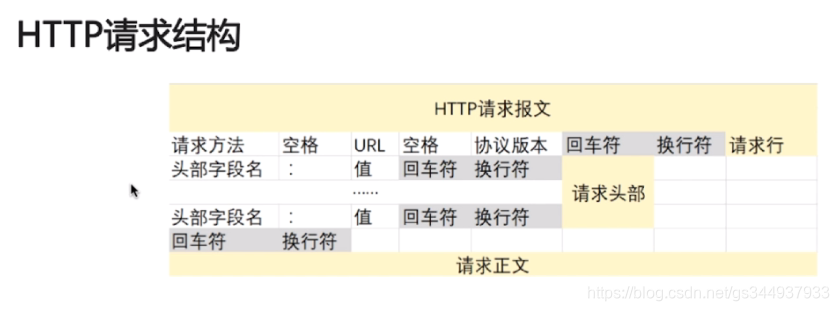

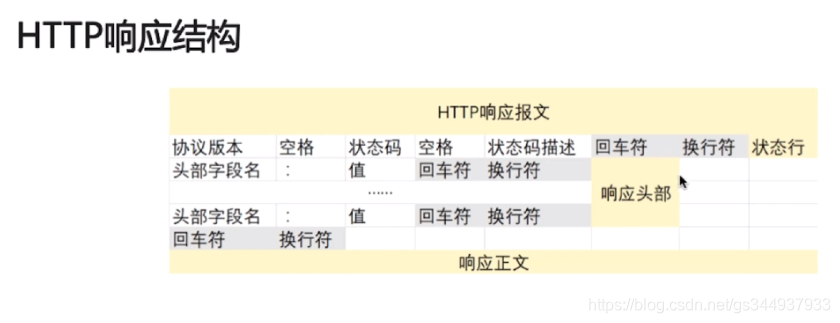

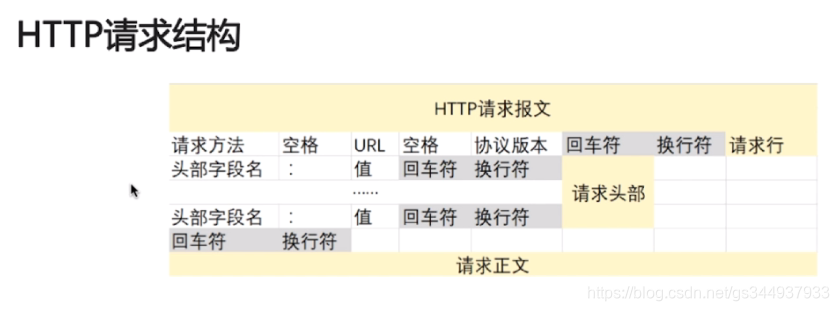

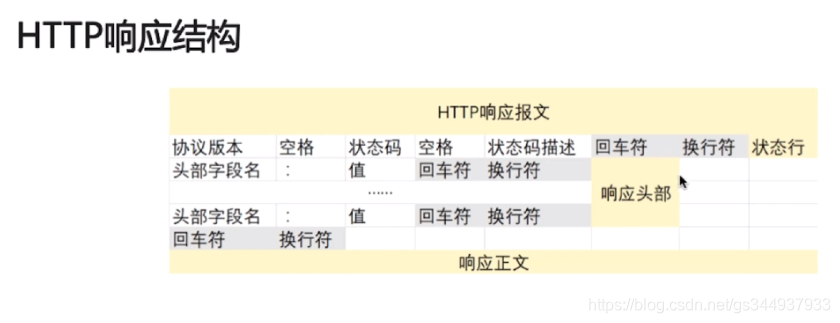

Http报文格式(这两个图非常的好)

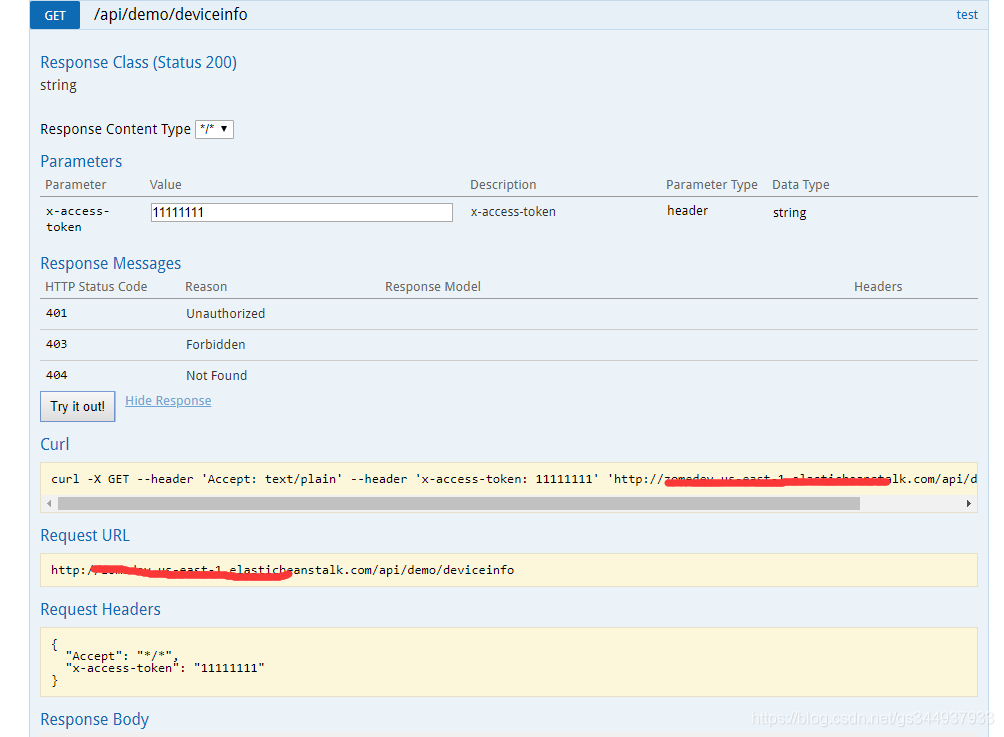

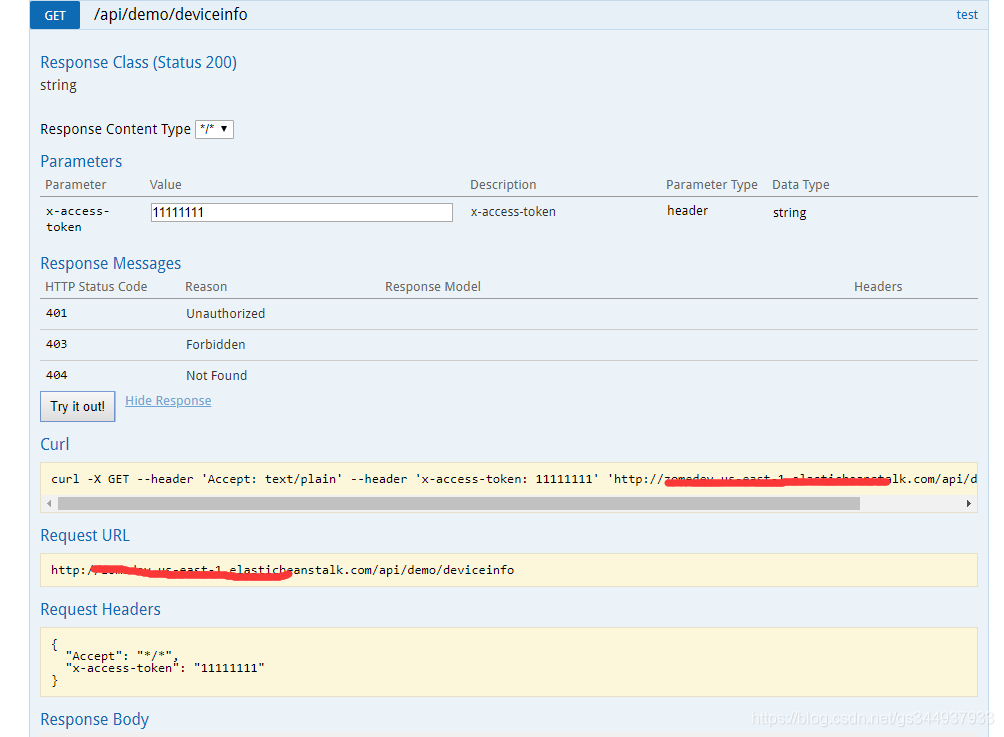

GET

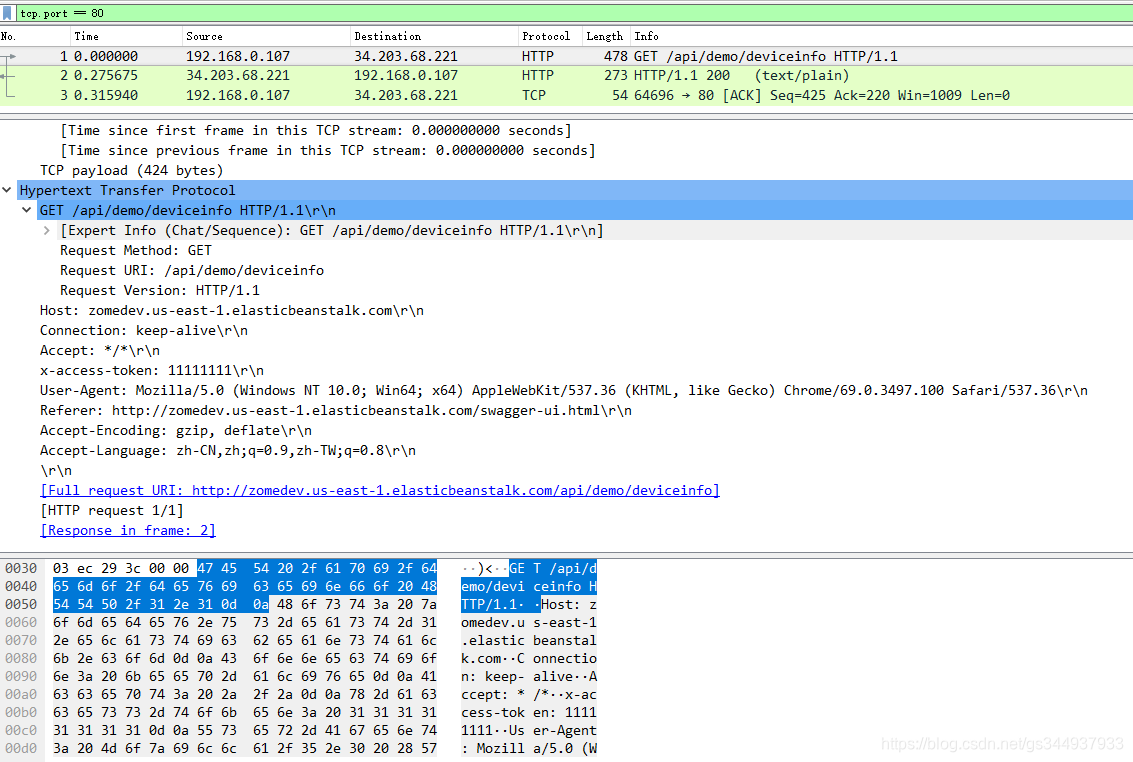

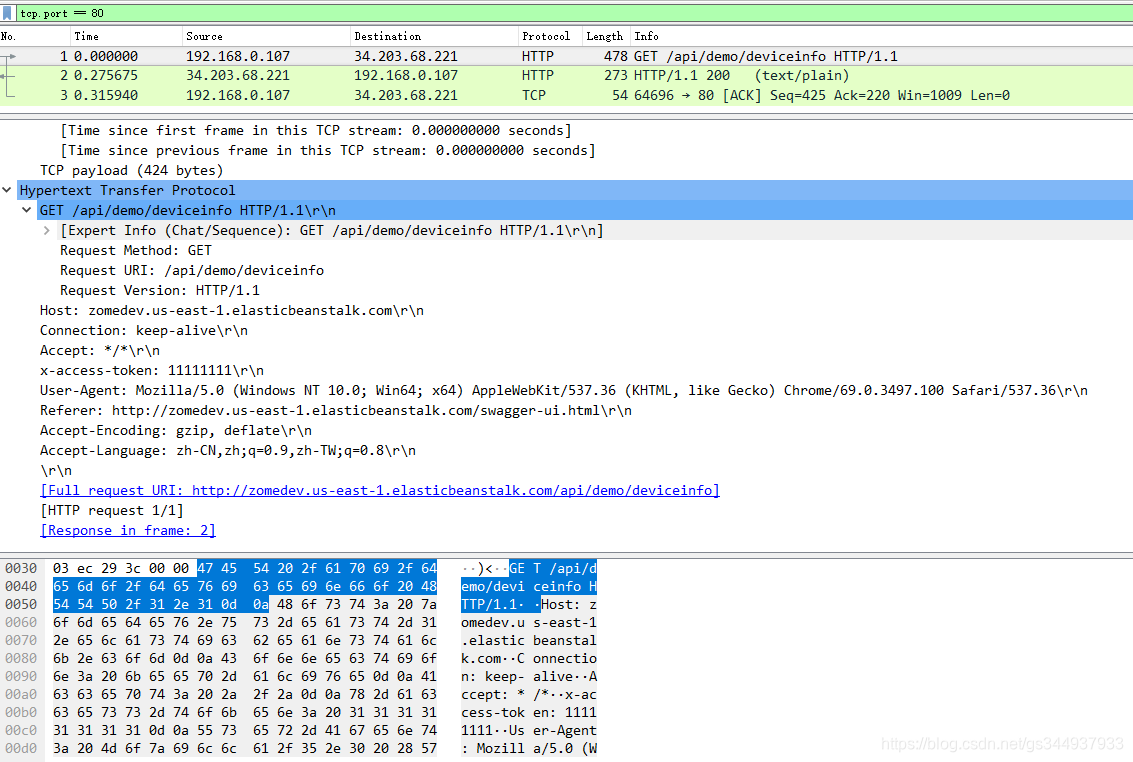

用swagger获取,再用Wireshark转包,分析协议;

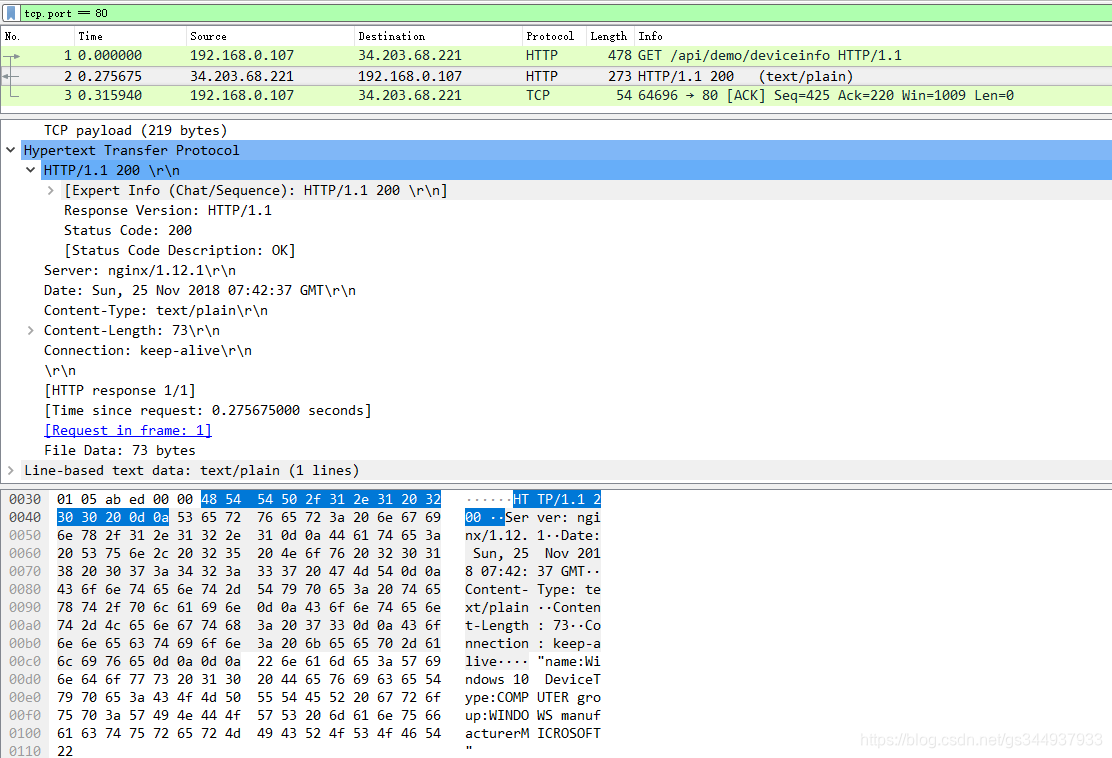

用WireShark抓包,如图:

客户端发送request包,如图:

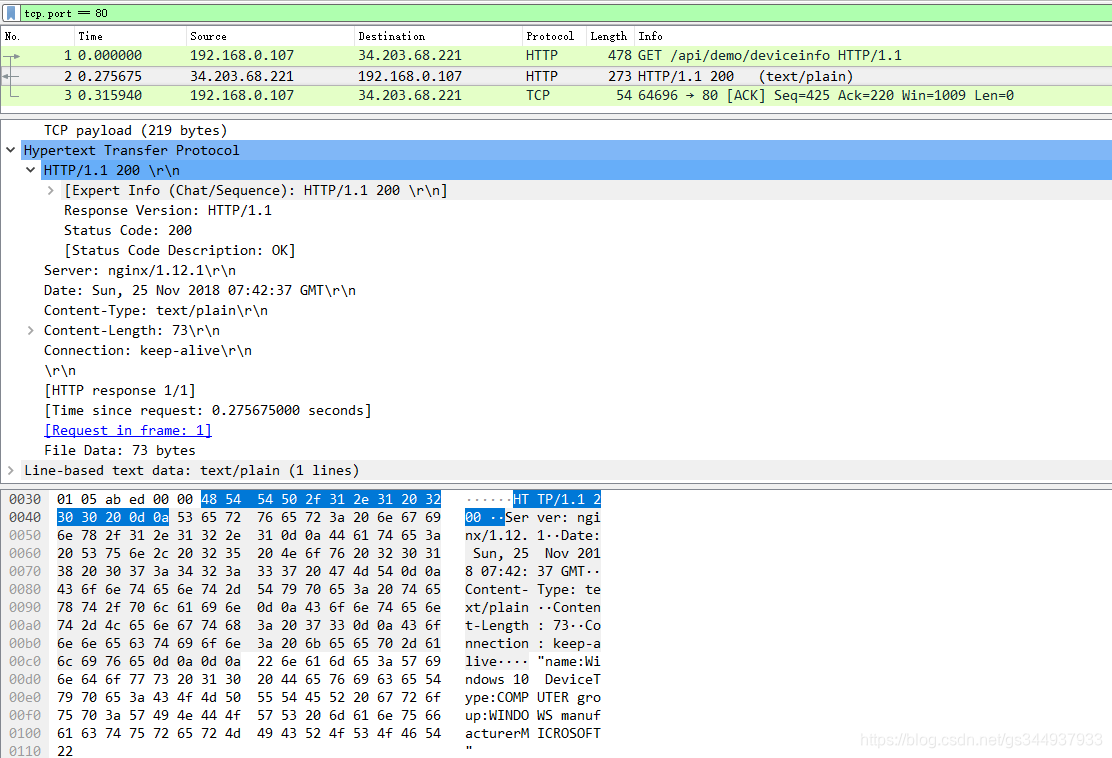

服务器相应客户端的response包:

参考文章:Http协议报文格式,包括请求头信息,响应吗列表,相应头信息

对于HTTPS协议,参考:[网络]从wireshark抓包看百度的https流程

用swagger获取,再用Wireshark转包,分析协议;

用WireShark抓包,如图:

客户端发送request包,如图:

服务器相应客户端的response包:

1035

1035

859

859

3242

3242

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?