本次学习内容为cs229第四节

牛顿方法

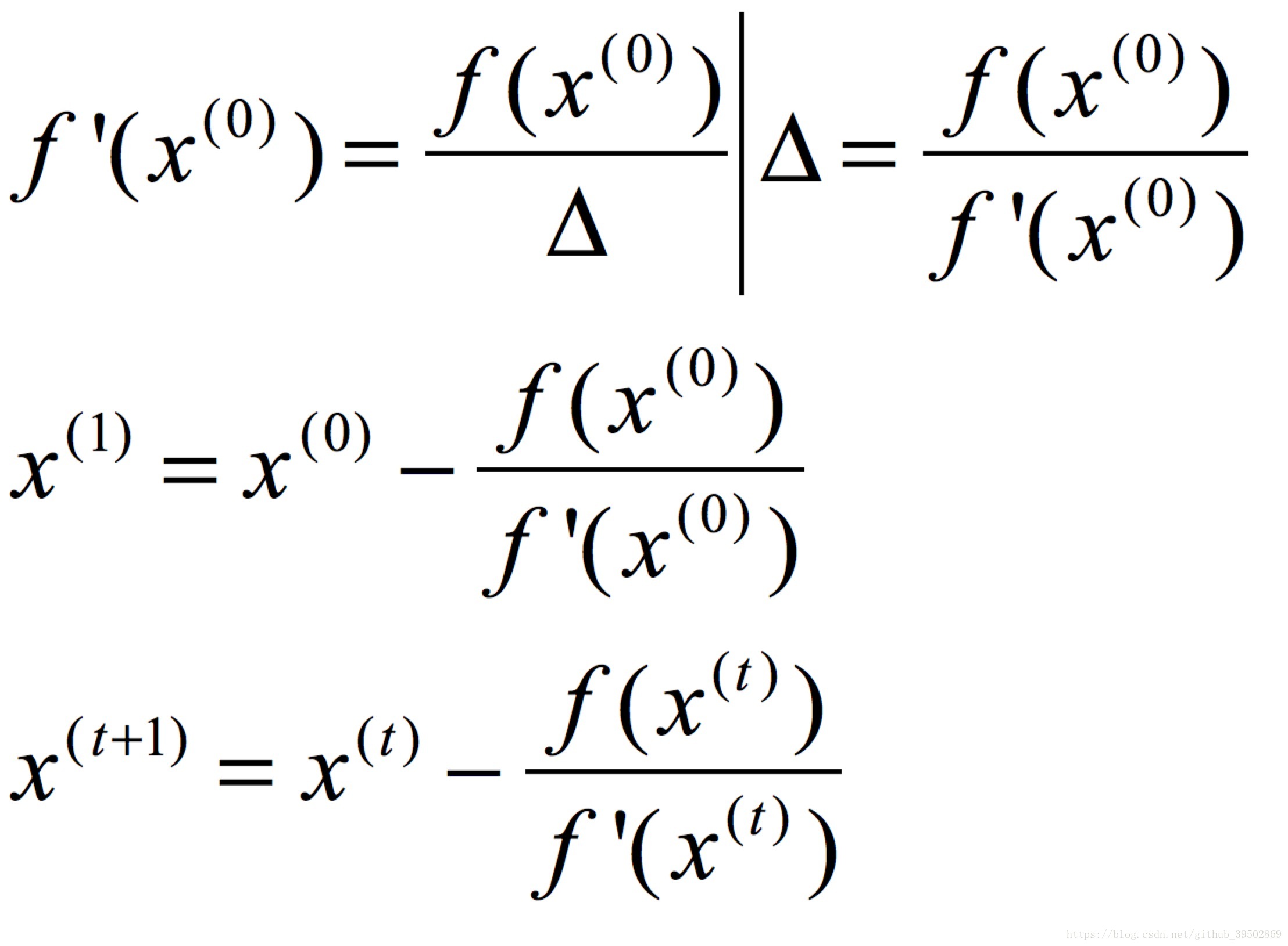

要求f(x)=0时对应的x值,先假设出一个x((0)),对其对应的函数值作切线,相交x轴于第二个点x((1)),如此反复,就可以逐渐逼近要求的点。

其实delta表示((0))到x((1))的距离,对应点的倒数为高度除以距离。

这样就完成了牛顿方法的一次迭代。

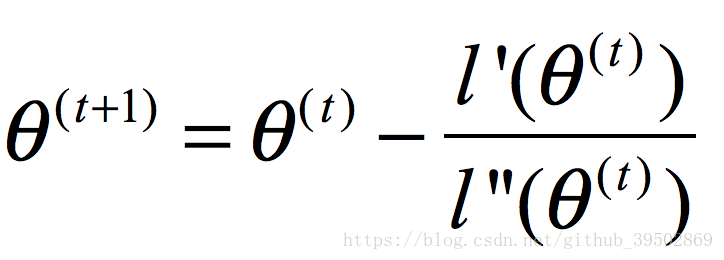

要使得找到某点,使得该点对应的函数值最大,则需要使其对应的导数为0。

因此把其导函数l’(x)定位为f(x),则得到如下内容:

牛顿算法是一个收敛速度非常快的二次收敛方法,每次迭代都会使你的逼近加倍。

使用牛顿方法求最小化的步骤也如此,没有变化。

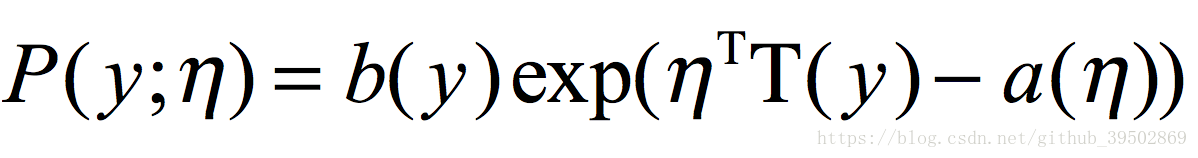

指数分布族

假设我们有一组只能取0或1的数据,我们希望用伯努利分布对其建模。当你改变参数时,你会得到不同的概率分布。同样适用于高斯分布。

对于一个给定的a,b,T,通过改变参数值可以得到伯努利分布或者告诉分布。

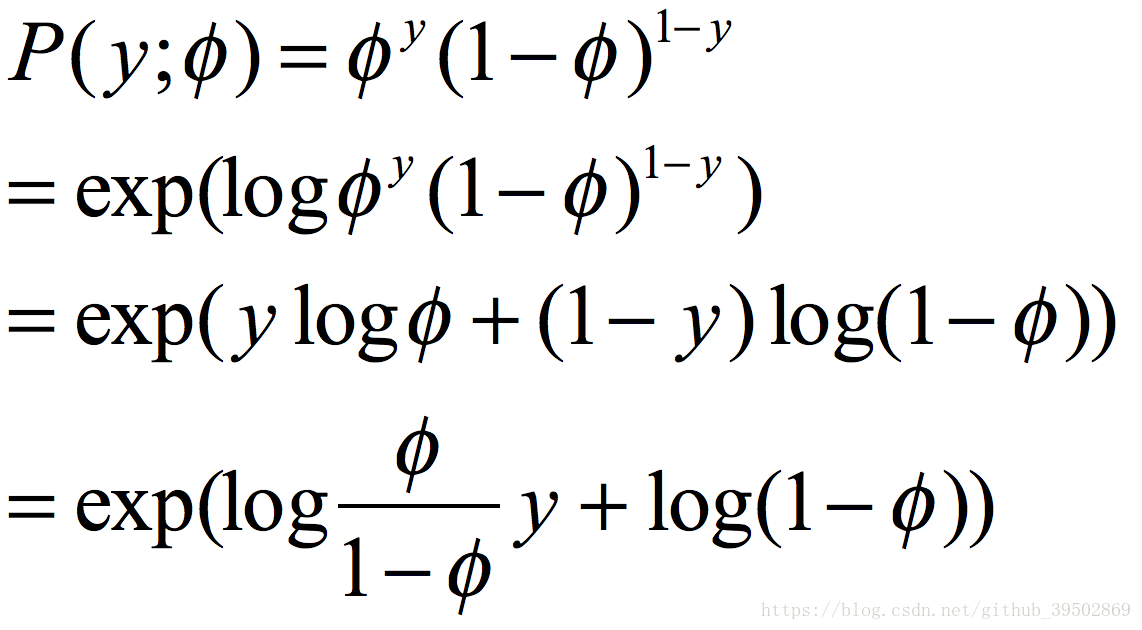

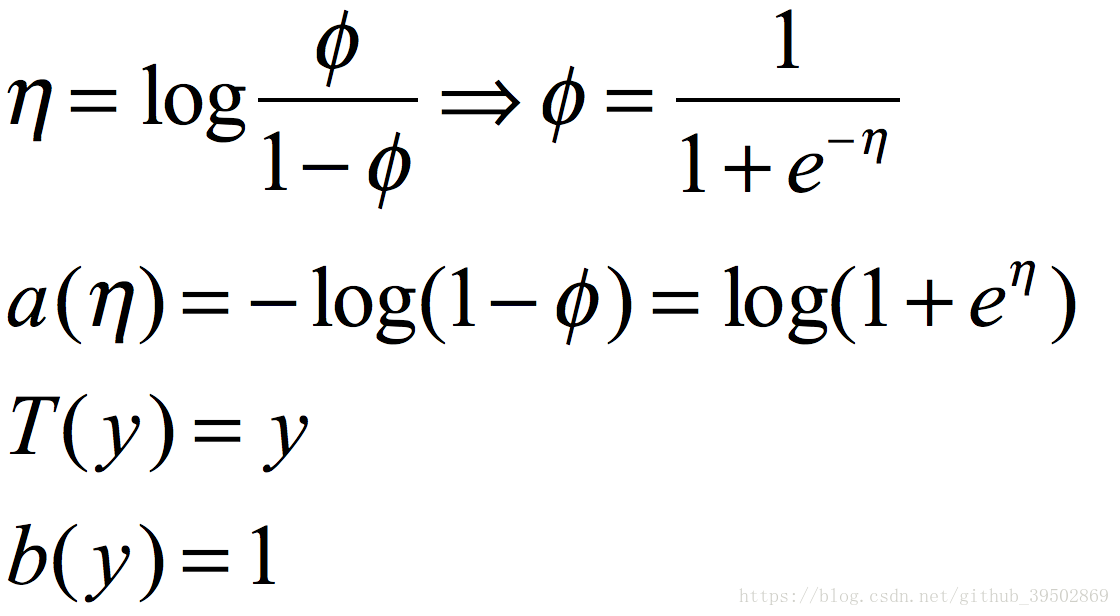

将伯努利分布变为指数分布族的形式:

而其中的a,b,T,则分别如下:

指数分布族的公式中参数同伯努利分布的参数有着特定的关系。

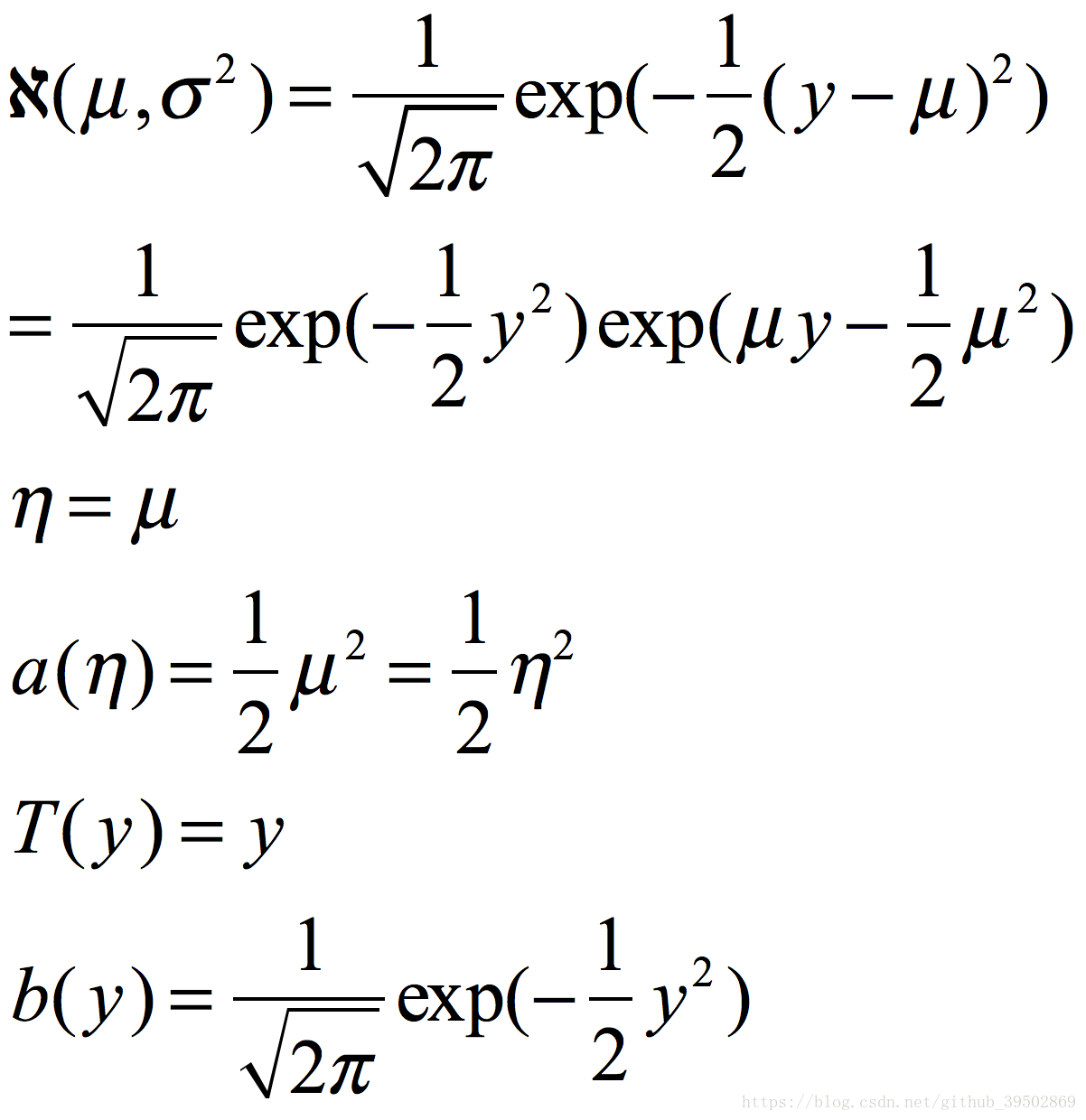

同样高斯分布也可以写成指数分布族的形式:

多项式分布、伽马分布、指数分布也属于指数分布族。事实上,大多数分布都可以写成指数分布族的形式。

广义线性模型

通常被写成GLM。

- 给定x和theta,使得y的概率分布属于指数分布族。

- 给定x,目标是输出E[T(y)|x]。换句话说,h(x)=E[T(y)|x]。

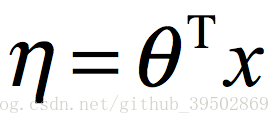

- 给出参数间的假设关系。

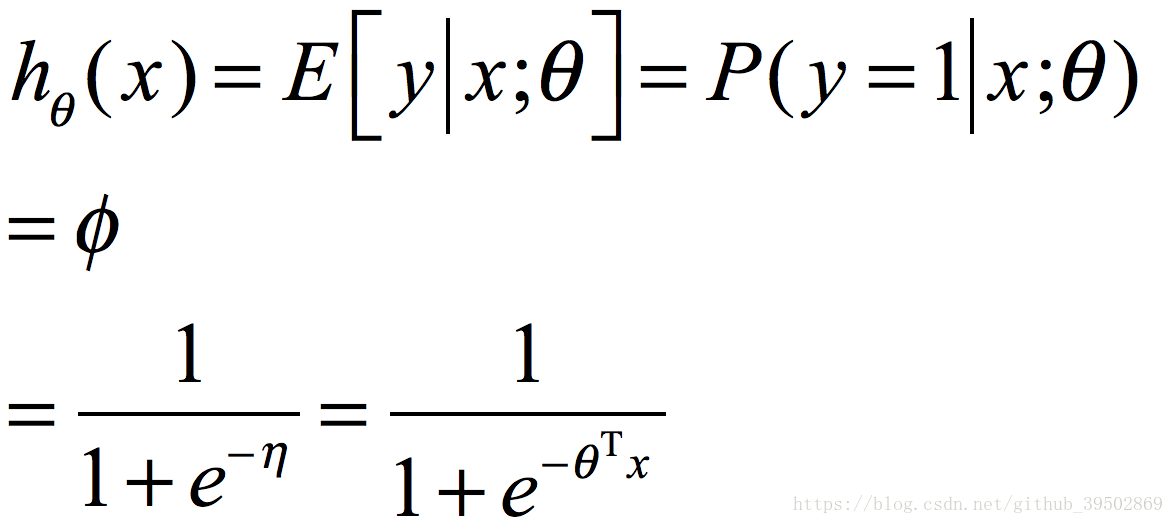

通过伯努利建模得到逻辑回归的过程:

也可以选择不同的分布来求得不同的广义线性模型。

将参数同y的期望值联系出来的函数g称为正则响应函数。

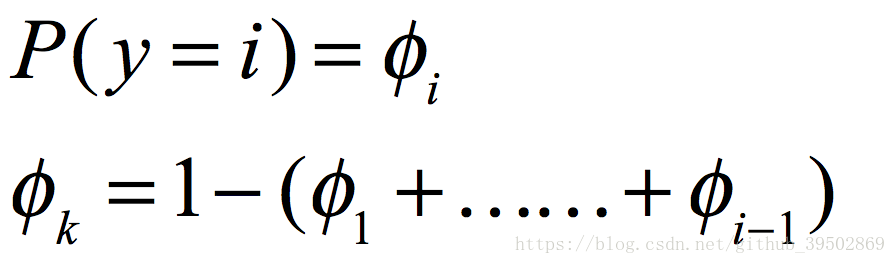

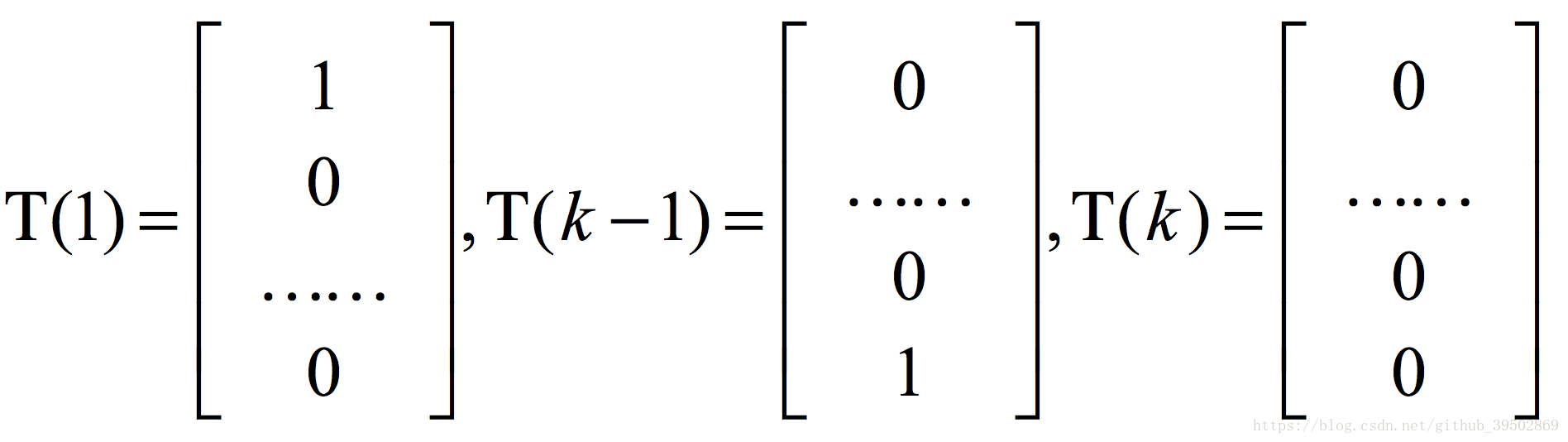

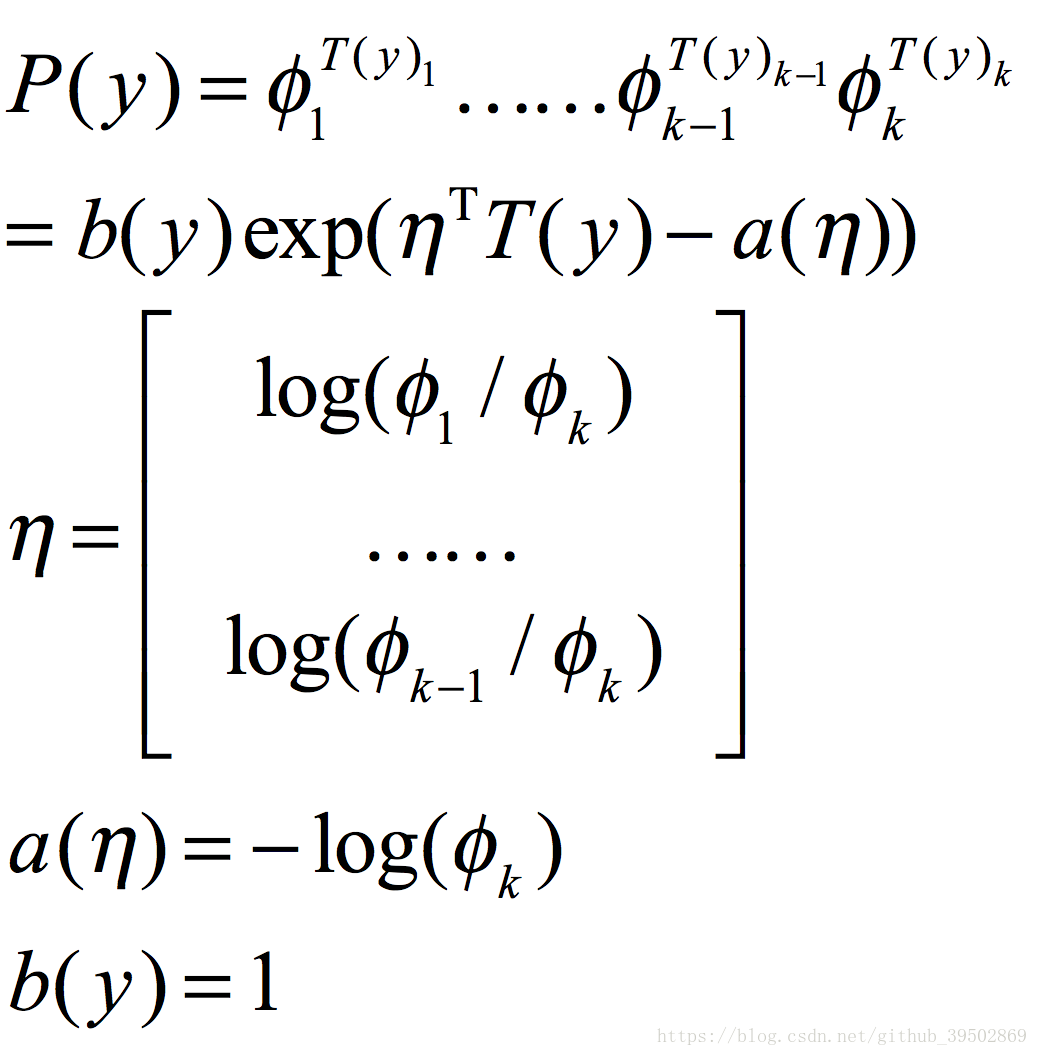

多项式分布

首先让我们将多项式分布写成指数分布族的形式。

这是一个少有的T(y)不等于y的例子,在这个例子中,T是一个随着y值变化的向量。

本文介绍了牛顿方法的基本原理及其在寻找函数根时的应用,并详细解释了如何利用牛顿方法进行函数最大值的搜索。同时,文章还探讨了几种常见的概率分布,包括伯努利分布、高斯分布等,并展示了它们如何被表示为指数分布族的形式。

本文介绍了牛顿方法的基本原理及其在寻找函数根时的应用,并详细解释了如何利用牛顿方法进行函数最大值的搜索。同时,文章还探讨了几种常见的概率分布,包括伯努利分布、高斯分布等,并展示了它们如何被表示为指数分布族的形式。

787

787

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?