Spark 安装

1、前置安装JDK就可以(Spark 不一定依靠Hadoop)

2、下载spark-2.4.3-bin-hadoop2.6.tgz

3、选择3个节点打通无密登录(1台做master节点 2台做worker节点)

4、 在conf下cp slaves 和 spark-env.sh

解压文件

解压文件并改名

tar -zxf scala-2.11.12.tgz

mv scala-2.11.12.tgz scala211

tar -zxf spark-2.4.5-bin-hadoop2.6.tgz

mv spark-2.4.5 spark245

修改环境变量

export SCALA_HOME=/root/software/scala211

export PATH=$PATH:$SCALA_HOME/bin

export SPARK_HOME=/root/software/spark245

export PATH=$PATH:$SPARK_HOME/bin

保存退出后source一下,到这里scala就安装完成了,下面来配置spark文件

配置Spark-env.sh

cd spark245/conf

vi spark-env.sh

添加如下内容:

export JAVA_HOME=/root/software/jdk1.8.0_221

export SCALA_HOME=/root/software/scala211

export SPARK_HOME=/root/software/spark245

export HADOOP_HOME=/root/software/hadoop

export HADOOP_CONF_DIR=/root/software/hadoop/etc/hadoop

export SPARK_MASTER_IP=hadoop222

export SPARK_EXECUTOR_MEMORY=1G

保存后退出

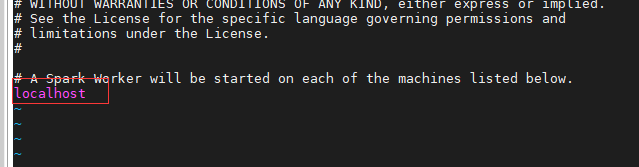

配置slaves文件

如果是集群,需要把从节点都配置到slaves文件内,如果是本地模式则跳过

启动spark

scala启动直接输入scala即可

spark启动需要输入 spark-shell

如图所示则为成功

本文详细介绍了如何在多节点环境中安装和配置Spark。首先确保安装了JDK,然后下载并解压Spark-2.4.5-bin-hadoop2.6.tgz文件,设置环境变量。接着配置Spark-env.sh,包括指定JAVA_HOME、SCALA_HOME、SPARK_HOME等,并设定SPARK_MASTER_IP和executor内存。同时,编辑slaves文件以配置从节点。最后,通过scala和spark-shell命令启动Spark,成功启动的标志是看到相应的shell提示。

本文详细介绍了如何在多节点环境中安装和配置Spark。首先确保安装了JDK,然后下载并解压Spark-2.4.5-bin-hadoop2.6.tgz文件,设置环境变量。接着配置Spark-env.sh,包括指定JAVA_HOME、SCALA_HOME、SPARK_HOME等,并设定SPARK_MASTER_IP和executor内存。同时,编辑slaves文件以配置从节点。最后,通过scala和spark-shell命令启动Spark,成功启动的标志是看到相应的shell提示。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?