什么是机器学习

强化学习中的Monte Carlo Tree Search (MCTS) 是一种用于决策制定和搜索的算法,特别在不确定环境下表现出色。

1. 强化学习背景

在强化学习中,一个智能体通过与环境的交互学习,以便在某个任务上获得最大的奖励。MCTS是一种用于搜索最优决策的方法。

2. MCTS概览

MCTS主要有四个阶段:选择(Selection)、扩展(Expansion)、模拟(Simulation)和回溯(Backpropagation)。算法通过多次重复这些阶段来逐步优化决策。

2.1 选择(Selection)

从树的根节点(当前状态)开始,通过一定策略选择子节点,直到达到叶节点。这个过程基于一定的选择策略,例如UCB (Upper Confidence Bound)。

2.2 扩展(Expansion)

当达到叶节点时,根据问题的定义,扩展树以添加一个或多个子节点。这模拟了在现实中采取一个动作并观察新状态的过程。

2.3 模拟(Simulation)

从扩展的节点开始,执行模拟来估计这个节点的价值。模拟是通过一种模型或随机方法生成的,模拟直到达到某个终止条件。

2.4 回溯(Backpropagation)

根据模拟的结果,将回报值(reward)传播回来更新经过的所有节点的统计信息,如访问次数和累计奖励。

3. 伪代码示例

以下是MCTS的简化伪代码:

def mcts(root_state, budget):

root_node = Node(state=root_state)

for _ in range(budget):

# Selection

selected_node = select(root_node)

# Expansion

if not selected_node.is_terminal():

expanded_node = expand(selected_node)

selected_node = expanded_node

# Simulation

reward = simulate(selected_node.state)

# Backpropagation

backpropagate(selected_node, reward)

best_child = best_child(root_node)

return best_child.action

4. Node 类

在实现中,你需要定义一个节点类,用于表示搜索树的节点。每个节点应该包含状态信息、动作信息、访问次数、累计奖励等。

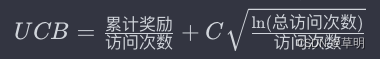

- UCB选择策略

UCB是一种常用的节点选择策略,其计算方式为:

其中:

C是一个可调节的参数。

6. 注意事项

- MCTS的性能很大程度上取决于选择策略和模拟过程的质量。

- 可以通过调整参数和使用领域专业知识来改进算法性能。

- MCTS常用于处理复杂环境和不完全信息的问题。

实际应用中可能需要根据具体情况进行调整和优化。深入了解MCTS的原理和实现将有助于更好地应用该算法。

本文介绍了强化学习中的MonteCarloTreeSearch(MCTS)算法,包括其四个核心阶段:选择、扩展、模拟和回溯。MCTS在不确定环境中通过模拟和策略优化决策,适用于复杂环境和不完全信息问题。

本文介绍了强化学习中的MonteCarloTreeSearch(MCTS)算法,包括其四个核心阶段:选择、扩展、模拟和回溯。MCTS在不确定环境中通过模拟和策略优化决策,适用于复杂环境和不完全信息问题。

1318

1318

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?