论文解读

Intra- and Inter-Action Understanding via Temporal Action Parsing

1. 文章主要做了几个工作

-

一个新的数据集TAPOS,它为每个动作实例以及它的时序结构提供一个类标签

-

一个新的任务,即时间动作解析,它鼓励探索动作的内部结构

-

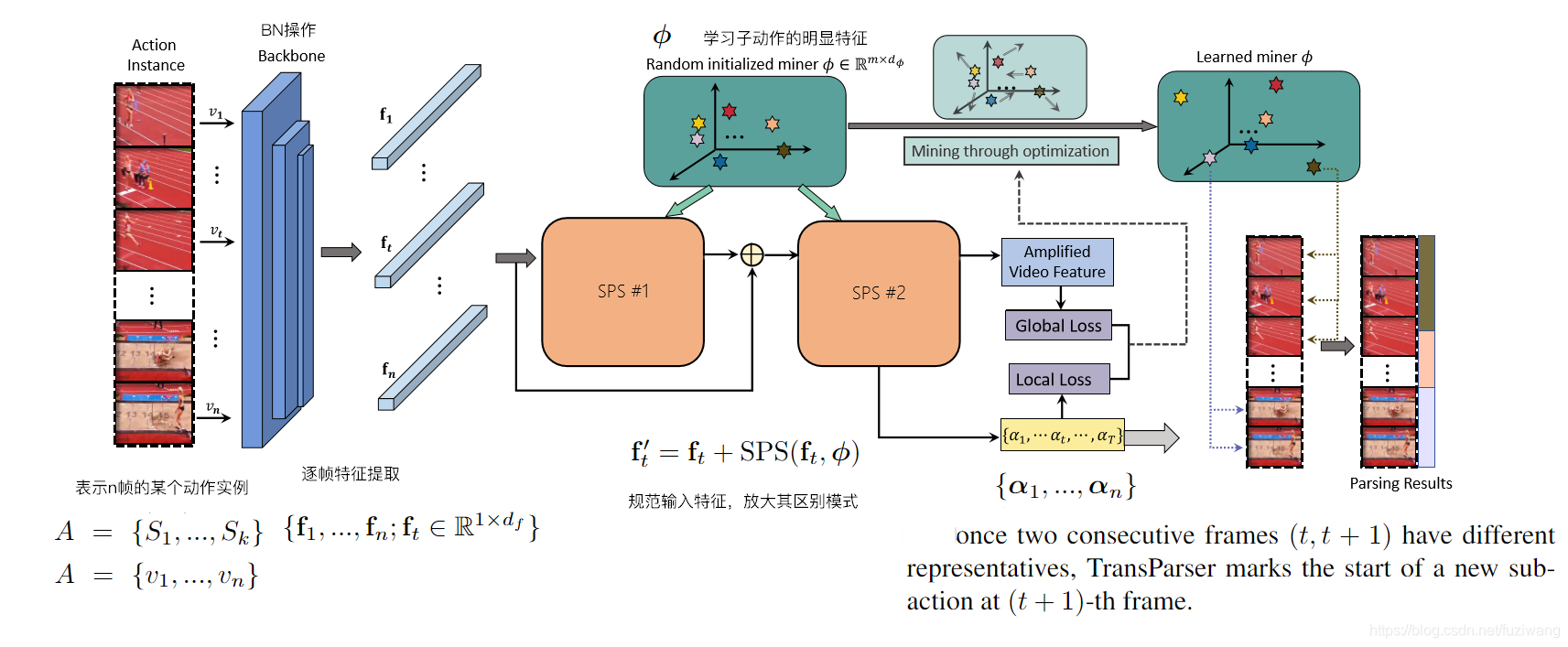

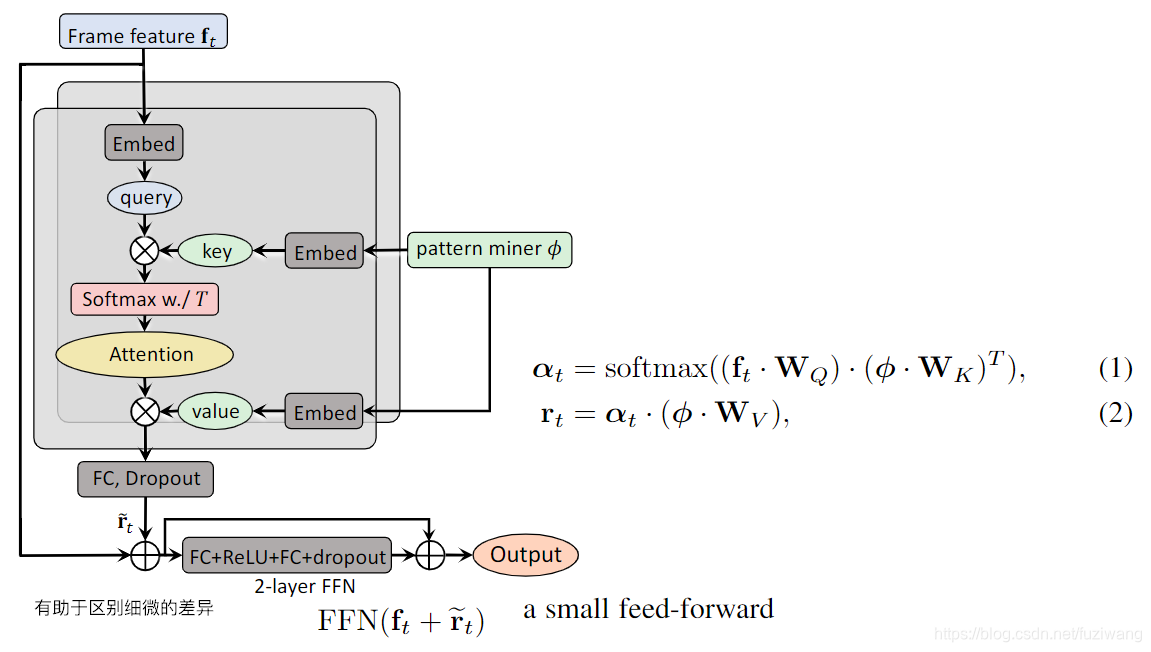

一种改进的时间动作解析框架(基于Transformer),它为进一步的动作内部和动作之间的理解提供了额外的能力。

2. 相关工作

Datasets

-

only class labels:

- KTH, Weizmann, UCFSports, Olympic

- UCF101, HMDB51, Sports1M, Kinetics

-

boundaries of actions in untrimmed video:

- THUMOS’15, ActivityNet, Charades, HACS, AVA

-

finegrained annotations for action instances(author’s): 动作实例的细粒度注释

- Salads, Breakfast, MPIICooking, JIGSAWS

Tasks

- 行为识别,给定一个行为一个标签,在untrimmed video中给定行为定位

- 对动作实例的内部结构的详细了解,特别是在时间维度上(TAP/TAS)

- TAP仅提供了子动作之间的边界,而这些边界的监督作用却明显较弱

- TAS的目标是在一组预定义的子动作中标记动作实例的每一个框架,这些子动作可以在一个监督下完成

3. 数据集TAPOS

-

关注于奥林匹克运动,奥运动作具有丰富的子动作,格式宽松但内部结构多种多样,因此鼓励模型以数据驱动的方式利用内部动作。 此外,同一奥林匹克运动的实例具有一致且干净的背景,使模型专注于运动本身

-

样本可确保覆盖完整的动作实例,而镜头不会发生变化。

sample=(class_lable,the_ranges_of_subactions)子动作的粒度为二级粒度 sample = (class\_lable,the\_ranges\_of\_subactions) 子动作的粒度为二级粒度 sample=(class_lable,the_ranges_of_subactions)子动作的粒度为二级粒度

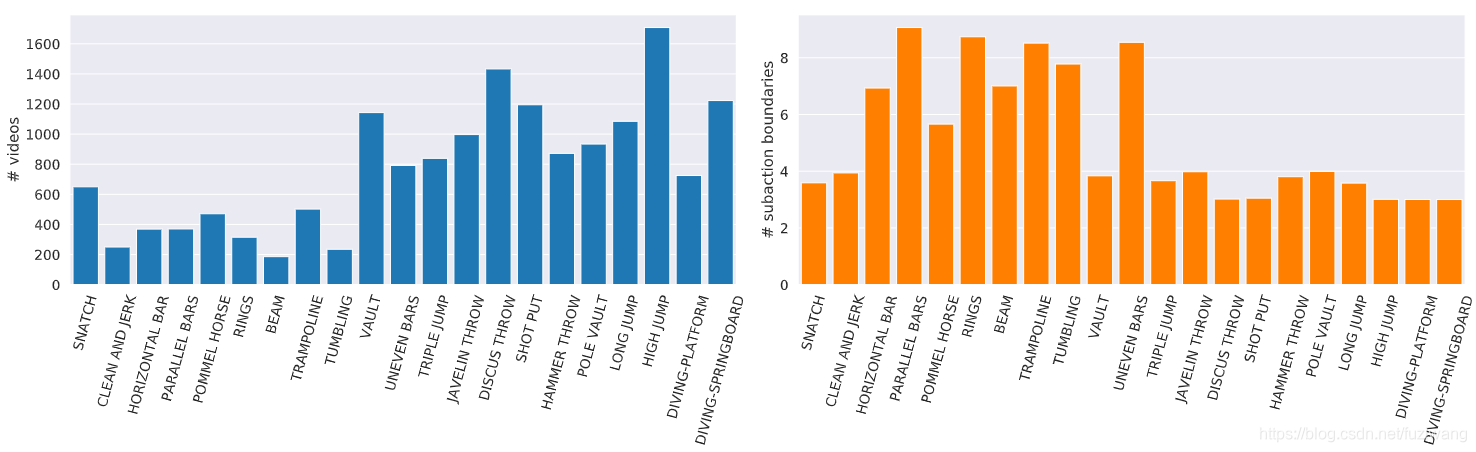

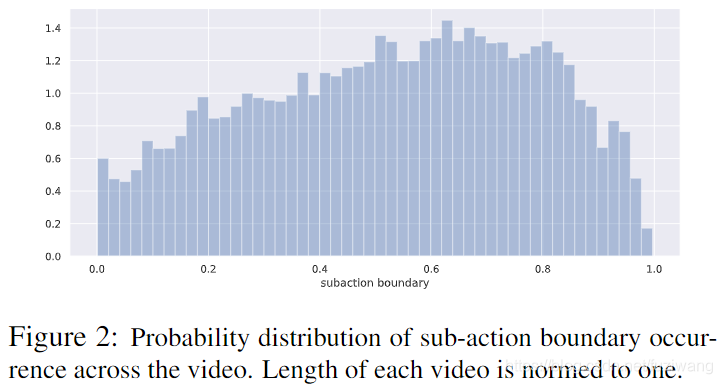

TAPOS contains 16,294 valid instances in total, across 21action classes. These instances have a duration of 9.4 seconds on average. The number of instances within each class is different, where the largest class high jump has over 1,600 instances, and the smallest class beam has 200 instances. The average number of sub-actions also varies from class to class, where parallel bars has 9 sub-actions on average, and long jump has 3 sub-actions on average.

4. 子动作分析

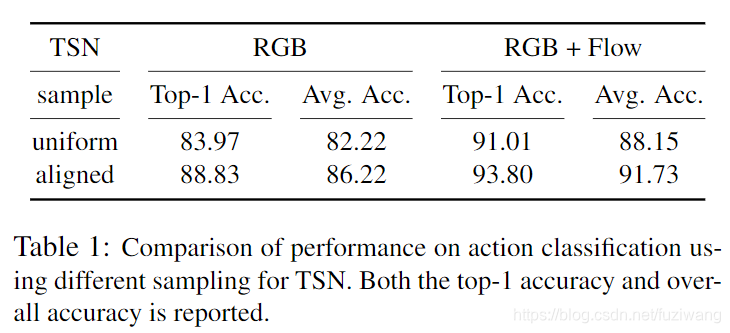

-

持续均匀的时间段

-

与带注释的子操作对齐的时间段

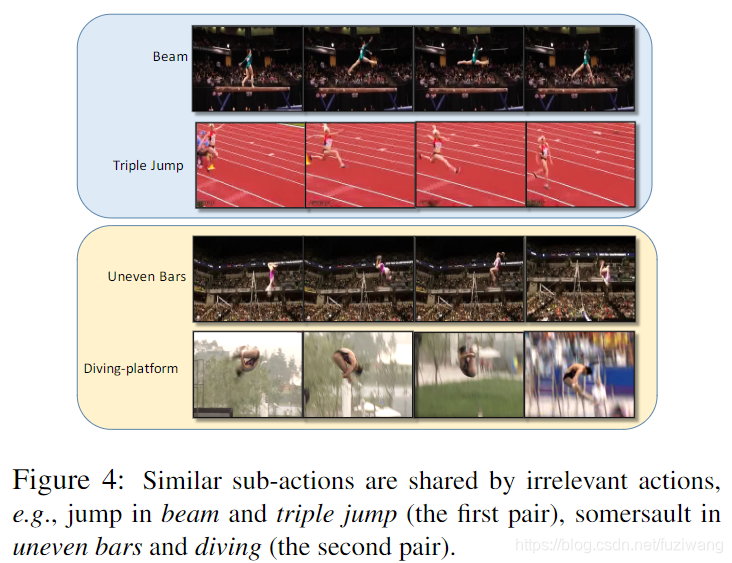

即使对于乍一看似乎完全不同的那些动作,不同动作类中的子动作也可以相似。

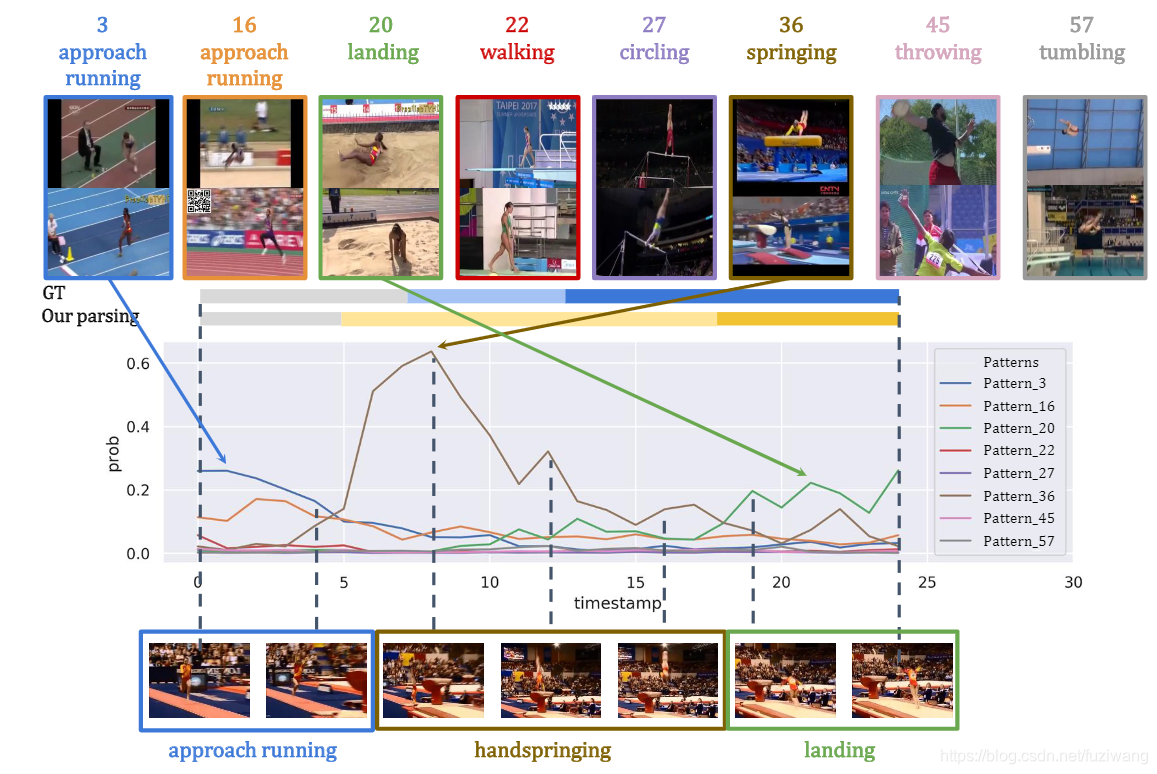

5. 时序动作解析

A=v1,...,vn=S1,...,SkA={v_1,...,v_n}={S_1,...,S_k}A=v1,...,vn=S1,...,Sk where Si=vti,...,vti+1−1Si={v_{t_i},...,v_{t_i+1−1}}Si=vti,...,vti+1−1

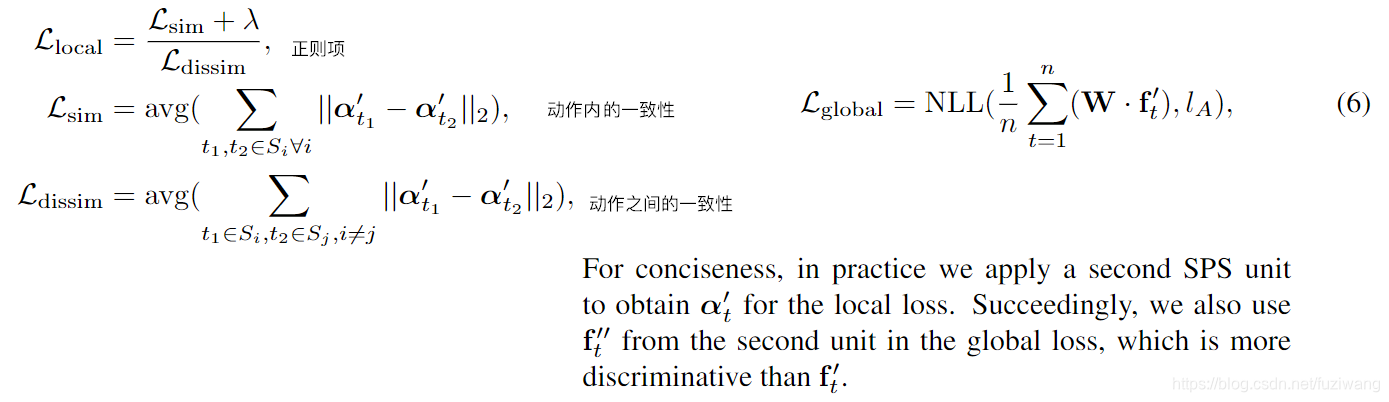

优化设计:两个损失函数

-

local loss:为了帮助模式挖掘者在动作框架的特征中捕获信息模式,应用语义损失来最大化子动作内的框架之间的一致性,同时抑制子动作之间的一致性

-

global loss:行为类别分类的损失

NLLLoss的结果就是把上面的输出与Label对应的那个值拿出来,再去掉负号,再求均值。

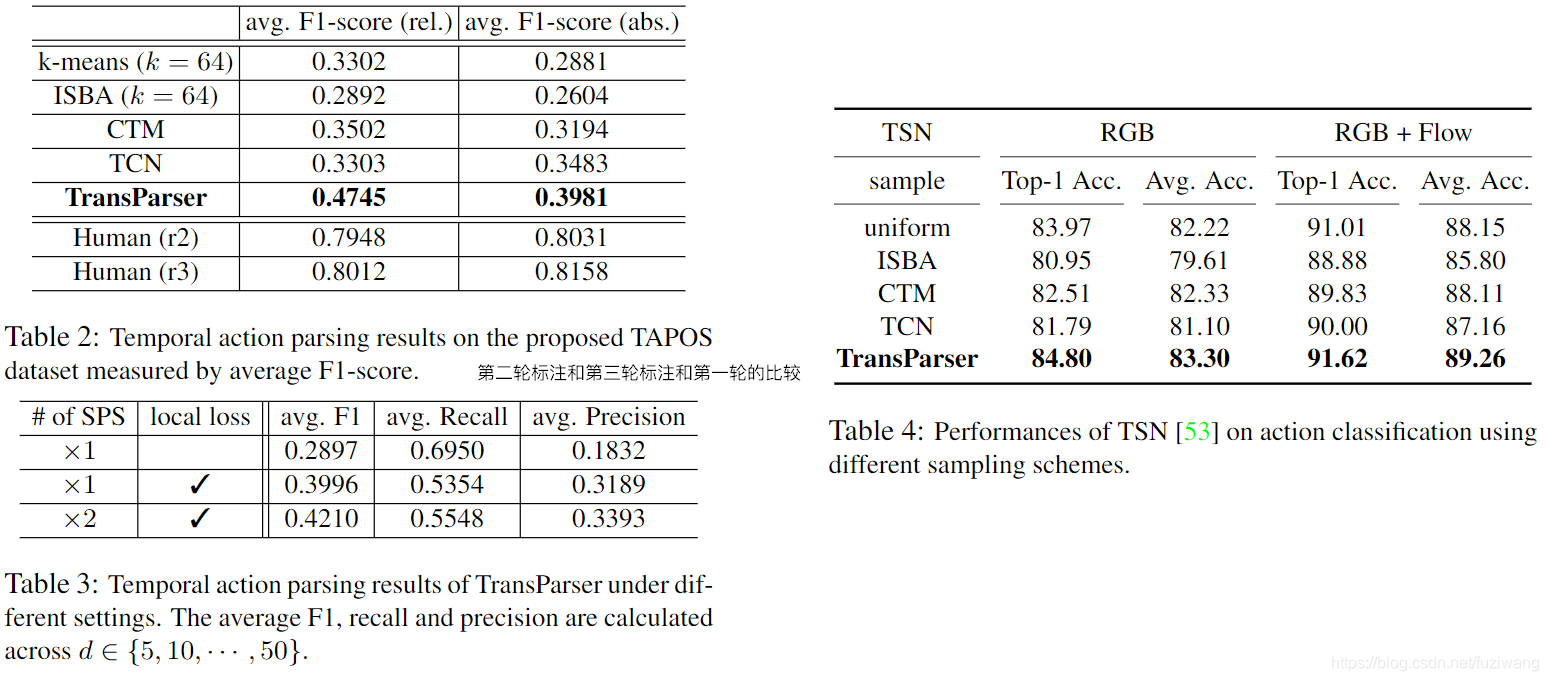

6. 实验结果分析

召回率、精准率、F1值:

Baseline:

TCN(时序卷积神经网络)、ISBA、CTM

定量分析:

- F1值方面比baseline有很大的优势,与人类的表现相比,还有很大的差距,还有很大的提升空间(Table2)

- TCN和CTM有高的recall,但是有低的prec,表明这些方法遭受严重的过度解析,表明它们过于关注局部差异

- ISBA performs poorly on recalls but yield higher precision than CTM and TCN,可能会捕获这种从粗到精的方式并且无法利用内部行为信息

- increase the distance,baseline的快速饱和

- the crucialrole of local semantic loss

- increasing the number of SPS Units

定量分析:

672

672