按顺序执行以下操作

1.在hdfs中创建文件夹:/itcast/test,如存在请删除(跳过回收站)

2.上传/etc/hosts文件到hdfs的/itcast/test内

3.查看hdfs中刚刚上传的文件内容

4.向hdfs中上传的文件追加:test到最后一行

5.下载hdfs中上传的文件到本地任意目录

6.在hdfs中创建文件夹:/itcast/bigdata,将/itcast/test/hosts文件复制到/itcast/bigdata内

7.将/itcast/test/hosts文件重命名为/itcast/test/myhost

8.删除/itcast文件夹

一,操作结果如下:

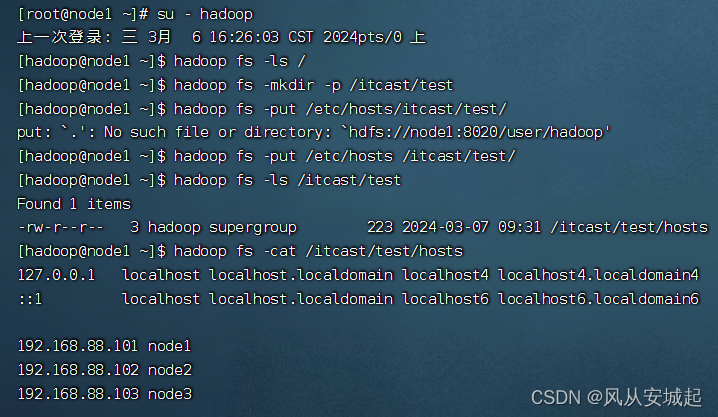

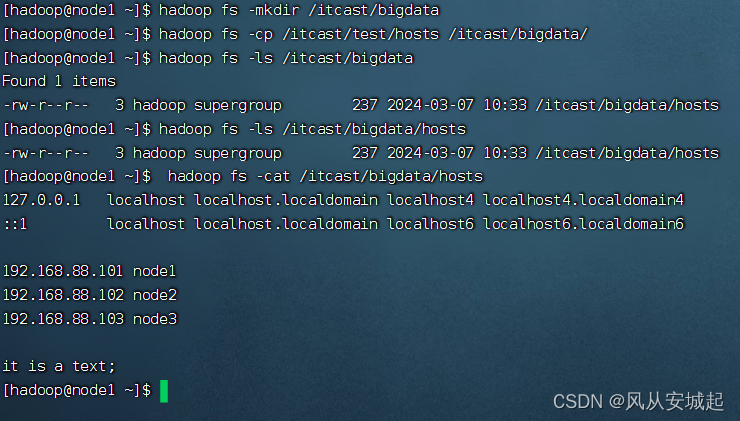

1.创建文件夹,并上传文件以及查看文件内容

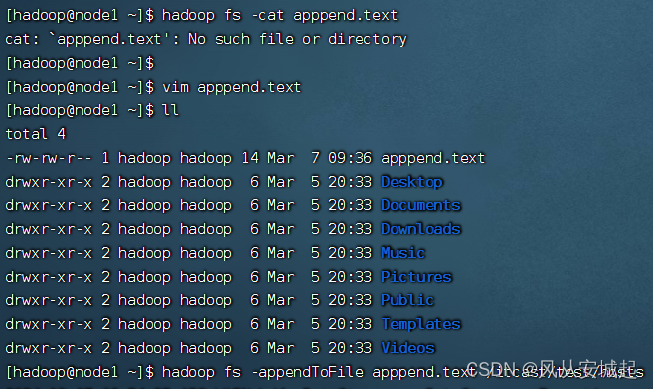

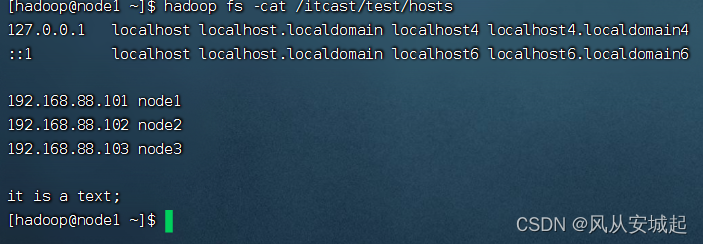

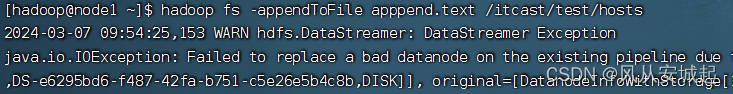

2.编写一个apppend.text文件,追加到test文件

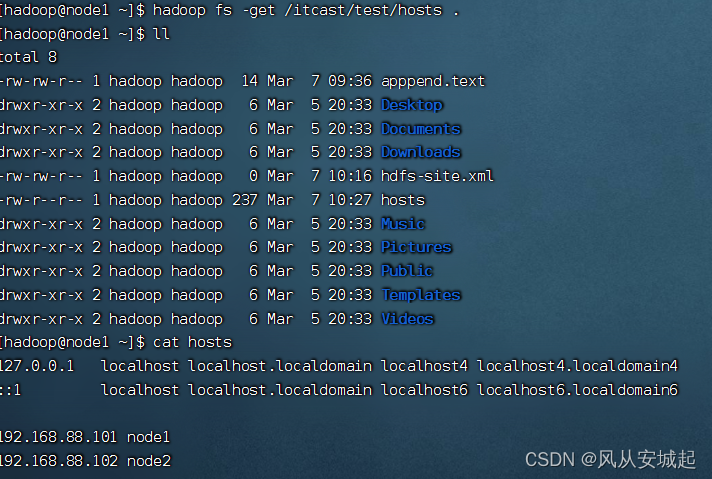

3.下载编写好的hosts文件

4.新建一个文件夹,并讲hosts文件复制到新建文件夹

5.将hosts文件重命名为myhost

6.删除/itcast文件夹

二,操作中间出现的问题:

当我想对文件进行追写时,它报错:

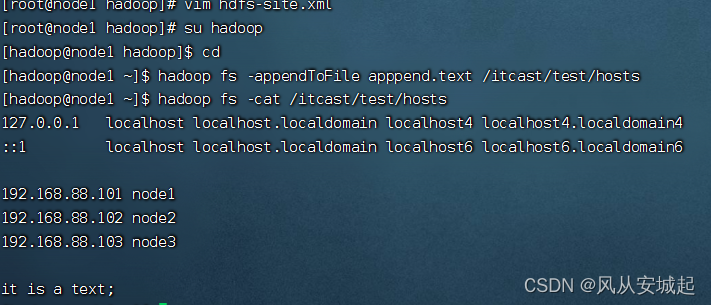

在站内搜索了一下发现好像是当一个DataNode写入失败时,为了保持DataNode的个数一致,会寻找其他的节点,继续写入,我总共只有三个DataNode节点,可以在hdfs-site.xml 文件中添加下面几行代码:

<property>

<name>dfs.client.block.write.replace-datanode-on-failure.policy</name>

<value>NEVER</value>

</property>

最后就可以解决了

注意这里需要切到root里进行操作,找到自己的配置文件的路径开始进行,我的是

/export/server/hadoop/etc/hadoop

本文详细描述了在HDFS中进行文件夹创建、文件上传、内容查看、追加、下载,以及遇到写入错误时如何调整配置解决问题的过程。作者还推荐了一篇关于HDFS基本操作命令的文章供读者参考。

本文详细描述了在HDFS中进行文件夹创建、文件上传、内容查看、追加、下载,以及遇到写入错误时如何调整配置解决问题的过程。作者还推荐了一篇关于HDFS基本操作命令的文章供读者参考。

3199

3199

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?