机器学习深版06:支持向量机SVM

文章目录

1. 各种概念分类

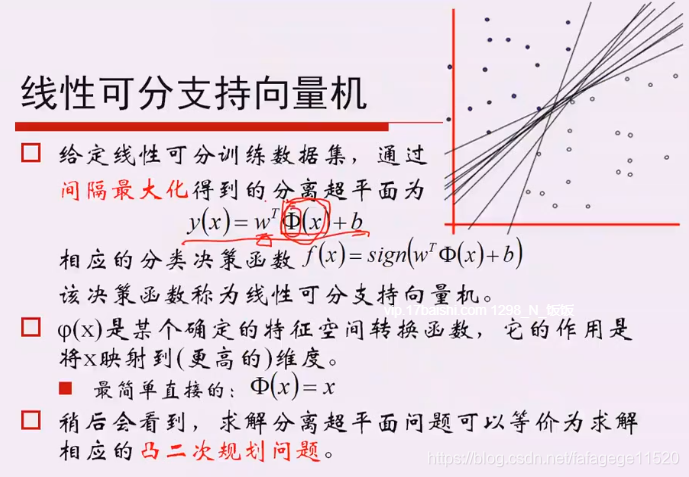

1. 线性可分的SVM(样本不会在分割面上出现)

1. 简单概念

如何理解这个式子:

+1是法线的正方向,-1是法线的负方向

2. SVM不同参数

伽马越大,越接近曲面,越小越像线性的。

c:越大过渡带越窄。

3. 深入理解

就是参数不为零的点,就是一些关键性的点,作为支持。

让距离线最近的点,使得他们的距离求最大。(最大最小问题)

1. 输入数据

做一个特征映射:

sign:符号函数

注意有约束条件:

在约束条件的约束下,得到较好看的目标函数:

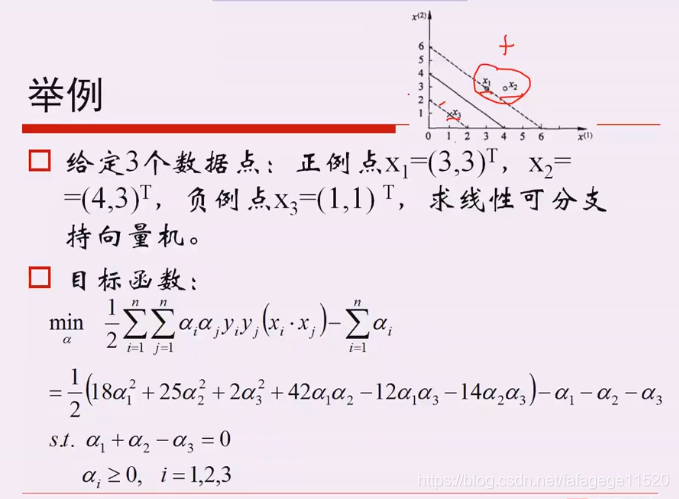

4. 举例:

2. 线性SVM

1.原因:

噪声数据、有些线性不可分

2. 基本概念

特别大的C,就说明无法容忍犯错误,就退化成了标准的SVM。c大过渡带窄,c小过渡带宽,它的泛化能力更强。

所有样本的损失和取最小,得到w和b,回过头来理解,右边就像是损失函数,左边是L2正则。

3. 核函数

核函数:是映射关系 的内积,映射函数本身仅仅是一种映射关系,并没有增加维度的特性,不过可以利用核函数的特性,构造可以增加维度的核函数,这通常是我们希望的。

左图为原数据,右图为映射到三维的数据,可以看出:同样是降到1维,先通过Kernel映射到(Kernel是映射的内积,不要弄乱了)三维,再投影到1维,就容易分离开,这就是Kernel在PCA降维中的应用,本质还是对原有数据增加维度。

2. 分类器指标补充

本文围绕机器学习中的支持向量机SVM展开。介绍了线性可分的SVM,包括简单概念、不同参数及深入理解,还举例说明;阐述了线性SVM的原因和基本概念;讲解了核函数,其可增加数据维度利于分离。最后补充了分类器指标。

本文围绕机器学习中的支持向量机SVM展开。介绍了线性可分的SVM,包括简单概念、不同参数及深入理解,还举例说明;阐述了线性SVM的原因和基本概念;讲解了核函数,其可增加数据维度利于分离。最后补充了分类器指标。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?