以下内容均为https//nndl.github.io/nndl-book.pdf的学习笔记。

激活函数

性质

为了增强网络的表示能力和学习能力,激活函数需要具备以下几点性质:

(1) 连续并可导(允许少数点上不可导)的非线性函数.可导的激活函数可以直接利用数值优化的方法来学习网络参数.

(2) 激活函数及其导函数要尽可能的简单,有利于提高网络计算效率.

(3) 激活函数的导函数的值域要在一个合适的区间内,不能太大也不能太小,否则会影响训练的效率和稳定性.

总结:非线性、连续可微、范围最好不饱和、单调性、原点处近似线性

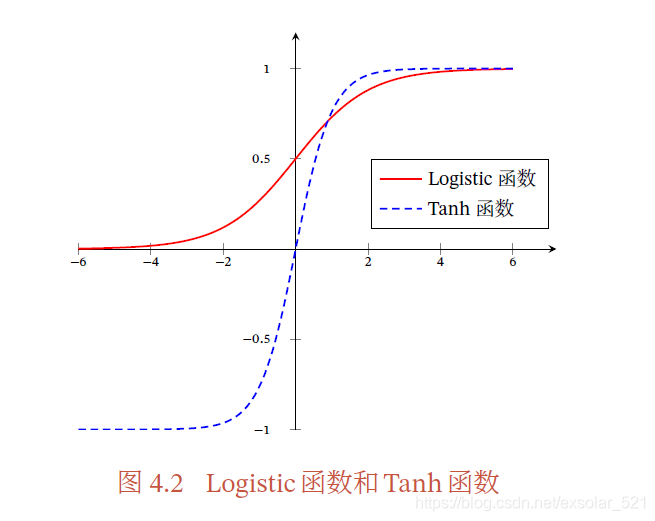

sigmoid型

两端饱和型S 型曲线函数,.常用的Sigmoid型函数有Logistic 函数和Tanh 函数。

logister

𝜎′(𝑥) = 𝜎(𝑥)(1 − 𝜎(𝑥)).

当输入值在0 附近时,Sigmoid 型函数近似为线性函数;当输入值靠近两端时,对输入进行抑制.输入越小,越接近于0;输入越大,越接近于1.

**性质:**1)其输出直接可以看作概率分布,使得神经网络可以更好地和统计学习模型进行结合.2)其可以看作一个软性门(Soft Gate),用来控制其他神经元输出信息的数量.

tanh

Tanh 函数可以看作放大并平移的Logistic 函数,其值域是(−1, 1).

对比:Tanh 函数的输出是零中心化的(Zero-Centered),而Logistic函数的输出恒大于0.非零中心化的输使得其后一层的神经元的输入发生偏置偏移(Bias Shift),并进一步使得梯度下降的收敛速度变慢.

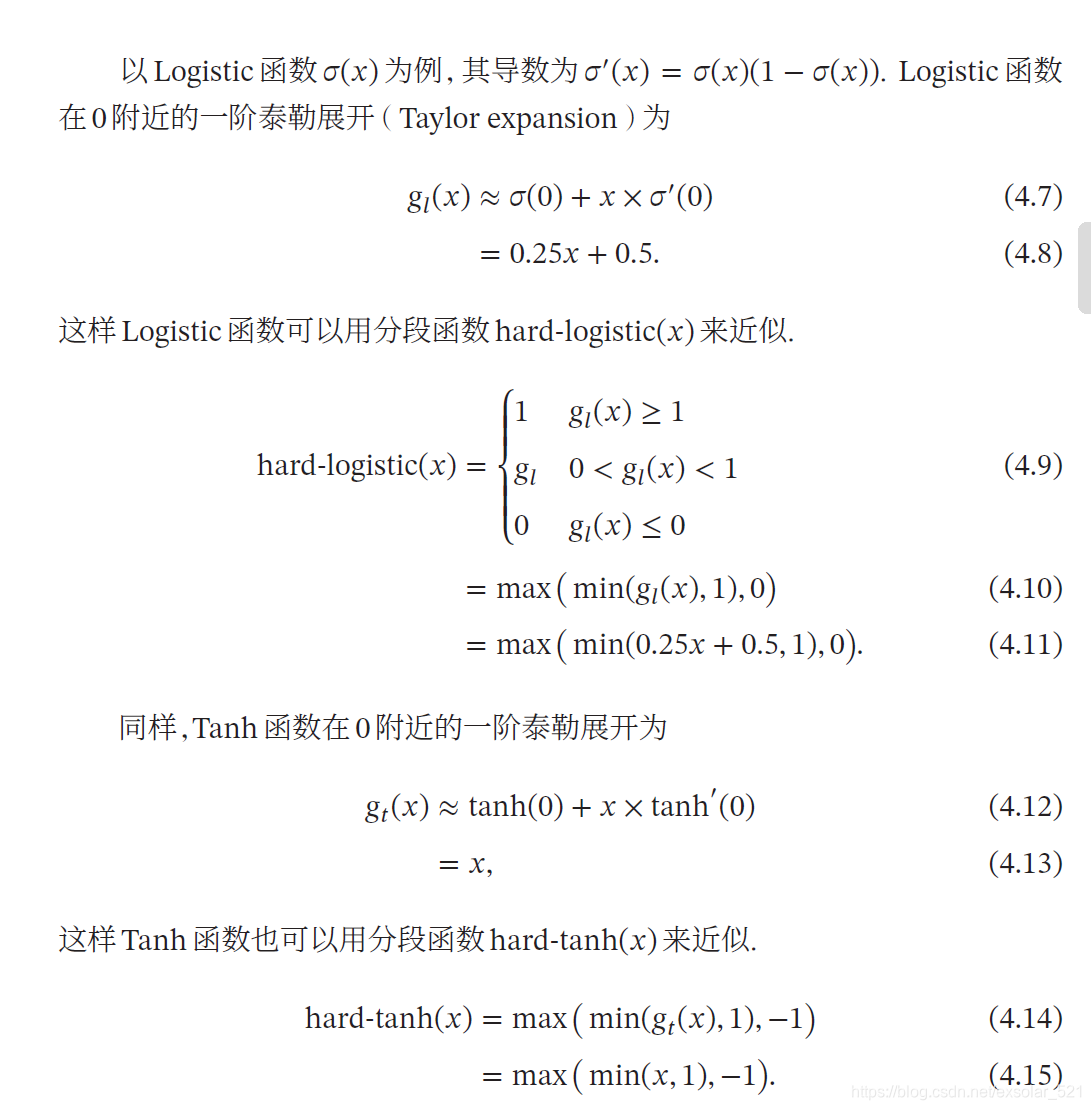

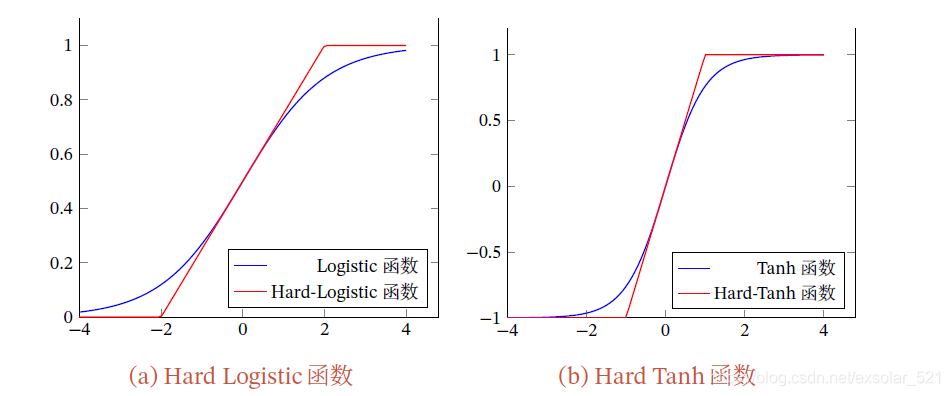

Hard logister/tanh

sigmoid函数中间线性,两端饱和,计算开销较大,可以用分段函数近似。

sigmoid函数会导致一个非稀疏的神经网络,收敛速度慢。会出现梯度消失问题。

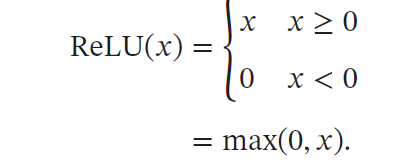

ReLU(Rectified Linear Unit,修正线性单元

ReLU(Rectified Linear Unit,修正线性单元),也叫Rectifier 函数,是目前深度神经网络中经常使用的激活函数,定义为:

优点:

1)ReLU 函数为左饱和函数,且在𝑥 > 0 时导数为1,在一定程度上缓解了神经网络的梯度消失问题,加速梯度下降的收敛速度.

2)𝑥 <0 时值为0,减少依赖,降低网络稠密性

3)ReLU 却具有很好的稀疏性,大约50% 的神经元会处于激活状态.

缺点:

1)ReLU 函数的输出是非零中心化的,给后一层的神经网络引入偏置偏移,会影响梯度下降的效率。

2)死亡ReLU问题(Dying ReLU Problem):,如果参数在一次不恰当的更新后,第一个隐藏层中的某个ReLU 神经元在所有的训练数据上都不能被激活,那么这个神经元自身参数的梯度永远都会是0,在以后的训练过程中永远不能被激活。

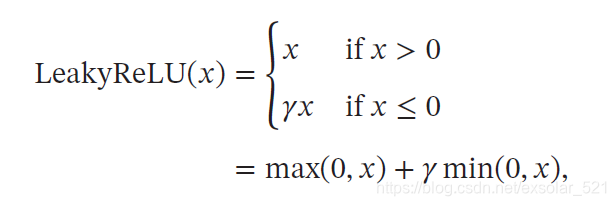

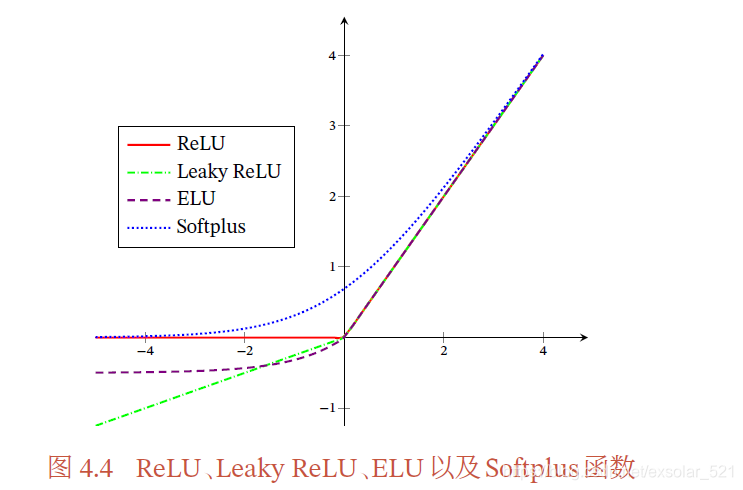

LRelu

**带泄露的ReLU(Leaky ReLU)😗*在输入𝑥 < 0 时,保持一个很小的梯度𝛾.这样当神经元非激活时也能有一个非零的梯度可以更新参数,避免永远不能被激活。

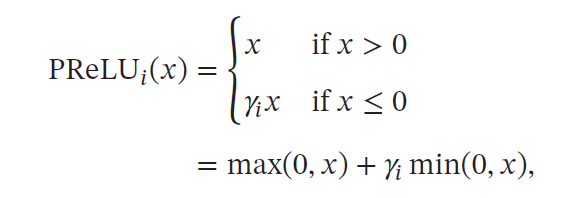

PRelu

**带参数的ReLU(Parametric ReLU,PReLU)**引入一个可学习的参数,不同神经元可以有不同的参数.对于第𝑖 个神经元,其PReLU 的定义为:

PReLU 可以允许不同神经元具有不同的参数,也可以一组神经元共享一

个参数.

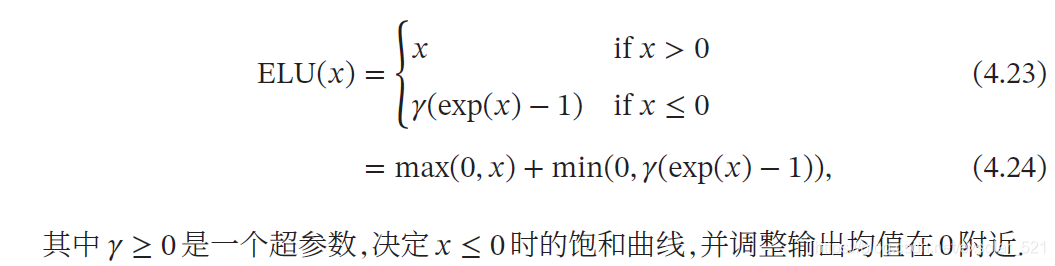

Elu

**ELU(Exponential Linear Unit,指数线性单元)**是一个近似的零中心化的非线性函数,其定义为:

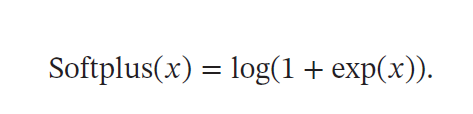

softplus

Softplus 函数其导数刚好是Logistic 函数.Softplus 函数虽然也具有单侧抑制、宽兴奋边界的特性,却没有稀疏激活性.

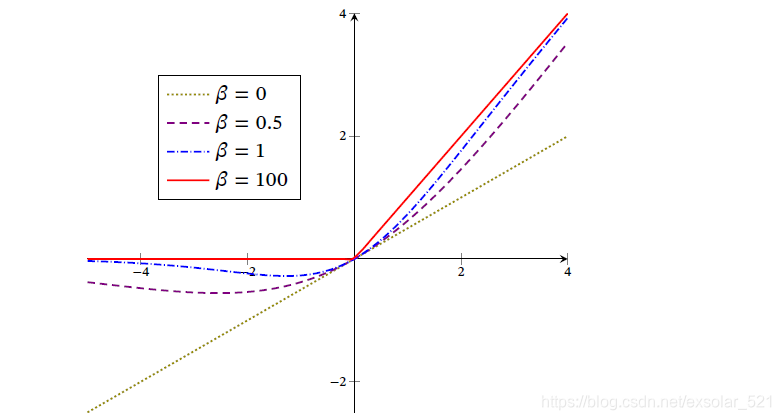

Swish

Swish 函数是一种自门控(Self-Gated)激活函数,定义为:

看作线性函数和ReLU 函数之间的非线性插值函数,其程度由参数𝛽 控制.

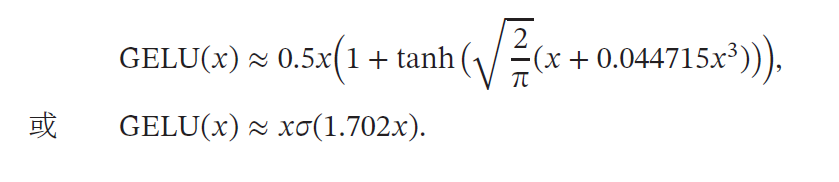

Gelu

**GELU(Gaussian Error Linear Unit,高斯误差线性单元)**也是一种通过门控机制来调整其输出值的激活函数,和Swish 函数比较类似.

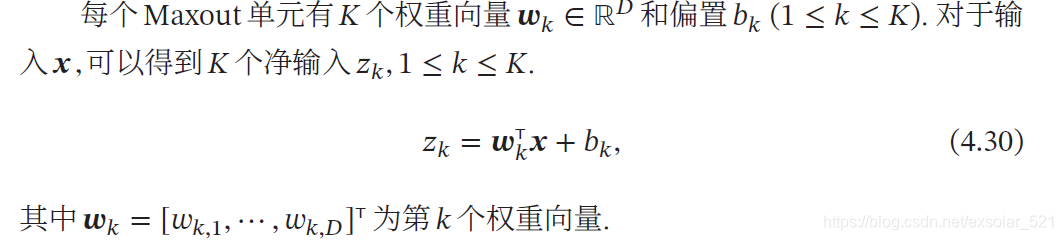

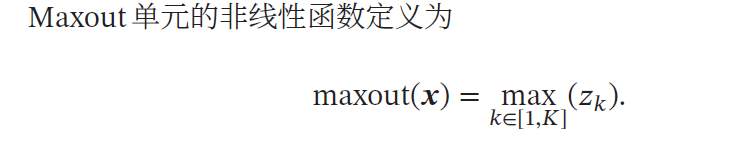

Maxout

Maxout 单元 也是一种分段线性函数. 采用Maxout 单元的神经网络也叫作Maxout网络.Sigmoid 型函数、ReLU 等激活函数的输入是神经元的净输入𝑧,是一个标量.而Maxout 单元的输入是上一层神经元的全部原始输出,是一个向量𝒙 = [𝑥1; 𝑥2; ⋯ ; 𝑥𝐷].

Maxout 单元不单是净输入到输出之间的非线性映射,而是整体学习输入到输出之间的非线性映射关系.Maxout 激活函数可以看作任意凸函数的分段线性近似,并且在有限的点上是不可微的.

本文深入探讨了激活函数在神经网络中的作用,包括Sigmoid、Tanh、ReLU及其变种的特性与优缺点,揭示了它们如何影响网络的学习能力和计算效率。

本文深入探讨了激活函数在神经网络中的作用,包括Sigmoid、Tanh、ReLU及其变种的特性与优缺点,揭示了它们如何影响网络的学习能力和计算效率。

5533

5533

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?