前言

经常会无网环境部署项目,导致每次镜像下载等很烦恼,所以特此整理当前资料进行方便rancher的部署

配置至少需要以下配置至少需要以下(当前主安装服务器竟可能配置高一些,硬盘大点,因镜像私服也在此服务器上)

cpu:4

内存:8G

硬盘:100G

以下步骤安装环境为离线无网络centos7.9 最小化安装 全新的机器上部署。直接运行脚本无人值守安装

当前安装rancher版本为2.5.9

目录结构如下

- 编辑config,配置文件所在

#当前脚本所在路径

export DIR="$(cd "$(dirname "$0")" && pwd)"

echo $DIR

#docker存储位置 docker当前镜像与运行容器存储位置,建议空间需要大一点

export DOCKER_LOCAL=/var/lib/docker

#docker私服部署方式,只有nexus部署方式与harbor方式 建议采用nexus方式部署docker私服,harbor存在网卡冲突问题,除非单独部署一台harbor

export DOCKER_REGISTRY_TYPE=nexus

#doker镜像仓库地址 如果存在端口需要在后面添加如 127.0.0.1 下面的证书的hostname需要与此ip一致 配置 如是本地域名需在各个服务器的/etc/host添加映射到harbor所在服务器ip 最好不要80端口,除非是单独部署一台服务器

export DOCKER_REGISTRY=$DOCKER_REGISTRY_TYPE.local.com:802

###################################harbor相关参数#################

#harbor拷贝的位置,位置设置大一点

export HARBOR_LOCAL=/home/harbor

#harbor日志位置

export HARBOR_LOG=$HARBOR_LOCAL'/log'

#harbor数据存储位置

export HARBOR_DATA=$HARBOR_LOCAL'/data'

#证书存储位置

export HARBOR_CERTS_CRT=$HARBOR_LOCAL'/certs/domain.crt'

export HARBOR_CERTS_KEY=$HARBOR_LOCAL'/certs/domain.key'

#harbor admin账户登录的密码

export HARBOR_ADMIN_PWD=admin@123

#harbor.yml的位置 一般不变

export harbor_local=$HARBOR_LOCAL/harbor.yml

export harbor_local_tmp=$HARBOR_LOCAL/harbor.yml.tmp

###################################harbor相关参数#################

###################################nexus相关参数#################

#/**nexus所在服务器ip地址,需进行指定正确**********重点需要更改ip为自己的ip*/

export NEXUS_IP_ADDRESS=10.211.55.30

#nexus拷贝的位置,位置设置大一点

export NEXUS_LOCAL=/home/nexus

#此处密码不会自动设置,nexus启动好后自行修改密码为此

export NEXUS_PASSWORD=admin123

###################################nexus相关参数#################

#rancher运行的端口

export RANCHER_HTTP_PROT=800

export RANCHER_HTTPS_PROT=4443

#rancher数据存储路径

export RANCHER_DATA_DIR=/home/rancher

- 假如harbor的域名更换后,需要重新执行create_crt.sh生成证书,或者云证书,执行create_crt.sh会生成到/当前目录/harbor/certs中,如无需,请在当前主机或其他主机的/etc/host中添加如下内容(假如当前安装的主机ip为:192.168.0.1)

192.168.0.1 $DOCKER_REGISTRY_TYPE.local.com

或执行

echo '192.168.0.1 $DOCKER_REGISTRY_TYPE.local.com' >> /etc/host

-

先执行

sh install.sh(如当前机器只需要安装harbor则只需要执行此项即可,后面步骤可忽略) -

登录https:// D O C K E R R E G I S T R Y T Y P E . l o c a l . c o m (如果是 n e x u s 私服,对应访问链接地址默认为: h t t p s : / / DOCKER_REGISTRY_TYPE.local.com (如果是nexus私服,对应访问链接地址默认为:https:// DOCKERREGISTRYTYPE.local.com(如果是nexus私服,对应访问链接地址默认为:https://DOCKER_REGISTRY_TYPE.local.com:8343) 创建仓库项目rancher与oher(harbor方式搭建的需要创建项目如若不创建镜像将无法上传到仓库,nexus方式搭建的私服需要进入后创建对应的docker访问地址,参考:https://blog.youkuaiyun.com/supertor/article/details/83146596 默认上述配置文件端口为:802)

-

步骤三执行无误后即可进行加载镜像,执行

sh loadImage.sh启动rancher的服务命令在此脚本中 -

rancher-images.tar.gz包含rancher运行基础镜像

-

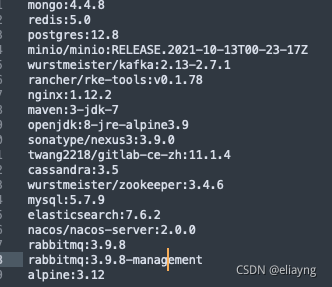

oher-images.tar.gz包含镜像列表如下:

-

执行无误之后,浏览器输入https://192.168.0.1:4443/ 即可访问rancher

-

rancher界面打开后即可创建k8s集群,目前所包含镜像包只支持创建k8s集群版本为

1.18.20-rancher1-2以下 -

单节点rancher 的容灾不是很高。请注意,集群不要开太多

rancher备份脚本

自行创建sh脚本,放入crontab中定时使用

#! /bin/sh

#前提需存在zip压缩命令,如没有到rmp中安装,记得给此脚本执行权限chmod +x back.sh,写好脚本后,执行 crontab -e 添加 00 3 * * * /root/back.sh #3点执行,以下脚本依据实际情况进行调整

#备份rancher

RANCHER_NAME=gracious_kalam

backpath=/home/bak

neet_rancher_path=/home/rancher

neet_etcd_path=/var/lib/etcd

docker stop $RANCHER_NAME

DATE=$(date +"%Y%m%d%H%M%S")

#备份rancher

mkdir -p ${backpath}/rancher_bak

tar -czf ${backpath}/rancher_bak/rancher_${DATE}.tar.gz ${neet_rancher_path}

# 保留的文件数量

KEEP_COUNT=20

# 待清理的目录

TARGET_PATH=${backpath}/rancher_bak

FILE_COUNT=$(find ${TARGET_PATH} -type f | wc -l)

# 当待清理的目录文件数量大于要保留的数量时才进行清理

if [ ${FILE_COUNT} -gt ${KEEP_COUNT} ]; then

ls -lt ${TARGET_PATH} | tail -n $((`find ${TARGET_PATH} -type f | wc -l` - ${KEEP_COUNT})) | awk '{print $NF}' | xargs -i rm -f ${TARGET_PATH}/{}

fi

#备份本地etcd

mkdir -p ${backpath}/etcd_bak

tar -czf ${backpath}/etcd_bak/etcd_member_${DATE}.zip ${neet_etcd_path}

# 待清理的目录

TARGET_PATH=${backpath}/etcd_bak

FILE_COUNT=$(find ${TARGET_PATH} -type f | wc -l)

# 当待清理的目录文件数量大于要保留的数量时才进行清理

if [ ${FILE_COUNT} -gt ${KEEP_COUNT} ]; then

ls -lt ${TARGET_PATH} | tail -n $((`find ${TARGET_PATH} -type f | wc -l` - ${KEEP_COUNT})) | awk '{print $NF}' | xargs -i rm -f ${TARGET_PATH}/{}

fi

docker start $RANCHER_NAME

rancher-2.5.9下载地址(建议使用2.5.16版本)

链接: https://pan.baidu.com/s/1mIYBcwtgOyMXMZwGOKUsTA?pwd=iuwh 提取码: iuwh

–来自百度网盘超级会员v6的分享

rancher-2.5.16下载地址

链接: https://pan.baidu.com/s/1Mo-gWbtSNJAie2dSFJ_UEw?pwd=28e2 提取码: 28e2

–来自百度网盘超级会员v6的分享

本文提供了一种在无网络环境中部署Rancher的方法,并详细介绍了所需的配置、镜像加载及备份脚本等内容。

本文提供了一种在无网络环境中部署Rancher的方法,并详细介绍了所需的配置、镜像加载及备份脚本等内容。

1520

1520

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?