用于实时和远程不适检测的婴儿监控系统

摘要

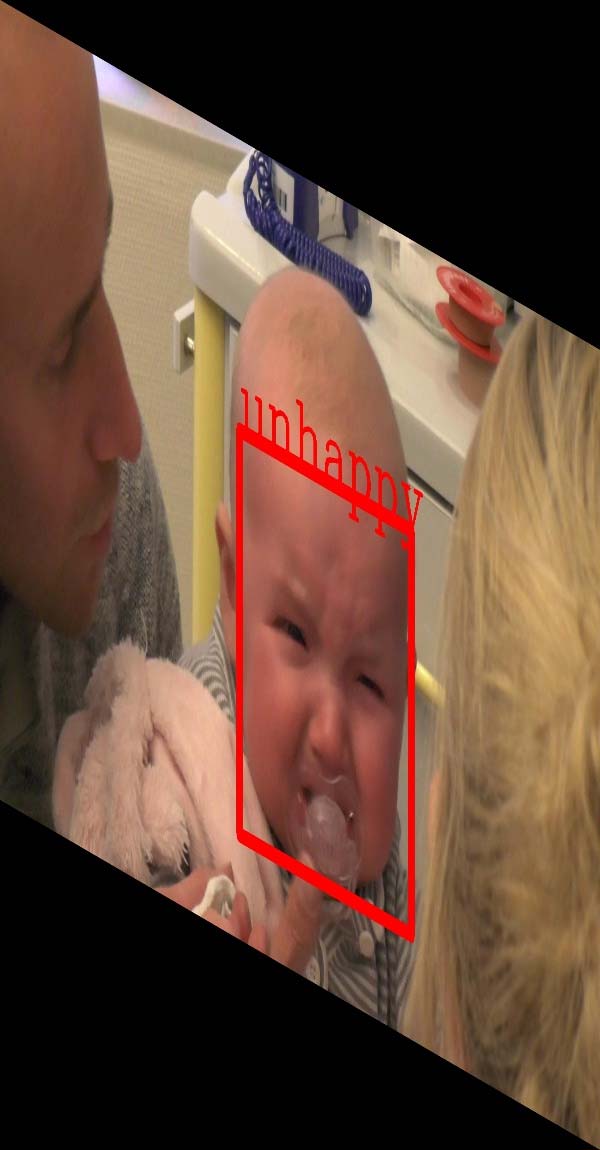

婴儿监测在日常生活中非常重要,因为婴儿缺乏与看护人进行语言表达和沟通的能力。然而,由看护人或医护人员提供的全天候监测非常昂贵且耗费人力。为解决夜间特定监测的实际困难并进一步降低人工成本,本文提出了一种新型的24小时婴儿监控系统,该系统利用RGB和近红外光(NIR)视频实现对婴儿不适检测的连续监测。所提出的算法对任意头部旋转、遮挡和面部轮廓均具有鲁棒性。为此,首先使用ImageNet数据集对Faster R‐CNN架构进行预训练,然后使用包含不同婴儿表情的特定训练数据集进行微调。我们所提出的方法在分类不适表情方面达到了超过87%的平均精度。本文首次提出了利用近红外视频进行夜间婴儿监测,所展示的系统能够实现反流疾病分析以及在更轻松环境下的连续远程家庭监护,这受到儿科医生和父母的广泛青睐。

关键词 —婴儿监测,实时应用,Faster R‐CNN,近红外视频。

一、引言

PAIN 对婴儿或新生儿的疼痛评估至关重要,因为新生儿由于对急性疼痛产生的生理和代谢反应,可能会对其神经和行为发育产生长期的负面影响[1]。除了这些负面影响之外,婴儿表现出的疼痛时刻还可作为某些疾病的指征,例如胃食管反流病(GERD),这是婴儿中最常见的疾病。

然而,尽管疼痛对新生儿具有不良影响且影响重大,在过去几十年中,其治疗和评估常常不足[2]。原因是婴儿疼痛评估较为困难且存在争议,因为他们仅能通过非语言方式进行交流,无法表达自身感受。为应对这一挑战,研究人员开发并验证了多种疼痛评分系统[3],[4],旨在评估疼痛评估。然而,这些系统需要医护人员在一定时间内观察婴儿以进行疼痛评分,这既费力又耗时。此外,对于某些疾病的诊断,需要进行持续性疼痛评估。例如,胃食管反流病(GERD)要求儿科患者住院接受对其不适的持续监测,旨在测量反流情况和由专业人员评估的疼痛程度。然而,基于上述疼痛评分工具实施此类不适测量是不切实际的,因为由医护人员进行的这种持续监测成本过高。结论:结合疼痛分析的疾病诊断需要大量的临床资源。作为一种替代方案和解决办法,基于视频的自动化不适检测系统将带来多种机会。第一,它能够实现对婴儿的持续观察,并将所需的临床监护减少到仅针对疼痛或不适事件的发生时刻;第二,它提供了疼痛持续时间的客观测量,可用于治疗计划;第三,也是最具吸引力的一点,它能够为病情较轻的患者实现家庭远程监控,为婴儿提供更轻松的环境,这也是父母普遍所期望的;第四,最终,它可以在家中提示与反流相关的症状,同时在医院由专业人员诊断胃食管反流病,从而避免婴儿长期住院。

然而,要开发这样的系统需要解决若干挑战。首先,即使婴儿的头部姿态相对于摄像头视角存在较大偏差,系统也应能够执行人脸检测。其次,用于婴儿表情分析的公开数据集较为稀缺,导致训练和验证鲁棒的不适检测系统变得难以实现。第三,该系统应能24小时工作,尤其是在夜间,因为相比白天,婴儿在夜间通常较少得到父母或医护人员的照护。最后但同样重要的是,完整系统(包括不适分类)应能够在面部被物体部分遮挡的情况下检测表情。

针对这些挑战的解决方案,我们采用了基于学习网络的特征进行婴儿不适检测。典型的网络如卷积神经网络(CNN),其已在许多计算机视觉任务中得到广泛应用。

这项工作是我们先前的研究[5]的扩展和更全面的描述。与[5]相比,我们对自动化婴儿监测系统做出了以下贡献和扩展。

为了训练一个用于婴儿监测的鲁棒且可靠的基于Faster R‐CNN的框架,我们提出使用一种结合未标注数据集的半监督训练方法,从而避免医护人员进行繁琐的标注工作。

我们将[5]中提出的开发的Faster R‐CNN框架应用于基于近红外(NIR)视频的夜间婴儿监测中的不适检测。据我们所知,这是首个基于近红外视频的婴儿监测应用中的不适检测工作。

• 对于训练所实现的框架,特别是对于夜间婴儿监护系统,我们提出了一种直方图匹配方法来扩增训练数据集。

为了便于将所提出的系统用于面向客户的应用,我们提供了使用临床数据集和公开可用的实际数据集的完整评估。实验结果表明,采用所提出方法训练的不适检测在临床环境和基于消费者的应用中均具有较强的鲁棒性和可靠性。

本文其余部分组织如下。第二节简要介绍了临床和技术领域的相关工作。随后,第三节详细阐述了系统设计。第四节提供了婴儿不适分析的实验结果。接着,第五节讨论了本研究在消费电子产品中应用的可行性。最后,第六节给出了结论。

II. 相关工作

近几十年来,临床研究人员开发并验证了多种疼痛评分系统,用于评估新生儿的疼痛。然而,由于新生儿对疼痛刺激的感受与其年龄、性别和个人自我效能相关,因此目前尚无标准化或通用的疼痛管理方法[1]。尽管定义标准化的婴儿疼痛评估较为困难,面部动作(皱眉、眯眼和鼻唇沟)仍然是用于疼痛表情分析的主要表情[7]。因此,已设计出多种依赖行为和面部表情[8]的疼痛评估工具,例如修订版FACES疼痛量表[9]、FLACC[10]、Wong‐Baker面部量表、新生儿面部编码系统(NFCS)[3],[11]以及10厘米视觉模拟量表[1]。除了疼痛相关的面部表情外,其他生理参数也被用于设计疼痛评估评分系统,例如包含警觉性、平静与躁动、呼吸反应、哭闹和身体运动、肌张力和面部紧张等作为疼痛指标的舒适度量表[12],[13]。尽管已有针对不同胎龄新生儿设计的各种疼痛评估方法,但这些疼痛评分的主要不足之处在于其主观性。研究人员发现,不同观察者(儿科医生和父母)[14]对婴儿疼痛评估的判断存在显著差异。然而,这一问题可以通过自动疼痛评估系统加以解决,该系统不仅能够提供一种客观的评分方式,不仅减少了劳动量,还能记录必要的信息以供进一步的疾病诊断,这一点深受医生和儿科医生的欢迎。

因此,几十年来,研究人员一直致力于设计用于疼痛强度估计的自动化系统,例如[15],[16],[17],[18]。这些方法使用几何特征或基于纹理的特征来进行疼痛表达的表示。然而,上述方法主要是针对成人而非婴儿设计的。尽管如此,近年来已提出利用面部描述符的自动化疼痛检测系统,专门用于婴儿疼痛评估。这些系统主要基于传统方法,例如[19],[20],[21],[22],[23],[24],[25]。[19]中的作者提出结合NNSOA和LSVM进行疼痛估计。[20],[21]中的研究采用局部二值模式(LBP)作为面部描述符,并将其与支持向量机(SVM)结合用于疼痛分类。在[22]中提出了一种用于不适检测的半自动化系统,该系统采用主动外观模型(AAM)进行面部外观建模。Sun等[23]提出了一种基于模板匹配方法的不适检测系统,其中将特定受试者的中性面部用作模板。包含与模板不同的特定表情的帧被分类为不适。然而,这些方法只能处理理想情况,难以集成到消费电子设备中。除了对面部疼痛表达进行分析外,研究人员还利用其他生理参数的方法进行婴儿疼痛评估。例如,[26],[27]中的研究使用心率信息进行疼痛分析,而[28],[29]中的作者通过分析婴儿啼哭的声音来评估疼痛。然而,啼哭可能由其他刺激引起,例如饥饿或愤怒,因此不能单独作为疼痛的唯一指标[30]。与传统方法相比,基于CNN的框架由于其强大的表示能力和在许多计算机视觉任务上的高性能,被认为更适用于消费电子领域[31]。类似于本研究的工作,[32]和[33]描述了基于深度学习的成人面部表情识别。在[32]中,李提出了一种个性化面部表情识别系统,该系统通过使用公开数据集和个体面部表情图像训练深度网络实现。因此,所提出的系统是依赖于个人的,这限制了其在医学用途的通用系统中的应用可能性。科特提出使用MobiExpressNet识别面部表情[33]。然而,其网络的输入是用于表情分类的面部图像块,这需要额外步骤才能应用于婴儿监控系统。萨莱金在[34]中提出了一种多通道神经网络,用于从视频中评估新生儿疼痛,该方法基于YOLO[35]、VGG16和LSTM的集成进行视频分析,与我们提出的Faster R‐CNN框架相比,对硬件计算和存储容量的需求更高。

在本研究中,我们将提出一种基于卷积神经网络特征的描述符,用于表示婴儿疼痛表情。得益于所提出的半监督训练方法,训练好的分类器将能够有效应对各种具有挑战性的情况,例如大幅度头部姿态和面部遮挡。

III. 婴儿监控系统

在本节中,我们将首先介绍所提出的自动化婴儿监护系统的实施设置。然后,将解释用于训练分类器的Faster R‐CNN框架。最后,将分别讨论白天光和基于近红外视频的监控方案的训练方法和数据增强。

A. 设置

在此应用中,我们目前关注婴儿因进行pH‐阻抗测量以诊断胃食管反流病而住院期间的婴儿监测。此外,仅考虑婴儿停留在床上并平躺的时刻。由于诊断胃食管反流病的关键指标与症状相关(不适表情)反流[36],遗漏不适时刻可能导致诊断不准确。因此,在视频采集设置中,采用双通道摄像头,并安装在床的两侧,以便在婴儿头部处于任何姿态时均能获取其面部视图。此外,由于护士需要接近婴儿,不允许在婴儿上方设置中央摄像头位置。安装摄像头的床是荷兰费尔德霍芬马西马医疗中心(MMC)常用的床型。摄像头安装在固定位置,以最佳角度捕捉婴儿面部。所选摄像头支持全高清视频质量和夜视模式,可在夜间拍摄近红外视频。两台摄像头均通过同轴视频电缆连接至录像机。最后,显示器连接到录像机,用于显示被监测婴儿的视频流。本应用中使用的视频采集设置如图1所示。尽管本研究在临床应用中使用了双通道摄像头,但当硬件设置适配为仅带单个摄像头的平板电脑和手机时,该方法还可进一步改进,适用于面向消费者的应用。

B. Faster R-CNN框架

近年来,由于卷积神经网络(CNN)在捕捉特征方面表现出色,已被广泛应用于目标检测和分割等多种计算机视觉应用中[31],通过学习神经网络来提取区分性特征。所捕获的特征集合及其层次关系构成一个用于检测和/或分割的物体模型。这种建模特性是通过将图像像素利用非线性变换转化为高层特征实现的,该过程通过堆叠卷积层和激活函数层完成。与传统的计算机视觉技术相比,卷积神经网络(CNN)能够表示非常复杂的纹理模式。通常,标准CNN架构由卷积层、池化层和全连接层组成。在每个卷积层中,一组滤波器(也称为感受野)与输入进行卷积以生成三维特征图。卷积层之后通常跟随一个池化层,其目的是逐步减小特征图的空间尺寸,并限制网络中的参数数量。非线性变换由激活层实现,激活层可通过Sigmoid函数或修正线性单元(ReLU)函数构建。全连接层在计算卷积方面与卷积层类似,但不同之处在于,全连接层将三维特征图转换为一维向量,该向量可由Softmax或支持向量机(SVM)分类器进行分类。低维卷积层提取基本视觉特征,如有方向边缘和角点,而高维层则描述超特征。因此,分类性能在很大程度上取决于CNN架构的深度、滤波器类型及其具有反馈连接的层次结构。

Faster R‐CNN由Girshick提出,通过将感兴趣区域(RoI)候选和目标分类结合到一个网络中,将检测建模为多任务学习过程,在基准ImageNet数据集上实现了目标检测的最先进的性能。与其他基于CNN的目标检测器相比,Faster R‐CNN首先通过候选区域层生成RoI,然后从最终的卷积特征图中提取每个RoI对应的CNN特征。最后,每个输入RoI的特征图体积被送入全连接层进行进一步分类,而对应于目标的分类则通过softmax回归实现。此外,通过边界框回归获得相应检测目标的精确定位。Faster R‐CNN的创新之处在于候选区域层和分类层的端到端训练。因此,与基于滑动窗口的方法相比,Faster R‐CNN在保持高精度的同时,提高了基于CNN的目标检测器的训练和测试速度。用于不适检测的基于Faster R‐CNN的框架结构如图2所示。

与原始Faster R‐CNN使用固定比例尺寸的锚点候选框不同,在本应用中,我们采用了YOLO目标检测[35]中的策略,该策略根据训练样本选择锚点的尺寸。由于前述设置的原因,我们基于小脸在本设置中出现的可能性较低这一事实,选择两种不同尺寸的目标尺度,而非原始Faster R‐CNN所使用的三种尺度。此外,边界框先验是通过k均值聚类从训练样本中获得的。

数据集。我们将k均值的类别数量设置为C= 3。最后,每个位置的候选锚框数量为6。训练的损失函数选择与Faster R‐CNN中的原始函数相同[37]。

C. 训练

众所周知,训练一个可靠的基于卷积神经网络的分类器需要大量的训练图像,然而带有标注的公开婴儿数据集却很难获得。为了解决这一问题,我们提出了一种针对白天光和近红外视频婴儿监测方案的数据增强训练方法。具体的训练细节将在下文进一步讨论。

1) 半监督训练

如前所述,获取带有标注的足够数据集来训练基于CNN的分类器是困难且耗时的。因此,我们为该任务提出了一种结合标注数据集和未标注数据集的半监督训练方法。未标注的RGB彩色数据集是通过对标注数据集应用[40]中描述的数据增强技术(旋转)而获得的。相关的训练过程现解释如下。

首先,使用标注数据集对Faster R‐CNN框架进行2个训练轮次的训练,以获得具有高召回率的粗分类器。此处,标注数据集的真实标签为人工标注。每幅图像的标注在数学上表示为(X,cls),其中,X是一个包含4个分量的向量,由(x1,y1,x2,y2)组成,表示边界框的左上角和右下角坐标,而cls表示对应边界框的真实表情标签。在获得粗分类结果后,进一步引入无标签数据集进行微调。为此,框架将交替使用标注图像和无标签图像进行训练。交替训练的过程如下:在使用标注图像训练n次后,随机选择一张无标签图像用于下一次训练迭代。数值n通过经验确定,在本研究中我们设定n= 3。无标签图像的表情标签及其对应的边界框通过当前训练好的网络对该选定的无标签图像进行推断获得。然而,这种交替训练的一个显著缺点是,如果粗分类器分类的表情标签错误,则使用这些无标签图像重新训练的网络性能将显著下降。因此,为了降低误检的影响,需对置信度应用一个阈值。

2) 数据增强

为了在夜间或黑暗环境中监测婴儿,我们提出了一种基于近红外视频分析的非侵入式婴儿监测方法。近红外光对人眼不可见,安装在医院病房中的近红外光源可在不对新生儿造成干扰和不便的情况下为视频拍摄提供足够的照明。摄像头通过 Night Shot模式捕捉近红外视频,该模式使摄像头能够感知更多的近红外光。对于分类器的训练,充足的数据集是解决过拟合问题的关键因素。遗憾的是,据我们所知,目前尚无公开的近红外数据集,且此前关于利用近红外视频分析进行婴儿疼痛/不适检测的研究内容匮乏。因此,我们通过将RGB图像人工转换为类近红外图像来扩充基于近红外的婴儿监测训练数据集。由于近红外光的波长范围为800至1400 nm,与红色光的波长相邻,因此我们简单地保留RGB图像的红色通道信息以模拟人工近红外图像。该方法通过直方图匹配变换实现,表示为 s= T(r),其中 s 是近红外图像的像素值,r 表示RGB图像的像素值。目标直方图 p(s) 可从现有的近红外图像数据集中获得,因此直方图匹配的目的是将RGB图像的 ∀p(r) 映射到 p(s)。该方法可通过 s= G−1 (S(r)) 简单计算,其中 G(.) 和 S(.) 分别为近红外图像和RGB图像的累积分布函数。图3展示了通过直方图匹配方法获得的人工近红外图像示例。与原始灰度图像和单一红色通道图像相比,人工近红外图像看起来更接近真实近红外图像,如图6所示。

原始图像;(b) 原始图像的灰度图像;(c) 原始图像的红色通道;(d) 通过直方图匹配生成的人工近红外图像。)

原始图像;(b) 原始图像的灰度图像;(c) 原始图像的红色通道;(d) 通过直方图匹配生成的人工近红外图像。)

IV. 实验与结果

本节首先描述用于训练和测试的RGB和近红外视频数据集。然后,将解释用于评估训练好的网络的指标。最后,将展示白天光和夜间不适检测的实验结果。

A. 数据集

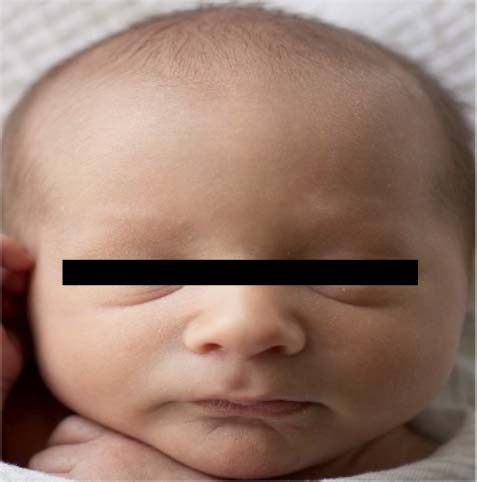

据我们所知,目前仅有两个可用于婴儿疼痛/不适分析的公开数据集,分别是 Brahnam 等人收集的 COPE/iCOPE数据集和另一组来自YouTube视频的数据集[43]。COPE/iCOPE包含204张从26名健康婴儿中截取的裁剪婴儿面部灰度静态图像。因此,该数据集更适合用于评估疼痛表情分类,而非在复杂背景下进行婴儿表情检测。YouTube视频[43]共包含142段12个月以下婴儿接受免疫接种时的视频。在此数据集中,所有视频的疼痛评分均依据FLACC[10]疼痛评估工具进行评估,并为每段视频分配一个最终得分以反映其疼痛程度。然而,这些视频的每一帧缺乏详细标注,这阻碍了利用该数据集对婴儿监控系统进行全面的训练与评估。因此,为了训练一个鲁棒且可靠的分类器,我们从互联网收集了16,165张婴儿图像,并手动标注了边界框,涵盖整个婴儿面部及其对应的真实表情标签。在训练过程中,这些标注图像经过镜像和翻转处理以实现数据增强。所有标注均由荷兰费尔德霍芬马西马医疗中心(MMC)的专业人员根据Wong‐Baker FACES疼痛量表[4]完成。婴儿表情评分高于6分(“更疼”)的图像被标记为“不适”,其余则标记为“中性”。此外,如第三节所述,半监督学习需要一个无标签数据集。为了获得这样的无标签数据集,我们将所有已标注的训练图像以 −30◦到+30◦的角度范围、步长为 10◦进行旋转。除此之外,还向这些生成的图像中添加随机高斯噪声,以增加无标签数据集内的多样性。为减少因歧义引入的训练误差,生成的数据集中剔除了包含多个婴儿面部的图像。最终,该生成的无标签数据集共包含62,488张图像。综上所述,我们的基于CNN的不适检测框架针对日光视频解决方案使用了有标签数据集和生成的无标签数据集进行训练,而基于近红外视频的分类器仅使用有标签数据集进行训练。图4展示了训练数据集中带有标注的图像示例。

为了对婴儿监控系统在24小时周期内进行全面评估,测试数据集由两个子集组成,分别是RGB彩色数据集和近红外数据集。

第一个RGB彩色数据集包含从50名不同婴儿的110个视频序列中选取的10个视频,涵盖了如大幅度头部姿态变化和物体遮挡等具有挑战性的情况。由于该数据集是在 MMC 菲尔德霍芬采集的,因此我们将此数据集标记为 Data-Clinic ,用于验证其临床应用。所有Data-Clinic中的视频均在遵守医院伦理标准的前提下录制,在获得父母书面同意后允许使用这些视频。在此数据集中,婴儿不适表情的视频是在他们经历足跟穿刺、放置静脉输液管或疫苗接种引起的疼痛时拍摄的;而其他表情的视频则是在婴儿因医疗护理住院期间无疼痛表现时采集的。所有选定的视频至少持续2分钟,这是专业人员观察并给出疼痛评分所需的时间。此外,为了展示所提出方法在定制化应用中的可行性,我们从YouTube随机选取了50个视频序列,记为 Data-YouTube,构成第二个RGB彩色数据集。该数据集中每个视频序列包含一名不同的婴儿。由于这些视频由 YouTube 用户上传,视频质量差异显著(从良好到较差),这是由于视频采集时使用的摄像机质量各不相同所致。此外,这些视频序列还包含某些图像中没有婴儿的帧,这些背景帧可用于进一步评估所提出网络的可靠性。

近红外数据集包含从在MMC菲尔德霍芬过夜并接受24小时pH‐阻抗测量以进行胃食管反流病诊断的25名婴儿中采集的102个视频序列。所有近红外视频均由图1所示的两个监控摄像头拍摄。采集这些近红外视频的医院病房使用900纳米红外灯照明。所有测试数据集中的视频均由 MMC的专业人员进行了完整标注。每帧真实标签的标注方法由专业人员提供,并与训练数据集中的图像一致。各测试数据集中标注为“不适”和“中性”的帧数如表I所示。

两种表情的测试图像数量不平衡,原因是被收治到MMC菲尔德霍芬的婴儿受到保护,尽可能减少疼痛。即使是重症患者也会接受符合伦理协议的镇痛药物治疗。因此,本研究中包含的婴儿表现出中性表情的频率远高于不适表情。

B. 指标

对于评估指标,主要使用精确率‐召回率(PR)曲线进行深入比较,以评估影响

| 表I | 测试视频中包含“不适”和“中性”表情的帧数 |

|---|---|

| 数据集 | “不适”帧数 |

| Data-Clinic | 1,247 |

| Data-YouTube | 986 |

| 近红外数据集 | 2,158 |

所提出方法各个组件的性能。采用的PR曲线基于Pascal VOC挑战赛中VOC2007指标[37]计算,这些是目标检测任务的标准指标。根据定义,平均精度(AP)表示每种舒适表情的检测准确率,而平均平均精度(mAP)则反映两种感兴趣表情的整体性能。对于该指标,若一个被分类为待评估表情的检测边界框与对应表情标注的真实边界框之间的交并比(IoU ≥ 0.5)达到一定阈值,则被视为真正例,其余情况则被视为假正例。这包括:被分类为待评估表情的检测边界框与任意真实边界框的交并比(IoU< 0.5)未达标,或与标注为相反表情的真实边界框之间的交并比(IoU ≥ 0.5)过高的情况。

C. 实验结果

在本节中,将分别讨论使用RGB彩色和近红外视频数据集对所提出方法进行评估的实验结果。随后,将对所提出的婴儿监控系统进行评估性讨论。

1) RGB彩色数据

对于彩色视频分析,我们将首先比较Faster R‐CNN结合不同架构的性能。随后,评估所提出的数据增强方法的影响。在这些实验中,所有采用的CNN架构都将使用ImageNet[39]数据集进行预训练,然后通过所提出的训练方法进行微调。为了评估各种CNN架构在不适分析中的性能,我们首先应用四种不同的卷积神经网络(CNN),并在未使用数据增强的训练数据集上进行训练。每种架构通过PR曲线评估的性能如表II所示。该性能是在各架构经过10个训练轮次微调后获得的。从表II可以看出,VGG网络[44]提供了最佳性能,在基于<Data‐Clinic和<Data‐YouTube数据集进行不适检测评估时,其平均精度分别达到87.7%和89.4%。

由于VGG网络在Data-Clinic和Data-YouTube上均表现最佳,因此在后续实验中将仅使用VGG网络,因其在RGB视频数据集上具有更高的性能。通过半监督训练进行所提出的数据增强方法在不适分析中的实验结果如表III所示。从表III可以看出,在使用数据增强的情况下,Data-Clinic数据集的不适平均精度提高了0.8%,平均平均精度提高了0.5%;而Data-YouTube数据集则分别提高了0.7%和1.1%。由于测试数据集中大多数视频为近正面视角(尤其是来自Data-YouTube的数据),我们推测若在评估中加入更具挑战性的情况(如大角度头部姿态),所提出的数据增强方法在RGB彩色视频的表情分析中将显著提升性能。然而,这些实验结果对于设计婴儿监控系统已极具吸引力。

| 表II | 使用PR曲线在RGB彩色数据集上评估的四种卷积神经网络结构在不适检测与分类中的性能,训练过程中未使用数据增强,训练轮次为10次(最高数值以粗体显示) |

|---|---|

| CNN架构 | Data-Clinic AP (%) |

| AlexNet | 78.3 |

| GoogLeNet | 81.5 |

| ResNet-50 | 84.6 |

| VGG-16 | 87.7 |

| 表III | 采用VGG网络的Faster R‐CNN框架在有无数据增强情况下进行不适检测性能的比较,使用RGB彩色数据集评估PR曲线(最高数值以粗体显示) |

|---|---|

| 数据集 | AP_不适 (%) |

| 无数据增强 | |

| Data-Clinic | 87.7 |

| Data-YouTube | 89.4 |

| 有数据增强 | |

| Data-Clinic | 88.5 |

| Data-YouTube | 90.1 |

2) 近红外数据

由于近红外视频数据集中包含的婴儿受试者数量有限,我们采用了五折交叉验证方法来评估不适检测与分类。因此,来自25名婴儿的102个视频被随机分为5组,每组包含5名婴儿的视频序列。在每一折的评估中,对应的训练集由来自其他四折视频中采样的帧以及通过第三节中所提出的算法转换得到的人工近红外图像组成。与RGB彩色数据集类似,在每一折验证中,VGG网络首先使用ImageNet[39]数据集进行预训练,然后使用每一折对应的训练数据集进行微调。表IV提供了基于Faster R‐CNN框架在使用和不使用数据增强的情况下,通过每一折的PR曲线进行不适分析比较的结果。可以看出,所提出的方法在“不适”类别上达到了87.5%的平均精度,并且在总体mAP性能上也获得了相似的分数。此外,与未使用数据增强的框架相比,采用数据增强的Faster R‐CNN在“不适”、“中性”和总体mAP上的平均精度分别提升了0.6%、3.1%和1.9%。显然,在训练样本有限的情况下,“不适”类别的准确率并且,通过使用数据增强技术可以改善近红外视频的“中性”分类。如图所示,近红外视频的高性能在夜间监测中尤其具有吸引力,并进一步促进了24小时婴儿监控系统的部署,使得远程婴儿监护有可能被应用于消费电子设备中。

| 表IV | 采用VGG网络的Faster R‐CNN框架在使用和不使用数据增强的情况下,基于近红外数据集通过PR曲线评估的不适检测性能比较(最高数值以粗体显示) |

|---|---|

| 数据增强 | AP_不适 (%) |

| 无 | 86.9 |

| 有 | 87.5 |

3) 附着

除了比较基于不同CNN架构的不适检测外,我们还评估了训练周期对训练好的网络性能的影响。图5展示了使用所有RGB和近红外数据集且不进行数据增强时,不适分类性能与训练周期之间的关系。本实验通过PR曲线进行评估。从图5可以看出,在最初的几个周期内,随着周期数的增加,性能有所提升,但在7个周期之后,平均精度趋于饱和。这可以归因于数据集数量有限,当CNN架构在现有标注的训练数据集上达到瓶颈后,进一步增加训练周期难以提升不适检测的性能。因此,提出采用数据增强方法以进一步提高不适检测与分类的准确率。

4) 讨论

所提出的不适检测与分类方法已达到高精度,可直接用于持续运行的实时婴儿监控系统。然而,在某些情况下仍可能出现不适的假阴性与假正例。例如,所提出的二分类用于区分不适与中性表情的分类器在识别过渡状态的表情时存在困难,例如从“不适”转变为“中性”或反之的情况。此外,由于训练数据集中包含的侧脸样本有限,当前训练的卷积神经网络分类器在面对纯侧脸时很难检测到“不适”。而且,当“不适”的关键特征被遮挡时,例如深鼻唇沟皱纹和张嘴,当前分类器将无法将其与中性表情区分开来。然而,上述大多数误检问题可通过采用其他解决方案进一步解决,例如增加用于训练的侧脸图像数量、将表情分为多个类别,以及添加时域滤波器以通过结合额外信息减少假阴性。这些提到的技术将在我们的未来工作中进行研究。

V. 消费者应用的可行性

从实验结果可以看出,所提出的婴儿监控系统能够以高性能检测婴儿在RGB和近红外视频中的不适。因此,当前框架已经可以利用本研究中使用的设置在临床环境中实现24小时婴儿监控。除了上述临床应用外,该系统还可以发展为面向消费者的应用,例如通过婴儿电话进行睡眠监测。我们提供了若干论据,说明这对父母和医院而言不仅是可行的,而且具有吸引力。

总体而言,所提出的婴儿监控系统在面向消费者的特定版本中,可让婴儿保持在家庭而非医院进行某些疾病诊断。这不仅为婴儿患者提供了舒适熟悉的环境,还避免了临床医护人员的手动观察。该方法要求系统能够与医院通信,并在需要时发送重要的临床信息。因此,该设备将作为不适检测的远程感知系统。针对心脏疾病患者的此类远程感知已经存在,因此我们提出的远程引导系统概念并非革命性的突破,而是一个自然的下一步。我们的系统专注于胃食管反流病(GERD)的不适检测,但也可轻松扩展至其他疾病。此外,医院将更倾向于接收更多的不适检测案例并对其进行分析,以实现更准确的疾病诊断。

消费类应用的另一个论点是,所提出的系统具有利用近红外视频进行不适检测的潜力。该功能可在夜间提供监控,当与RGB视频分析相结合时,能够实现全天候监控。

在消费领域实现可行性的关键论点是在低成本和低功耗计算平台上进行部署。尽管目前实验使用了 GTX1080ti GPU和昂贵的台式计算机,但GPU计算可以实现在新型小型TX2模块上,这些模块为嵌入式应用提供了低成本和低功耗的优势。这为消费型设备铺平了道路,在进一步结合最先进的嵌入式计算平台后,父母可以在家庭中用于婴儿监测。

六、结论

为了避免昂贵的婴儿疼痛人工评估,我们提出了一种自动化基于视频的婴儿不适检测系统,该系统还能在婴儿通常更喜欢的轻松环境中实现远程家庭监测,这也是父母普遍偏好的方式。所提出的系统基于Faster R‐CNN框架设计,对不适表情分类具有较强的鲁棒性。我们利用有限数量的近红外视频,通过一种新颖的基于直方图的数据增强技术扩展了夜间录像。此外,我们的系统还针对近红外视频数据集进行了评估,这在该领域也属于首次尝试。因此,所提出的系统为白天和夜间的婴儿监测提供了稳健的解决方案。实验结果在RGB和近红外视频上均达到了超过87%的平均精度。我们提出的系统可实时运行,能够立即向看护人通知疼痛和不适事件,并为临床专家提供客观的疼痛持续时间和频率测量,以便在需要时启动会诊。在未来工作中,可进一步利用时序依赖性来降低系统的计算复杂度,从而实现与现有计算平台(如平板电脑和手机)的集成。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?