root@node01:/usr/lib/spark/spark-3.1.2-bin-hadoop3.2# sbin/start-workers.sh

root@node02's password:

root@node01's password: node01: Permission denied, please try again.

解决

使用公钥链接,在每个节点执行一下命令

ssh-keygen #在节点中生成公钥,一直按enter即可

cat /.ssh/id_rsa.pub >> ~/.ssh/authorized_keys# 将公钥存到同一个公钥包中

注意将所有节点的公钥都放在同一个/.ssh/authorized_keys中,并复制保存在每个节点的/.ssh/authorized_keys

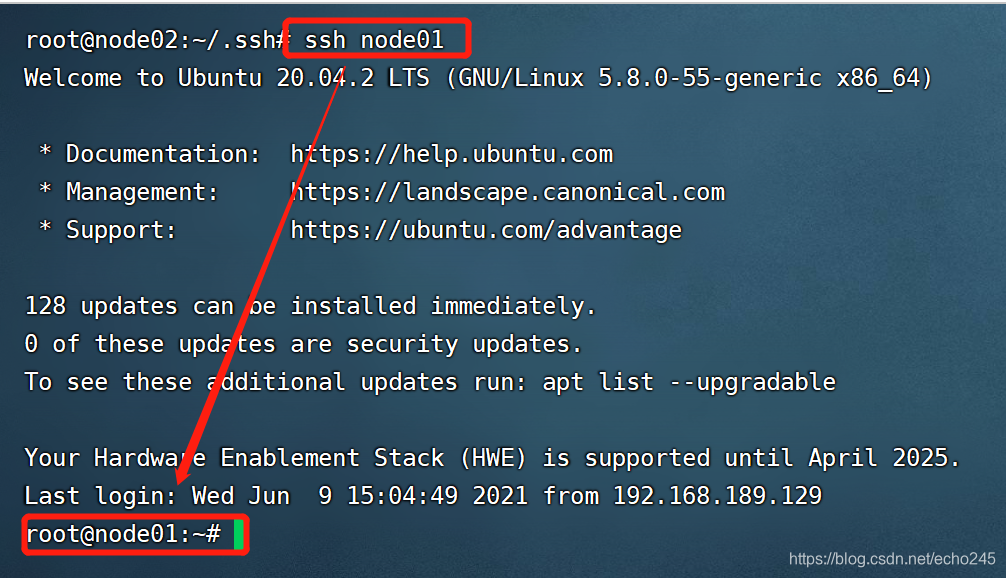

使用命令验证

ssh node01

本文介绍如何在Spark集群中配置worker节点并实现节点间的免密登录。通过使用ssh-keygen生成公钥并将其添加到authorized_keys文件中,可以避免在启动Spark集群时输入密码,从而提高部署效率。

本文介绍如何在Spark集群中配置worker节点并实现节点间的免密登录。通过使用ssh-keygen生成公钥并将其添加到authorized_keys文件中,可以避免在启动Spark集群时输入密码,从而提高部署效率。

4456

4456