全文共6081字,预计学习时长18分钟

图源:pexels

综述

强大的SIFT技术初学者指南;

如何使用SIFT进行特征匹配;

在Python中通过动手编码展示SIFT。

简介

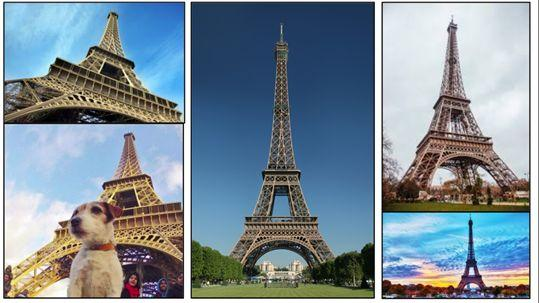

观察下面选取的图片,并思考他们的共同元素:

对了,就是美丽的埃菲尔铁塔!眼尖的你们一定也发现了每张图片都有一个不同的背景,是从不同的角度捕捉到的,不同的位置还有不同的物体。

相信你只需要一两秒的时间就能找出这些不同。即使图片以奇怪的角度或是只拉近了一半镜头,也能看得出来。这主要是因为你已经看过埃菲尔铁塔的图片许多次了,并且你的记忆很容易使你想起它的特征。所以说,图片的大小和角度可能会改变,但是展示的物体永远不变。

对于相同的想法,机器也进行了全方位的探索。但如果我们改变了某些东西(例如角度或比例),对它们来说识别图像中的物体却是一个挑战。好消息是——机器超级灵活,我们可以教会它们亦人的水平识别图像。

这是使用计算机视觉工作的最激动人心的部分!

本文将会讨论图像搜索算法,即定义图像上的关键特征并且能够根据这些特征搜索到一张新图片。让我们开始吧!

目录

1. SIFT介绍

2. 创建尺度空间

1. 高斯模糊软件

2. 高斯软件的不同

3. 关键信息本地化

1. 极值

2. 关键信息筛选

4. 关键信息描述符

1. 计算幅度和方向

2. 创建幅度和方向柱状图

5. 关键点描述符

6. 特征匹配

1. SIFT介绍

SIFT(Scale Invariant Feature Transform),又称尺度不变特征转换匹配算法,是在计算机视觉任务中的特征提取算法。

SIFT可以帮助定位图像中的局部特征,通常称为图像的“关键点”。这些关键点是比例尺和旋转不变量,可用于各种计算机视觉应用,例如图像匹配,物体检测,场景检测等。

还可以将通过SIFT生成的关键点用作模型训练期间的图像特征。与边缘特征或单一特征相比,SIFT特征的主要优势在于它们不受图像大小或方向的影响。

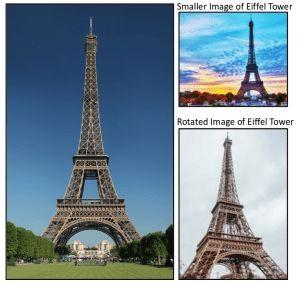

例如,这是埃菲尔铁塔的另一张图片以及它的较小版本。第一张图像的关键点与第二图像中找到的关键点相匹配。当另一幅图像中的对象稍微旋转时,两幅图像也是如此。是不是很厉害?

了解如何识别这些关键点,以及用于确保比例和旋转角度不变的技术是什么。广义上讲,整个过程可以分为四个部分:

- 构造比例空间:确保要素与比例无关

- 关键点本地化:确定合适的特征或关键点

- 方向分配:确保关键点是角度不变

- 关键点描述符:为每个关键点分配独一的指纹

最后,用这些关键信息进行特征匹配!

2. 创建尺度空间(Scale Space)

识别给定图像中最鲜明的特征,

本文介绍了SIFT(尺度不变特征转换)技术,用于图像的关键点检测和匹配,实现尺度和旋转不变性。通过创建尺度空间、高斯模糊、高斯差异、关键点本地化、方向分配、关键点描述符和特征匹配等步骤,详细阐述SIFT算法。并提供了Python代码示例,展示如何在实际中应用SIFT进行图像匹配。

本文介绍了SIFT(尺度不变特征转换)技术,用于图像的关键点检测和匹配,实现尺度和旋转不变性。通过创建尺度空间、高斯模糊、高斯差异、关键点本地化、方向分配、关键点描述符和特征匹配等步骤,详细阐述SIFT算法。并提供了Python代码示例,展示如何在实际中应用SIFT进行图像匹配。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2608

2608

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?