1. 设置远程解释器

2. 添加远程解释器

3. 输入密码

4. 设置同步文件夹

5. 完成

6. 上传本地代码至远程服务器

7. 其他设置

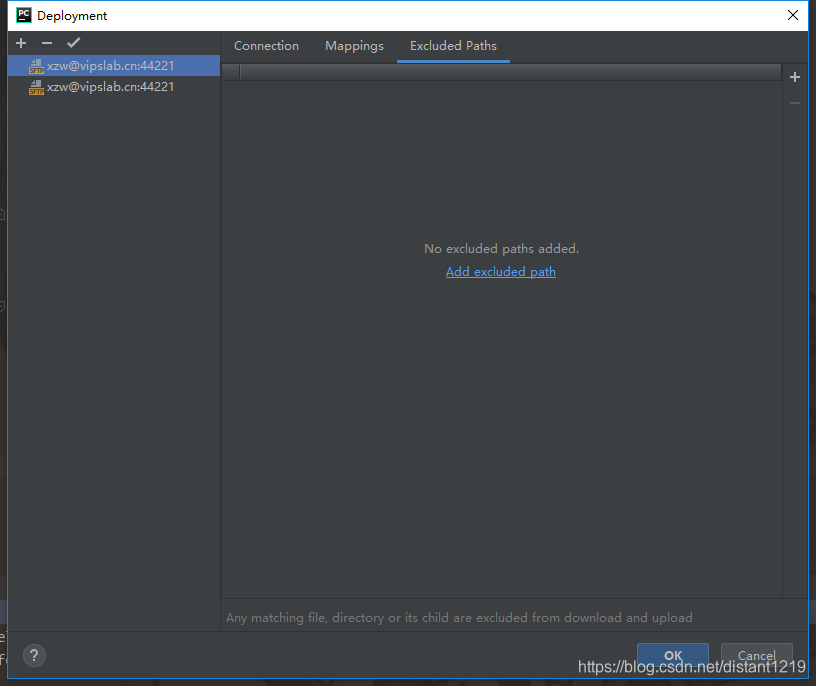

打开 “Tools-> Deployment -> Configurnation”

-

添加不需要同步的文件夹,比如数据集或者模型文件

-

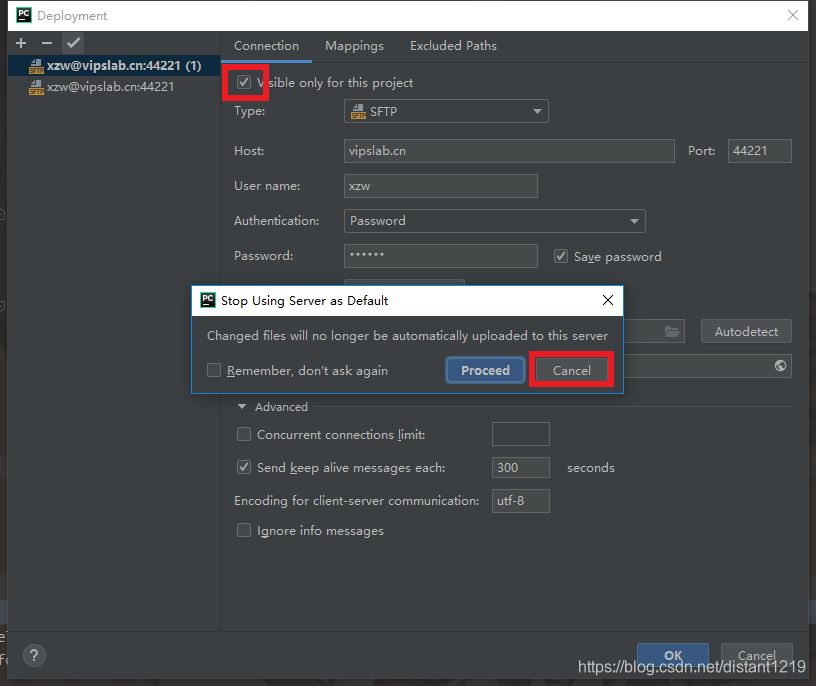

设置默认服务器

注意1, 图片里是取消操作,点击

Cancel注意2,取消

Visible only for this project的选项,不然会出错

-

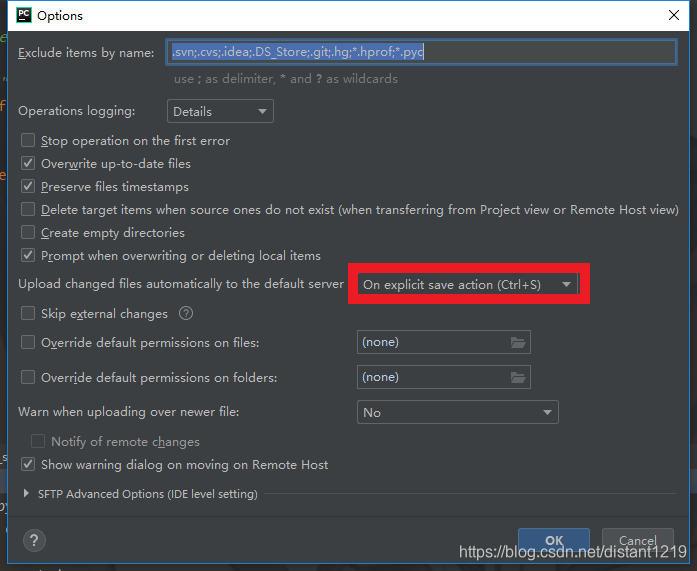

设置自动上传,根据个人习惯,下图设置为

ctrl+s之后,自动上传。

8. 使用逻辑

- 本地创建文件 ----> 上传到远端执行

- 修改存在文件 ----> 上传同步修改

9. 存在问题

如果使用Pycharm 的编译运行按钮,在长时间的模型训练中可能会因为断网而造成训练终端,所以本方法作为代码编写修改的工具,训练时可以使用脚本后台运行或者 screen 命令后台运行。

本文详细介绍了如何在PyCharm中设置远程解释器进行远程调试和训练。步骤包括设置远程解释器、添加解释器、输入密码、同步文件夹,以及注意事项,如设置自动上传和排除不需同步的文件。尽管使用PyCharm的编译运行可能因断网导致训练中断,但此方法适合作为代码编辑工具,建议在实际训练时采用脚本后台运行或screen命令。

本文详细介绍了如何在PyCharm中设置远程解释器进行远程调试和训练。步骤包括设置远程解释器、添加解释器、输入密码、同步文件夹,以及注意事项,如设置自动上传和排除不需同步的文件。尽管使用PyCharm的编译运行可能因断网导致训练中断,但此方法适合作为代码编辑工具,建议在实际训练时采用脚本后台运行或screen命令。

9238

9238

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?