卷积神经网络通常是由四部分组成:输入层、卷积层、下采样层、全连接层和输出层。典型的卷积神经网络中,开始的几层一般是卷积层和下采样层交替出现,靠近输出层的最后几层通常是全连接层,其结构如图2-4所示。一幅原始二维图像输入卷积神经网络网络进入卷积层后,将会被卷积核函数作用提取到输入图像的局部特征,这些局部特征一旦被提取之后,它们之间的位置关系也会随之确定下来。一个卷积核对应一种特征,对同一幅图像采用相同卷积核提取不同位置的相同特征构成一幅特征图,这方式称作卷积神经网的权值共享。通过增加卷积核个数,对输入图像同一位置提取不同的特征,由此构成不同的特征图,这些不同的特征图经过组合作为卷积层的输出。权值共享和下采样不仅减少了网络的参数个数,而且对输入数据具有一定的位移不变和缩放不变性。卷积层后接着是下采样层,下采样层对卷积层的特征图进行了子采样。卷积神经网络最末几层是全连接层,它将最后产生的特征图连接起来,调节输出节点数并得到分类结果。

卷积层

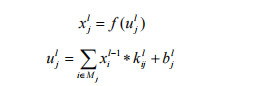

在一个卷积层中,上一层特征图(Feature Map)被一个可学习的卷积核进行卷积,组合这些卷积运算,把获得的结果输入到一个激活函数,最终得到一个输出特征图:

其中,![]() 为卷积层l的第j个特征图,

为卷积层l的第j个特征图,![]() 为卷积层l第j个通道的净激活,

为卷积层l第j个通道的净激活,![]() 为选择的输入特征图的集合,f (·)为激活函数,通常为sigmoid和tanh函数,

为选择的输入特征图的集合,f (·)为激活函数,通常为sigmoid和tanh函数,![]() 为第l-1层的第i个特征图与第l层的第j个特征图的卷积核,

为第l-1层的第i个特征图与第l层的第j个特征图的卷积核,![]() 为第j个特征图的偏置,“*”是卷积操作。

为第j个特征图的偏置,“*”是卷积操作。

下采样层

通过下采样操作,输入特征图的尺寸将变小,输出特征图的计算公式如下所示:

其中,![]() 是下采样层l的第j个通道的净激活,

是下采样层l的第j个通道的净激活,![]() 是下采样层l的第j个特征图的权重,

是下采样层l的第j个特征图的权重,![]() 为其对应的偏置。down (·)为下采样函数,采用滑动窗口方法将输入特征图划分为多个互相不重叠的n×n大小的图像块,接着再对每个图像块内的像素进行求和、均值或者最大值,这样输出特征图就缩小了n倍。

为其对应的偏置。down (·)为下采样函数,采用滑动窗口方法将输入特征图划分为多个互相不重叠的n×n大小的图像块,接着再对每个图像块内的像素进行求和、均值或者最大值,这样输出特征图就缩小了n倍。

全连接层

全连接网络中,所有二维图像的特征图被拼接成一维向量输入到全连接网络中。全连接层l的输出可由如下公式计算得出:

其中,![]() 为全连接层l的净激活,

为全连接层l的净激活,![]() 为全连接层的权值,

为全连接层的权值,![]() 为全连接层的偏置。

为全连接层的偏置。

4608

4608

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?