环境准备

JDK环境

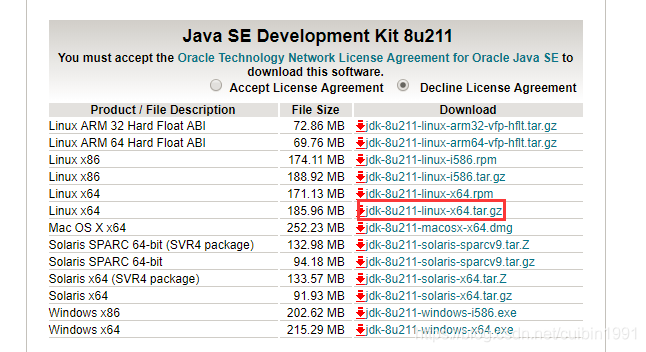

1.下载JDK Linux版本

这里需要确认jdk版本是否与hadoop版本适配。我这里选择的是hadoop-3.2.0,只支持JDK7与JDK8,不要采用JDK9,会出现问题。

2.查看是否有默认安装的 Open JDK

以 root 用户登录:输入 java -vesion。

如果有安装,就需要卸载。

查看:

rpm -qa | grep jdk

卸载:

rpm -e --nodeps

上面命令出现的信息

3.上传解压

我这里是通过WinSCP工具上传到/usr/local目录下。

解压

tar -zxvf jdk-8u201-linux-x64.tar.gz

重命名

mv jdk-8u201-linux-x64 java

4.设置环境变量

vi /etc/profile

在文件最后一行输入

export JAVA_HOME=/usr/local/java

CLASSPATH=$JAVA_HOME/lib/

PATH=$PATH:$JAVA_HOME/bin

export PATH JAVA_HOME CLASSPATH

让修改生效

source /etc/profile

本机ssh免密码登录

我是新建hadoop用户

1.生成秘钥对

ssh-keygen -t rsa

2.把公钥 id_rsa.pub追加到授权的key里面去。

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

3.修改文件"authorized_keys"权限

chmod 600 ~/.ssh/authorized_keys

4.用root用户登录服务器修改SSH配置文件

vi /etc/ssh/sshd_config

把文件中的下面几条信息的注释去掉:

RSAAuthentication yes # 启用 RSA 认证

PubkeyAuthentication yes # 启用公钥私钥配对认证方式

AuthorizedKeysFile .ssh/authorized_keys # 公钥文件路径(和上面生成的文件同)

5.重启服务

service sshd restart

安装Hadoop

上传安装

1.将下载的hadoop-3.2.0.tar.gz复制到/home/hadoop目录下

2.解压

tar -zxvf hadoop-3.2.0.tar.gz

3.在/home/hadoop 目录下新建文件夹 tmp

修改配置文件

1./home/hadoop/hadoop-3.2.0/etc/hadoop目录下hadoop-env.sh

修改 hadoop-env.sh 的 JAVA_HOME 值

export JAVA_HOME=/usr/local/java

2./home/hadoop/hadoop-3.2.0/etc/hadoop目录下core-site.xml

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/home/hadoop/tmp</value>

</property>

</configuration>

3./home/hadoop/hadoop-3.2.0/etc/hadoop目录下hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<!-- Hadoop 的Web UI端口配置 -->

<property>

<name>dfs.http.address</name>

<value>0.0.0.0:8777</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/home/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/home/hadoop/tmp/dfs/data</value>

</property>

</configuration>

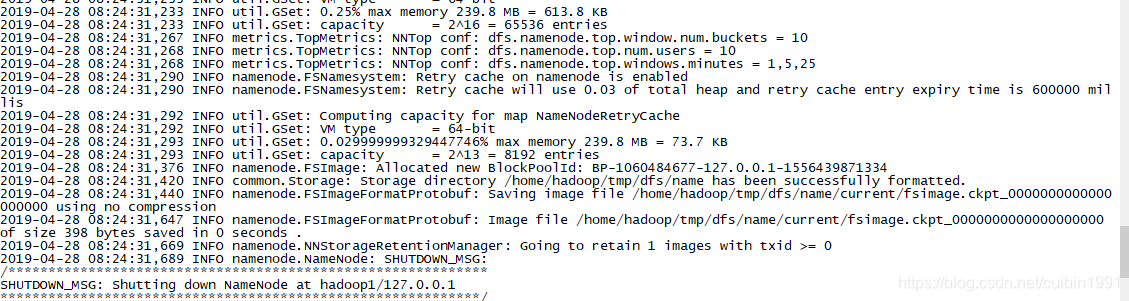

4.初始化 hdfs 文件系统

./hdfs namenode -format

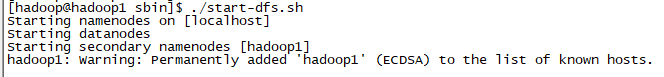

5.启动 hdfs

./start-dfs.sh

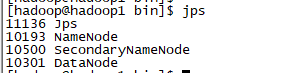

6.输入jps看是否启动成功

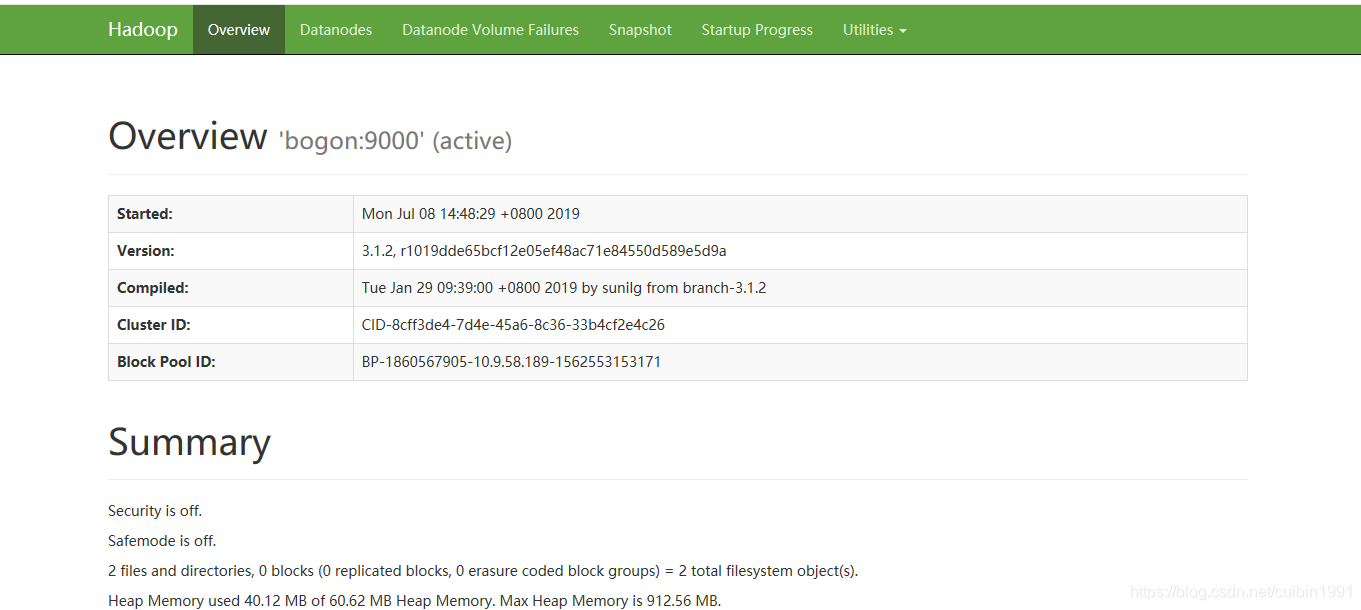

7.web页面效果图

参考链接:https://www.cnblogs.com/ysocean/p/6972143.html

本文详细介绍如何在Linux环境下搭建Hadoop3.2.0集群,包括JDK环境准备、SSH免密码登录配置、Hadoop安装与配置等关键步骤。

本文详细介绍如何在Linux环境下搭建Hadoop3.2.0集群,包括JDK环境准备、SSH免密码登录配置、Hadoop安装与配置等关键步骤。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?