基于Qwen2.5-Coder 快速搭建应用管理系统

序言

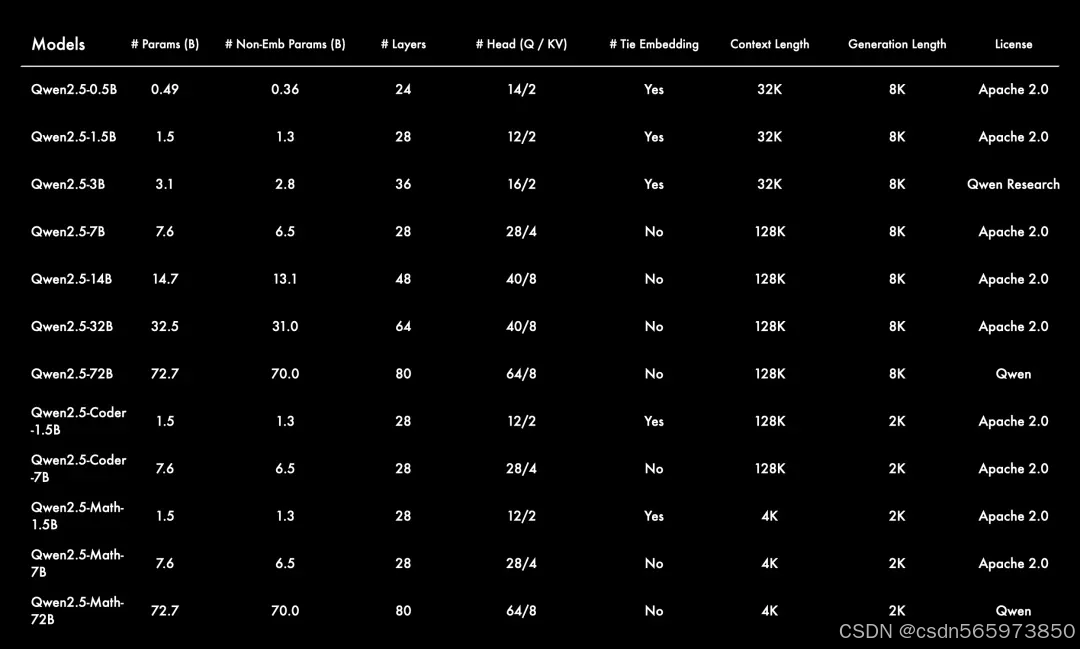

在过去的一段时间里,通义千问团队基于Qwen2 语言模型获得的更多语言模型反馈,专注于创建更智能、更博学的语言模型,最新发布包括了语言模型 Qwen2.5,以及专门针对编程的 Qwen2.5-Coder 和数学的 Qwen2.5-Math 模型。所有开放权重的模型都是稠密的、decoder-only的语言模型,提供多种不同规模的版本,包括:

• Qwen2.5: 0.5B, 1.5B, 3B, 7B, 14B, 32B, 以及72B;

• Qwen2.5-Coder: 1.5B, 7B, 以及即将推出的32B;

• Qwen2.5-Math: 1.5B, 7B, 以及72B。

除了3B和72B的版本外,Qwen2.5所有的开源模型都采用了 Apache 2.0 许可证。您可以在相应的模型仓库中找到许可证文件。此外,本次通义千问团队还开源了性能不输于GPT-4o的 Qwen2-VL-72B。

官方对于Qwen2.5系列本次开源内容,给出了详细的内容阐述,包括:

• 更大的训练数据集:Qwen2.5 语言模型的所有尺寸都在最新的大规模数据集上进行了预训练,该数据集包含多达 18T tokens。相较于 Qwen2,Qwen2.5 获得了显著更多的知识(MMLU:85+),并在编程能力(HumanEval 85+)和数学能力(MATH 80+)方面有了大幅提升。

• 更强的指令遵循能力:新模型在指令执行、生成长文本(超过 8K 标记)、理解结构化数据(例如表格)以及生成结构化输出特别是 JSON 方面取得了显著改进。Qwen2.5 模型总体上对各种system prompt更具适应性,增强了角色扮演实现和聊天机器人的条件设置功能。

• 长文本支持能力:与 Qwen2 类似,Qwen2.5 语言模型支持高达 128K tokens,并能生成最多 8K tokens的内容。

• 强大的多语言能力:它们同样保持了对包括中文、英文、法文、西班牙文、葡萄牙文、德文、意大利文、俄文、日文、韩文、越南文、泰文、阿拉伯文等 29 种以上语言的支持。

• 专业领域的专家语言模型能力增强,即用于编程的 Qwen2.5-Coder 和用于数学的 Qwen2.5-Math,相比其前身 CodeQwen1.5 和 Qwen2-Math 有了实质性的改进。具体来说,Qwen2.5-Coder 在包含 5.5 T tokens 编程相关数据上进行了训练,使即使较小的编程专用模型也能在编程评估基准测试中表现出媲美大型语言模型的竞争力。同时,Qwen2.5-Math 支持 中文 和 英文,并整合了多种推理方法,包括CoT(Chain of Thought)、PoT(Program of Thought)和 TIR(Tool-Integrated Reasoning)。

本文主要是基于Qwen2.5-Coder 快速搭建应用管理系统,那么下面先来了解一下什么是 Qwen2.5-Coder。

Qwen2.5-Coder

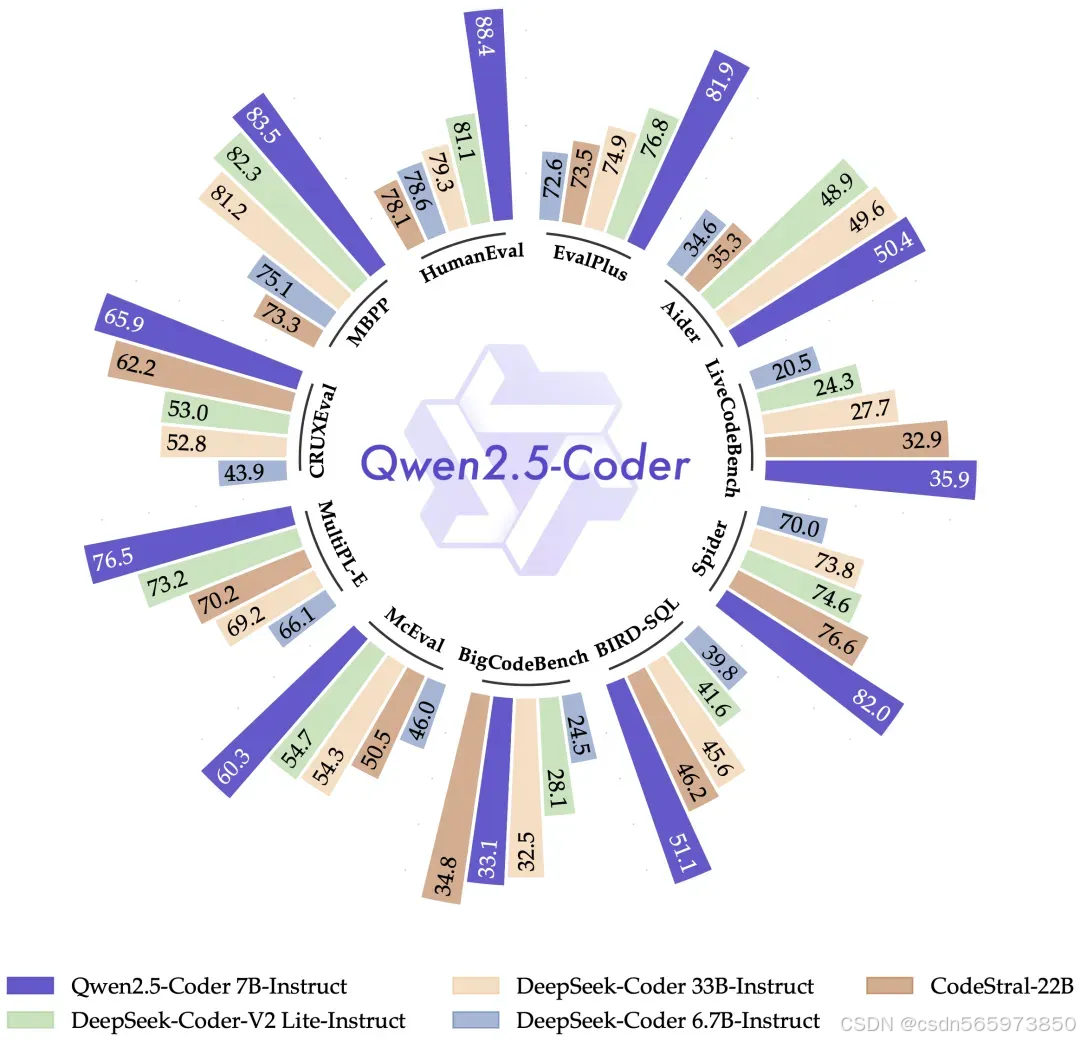

自从推出 CodeQwen1.5 以来,通义千问吸引了大量依赖该模型完成各种编程任务的用户,这些任务包括调试、回答编程相关的问题以及提供代码建议。Qwen2.5-Coder 特别为编程应用而设计。在本节展示了 Qwen2.5-Coder-7B-Instruct 的性能结果,并将其与领先的开源模型进行了基准测试,其中包括那些参数量大得多的模型。

Qwen2.5-Coder 是您个人编程助手的优秀选择。尽管它的体积较小,但在多种编程语言和任务中,它的表现超过了众多大型语言模型,展现了其卓越的编程能力。

如何基于 Qwen2.5-Coder 快速搭建应用管理系统,下面开始详细讲解。

快速搭建应用管理系统

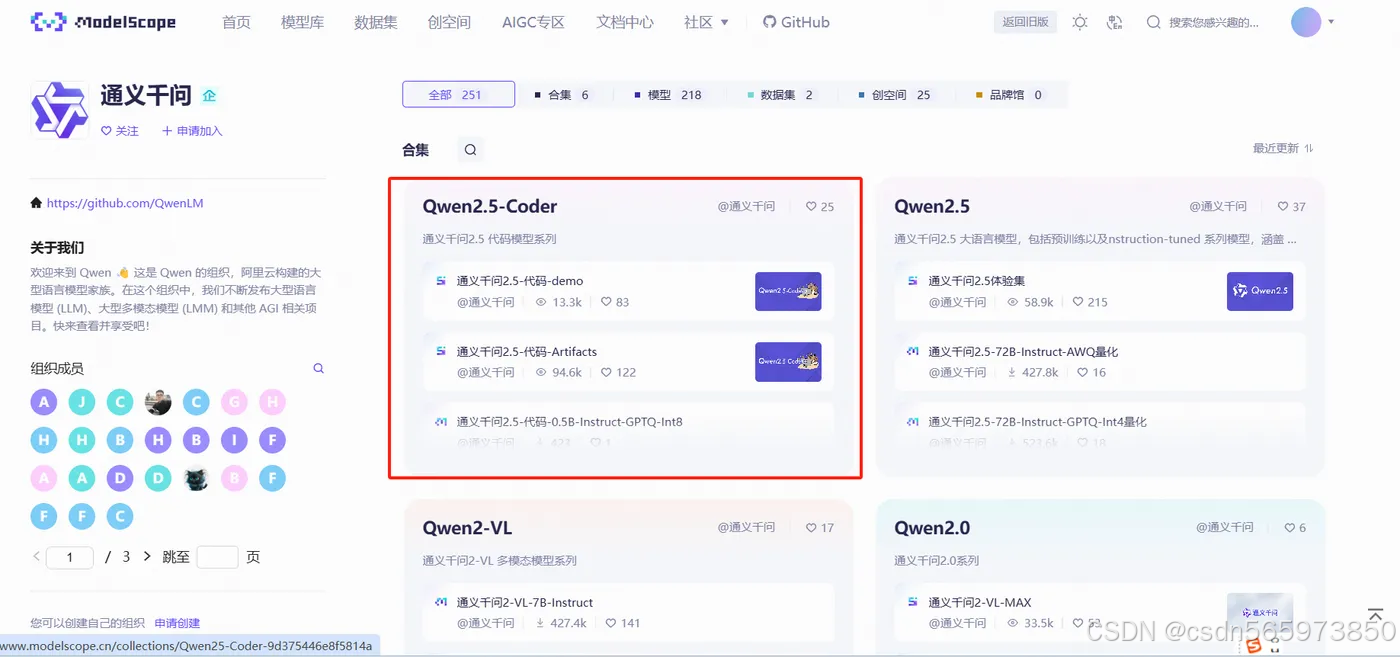

在快速搭建应用管理系统之前,我们先要进入到魔塔社区,通义千问Qwen开源模型库地址:https://www.modelscope.cn/organization/Qwen,点击链接地址进入ModelScope 通义千问Qwen 模型详情页

我们今天主要需要使用的通义千问Qwen开源模型 为 Qwen2.5-Coder,点击Qwen2.5-Coder 模型合集进入Qwen2.5-Coder 模型合集详情页,

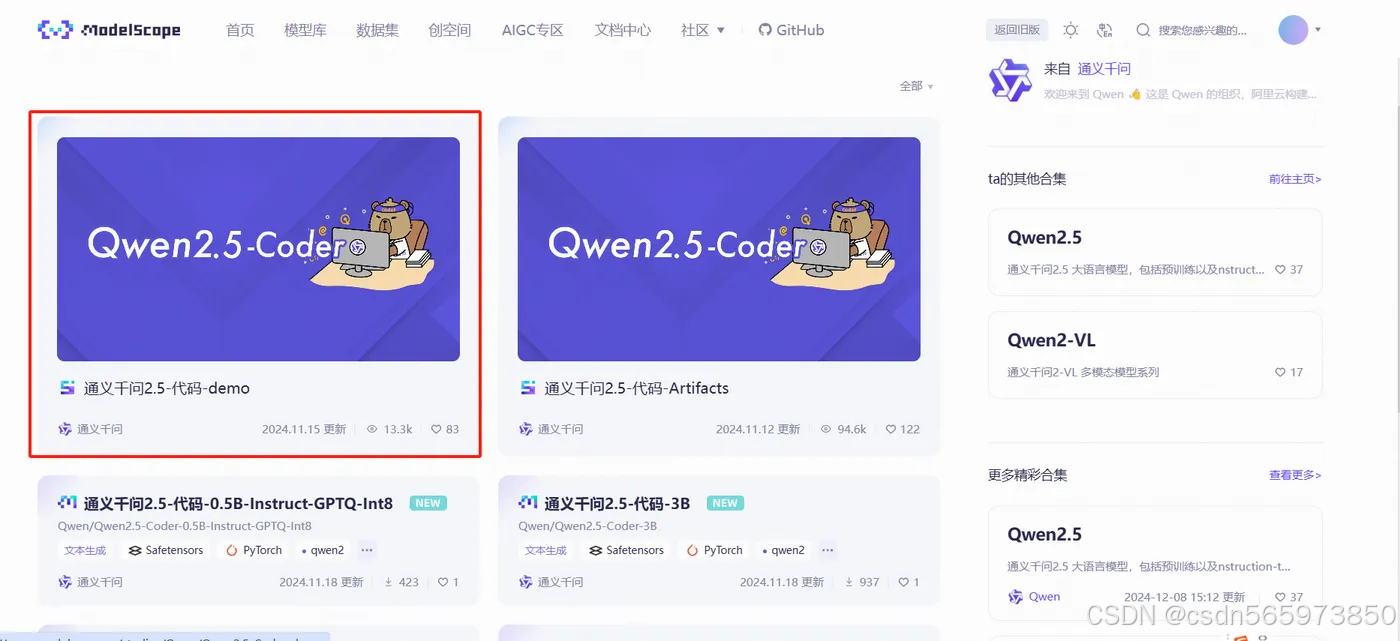

这里我们选择 通义千问2.5-代码-demo 点击模型tab进入模型详情页,在模型详情页输入我们的需求【基于springboot生成一个项目代码包】

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

8888

8888

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?