摘要

随着人工智能技术的快速发展,越来越多的开发者开始关注如何将 AI 能力集成到自己的应用程序中。Ollama 作为一个流行的本地 AI 模型运行平台,为开发者提供了便捷的方式来运行和管理各种大语言模型。本文将详细介绍如何在 Java 8 环境下通过 REST API 调用 Ollama,实现 AI 应用开发。文章从环境搭建、核心技术实现到实际应用案例,逐步讲解如何通过 Java 8 与 Ollama 集成,构建功能强大的 AI 应用。通过本文的学习,读者将能够掌握 Java 8 与 Ollama 的集成方法,并将其应用于实际项目中。

正文

1. 引言

近年来,人工智能技术迅猛发展,特别是大语言模型(LLM)的出现,为各行各业带来了革命性的变化。然而,如何将这些强大的 AI 能力集成到企业现有的 Java 应用系统中,成为了许多开发者面临的重要挑战。

Ollama 是一个开源的 AI 模型运行平台,它简化了在本地环境中运行大语言模型的过程。通过 Ollama,开发者可以轻松地下载、运行和管理各种 AI 模型,而无需深入了解底层的复杂技术细节。

虽然 Java 8 是一个相对较为老旧的 Java 版本,但在许多企业级应用中仍然广泛使用。本文将详细介绍如何在 Java 8 玎境下通过 REST API 调用 Ollama,实现 AI 应用开发,帮助开发者在不升级现有技术栈的情况下,快速集成 AI 能力。

2. Ollama 简介

2.1 什么是 Ollama

Ollama 是一个开源的 AI 模型运行平台,专为在本地环境中运行大语言模型而设计。它提供了简单易用的命令行界面和 REST API,使得开发者可以轻松地管理各种 AI 模型。

Ollama 的主要特点包括:

- 简单易用:通过简单的命令即可下载和运行各种 AI 模型

- 本地运行:所有模型都在本地运行,保护数据隐私

- 跨平台支持:支持 Windows、macOS 和 Linux 等多种操作系统

- 模型丰富:支持多种主流的大语言模型,如 Llama、Mistral 等

- API 支持:提供 REST API,方便与其他应用程序集成

2.2 Ollama 的工作原理

Ollama 通过以下方式工作:

- 模型管理:Ollama 负责下载、存储和管理各种 AI 模型

- 模型运行:Ollama 在本地环境中运行 AI 模型,处理用户请求

- API 接口:Ollama 提供 REST API 接口,允许外部应用程序与其交互

- 资源管理:Ollama 管理模型运行所需的计算资源

3. 环境搭建

3.1 安装 Java 8

确保你的开发环境中安装了 Java 8。可以通过以下命令检查 Java 版本:

java -version

如果尚未安装 Java 8,可以从 Oracle 官方网站下载并安装。

3.2 安装 Docker

由于 Ollama 通常通过 Docker 容器运行,我们需要先安装 Docker。可以从 Docker 官方网站下载并安装 Docker Desktop。

安装完成后,可以通过以下命令验证 Docker 是否正常工作:

docker --version

3.3 安装和运行 Ollama

通过 Docker 安装和运行 Ollama 是最简单的方式。执行以下命令:

docker run -d -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

这条命令会:

- 在后台运行 Ollama 容器(

-d参数) - 将 Ollama 的数据卷挂载到本地(

-v ollama:/root/.ollama) - 将容器的 11434 端口映射到主机的 11434 端口(

-p 11434:11434) - 设置容器名称为 ollama(

--name ollama)

安装完成后,通过以下命令验证 Ollama 是否正常运行:

curl http://localhost:11434/api/tags

如果返回 JSON 格式的模型列表,则说明 Ollama 已正常运行。

3.4 下载 AI 模型

Ollama 支持多种 AI 模型,我们可以根据需要下载合适的模型。例如,下载 Llama2 模型:

docker exec -it ollama ollama pull llama2

或者下载更小的模型,如 Gemma:

docker exec -it ollama ollama pull gemma:2b

4. Java 8 与 Ollama 集成

4.1 项目搭建

我们使用 Maven 构建一个简单的 Java 项目。创建 pom.xml 文件:

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0

http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>com.example</groupId>

<artifactId>ollama-java-demo</artifactId>

<version>1.0-SNAPSHOT</version>

<properties>

<maven.compiler.source>8</maven.compiler.source>

<maven.compiler.target>8</maven.compiler.target>

<project.build.sourceEncoding>UTF-8</project.build.sourceEncoding>

</properties>

<dependencies>

<!-- HTTP 客户端 -->

<dependency>

<groupId>org.apache.httpcomponents</groupId>

<artifactId>httpclient</artifactId>

<version>4.5.14</version>

</dependency>

<!-- JSON 处理 -->

<dependency>

<groupId>com.google.code.gson</groupId>

<artifactId>gson</artifactId>

<version>2.8.9</version>

</dependency>

</dependencies>

</project>

4.2 核心代码实现

创建一个用于与 Ollama 通信的工具类:

import com.google.gson.Gson;

import com.google.gson.JsonObject;

import org.apache.http.HttpEntity;

import org.apache.http.client.methods.CloseableHttpResponse;

import org.apache.http.client.methods.HttpPost;

import org.apache.http.entity.StringEntity;

import org.apache.http.impl.client.CloseableHttpClient;

import org.apache.http.impl.client.HttpClients;

import org.apache.http.util.EntityUtils;

import java.io.IOException;

import java.nio.charset.StandardCharsets;

/**

* Ollama 客户端工具类

* 用于与 Ollama 服务进行通信

*/

public class OllamaClient {

// Ollama 服务地址

private static final String OLLAMA_URL = "http://localhost:11434/api/generate";

// Gson 对象用于 JSON 处理

private final Gson gson = new Gson();

/**

* 向 Ollama 发送请求并获取响应

*

* @param model 模型名称

* @param prompt 提示词

* @return 模型生成的文本

* @throws IOException 网络请求异常

*/

public String generateText(String model, String prompt) throws IOException {

// 创建 HTTP 客户端

try (CloseableHttpClient httpClient = HttpClients.createDefault()) {

// 创建 POST 请求

HttpPost post = new HttpPost(OLLAMA_URL);

post.setHeader("Content-Type", "application/json");

// 构建请求参数

JsonObject requestBody = new JsonObject();

requestBody.addProperty("model", model);

requestBody.addProperty("prompt", prompt);

requestBody.addProperty("stream", false);

// 设置请求体

StringEntity entity = new StringEntity(gson.toJson(requestBody), StandardCharsets.UTF_8);

post.setEntity(entity);

// 发送请求并获取响应

try (CloseableHttpResponse response = httpClient.execute(post)) {

HttpEntity responseEntity = response.getEntity();

if (responseEntity != null) {

// 解析响应

String responseString = EntityUtils.toString(responseEntity);

JsonObject responseObject = gson.fromJson(responseString, JsonObject.class);

return responseObject.get("response").getAsString();

}

}

}

return null;

}

}

创建一个服务类来处理业务逻辑:

import java.io.IOException;

/**

* AI 服务类

* 提供高级的 AI 功能接口

*/

public class AIService {

private final OllamaClient ollamaClient = new OllamaClient();

/**

* 生成文本内容

*

* @param prompt 用户输入的提示词

* @return AI 生成的文本

*/

public String generateContent(String prompt) {

try {

// 使用 llama2 模型生成文本

return ollamaClient.generateText("llama2", prompt);

} catch (IOException e) {

// 处理异常

e.printStackTrace();

return "抱歉,处理您的请求时出现错误: " + e.getMessage();

}

}

/**

* 翻译文本

*

* @param text 待翻译的文本

* @param targetLanguage 目标语言

* @return 翻译后的文本

*/

public String translateText(String text, String targetLanguage) {

String prompt = String.format("请将以下文本翻译成%s:\n%s", targetLanguage, text);

try {

return ollamaClient.generateText("llama2", prompt);

} catch (IOException e) {

e.printStackTrace();

return "翻译失败: " + e.getMessage();

}

}

/**

* 文本摘要

*

* @param text 待摘要的文本

* @return 文本摘要

*/

public String summarizeText(String text) {

String prompt = "请为以下文本生成一个简短的摘要:\n" + text;

try {

return ollamaClient.generateText("llama2", prompt);

} catch (IOException e) {

e.printStackTrace();

return "摘要生成失败: " + e.getMessage();

}

}

}

创建主类用于测试功能:

/**

* 主类 - 演示 Ollama 与 Java 8 的集成

*/

public class OllamaDemo {

public static void main(String[] args) {

// 创建 AI 服务实例

AIService aiService = new AIService();

// 测试文本生成

System.out.println("=== 文本生成测试 ===");

String content = aiService.generateContent("写一首关于春天的诗");

System.out.println("生成内容: " + content);

System.out.println("\n=== 文本翻译测试 ===");

String translated = aiService.translateText("你好,世界!", "英语");

System.out.println("翻译结果: " + translated);

System.out.println("\n=== 文本摘要测试 ===");

String summary = aiService.summarizeText("人工智能是计算机科学的一个分支,它企图了解智能的实质," +

"并生产出一种新的能以人类智能相似的方式做出反应的智能机器。该领域的研究包括机器人、" +

"语言识别、图像识别、自然语言处理和专家系统等。");

System.out.println("摘要结果: " + summary);

}

}

5. 系统架构设计

5.1 架构图

5.2 组件说明

- Java 8 应用:用户开发的应用程序,通过 HTTP 客户端与 Ollama 通信

- HTTP 客户端:负责发送 HTTP 请求到 Ollama 服务

- Ollama REST API:Ollama 提供的 RESTful API 接口

- Docker 容器:运行 Ollama 服务的容器环境

- AI 模型:实际运行的大语言模型

6. 业务流程梳理

6.1 流程图

6.2 流程说明

- 用户向 Java 应用发送请求

- Java 应用处理用户请求,构建发送给 Ollama 的 API 请求

- 通过 HTTP 客户端发送请求到 Ollama 服务

- Ollama 接收请求,加载相应模型进行推理

- 模型生成结果并返回给 Ollama 服务

- Ollama 将结果通过 REST API 返回给 Java 应用

- Java 应用处理返回结果

- 将最终结果返回给用户

7. 实践案例

7.1 智能客服系统

我们来构建一个简单的智能客服系统,展示如何在实际应用中使用 Ollama。

首先创建客服系统的核心类:

import java.time.LocalDateTime;

import java.time.format.DateTimeFormatter;

import java.util.ArrayList;

import java.util.List;

/**

* 智能客服系统

* 演示如何在实际应用中集成 Ollama

*/

public class SmartCustomerService {

private final AIService aiService = new AIService();

private final List<Conversation> conversations = new ArrayList<>();

/**

* 客服对话记录类

*/

static class Conversation {

private final String userQuestion;

private final String aiResponse;

private final String timestamp;

public Conversation(String userQuestion, String aiResponse) {

this.userQuestion = userQuestion;

this.aiResponse = aiResponse;

this.timestamp = LocalDateTime.now().format(DateTimeFormatter.ofPattern("yyyy-MM-dd HH:mm:ss"));

}

// getter 方法

public String getUserQuestion() { return userQuestion; }

public String getAiResponse() { return aiResponse; }

public String getTimestamp() { return timestamp; }

}

/**

* 处理用户问题

*

* @param question 用户问题

* @return AI 回答

*/

public String handleQuestion(String question) {

// 构造更详细的提示词,提供上下文

String prompt = "你是一个专业的客服助手,请用友好、专业的语气回答用户的问题。\n" +

"用户问题: " + question + "\n" +

"请提供详细、准确的回答:";

// 获取 AI 回答

String response = aiService.generateContent(prompt);

// 记录对话

conversations.add(new Conversation(question, response));

return response;

}

/**

* 获取对话历史

*

* @return 对话历史列表

*/

public List<Conversation> getConversationHistory() {

return new ArrayList<>(conversations);

}

/**

* 清除对话历史

*/

public void clearHistory() {

conversations.clear();

}

}

创建测试类验证客服系统功能:

import java.util.List;

/**

* 智能客服系统测试类

*/

public class CustomerServiceTest {

public static void main(String[] args) {

// 创建智能客服实例

SmartCustomerService customerService = new SmartCustomerService();

System.out.println("=== 智能客服系统测试 ===\n");

// 测试问题1

String question1 = "你们的退货政策是什么?";

System.out.println("用户: " + question1);

String response1 = customerService.handleQuestion(question1);

System.out.println("客服: " + response1 + "\n");

// 测试问题2

String question2 = "如何重置我的账户密码?";

System.out.println("用户: " + question2);

String response2 = customerService.handleQuestion(question2);

System.out.println("客服: " + response2 + "\n");

// 测试问题3

String question3 = "产品保修期多长?";

System.out.println("用户: " + question3);

String response3 = customerService.handleQuestion(question3);

System.out.println("客服: " + response3 + "\n");

// 显示对话历史

System.out.println("=== 对话历史 ===");

List<SmartCustomerService.Conversation> history = customerService.getConversationHistory();

for (SmartCustomerService.Conversation conv : history) {

System.out.println("[" + conv.getTimestamp() + "] 用户: " + conv.getUserQuestion());

System.out.println("[" + conv.getTimestamp() + "] 客服: " + conv.getAiResponse());

System.out.println();

}

}

}

7.2 内容创作助手

创建一个内容创作助手,帮助用户生成各种类型的内容:

/**

* 内容创作助手

* 帮助用户生成各种类型的内容

*/

public class ContentCreationAssistant {

private final AIService aiService = new AIService();

/**

* 生成博客文章

*

* @param topic 文章主题

* @param wordCount 字数要求

* @return 生成的文章

*/

public String generateBlogPost(String topic, int wordCount) {

String prompt = String.format("请写一篇关于'%s'的博客文章,字数约%d字。" +

"文章应包括引言、主要内容和结论,语言通俗易懂,结构清晰。", topic, wordCount);

return aiService.generateContent(prompt);

}

/**

* 生成社交媒体内容

*

* @param topic 内容主题

* @param platform 社交媒体平台

* @return 生成的内容

*/

public String generateSocialMediaContent(String topic, String platform) {

String prompt = String.format("为%s平台创作一条关于'%s'的帖子。" +

"内容应该吸引人、简洁明了,适合在%s上分享。", platform, topic, platform);

return aiService.generateContent(prompt);

}

/**

* 生成产品描述

*

* @param productName 产品名称

* @param features 产品特性

* @return 产品描述

*/

public String generateProductDescription(String productName, String[] features) {

StringBuilder featureList = new StringBuilder();

for (String feature : features) {

featureList.append("- ").append(feature).append("\n");

}

String prompt = String.format("为产品'%s'写一段吸引人的产品描述。\n" +

"产品特性包括:\n%s\n" +

"描述应该突出产品的优势和特点,语言生动,能够吸引潜在客户。",

productName, featureList.toString());

return aiService.generateContent(prompt);

}

}

测试内容创作助手:

/**

* 内容创作助手测试类

*/

public class ContentCreationTest {

public static void main(String[] args) {

ContentCreationAssistant assistant = new ContentCreationAssistant();

System.out.println("=== 内容创作助手测试 ===\n");

// 生成博客文章

System.out.println("1. 生成博客文章:");

String blogPost = assistant.generateBlogPost("人工智能在医疗领域的应用", 500);

System.out.println(blogPost + "\n");

// 生成社交媒体内容

System.out.println("2. 生成微博内容:");

String weiboContent = assistant.generateSocialMediaContent("环保生活", "微博");

System.out.println(weiboContent + "\n");

// 生成产品描述

System.out.println("3. 生成产品描述:");

String[] features = {

"超长续航,可达24小时",

"高清显示屏,支持4K分辨率",

"轻薄便携,重量仅1.2kg",

"快速充电,30分钟充电80%"

};

String productDesc = assistant.generateProductDescription("智能笔记本电脑", features);

System.out.println(productDesc);

}

}

8. 注意事项

在使用 Java 8 调用 Ollama 时,需要注意以下几个关键点:

8.1 模型选择

- 模型大小:根据硬件资源选择合适的模型,避免内存不足

- 推理速度:大模型虽然能力强但响应慢,小模型速度快但能力有限

- 专业领域:根据应用领域选择专门训练的模型

8.2 错误处理

在实际项目中,需要完善的错误处理机制:

/**

* 增强版 Ollama 客户端,包含完善的错误处理

*/

public class EnhancedOllamaClient {

private static final String OLLAMA_URL = "http://localhost:11434/api/generate";

private final Gson gson = new Gson();

public String generateText(String model, String prompt) {

try (CloseableHttpClient httpClient = HttpClients.createDefault()) {

HttpPost post = new HttpPost(OLLAMA_URL);

post.setHeader("Content-Type", "application/json");

JsonObject requestBody = new JsonObject();

requestBody.addProperty("model", model);

requestBody.addProperty("prompt", prompt);

requestBody.addProperty("stream", false);

StringEntity entity = new StringEntity(gson.toJson(requestBody), StandardCharsets.UTF_8);

post.setEntity(entity);

// 设置超时时间

post.setConfig(org.apache.http.client.config.RequestConfig.custom()

.setConnectTimeout(5000)

.setSocketTimeout(30000)

.build());

try (CloseableHttpResponse response = httpClient.execute(post)) {

int statusCode = response.getStatusLine().getStatusCode();

if (statusCode == 200) {

HttpEntity responseEntity = response.getEntity();

if (responseEntity != null) {

String responseString = EntityUtils.toString(responseEntity);

JsonObject responseObject = gson.fromJson(responseString, JsonObject.class);

return responseObject.get("response").getAsString();

}

} else if (statusCode == 404) {

throw new RuntimeException("指定的模型未找到,请检查模型名称");

} else if (statusCode == 500) {

throw new RuntimeException("Ollama 服务内部错误");

} else {

throw new RuntimeException("请求失败,状态码: " + statusCode);

}

}

} catch (java.net.SocketTimeoutException e) {

throw new RuntimeException("请求超时,请稍后重试", e);

} catch (IOException e) {

throw new RuntimeException("网络请求异常: " + e.getMessage(), e);

}

return null;

}

}

8.3 性能优化

对于高并发场景,可以考虑以下优化措施:

- 连接池:使用 HTTP 连接池复用连接

- 缓存:对常见问题和答案进行缓存

- 异步处理:使用异步方式处理长时间运行的请求

/**

* 使用连接池的 Ollama 客户端

*/

public class PooledOllamaClient {

private static final String OLLAMA_URL = "http://localhost:11434/api/generate";

private final CloseableHttpClient httpClient;

private final Gson gson = new Gson();

public PooledOllamaClient() {

// 创建带连接池的 HTTP 客户端

this.httpClient = HttpClients.custom()

.setMaxConnTotal(20) // 最大连接数

.setMaxConnPerRoute(10) // 每个路由最大连接数

.build();

}

public String generateText(String model, String prompt) throws IOException {

HttpPost post = new HttpPost(OLLAMA_URL);

post.setHeader("Content-Type", "application/json");

JsonObject requestBody = new JsonObject();

requestBody.addProperty("model", model);

requestBody.addProperty("prompt", prompt);

requestBody.addProperty("stream", false);

StringEntity entity = new StringEntity(gson.toJson(requestBody), StandardCharsets.UTF_8);

post.setEntity(entity);

try (CloseableHttpResponse response = httpClient.execute(post)) {

HttpEntity responseEntity = response.getEntity();

if (responseEntity != null) {

String responseString = EntityUtils.toString(responseEntity);

JsonObject responseObject = gson.fromJson(responseString, JsonObject.class);

return responseObject.get("response").getAsString();

}

}

return null;

}

public void close() throws IOException {

if (httpClient != null) {

httpClient.close();

}

}

}

9. 最佳实践

9.1 模块化设计

将业务逻辑和 AI 调用分离,便于维护和扩展:

// AI 接口定义

public interface AIClient {

String generateText(String model, String prompt) throws IOException;

}

// Ollama 实现

public class OllamaClientImpl implements AIClient {

// 实现细节...

}

// AI 服务层

public class AIService {

private final AIClient aiClient;

public AIService(AIClient aiClient) {

this.aiClient = aiClient;

}

// 业务方法...

}

9.2 安全性

确保 API 调用的安全性,避免敏感信息泄露:

- 不要在日志中记录敏感信息

- 对用户输入进行验证和清理

- 使用 HTTPS(如果 Ollama 配置了 SSL)

9.3 日志记录

记录关键操作的日志,便于问题排查:

import java.util.logging.Logger;

import java.util.logging.Level;

public class LoggingOllamaClient {

private static final Logger logger = Logger.getLogger(LoggingOllamaClient.class.getName());

public String generateText(String model, String prompt) {

logger.info("开始生成文本,模型: " + model);

try {

// 实际调用逻辑

String result = callOllama(model, prompt);

logger.info("文本生成成功,长度: " + (result != null ? result.length() : 0));

return result;

} catch (Exception e) {

logger.log(Level.SEVERE, "文本生成失败", e);

throw new RuntimeException("文本生成失败", e);

}

}

}

10. 常见问题

10.1 Q: 如何选择合适的 Ollama 模型?

A: 选择模型时需要考虑以下因素:

- 硬件资源:根据可用的内存和计算能力选择模型

- 应用需求:根据应用场景选择专门训练的模型

- 响应速度:权衡模型能力和响应时间

常见的模型选择:

- 小型模型(如 Gemma 2B):适合资源受限环境,响应速度快

- 中型模型(如 Llama 2 7B):平衡性能和资源消耗

- 大型模型(如 Llama 2 13B/70B):能力强但资源消耗大

10.2 Q: 如何处理 Ollama 返回的错误?

A: 在调用 Ollama 时,应该捕获异常并记录日志,同时向用户返回友好的错误信息:

public String safeGenerateText(String model, String prompt) {

try {

return ollamaClient.generateText(model, prompt);

} catch (RuntimeException e) {

// 记录详细错误日志

logger.severe("AI 服务调用失败: " + e.getMessage());

// 返回用户友好的错误信息

return "抱歉,暂时无法处理您的请求,请稍后重试。";

} catch (Exception e) {

logger.severe("未知错误: " + e.getMessage());

return "系统出现异常,请联系管理员。";

}

}

10.3 Q: Java 8 是否限制了与 Ollama 的集成?

A: Java 8 虽然是较老的版本,但完全可以通过 HTTP 客户端与 Ollama 集成。主要限制在于:

- 缺少一些现代 Java 特性(如 Lambda 表达式在 Java 8 中有限支持)

- 某些新版本库可能不支持 Java 8

- 并发处理能力相对较弱

但通过合理的设计和第三方库的使用,完全可以实现功能完整的集成。

10.4 Q: 如何提高响应速度?

A: 可以通过以下方式提高响应速度:

- 选择较小的模型

- 使用连接池复用 HTTP 连接

- 对常见查询结果进行缓存

- 优化提示词,使其更精确

- 在 Ollama 端进行模型优化

11. 扩展阅读

- Ollama 官方文档 - Ollama 的官方 GitHub 仓库和文档

- Apache HttpClient 文档 - Java HTTP 客户端库文档

- Gson 用户指南 - Google 的 JSON 处理库文档

- Llama 2 论文 - 了解 Llama 2 模型的技术细节

- Docker 官方文档 - Docker 容器技术文档

12. 总结

本文详细介绍了如何在 Java 8 环境下通过 REST API 调用 Ollama,实现 AI 应用开发。我们从环境搭建、核心技术实现到实际应用案例,全面讲解了 Java 8 与 Ollama 的集成方法。

通过本文的学习,我们了解到:

-

Ollama 简介:Ollama 是一个开源的 AI 模型运行平台,简化了在本地环境中运行大语言模型的过程。

-

环境搭建:通过 Docker 可以快速部署 Ollama 服务,并下载所需的 AI 模型。

-

核心技术实现:使用 Apache HttpClient 和 Gson 库,通过 REST API 与 Ollama 进行通信。

-

实际应用案例:通过智能客服系统和内容创作助手两个案例,展示了如何在实际项目中应用这些技术。

-

注意事项和最佳实践:包括模型选择、错误处理、性能优化、安全性等方面的重要考虑。

-

常见问题解答:针对开发过程中可能遇到的问题提供了详细的解答。

虽然 Java 8 是一个相对老旧的版本,但通过合理的技术选型和设计,我们完全可以在不升级现有技术栈的情况下,成功集成强大的 AI 能力。这为许多仍在使用 Java 8 的企业提供了快速拥抱 AI 技术的途径。

希望本文能够帮助开发者更好地理解和应用 Java 8 调用 Ollama 的技术,为构建智能化应用提供有价值的参考。

参考资料

- Ollama 官方文档. https://github.com/ollama/ollama

- Apache HttpClient 文档. https://hc.apache.org/httpcomponents-client-4.5.x/index.html

- Gson 用户指南. https://github.com/google/gson/blob/master/UserGuide.md

- Docker 官方文档. https://docs.docker.com/

- Llama 2 论文. https://arxiv.org/abs/2307.09288

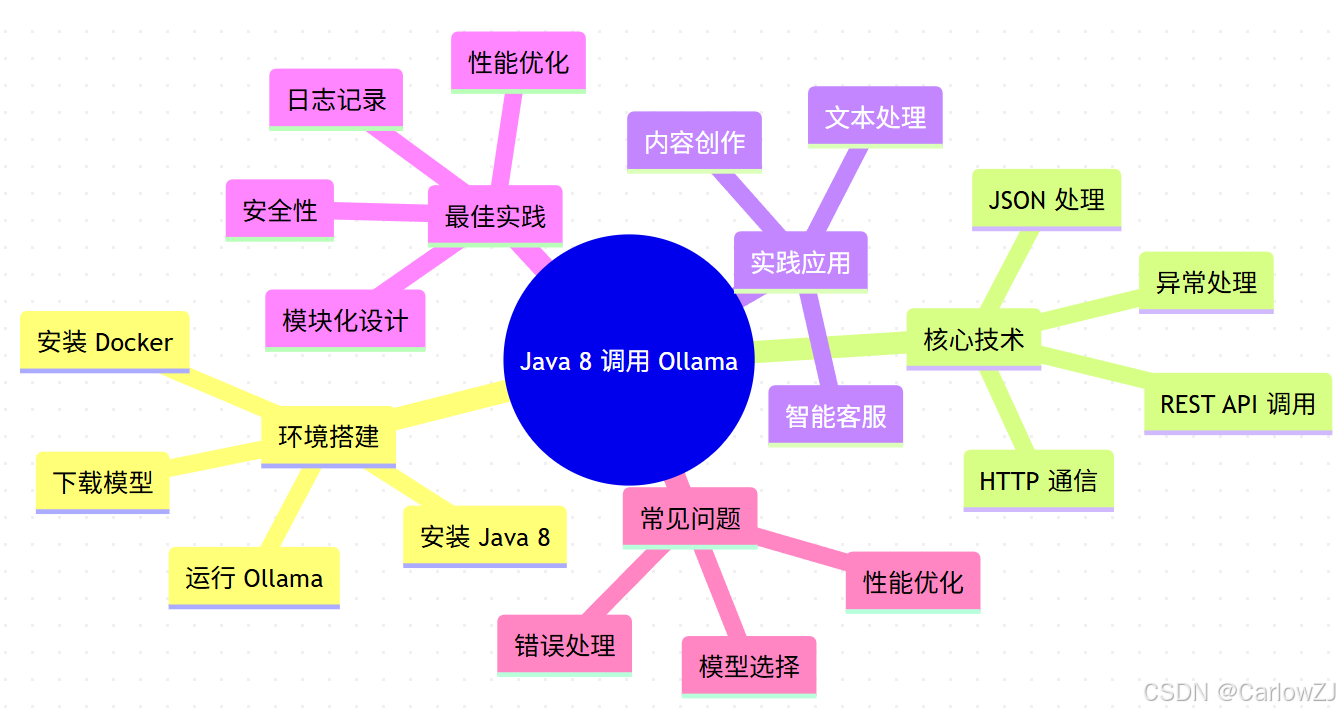

知识点梳理

mindmap

root((Java 8 调用 Ollama))

环境搭建

安装 Java 8

安装 Docker

运行 Ollama

下载模型

核心技术

HTTP 通信

JSON 处理

REST API 调用

异常处理

实践应用

智能客服

内容创作

文本处理

最佳实践

模块化设计

性能优化

安全性

日志记录

常见问题

模型选择

错误处理

性能优化

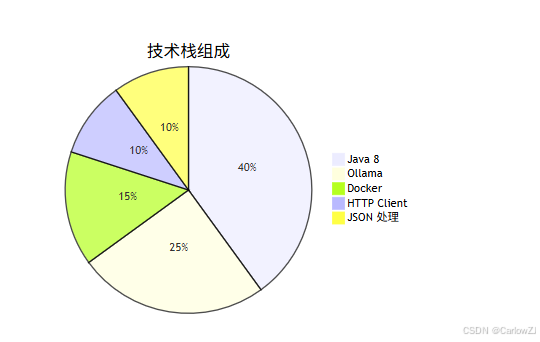

项目实施计划

技术栈分布

交互时序图

Python 代码示例

虽然本文主要介绍 Java 8 的实现,但为了对比,我们也提供一个 Python 版本的实现:

# -*- coding: utf-8 -*-

"""

Python 调用 Ollama 示例

展示与 Java 实现的对比

"""

import requests

import json

class OllamaClient:

"""Ollama 客户端 (Python 版本)"""

def __init__(self, base_url="http://localhost:11434"):

"""

初始化 Ollama 客户端

Args:

base_url (str): Ollama 服务的基础 URL

"""

self.base_url = base_url

def generate_text(self, model, prompt):

"""

生成文本

Args:

model (str): 模型名称

prompt (str): 提示词

Returns:

str: 生成的文本

"""

# 构造请求 URL

url = f"{self.base_url}/api/generate"

# 构造请求数据

data = {

"model": model,

"prompt": prompt,

"stream": False

}

try:

# 发送 POST 请求

response = requests.post(url, json=data, timeout=30)

# 检查响应状态

if response.status_code == 200:

# 解析响应数据

result = response.json()

return result.get("response", "")

else:

raise Exception(f"请求失败,状态码: {response.status_code}")

except requests.exceptions.Timeout:

raise Exception("请求超时,请稍后重试")

except requests.exceptions.RequestException as e:

raise Exception(f"网络请求异常: {str(e)}")

def list_models(self):

"""

获取可用模型列表

Returns:

list: 模型列表

"""

url = f"{self.base_url}/api/tags"

try:

response = requests.get(url)

if response.status_code == 200:

data = response.json()

return [model["name"] for model in data.get("models", [])]

else:

raise Exception(f"获取模型列表失败,状态码: {response.status_code}")

except Exception as e:

raise Exception(f"获取模型列表异常: {str(e)}")

# 使用示例

if __name__ == "__main__":

# 创建客户端实例

client = OllamaClient()

try:

# 列出可用模型

print("可用模型:")

models = client.list_models()

for model in models:

print(f" - {model}")

print("\n" + "="*50)

# 生成文本

print("生成文本:")

result = client.generate_text("llama2", "写一首关于科技的诗")

print(result)

except Exception as e:

print(f"错误: {e}")

重点内容总结

环境搭建是基础:正确安装和配置 Java 8、Docker 和 Ollama 是成功集成的前提。

HTTP 通信是核心:通过 HTTP 客户端与 Ollama 的 REST API 进行通信是实现集成的关键技术。

错误处理不可忽视:完善的异常处理机制是保证系统稳定运行的重要保障。

性能优化提升体验:通过连接池、缓存等技术优化系统性能,提升用户体验。

模块化设计便于维护:良好的架构设计有助于系统的长期维护和扩展。

1189

1189

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?