摘要

本文主要介绍了如何使用Prometheus监控RAGFlow系统,帮助中国开发者,特别是AI应用开发者,快速掌握监控系统的搭建与配置。文章通过详细讲解监控目标的添加、Prometheus的配置、Grafana的可视化以及告警规则的设置,结合实践示例和丰富的图表,帮助读者更好地理解和应用监控技术。

前言

在AI应用开发中,监控系统的稳定性至关重要。RAGFlow作为一种高效的AI开发框架,其监控系统的搭建对于保障系统稳定运行和及时发现潜在问题具有重要意义。本文将详细讲解如何使用Prometheus监控RAGFlow系统,并结合实际案例,提供实用的实践建议。

一、RAGFlow监控概述

1.1 RAGFlow简介

RAGFlow是一个基于Retrieval-Augmented Generation (RAG)的AI开发框架,广泛应用于自然语言处理和文本生成任务。它通过检索增强生成的方式,结合大规模预训练模型,能够高效地生成高质量的文本内容。

RAGFlow的核心优势在于:

- 深度文档理解:采用先进的文档版面分析技术(deepdoc),能够精准解析复杂格式的文档

- 高效检索机制:通过向量检索和重排序技术,提高检索准确率

- 可验证的引用信息:提供来源追溯,确保生成内容的可信度

1.2 监控的重要性

监控系统可以帮助开发者实时了解系统的运行状态,及时发现并解决潜在问题。对于RAGFlow系统,监控的关键指标包括系统性能、资源利用率、错误率等。

监控RAGFlow系统的主要价值包括:

- 实时性能洞察:了解系统响应时间、吞吐量等关键性能指标

- 资源优化:监控CPU、内存、磁盘和网络使用情况,优化资源配置

- 故障预警:及时发现系统异常,避免服务中断

- 业务指标追踪:跟踪对话数、消息数、工作流执行情况等业务指标

二、RAGFlow日志与指标配置

2.1 日志管理

RAGFlow的日志文件默认存放在logs文件夹中,日志格式清晰,包含时间戳、日志级别、进程ID和消息内容。可以通过环境变量LOG_LEVELS调整日志级别。

# 设置日志级别为INFO

export LOG_LEVELS=INFO

日志管理的关键要点:

- 日志级别控制:在生产环境中建议设置为INFO或WARNING级别,避免过多调试信息影响性能

- 日志轮转:定期清理或归档日志文件,防止磁盘空间被占满

- 结构化日志:使用结构化日志格式,便于后续分析和处理

2.2 指标暴露

如果RAGFlow支持Prometheus客户端,可以在关键模块中集成Prometheus客户端,暴露指标接口供监控系统抓取。

# 示例:在RAGFlow中集成Prometheus客户端

from prometheus_client import start_http_server, Counter, Histogram, Gauge

import time

import psutil

import threading

import logging

class RAGFlowMetrics:

"""RAGFlow核心监控指标"""

def __init__(self):

# 业务指标

self.app_conversations = Counter(

'ragflow_app_conversations_total',

'Total number of conversations',

['app_id', 'tenant_id']

)

self.app_messages = Counter(

'ragflow_app_messages_total',

'Total number of messages',

['app_id', 'tenant_id', 'message_type']

)

self.workflow_executions = Counter(

'ragflow_workflow_executions_total',

'Total workflow executions',

['workflow_id', 'status']

)

self.workflow_duration = Histogram(

'ragflow_workflow_duration_seconds',

'Workflow execution duration',

['workflow_id', 'status'],

buckets=[0.1, 0.5, 1.0, 2.5, 5.0, 10.0, 30.0, 60.0]

)

self.token_usage = Counter(

'ragflow_token_usage_total',

'Total token usage',

['model_provider', 'model_name', 'usage_type']

)

self.active_conversations = Gauge(

'ragflow_active_conversations',

'Number of active conversations',

['app_id']

)

# 系统指标

self.cpu_usage = Gauge('system_cpu_usage_percent', 'CPU usage percentage')

self.memory_usage = Gauge('system_memory_usage_bytes', 'Memory usage in bytes')

self.memory_usage_percent = Gauge('system_memory_usage_percent', 'Memory usage percentage')

self.disk_usage = Gauge('system_disk_usage_bytes', 'Disk usage in bytes', ['path'])

self.disk_usage_percent = Gauge('system_disk_usage_percent', 'Disk usage percentage', ['path'])

self.network_bytes_sent = Gauge('system_network_bytes_sent_total', 'Network bytes sent')

self.network_bytes_recv = Gauge('system_network_bytes_received_total', 'Network bytes received')

# 启动监控线程

self._start_monitoring()

def _start_monitoring(self):

"""启动系统监控线程"""

def monitor():

while True:

try:

# 收集CPU使用率

cpu_percent = psutil.cpu_percent(interval=1)

self.cpu_usage.set(cpu_percent)

# 收集内存使用情况

memory = psutil.virtual_memory()

self.memory_usage.set(memory.used)

self.memory_usage_percent.set(memory.percent)

# 收集磁盘使用情况

for disk in ['/']:

disk_usage = psutil.disk_usage(disk)

self.disk_usage.labels(path=disk).set(disk_usage.used)

self.disk_usage_percent.labels(path=disk).set(

(disk_usage.used / disk_usage.total) * 100

)

# 收集网络使用情况

network = psutil.net_io_counters()

self.network_bytes_sent.set(network.bytes_sent)

self.network_bytes_recv.set(network.bytes_recv)

except Exception as e:

logging.error(f"System metrics collection failed: {e}")

# 每30秒收集一次系统指标

time.sleep(30)

# 启动后台监控线程

thread = threading.Thread(target=monitor, daemon=True)

thread.start()

def update_conversation_metrics(self, app_id, tenant_id):

"""更新对话相关指标"""

self.app_conversations.labels(app_id=app_id, tenant_id=tenant_id).inc()

def update_message_metrics(self, app_id, tenant_id, message_type):

"""更新消息相关指标"""

self.app_messages.labels(

app_id=app_id,

tenant_id=tenant_id,

message_type=message_type

).inc()

def update_workflow_metrics(self, workflow_id, status, duration):

"""更新工作流相关指标"""

self.workflow_executions.labels(workflow_id=workflow_id, status=status).inc()

self.workflow_duration.labels(workflow_id=workflow_id, status=status).observe(duration)

def update_token_usage(self, provider, model_name, usage_type, count):

"""更新Token使用量指标"""

self.token_usage.labels(

model_provider=provider,

model_name=model_name,

usage_type=usage_type

).inc(count)

def set_active_conversations(self, app_id, count):

"""设置活跃对话数"""

self.active_conversations.labels(app_id=app_id).set(count)

# 初始化指标收集器

metrics = RAGFlowMetrics()

# 启动指标服务

if __name__ == "__main__":

start_http_server(8000)

print("Prometheus metrics server started on port 8000")

三、Prometheus配置

3.1 添加监控目标

在Prometheus的scrape_configs中添加RAGFlow的监控目标。

scrape_configs:

- job_name: 'ragflow'

static_configs:

- targets: ['localhost:8000']

3.2 配置抓取间隔

可以根据需要调整抓取间隔,默认为15秒。

scrape_interval: 15s

3.3 实践示例

以下是一个完整的Prometheus配置文件示例:

# 全局配置

global:

scrape_interval: 15s # 默认抓取间隔

evaluation_interval: 15s # 规则评估间隔

# 告警管理器配置

alerting:

alertmanagers:

- static_configs:

- targets:

# - alertmanager:9093

# 规则文件

rule_files:

# - "first_rules.yml"

# - "second_rules.yml"

# 抓取配置

scrape_configs:

# Prometheus自身监控

- job_name: 'prometheus'

static_configs:

- targets: ['localhost:9090']

# RAGFlow监控

- job_name: 'ragflow'

metrics_path: '/metrics'

static_configs:

- targets: ['localhost:8000']

labels:

service: 'ragflow-api'

environment: 'production'

# Node Exporter(系统级监控)

- job_name: 'node'

static_configs:

- targets: ['localhost:9100']

labels:

service: 'node-exporter'

environment: 'production'

四、Grafana可视化

4.1 配置数据源

在Grafana中配置Prometheus数据源,连接到Prometheus服务器。

4.2 导入Dashboard

创建或导入适合RAGFlow的Grafana Dashboard,展示关键指标。

4.3 实践示例

以下是一个简单的Grafana Dashboard配置示例:

{

"panels": [

{

"type": "graph",

"title": "Request Latency",

"targets": [

{

"expr": "ragflow_request_latency",

"legendFormat": "Latency",

"refId": "A"

}

]

},

{

"type": "stat",

"title": "Active Conversations",

"targets": [

{

"expr": "ragflow_active_conversations",

"legendFormat": "Active Conversations",

"refId": "B"

}

]

},

{

"type": "gauge",

"title": "CPU Usage",

"targets": [

{

"expr": "system_cpu_usage_percent",

"legendFormat": "CPU Usage %",

"refId": "C"

}

]

}

]

}

五、告警规则设置

5.1 定义告警规则

在Prometheus中定义告警规则,例如当RAGFlow的某个关键指标超过阈值时触发告警。

groups:

- name: ragflow_alerts

rules:

- alert: HighRequestLatency

expr: ragflow_request_latency > 2

for: 1m

labels:

severity: critical

annotations:

summary: "High request latency"

description: "Request latency is above 2 seconds"

- alert: HighCPUUsage

expr: system_cpu_usage_percent > 80

for: 2m

labels:

severity: warning

annotations:

summary: "High CPU usage"

description: "CPU usage has been above 80% for more than 2 minutes"

- alert: LowDiskSpace

expr: system_disk_usage_percent > 90

for: 1m

labels:

severity: critical

annotations:

summary: "Low disk space"

description: "Disk usage is above 90%"

5.2 集成告警系统

将告警规则与Grafana或其他告警系统集成,以便及时收到通知。

5.3 实践示例

以下是一个完整的告警规则文件示例:

groups:

- name: ragflow_alerts

rules:

# 业务相关告警

- alert: HighRequestLatency

expr: histogram_quantile(0.99, rate(ragflow_workflow_duration_seconds_bucket[5m])) > 5

for: 1m

labels:

severity: critical

annotations:

summary: "High request latency (P99)"

description: "99th percentile of request latency is above 5 seconds"

- alert: HighErrorRate

expr: rate(ragflow_app_messages_total{message_type="error"}[5m]) / rate(ragflow_app_messages_total[5m]) > 0.05

for: 1m

labels:

severity: warning

annotations:

summary: "High error rate"

description: "Error rate is above 5%"

# 系统相关告警

- alert: HighCPUUsage

expr: system_cpu_usage_percent > 85

for: 2m

labels:

severity: warning

annotations:

summary: "High CPU usage"

description: "CPU usage has been above 85% for more than 2 minutes"

- alert: HighMemoryUsage

expr: system_memory_usage_percent > 85

for: 2m

labels:

severity: warning

annotations:

summary: "High memory usage"

description: "Memory usage has been above 85% for more than 2 minutes"

- alert: LowDiskSpace

expr: system_disk_usage_percent{path="/"} > 90

for: 1m

labels:

severity: critical

annotations:

summary: "Low disk space"

description: "Root disk usage is above 90%"

六、实践案例

6.1 实际应用场景

假设我们正在开发一个基于RAGFlow的智能客服系统,需要监控系统的请求延迟和错误率。

6.2 实施步骤

- 配置RAGFlow日志和指标:在RAGFlow中集成Prometheus客户端,暴露关键指标。

- 配置Prometheus:添加监控目标,配置抓取间隔。

- 配置Grafana:导入Dashboard,展示关键指标。

- 设置告警规则:定义告警规则,集成告警系统。

6.3 实践示例

以下是一个完整的实施计划:

七、注意事项

7.1 日志级别

在生产环境中,建议将日志级别设置为INFO或WARNING,以避免过多调试信息影响性能。

7.2 监控指标

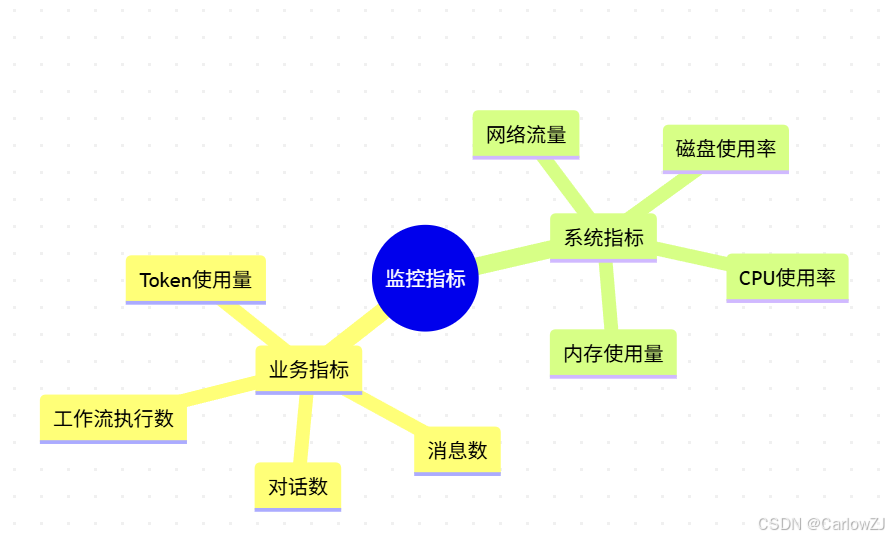

结合业务指标与系统指标,构建综合监控体系:

mindmap

root((监控指标))

业务指标

对话数

消息数

工作流执行数

Token使用量

系统指标

CPU使用率

内存使用量

磁盘使用率

网络流量

7.3 安全性

确保日志和监控数据的安全性,避免敏感信息泄露:

- 限制对监控端点的访问权限

- 使用HTTPS加密传输

- 定期审查和清理监控数据

八、最佳实践

8.1 实施建议

- 监控指标选择:选择关键指标进行监控,避免监控过多指标导致性能下降。

- 告警规则设置:合理设置告警阈值,避免过多误报。

- 数据备份:定期备份监控数据,防止数据丢失。

8.2 常见问题

-

Q: 如何选择监控指标?

- A: 选择与业务相关的关键指标,如请求延迟、错误率等。

-

Q: 如何优化监控性能?

- A: 合理设置抓取间隔,避免过多抓取导致性能问题。

-

Q: 如何处理监控数据的存储?

- A: 根据数据重要性和保留期限,设置合理的数据保留策略。

8.3 扩展阅读

九、总结

本文详细介绍了如何使用Prometheus监控RAGFlow系统,包括日志与指标配置、Prometheus配置、Grafana可视化以及告警规则设置。通过实践案例和丰富的图表,帮助读者更好地理解和应用监控技术。

关键要点总结:

- 指标设计:合理设计业务和系统指标,全面反映系统状态

- 监控配置:正确配置Prometheus和Grafana,实现有效监控

- 告警策略:设置合理的告警规则,及时发现系统问题

- 持续优化:根据实际运行情况,不断优化监控策略

希望本文对广大开发者有所帮助。

Prometheus监控RAGFlow系统实践指南

Prometheus监控RAGFlow系统实践指南

401

401