摘要

本文面向中国AI应用开发者,系统讲解GIN框架在高并发AI服务场景下的性能优化方法与架构设计。内容涵盖路由优化、中间件性能、连接池、异步处理、负载均衡等关键技术,配合架构图、流程图、思维导图、甘特图、饼图等多种可视化展示,辅以详细Python代码示例和最佳实践建议,助力开发者构建高性能、可扩展的AI推理服务。

目录

- 引言

- 高并发AI服务的性能挑战

- GIN性能优化源码结构

- 路由与中间件性能优化

- 连接池与异步处理

- 负载均衡与扩展性设计

- Python实践:高并发AI服务

- 常见问题与注意事项

- 最佳实践与扩展阅读

- 实施计划甘特图

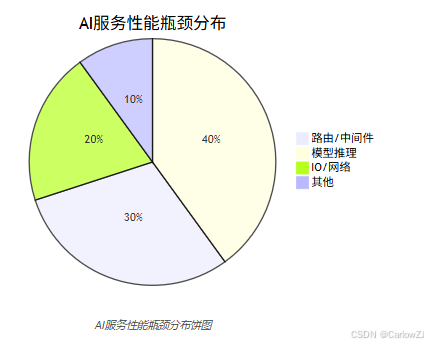

- 性能瓶颈分布饼图

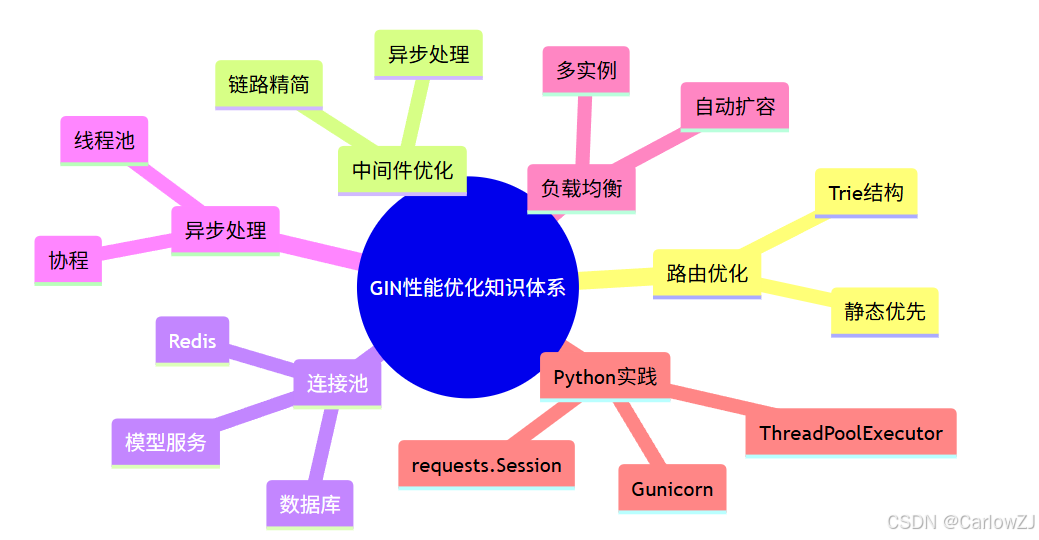

- 知识体系思维导图

- 总结

- 参考资料

引言

高并发AI服务对Web框架性能提出极高要求。GIN以高效路由和灵活中间件著称,适合大规模AI推理服务。本文将带你系统掌握GIN性能优化与高并发架构设计。

高并发AI服务的性能挑战

- 大量并发请求:模型推理、批量数据处理

- 响应延迟敏感:AI服务需低延迟高吞吐

- 资源消耗大:CPU、内存、网络压力

- 典型场景:智能客服、实时推荐、内容审核等

重点:

- 性能瓶颈常见于路由、中间件、IO、模型推理等环节

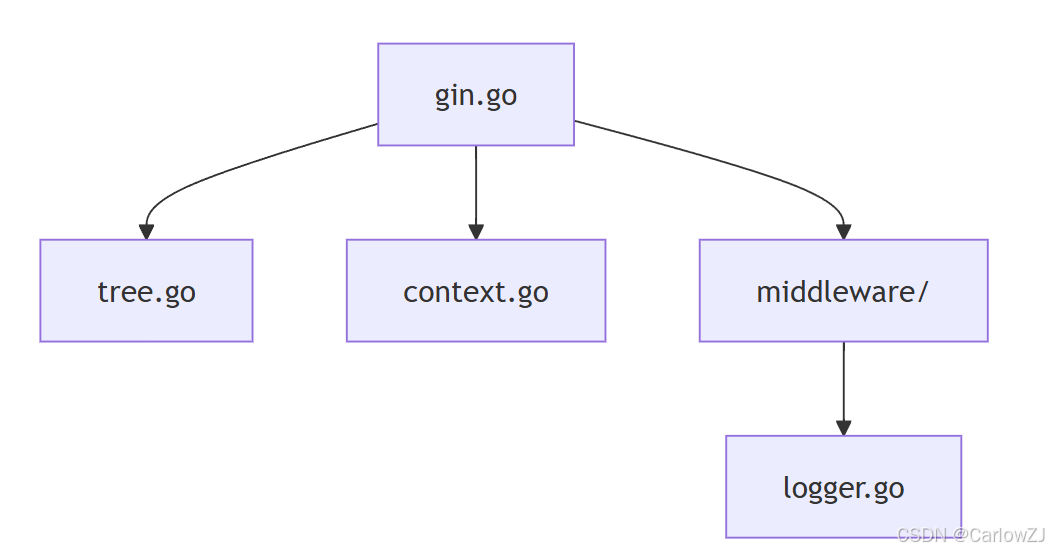

GIN性能优化源码结构

主要源码文件

tree.go:高效路由树实现context.go:请求上下文优化middleware/:中间件性能logger.go:高性能日志

Mermaid架构图

graph TD

A[gin.go] --> B[tree.go]

A --> C[context.go]

A --> D[middleware/]

D --> E[logger.go]

GIN性能优化源码架构图

路由与中间件性能优化

- 路由树Trie结构,O(n)级别查找

- 静态路由优先,减少分支判断

- 中间件链路精简,避免冗余处理

- 日志、监控等建议异步处理

Mermaid流程图

高性能请求处理流程

连接池与异步处理

- 数据库、Redis、模型服务等建议用连接池

- 推理任务可用异步队列提升吞吐

- Python可用

concurrent.futures、asyncio等实现异步

Python连接池与异步示例

import requests

from concurrent.futures import ThreadPoolExecutor

session = requests.Session()

executor = ThreadPoolExecutor(max_workers=10)

def call_model(text):

url = "http://localhost:8000/model/predict"

payload = {"text": text}

resp = session.post(url, json=payload, timeout=3)

return resp.json()

# 异步批量推理

texts = ["文本1", "文本2", "文本3"]

results = list(executor.map(call_model, texts))

print(results)

负载均衡与扩展性设计

- 多实例部署,Nginx/负载均衡器分发请求

- 支持水平扩展,容器化部署

- 监控与自动扩容,保障高可用

Mermaid架构图

高并发AI服务负载均衡架构

Python实践:高并发AI服务

代码示例:Flask + Gunicorn高并发部署

# app.py

from flask import Flask, request, jsonify

app = Flask(__name__)

@app.route('/ai/predict', methods=['POST'])

def predict():

data = request.get_json()

return jsonify({'result': '正面', 'score': 0.98})

# 启动命令:gunicorn -w 8 -b 0.0.0.0:5000 app:app

常见问题与注意事项

注意:

- 路由和中间件链路过长会影响性能

- 日志、监控建议异步处理,避免阻塞主流程

- 连接池参数需根据业务压力合理配置

- 负载均衡需关注会话保持与健康检查

最佳实践与扩展阅读

- 路由表建议定期梳理,避免冗余

- 中间件拆分关注单一职责,便于优化

- Gunicorn/Uvicorn等多进程部署提升并发

- 推荐阅读:Go高性能Web服务实践

实施计划甘特图

性能优化与高并发架构甘特图

性能瓶颈分布饼图

知识体系思维导图

mindmap

root((GIN性能优化知识体系))

路由优化

Trie结构

静态优先

中间件优化

链路精简

异步处理

连接池

数据库

Redis

模型服务

异步处理

线程池

协程

负载均衡

多实例

自动扩容

Python实践

Gunicorn

requests.Session

ThreadPoolExecutor

GIN性能优化知识体系思维导图

总结

本文系统讲解了GIN在高并发AI服务场景下的性能优化方法与架构设计,并结合Python实践演示了高性能服务的关键实现。建议开发者在AI服务开发中,关注性能瓶颈、合理拆分架构,持续优化服务以支撑业务增长。

参考资料

如需获取更多GIN与AI开发实战内容,欢迎关注后续系列博客!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?