摘要

LobeChat 是一个功能强大的开源 AI 聊天应用与开发框架,支持多种大语言模型,具备思维链可视化、分支对话、知识库等创新特性。本文将深入探讨 LobeChat 的技术架构、核心功能实现以及最佳实践,帮助开发者快速构建自己的 AI 聊天应用。

一、LobeChat 概述

1.1 项目背景

LobeChat 是由 LobeHub 团队开发的开源项目,旨在为开发者提供一个现代化的 AI 聊天应用框架。它不仅支持多种主流大语言模型,还提供了丰富的功能扩展和插件系统。

1.2 核心特性

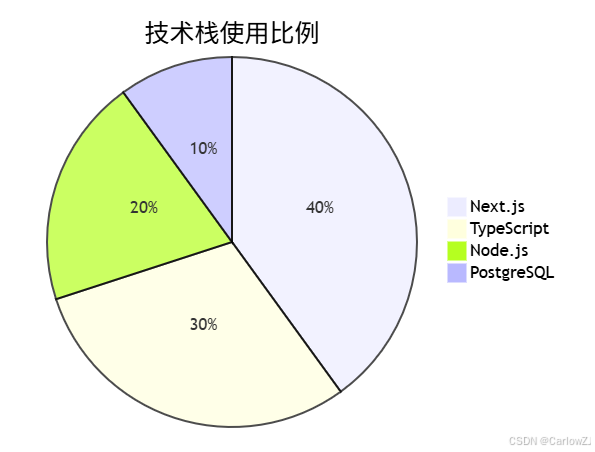

1.3 技术栈

- 前端:Next.js + TypeScript

- 后端:Node.js

- 数据库:PostgreSQL

- 部署:Docker + Vercel

二、系统架构设计

2.1 整体架构

2.2 核心模块

-

模型适配层

- 统一接口设计

- 模型参数配置

- 错误处理机制

-

对话管理系统

- 会话状态管理

- 上下文处理

- 历史记录存储

-

知识库系统

- 文档索引

- 向量存储

- 相似度搜索

三、核心功能实现

3.1 思维链可视化

class ChainOfThought:

def __init__(self):

self.steps = []

self.current_step = None

def add_step(self, thought, action, result):

step = {

'thought': thought,

'action': action,

'result': result

}

self.steps.append(step)

def visualize(self):

# 生成思维链可视化图表

return self.generate_visualization()

3.2 分支对话系统

class ConversationBranch:

def __init__(self):

self.branches = {}

self.current_branch = None

def create_branch(self, parent_id, message):

branch_id = str(uuid.uuid4())

self.branches[branch_id] = {

'parent': parent_id,

'messages': [message],

'created_at': datetime.now()

}

return branch_id

def switch_branch(self, branch_id):

if branch_id in self.branches:

self.current_branch = branch_id

return True

return False

3.3 知识库集成

class KnowledgeBase:

def __init__(self):

self.vector_store = None

self.document_store = {}

def add_document(self, doc_id, content):

# 文档预处理

processed_content = self.preprocess(content)

# 生成向量

vector = self.generate_vector(processed_content)

# 存储文档和向量

self.document_store[doc_id] = {

'content': content,

'vector': vector

}

def search(self, query, top_k=5):

query_vector = self.generate_vector(query)

results = self.vector_search(query_vector, top_k)

return results

四、部署与优化

4.1 部署架构

4.2 性能优化

-

缓存策略

- 对话历史缓存

- 模型响应缓存

- 知识库索引缓存

-

并发处理

- 异步请求处理

- 批量处理优化

- 资源池化管理

五、最佳实践

5.1 开发建议

-

代码组织

- 模块化设计

- 清晰的目录结构

- 统一的编码规范

-

错误处理

- 全局异常处理

- 日志记录

- 监控告警

5.2 部署建议

-

环境配置

- 使用环境变量

- 配置文件管理

- 密钥安全存储

-

监控运维

- 性能监控

- 错误追踪

- 资源使用统计

六、常见问题与解决方案

6.1 性能问题

-

响应延迟

- 优化模型调用

- 实现请求队列

- 使用缓存机制

-

资源消耗

- 实现资源限制

- 优化内存使用

- 定期清理缓存

6.2 功能问题

-

模型兼容性

- 统一接口适配

- 参数标准化

- 错误处理机制

-

知识库更新

- 增量更新机制

- 版本控制

- 数据一致性检查

七、未来展望

7.1 技术演进

-

模型支持

- 更多模型接入

- 模型性能优化

- 自定义模型支持

-

功能扩展

- 多模态交互

- 实时协作

- 个性化定制

7.2 生态建设

-

插件系统

- 标准化接口

- 插件市场

- 开发者工具

-

社区建设

- 技术分享

- 最佳实践

- 问题反馈

总结

LobeChat 作为一个现代化的 AI 聊天应用框架,通过其丰富的功能和灵活的架构设计,为开发者提供了一个强大的工具。通过本文的详细介绍,希望读者能够更好地理解和使用 LobeChat,构建出更优秀的 AI 应用。

参考资料

- LobeChat 官方文档:https://lobehub.com/docs

- Next.js 文档:https://nextjs.org/docs

- OpenAI API 文档:https://platform.openai.com/docs

- Anthropic API 文档:https://docs.anthropic.com

- PostgreSQL 文档:https://www.postgresql.org/docs

附录

A. 项目甘特图

B. 技术栈分布

C. 常见问题解答

-

如何选择合适的模型?

- 根据应用场景选择

- 考虑性能和成本

- 评估模型特性

-

如何优化响应速度?

- 实现缓存机制

- 优化模型调用

- 使用异步处理

-

如何保证系统稳定性?

- 完善的监控系统

- 自动扩缩容

- 故障转移机制

3184

3184

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?