前言

在实际生产环境中,经常需要使用flink读取外部的数据源作为数据的输入流,其中kafka就是重要的实时数据源,flink可以通过消费kafka指定的topic数据达到实时处理的目的,下面演示如何使用flink读取kafka的数据

环境准备

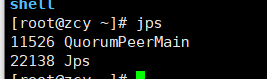

1、安装并启动zk服务

这个相信基本上都会了,就不再演示了

2、安装并启动kafka

本文为演示方便,直接使用docker快速启动一个kafka的容器,可以执行如下命令

docker run -d --name my_kafka \

-p 9092:9092 \

-e KAFKA_BROKER_ID=0 \

-e KAFKA_ZOOKEEPER_CONNECT=ZK公网IP:2181 \

-e KAFKA_ADVERTISED_LISTENERS=PLAINTEXT://ZK公网IP:9092 \

-e KAFKA_LISTENERS=PLAINTEXT://0.0.0.0:9092 wurstmeister/kafka注意执行上面的命令之前,确保zk已经启动

docker命令执行完毕后,检查kafka容器是否创建成功

本文介绍了如何在生产环境中使用 Flink 从 Kafka 实时读取数据。首先,详细阐述了环境准备过程,包括启动 ZooKeeper 和 Kafka 服务,以及创建 Kafka Topic。接着,讲解了编码实现的步骤,包括引入 Flink-Kafka 依赖,并展示了核心代码片段,用于订阅 Kafka Topic 并实时处理接收到的数据。当通过 Kafka 生产者发送消息时,Flink 应用能即时地在控制台输出数据,实现了近实时的数据处理。

本文介绍了如何在生产环境中使用 Flink 从 Kafka 实时读取数据。首先,详细阐述了环境准备过程,包括启动 ZooKeeper 和 Kafka 服务,以及创建 Kafka Topic。接着,讲解了编码实现的步骤,包括引入 Flink-Kafka 依赖,并展示了核心代码片段,用于订阅 Kafka Topic 并实时处理接收到的数据。当通过 Kafka 生产者发送消息时,Flink 应用能即时地在控制台输出数据,实现了近实时的数据处理。

订阅专栏 解锁全文

订阅专栏 解锁全文

1065

1065

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?