中文 CLIP模型

分类问题转为检索问题)

- 准备好多个text prompt和一张image,然后CLIP会根据Text Encoder和Image Encoder输出的特征进行逐一匹配(可以看出分类问题转为检索问题)计算相似分数,根据相似分数从而获取到image对应的最大可能类别,反过来也可得到单个文本与多张图片中的某个进行匹配对应。

zero-shot迁移能力

- 由于CLIP是基于文本与图像进行对比学习,所以对于没出现过(不在训练集里面)的图像,可以根据文本特征与图像特征匹配得到,这也是clip具备强大的zero-shot迁移能力的原因。

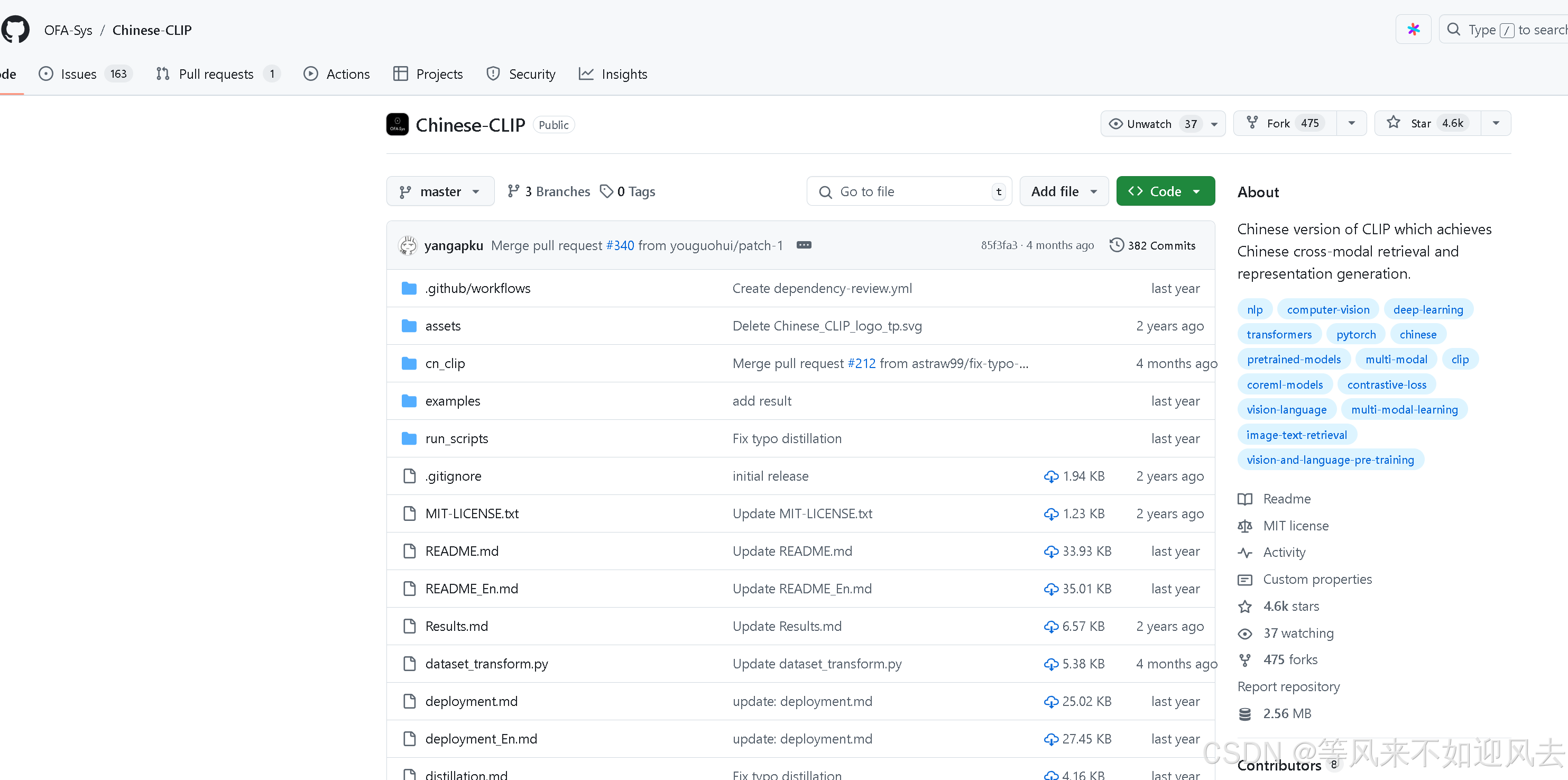

Chinese-CLIP

文章:https://arxiv.org/

订阅专栏 解锁全文

订阅专栏 解锁全文

1206

1206

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?