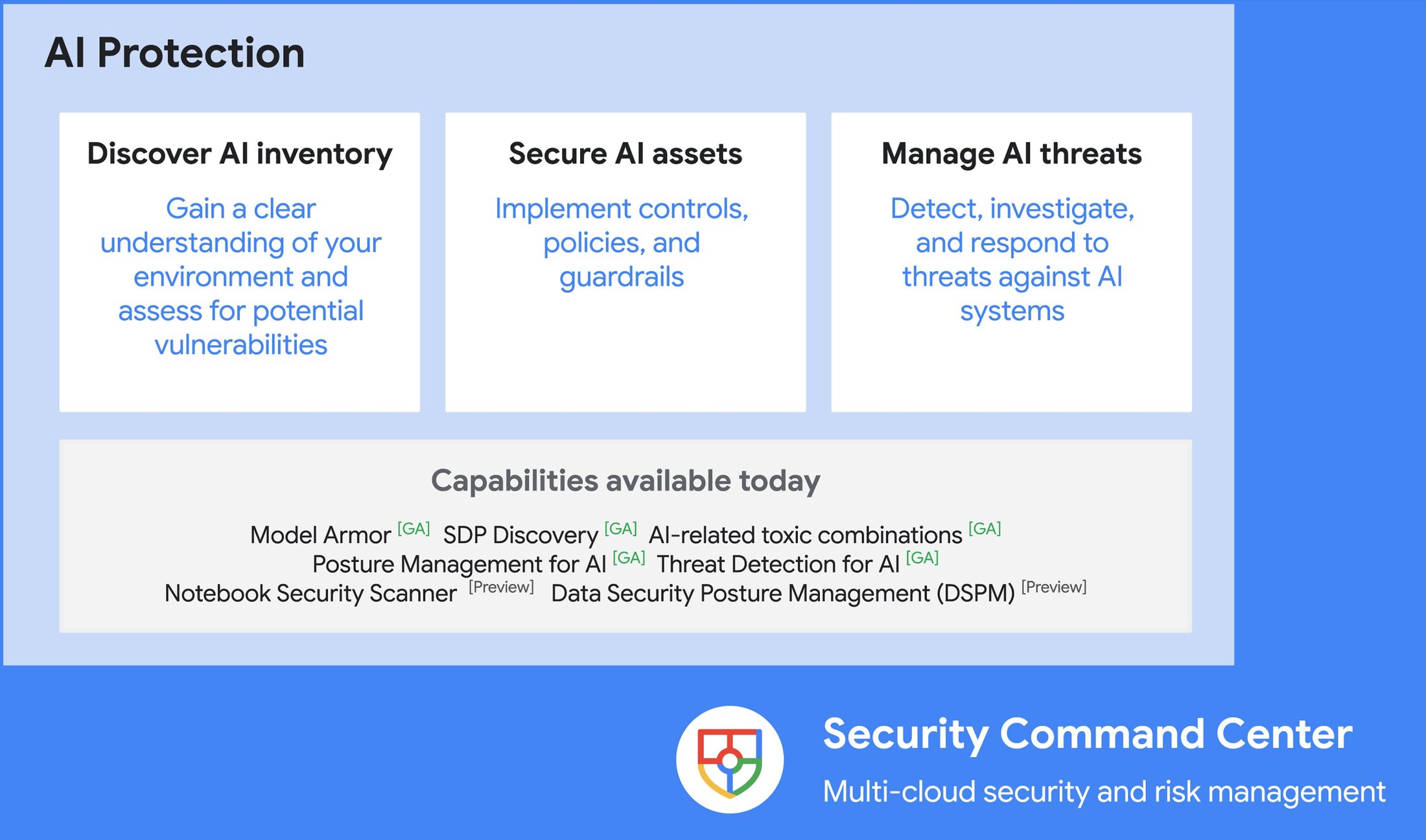

谷歌云最近宣布了AI保护,这是一个全面的解决方案,用于保护与生成式人工智能相关的风险和威胁。

公司表示,AI保护通过发现和评估其AI资产的潜在漏洞,帮助团队有效管理AI风险。此外,通过实施控制和政策来保护AI资产,它还增强了安全性。最后,通过强大的检测和响应能力,它使主动威胁管理成为可能,确保对AI系统相关风险的全面管理。

该解决方案与Google Security Command Center (SCC) 集成,SCC 现在可以为用户在一个中心视图中展示其 IT 状态,并在其他云风险的背景下管理 AI 风险。

(来源: Google Cloud News 博客文章)

公司将这一解决方案带给客户,这是在《网络安全预测报告》中确定的关键发现之一:

攻击者使用人工智能 (AI):威胁行为者将越来越多地使用 AI 进行复杂的网络钓鱼、语音钓鱼和社会工程学攻击。他们还将利用深度伪造进行身份盗窃、欺诈和绕过安全措施。

此外,Mahmoud Rabie,一位主要解决方案顾问,在 LinkedIn 上发布了为什么 AI 保护很重要:

AI模型越来越多地应用于关键应用,这使它们成为网络威胁的有吸引力的目标。诸如数据投毒、对抗攻击和模型泄露等安全风险带来了重大挑战。

公司认为有效的AI风险管理需要了解AI资产及其关系,并识别和保护AI应用程序中的敏感数据。AI保护工具自动化数据发现并使用虚拟红队来检测漏洞,提供增强安全状况的修复建议。

除了理解AI资产,保护它们同样重要。为了保护AI资产,AI Protection利用Model Armor,这是一个完全托管的服务,通过筛查 prompts 和 responses 的安全性和安全性风险,增强AI应用的安全性和可靠性。

(来源: Google Cloud News 博客文章)

在Medium上的一篇博客文章中,Sasha Heyer总结道关于Model Armor:

Model Armor 是增强您的生成式人工智能应用安全性的绝佳选择。它有助于防止提示注入、数据泄露和恶意内容。然而,它缺乏与现有Vertex AI生成式人工智能堆栈的直接集成,这意味着开发人员必须手动将其整合到其工作流程中。

最后,AI Protection利用先进的安全情报和研究来自Google和Mandiant,有效保护客户的AI系统。Security Command Center的检测器在识别与AI工作负载相关的初始访问尝试、权限提升和持久化努力方面发挥着关键作用。公司致力于保持在安全挑战最前沿,即将为AI Protection引入新的检测器,旨在识别和管理运行时威胁,包括基础模型劫持。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?