1.初识大模型

1.1关于大模型

大模型(Large Language Model,LLM)是一种基于海量文本数据训练的人工智能系统,核心是理解和生成人类语言,参数规模大,训练数据量大。

人工智能是使机器模拟人类智能过程的学科,包括学习、推理、自我修正、感知和处理语言,人工智能按照技术实现的不同分为多个子领域

- 人工智能

- 机器学习:在计算机没有明确编程的情况下,对数据进行分析、处理或预测,使计算机系统具备从经验中学习的能力。机器学习可分为以下三类:

- 监督学习:直接告诉内容进行学习

- 无监督学习:自己学习

- 强化学习:不直接进行教学,每次直接进行判断,判断正确给奖励,通过反复尝试和反馈,通过这种奖励机制逐渐学习准确判断

- 深度学习(Deep Learning, DL):使用神经网络模型对数据进行学习和表示,通过对大量数据的学习,自动提取数据的高层次特征和模式,从而实现图像识别、自然语言处理等任务。按照架构的不同,神经网络可以分为:卷积神经网络(CNNs)、循环神经网络(RNNs)、Transformer网络等等。

- 生成式人工智能(Generative AI):在大量原始、未标记的数据基础上对深度学习模型进行预处理,使机器能够理解语言甚至图像 ,并能够根据现需要自动生成内容,使用了大模型支持,例如:Chat GPT

大模型:一类具有大量参数,能在极为广泛的数据进行训练,并适用于多种任务和应用的预训练深度学习模型

1.2大模型的训练

大模型的训练整体上分为三个阶段:预训练、SFT(监督微调)以及RLHF(基于人类反馈的强化学习)

预训练(Pre-training):学习到了不同种类的知识(类似于从婴儿到中学生),但是未学到怎样去领会人类的意图,可能会答非所问,因此我们需要让它能够遵循人类的指示进行回答,这个步骤是SFT(监督微调)

监督微调(SFT,Supervised Fine Tuning):学习到专业知识(类似于从中学生到大学生),可以按照人类的意图去完成基本的对话,但有时候的回答不会符合人类的喜好,所以对模型进行RLHF(基于人类反馈的强化学习)

基于人类反馈的强化学习(RLHF,Reinforcement Learing from Human Feedback):开始工作(类似大学生步入职场的阶段),可能会收到表扬和批评,根据反馈调整自己的工作方法,以获得更多正反馈(大模型在这个阶段会对同一问题进行多次回答,人类会对这些回答打分,大模型会学习到如何输出分数最高的回答)

1.3 大模型的特点

规模和参数大(数亿到数千亿级别的参数数量)

适应性和灵活性强(通过微调或少数样本的学习可以高效的迁移到下游任务)

广泛数据集的预训练(学习广泛的知识)

计算资源需求大(高昂的计算和资源需求,包括但不限于数据存储、训练时间、能量消耗和硬件设施等)

1.4大模型的分类

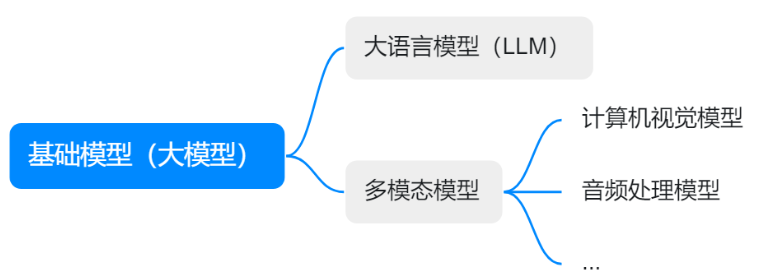

按照应用场景,可大致分为如下:

大语言模型(LLM):专注自然语言的处理(NLP),旨在处理语言、文章、对话等自然语言文本,通常基于深度学习框架(如Transformer模型),经过大规模文本数据集训练而成,捕捉语言的复杂性,包括语法、语义、语境以及蕴含的文化和社会知识,例如chat系列(open AI),通义等

多模态模型:多模态大模型能够同时处理和理解不同感知通道(模态)的数据(如文本、图像、音频、视频等),并在这些模态之间建立关联和交互。能整合不同类型的输入信息,进行跨模态推理、生成和理解任务。

能够捕捉不同模态信息之间的关联

2 大模型是如何工作的

用户使用自然语言和大模型进行交流,用户的文本是提示词,大模型处理提示词的工作流程可以分为两部分,一是分词化与词表映射,二是生成文本

2.1 分词话(Tokenization)与词表映射

分词话是自然语言处理(NLP)中的重要概念,将段落和过程分割成更小的分词(token)的过程,分词话有不同的粒度分类:

1、词粒度(Word-Level Tokenization)分词化,,适用于大多数西方语言,如英语。

2、字符粒度(Character-Level)分词化是中文最直接的分词方法,它是以单个汉字为单位进行分词化。

3、子词粒度(Subword-Level)分词化,它将单词分解成更小的单位,比如词根、词缀等。这种方法对于处理新词(比如专有名词、网络用语等)特别有效。

每一个token都会通过预先设置好的词表,映射为一个token id,这是token的“身份证",一句话最终会被表示为一个元素为token id的列表,供计算机进行下一步处理。

2.2 大语言模型生成文本过程

根据给定的文本预测下一个token。对我们来说,看似像在对大模型提问,但实际上是给了大模型一串提示文本,让它可以对后续的文本进行推理。

大模型的推理过程不是一步到位的,当大模型进行推理时,它会基于现有的token,根据概率最大原则预测出下一个最有可能的token,然后将该预测的token加入到输入序列中,并将更新后的输入序列继续输入大模型预测下一个token,这个过程叫做自回归。直到输出特殊token(如<EOS>,end of sentence,专门用来控制推理何时结束)或输出长度达到阈值,

6万+

6万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?