Redis与Memcached的区别与比较

- Redis不仅仅支持简单的k/v类型的数据,同时还提供list,set,zset,hash等数据结构的存储。memcache支持简单的数据类型,String。

- Redis支持数据的备份,即master-slave模式的数据备份。

- Redis支持数据的持久化,可以将内存中的数据保持在磁盘中,重启的时候可以再次加载进行使用,而Memecache把数据全部存在内存之中

- Redis的速度比memcached快很多

- Memcached是多线程,非阻塞IO复用的网络模型;Redis使用单线程的IO复用模型。

Redis与Memcached的选择

终极策略: 使用Redis的String类型做的事,都可以用Memcached替换,以此换取更好的性能提升; 除此以外,优先考虑Redis;

使用redis有哪些好处? (1) 速度快,因为数据存在内存中,类似于HashMap,HashMap的优势就是查找和操作的时间复杂度都是O(1)

(2)支持丰富数据类型,支持string,list,set,sorted set,hash

(3) 支持事务,操作都是原子性,所谓的原子性就是对数据的更改要么全部执行,要么全部不执行

(4) 丰富的特性:可用于缓存,消息,按key设置过期时间,过期后将会自动删除

Redis常见数据结构使用场景

- String

常用命令: set,get,decr,incr,mget 等。

String数据结构是简单的key-value类型,value其实不仅可以是String,也可以是数字。 常规key-value缓存应用; 常规计数:微博数,粉丝数等。

- Hash

常用命令: hget,hset,hgetall 等。

Hash是一个string类型的field和value的映射表,hash特别适合用于存储对象。 比如我们可以Hash数据结构来存储用户信息,商品信息等等。

举个例子: 最近做的一个电商网站项目的首页就使用了redis的hash数据结构进行缓存,因为一个网站的首页访问量是最大的,所以通常网站的首页可以通过redis缓存来提高性能和并发量。我用jedis客户端来连接和操作我搭建的redis集群或者单机redis,利用jedis可以很容易的对redis进行相关操作。

- List

常用命令: lpush,rpush,lpop,rpop,lrange等 list就是链表,Redis list的应用场景非常多,也是Redis最重要的数据结构之一,比如微博的关注列表,粉丝列表,最新消息排行等功能都可以用Redis的list结构来实现。 Redis list的实现为一个双向链表,即可以支持反向查找和遍历,更方便操作,不过带来了部分额外的内存开销。

- Set

常用命令: sadd,spop,smembers,sunion 等 set对外提供的功能与list类似是一个列表的功能,特殊之处在于set是可以自动排重的。 当你需要存储一个列表数据,又不希望出现重复数据时,set是一个很好的选择,并且set提供了判断某个成员是否在一个set集合内的重要接口,这个也是list所不能提供的。 在微博应用中,可以将一个用户所有的关注人存在一个集合中,将其所有粉丝存在一个集合。Redis可以非常方便的实现如共同关注、共同喜好、二度好友等功能。

- Sorted Set

常用命令: zadd,zrange,zrem,zcard等 和set相比,sorted set增加了一个权重参数score,使得集合中的元素能够按score进行有序排列。 举例: 在直播系统中,实时排行信息包含直播间在线用户列表,各种礼物排行榜,弹幕消息(可以理解为按消息维度的消息排行榜)等信息,适合使用Redis中的SortedSet结构进行存储。

Redis有哪些数据淘汰策略

相关知识:redis 内存数据集大小上升到一定大小的时候,就会施行数据淘汰策略(回收策略)。redis 提供 6种数据淘汰策略:

- volatile-lru:从已设置过期时间的数据集(server.db[i].expires)中挑选最近最少使用的数据淘汰

- volatile-ttl:从已设置过期时间的数据集(server.db[i].expires)中挑选将要过期的数据淘汰

- volatile-random:从已设置过期时间的数据集(server.db[i].expires)中任意选择数据淘汰

- allkeys-lru:从数据集(server.db[i].dict)中挑选最近最少使用的数据淘汰

- allkeys-random:从数据集(server.db[i].dict)中任意选择数据淘汰

- no-enviction(驱逐):禁止驱逐数据

Redis的并发竞争问题如何解决?

Redis的并发竞争问题,主要是发生在并发写竞争。

Redis为单进程单线程模式,采用队列模式将并发访问变为串行访问。Redis本身没有锁的概念,Redis对于多个客户端连接并不存在竞争,但是在Jedis客户端对Redis进行并发访问时会发生连接超时、数据转换错误、阻塞、客户端关闭连接等问题,这些问题均是由于客户端连接混乱造成

考虑到redis没有像db中的sql语句,update val = val + 10 where ...,无法使用这种方式进行对数据的更新。 假如有某个key = "price", value值为10,现在想把value值进行+10操作。正常逻辑下,就是先把数据key为price的值读回来,加上10,再把值给设置回去。如果只有一个连接的情况下,这种方式没有问题,可以工作得很好,但如果有两个连接时,两个连接同时想对还price进行+10操作,就可能会出现问题了。 例如:两个连接同时对price进行写操作,同时加10,最终结果我们知道,应该为30才是正确。 考虑到一种情况: T1时刻,连接1将price读出,目标设置的数据为10+10 = 20。 T2时刻,连接2也将数据读出,也是为10,目标设置为20。 T3时刻,连接1将price设置为20。 T4时刻,连接2也将price设置为20,则最终结果是一个错误值20。

解决方案:

方案1

利用redis自带的incr命令,具体用法看这里http://doc.redisfans.com/string/incr.html。

方案2

可以使用独占锁的方式,类似操作系统的mutex机制。(网上有例子,http://blog.youkuaiyun.com/black_ox/article/details/48972085 不过实现相对复杂,成本较高)

方案3

使用乐观锁的方式进行解决(成本较低,非阻塞,性能较高)

如何用乐观锁方式进行解决?

本质上是假设不会进行冲突,使用redis的命令watch进行构造条件。伪代码如下:

watch price

get price $price

$price = $price + 10

multi

set price $price

exec

解释一下:

watch这里表示监控该key值,后面的事务是有条件的执行,如果从watch的exec语句执行时,watch的key对应的value值被修改了,则事务不会执行。

具体看Redis的事务功能详解这篇文章里的watch命令介绍。

方案4

这个是针对客户端来的,在代码里要对redis操作的时候,针对同一key的资源,就先进行加锁(java里的synchronized或lock)。

方案5

利用redis的setnx实现内置的锁,具体看http://www.cnblogs.com/0201zcr/p/5942748.html这篇文章介绍

while 1:

lock = redis.SETNX(key, time.now() + timeout)

if lock == 1:

// 获得锁

break

lock_ts = redis.GET(key)

if (lock_ts < time.now()) && (redis.GETSET(key, time.now() + timeout) < time.now()):

// 锁已经过期,用GETSET重新写锁

// 返回的原来的时间仍旧过期,说明加锁成功

break

else:

sleep

.... do something ...

// 完成之后释放锁

redis.DEL(key)

Java代码实现

import org.slf4j.Logger;

import org.slf4j.LoggerFactory;

import org.springframework.dao.DataAccessException;

import org.springframework.data.redis.connection.RedisConnection;

import org.springframework.data.redis.core.RedisCallback;

import org.springframework.data.redis.core.RedisTemplate;

import org.springframework.data.redis.serializer.StringRedisSerializer;

/**

* Redis distributed lock implementation.

*

* [@author](https://my.oschina.net/arthor) zhengcanrui

*/

public class RedisLock {

private static Logger logger = LoggerFactory.getLogger(RedisLock.class);

private RedisTemplate redisTemplate;

private static final int DEFAULT_ACQUIRY_RESOLUTION_MILLIS = 100;

/**

* Lock key path.

*/

private String lockKey;

/**

* 锁超时时间,防止线程在入锁以后,无限的执行等待

*/

private int expireMsecs = 60 * 1000;

/**

* 锁等待时间,防止线程饥饿

*/

private int timeoutMsecs = 10 * 1000;

private volatile boolean locked = false;

/**

* Detailed constructor with default acquire timeout 10000 msecs and lock expiration of 60000 msecs.

*

* [@param](https://my.oschina.net/u/2303379) lockKey lock key (ex. account:1, ...)

*/

public RedisLock(RedisTemplate redisTemplate, String lockKey) {

this.redisTemplate = redisTemplate;

this.lockKey = lockKey + "_lock";

}

/**

* Detailed constructor with default lock expiration of 60000 msecs.

*

*/

public RedisLock(RedisTemplate redisTemplate, String lockKey, int timeoutMsecs) {

this(redisTemplate, lockKey);

this.timeoutMsecs = timeoutMsecs;

}

/**

* Detailed constructor.

*

*/

public RedisLock(RedisTemplate redisTemplate, String lockKey, int timeoutMsecs, int expireMsecs) {

this(redisTemplate, lockKey, timeoutMsecs);

this.expireMsecs = expireMsecs;

}

/**

* [@return](https://my.oschina.net/u/556800) lock key

*/

public String getLockKey() {

return lockKey;

}

private String get(final String key) {

Object obj = null;

try {

obj = redisTemplate.execute(new RedisCallback<Object>() {

[@Override](https://my.oschina.net/u/1162528)

public Object doInRedis(RedisConnection connection) throws DataAccessException {

StringRedisSerializer serializer = new StringRedisSerializer();

byte[] data = connection.get(serializer.serialize(key));

connection.close();

if (data == null) {

return null;

}

return serializer.deserialize(data);

}

});

} catch (Exception e) {

logger.error("get redis error, key : {}", key);

}

return obj != null ? obj.toString() : null;

}

private boolean setNX(final String key, final String value) {

Object obj = null;

try {

obj = redisTemplate.execute(new RedisCallback<Object>() {

[@Override](https://my.oschina.net/u/1162528)

public Object doInRedis(RedisConnection connection) throws DataAccessException {

StringRedisSerializer serializer = new StringRedisSerializer();

Boolean success = connection.setNX(serializer.serialize(key), serializer.serialize(value));

connection.close();

return success;

}

});

} catch (Exception e) {

logger.error("setNX redis error, key : {}", key);

}

return obj != null ? (Boolean) obj : false;

}

private String getSet(final String key, final String value) {

Object obj = null;

try {

obj = redisTemplate.execute(new RedisCallback<Object>() {

@Override

public Object doInRedis(RedisConnection connection) throws DataAccessException {

StringRedisSerializer serializer = new StringRedisSerializer();

byte[] ret = connection.getSet(serializer.serialize(key), serializer.serialize(value));

connection.close();

return serializer.deserialize(ret);

}

});

} catch (Exception e) {

logger.error("setNX redis error, key : {}", key);

}

return obj != null ? (String) obj : null;

}

/**

* 获得 lock.

* 实现思路: 主要是使用了redis 的setnx命令,缓存了锁.

* reids缓存的key是锁的key,所有的共享, value是锁的到期时间(注意:这里把过期时间放在value了,没有时间上设置其超时时间)

* 执行过程:

* 1.通过setnx尝试设置某个key的值,成功(当前没有这个锁)则返回,成功获得锁

* 2.锁已经存在则获取锁的到期时间,和当前时间比较,超时的话,则设置新的值

*

* @return true if lock is acquired, false acquire timeouted

* @throws InterruptedException in case of thread interruption

*/

public synchronized boolean lock() throws InterruptedException {

int timeout = timeoutMsecs;

while (timeout >= 0) {

long expires = System.currentTimeMillis() + expireMsecs + 1;

String expiresStr = String.valueOf(expires); //锁到期时间

if (this.setNX(lockKey, expiresStr)) {

// lock acquired

locked = true;

return true;

}

String currentValueStr = this.get(lockKey); //redis里的时间

if (currentValueStr != null && Long.parseLong(currentValueStr) < System.currentTimeMillis()) {

//判断是否为空,不为空的情况下,如果被其他线程设置了值,则第二个条件判断是过不去的

// lock is expired

String oldValueStr = this.getSet(lockKey, expiresStr);

//获取上一个锁到期时间,并设置现在的锁到期时间,

//只有一个线程才能获取上一个线上的设置时间,因为jedis.getSet是同步的

if (oldValueStr != null && oldValueStr.equals(currentValueStr)) {

//防止误删(覆盖,因为key是相同的)了他人的锁——这里达不到效果,这里值会被覆盖,但是因为什么相差了很少的时间,所以可以接受

//[分布式的情况下]:如过这个时候,多个线程恰好都到了这里,但是只有一个线程的设置值和当前值相同,他才有权利获取锁

// lock acquired

locked = true;

return true;

}

}

timeout -= DEFAULT_ACQUIRY_RESOLUTION_MILLIS;

/*

延迟100 毫秒, 这里使用随机时间可能会好一点,可以防止饥饿进程的出现,即,当同时到达多个进程,

只会有一个进程获得锁,其他的都用同样的频率进行尝试,后面有来了一些进行,也以同样的频率申请锁,这将可能导致前面来的锁得不到满足.

使用随机的等待时间可以一定程度上保证公平性

*/

Thread.sleep(DEFAULT_ACQUIRY_RESOLUTION_MILLIS);

}

return false;

}

/**

* Acqurired lock release.

*/

public synchronized void unlock() {

if (locked) {

redisTemplate.delete(lockKey);

locked = false;

}

}

}

Java调用代码

RedisLock lock = new RedisLock(redisTemplate, key, 10000, 20000);

try {

if(lock.lock()) {

//需要加锁的代码

}

}

} catch (InterruptedException e) {

e.printStackTrace();

}finally {

//为了让分布式锁的算法更稳键些,持有锁的客户端在解锁之前应该再检查一次自己的锁是否已经超时,再去做DEL操作,因为可能客户端因为某个耗时的操作而挂起,

//操作完的时候锁因为超时已经被别人获得,这时就不必解锁了。 ————这里没有做

lock.unlock();

}

Redis高可用方案

Redis高可用方案有三种:

1)主从复制模式

2)哨兵(Sentinel)

3)集群(Cluster)-Redis3.x以后功能

第三种的集群模式是在Redis 3.x以后的版本才增加进来的。

主从复制模式

主从复制(Master-Slave Replication)的工作原理

Slave从节点服务启动并连接到Master之后,它将主动发送一个SYNC命令。Master服务主节点收到同步命令后将启动后台存盘进程,同时收集所有接收到的用于修改数据集的命令,在后台进程执行完毕后,Master将传送整个数据库文件到Slave,以完成一次完全同步。而Slave从节点服务在接收到数据库文件数据之后将其存盘并加载到内存中。此后,Master主节点继续将所有已经收集到的修改命令,和新的修改命令依次传送给Slaves,Slave将在本次执行这些数据修改命令,从而达到最终的数据同步。

主从复制的配置

主节点关键配置项

bind 192.168.127.128

port 6379

timeout 30 # Client 端空闲断开连接的时间

daemonize yes #默认值是no,把值修改为yes,以后台模式运行

logfile /root/application/program/redis-tool/logs/redis.log #日志文件的位置

dir /root/application/program/redis-tool/datas #SNAPSHOTTING文件的路径

appendonly yes #默认值是No,意思是不使用AOF增量持久化的方式,使用RDB全量持久化的方式。把No值改成Yes,使用AOF增量持久化的方式

appendfsync always

从节点关键配置项

bind 192.168.127.129

port 6379

timeout 30 # Client 端空闲断开连接的时间

daemonize yes #默认值是no,把值修改为yes,以后台模式运行

logfile /root/application/program/redis/logs/redis.log #日志文件的位置

dir /root/application/program/redis/datas #SNAPSHOTTING文件的路径

laveof 192.168.127.128 6379

slave-serve-stale-data no #如果slave 无法与master 同步,设置成slave不可读,方便监控脚本发现问题。

appendonly yes #默认值是No,意思是不使用AOF增量持久化的方式,使用RDB全量持久化的方式。把No值改成Yes,使用AOF增量持久化的方式

appendfsync always

主从模式的优缺点 1、Redis的Replication的特点和优点:

- 同一个Master可以同步多个Slaves。

- Slave同样可以接受其它Slaves的连接和同步请求,这样可以有效的分载Master的同步压力。因此我们可以将Redis的Replication架构视为图结构。

- Master Server是以非阻塞的方式为Slaves提供服务。所以在Master-Slave同步期间,客户端仍然可以提交查询或修改请求。

- Slave Server同样是以非阻塞的方式完成数据同步。在同步期间,如果有客户端提交查询请求,Redis则返回同步之前的数据。

- 为了分载Master的读操作压力,Slave服务器可以为客户端提供只读操作的服务,写服务仍然必须由Master来完成。即便如此,系统的伸缩性还是得到了很大的提高。

- Master可以将数据保存操作交给Slaves完成,从而避免了在Master中要有独立的进程来完成此操作。 支持主从复制,主机会自动将数据同步到从机,可以进行读写分离。

2、Redis的Replication的缺点:

- Redis不具备自动容错和恢复功能,主机从机的宕机都会导致前端部分读写请求失败,需要等待机器重启或者手动切换前端的IP才能恢复。

- 主机宕机,宕机前有部分数据未能及时同步到从机,切换IP后还会引入数据不一致的问题,降低了系统的可用性。

- Redis的主从复制采用全量复制,复制过程中主机会fork出一个子进程对内存做一份快照,并将子进程的内存快照保存为文件发送给从机,这一过程需要确保主机有足够多的空余内存。若快照文件较大,对集群的服务能力会产生较大的影响,而且复制过程是在从机新加入集群或者从机和主机网络断开重连时都会进行,也就是网络波动都会造成主机和从机间的一次全量的数据复制,这对实际的系统运营造成了不小的麻烦。

- Redis较难支持在线扩容,在集群容量达到上限时在线扩容会变得很复杂。为避免这一问题,运维人员在系统上线时必须确保有足够的空间,这对资源造成了很大的浪费。

redis的主从模式很简单,在实际的生产环境中是很少使用的,因此不建议在实际的生产环境中使用主从模式来提供系统的高可用性,之所以不建议使用都是由它的缺点造成的,在数据量非常大的情况,或者对系统的高可用性要求很高的情况下,主从模式也是不稳定的。

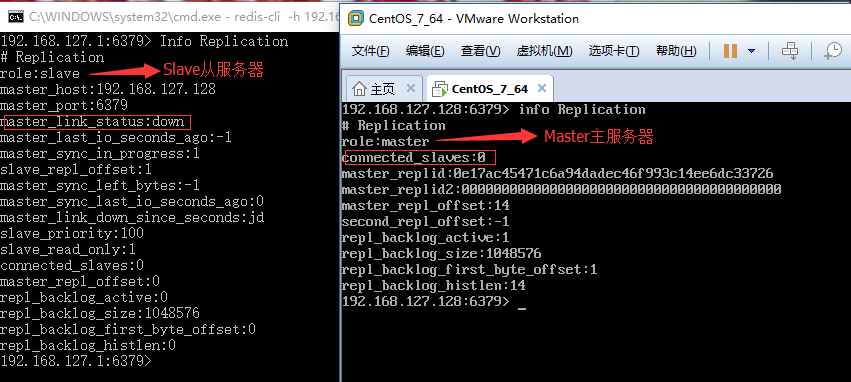

查看主从信息:

哨兵模式

其中哨兵与集群是两个独立的功能,但从特性来看哨兵可以视为集群的子集。当不需要数据分片或者已经利用客户端分片的场景下哨兵已经足够使用,如果需要水平扩容,Cluster是非常好的选择。每个集群至少三台主节点。

哨兵模式的优缺点 优点: 1、哨兵集群模式是基于主从模式的,所有主从的优点,哨兵模式同样具有。 2、主从可以切换,故障可以转移,系统可用性更好。 3、哨兵模式是主从模式的升级,系统更健壮,可用性更高。

缺点:

1、Redis较难支持在线扩容,在集群容量达到上限时在线扩容会变得很复杂。为避免这一问题,运维人员在系统上线时必须确保有足够的空间,这对资源造成了很大的浪费。

Redis的哨兵模式是以主从模式为基础的,所以说,主从模式拥有的一些缺点,在哨兵模式下也具有。哨兵模式主要是监控Master主服务器的运行情况,当然也会监控Slave从服务器的运行情况,如果Master主服务器发生了故障,该模式可以保证Slave从服务器顺利升级为Master主服务器继续提供服务,以此提高系统的高可用性。虽然哨兵模式比主从模式提高了不少系统的高可用性,但是该模式不能水平扩容,不能动态的增、删节点,这也是限制哨兵模式广泛应用的主要原因。Redis也看到了这个情况,所在在Redis的3.x以后的版本提供了一个更加强大集群模式,那就是Cluster集群模式。

介绍

Redis Sentinel 是一个分布式系统, 你可以在一个架构中运行多个 Sentinel 进程(progress), 这些进程使用流言协议(gossip protocols)来接收关于主服务器是否下线的信息, 并使用投票协议(agreement protocols)来决定是否执行自动故障迁移, 以及选择哪个从服务器作为新的主服务器。 虽然 Redis Sentinel 释出为一个单独的可执行文件 redis-sentinel , 但实际上它只是一个运行在特殊模式下的 Redis 服务器, 你可以在启动一个普通 Redis 服务器时通过给定 --sentinel 选项来启动 Redis Sentinel 。 Sentinel 系统用于管理多个 Redis 服务器(instance), 该系统执行以下三个任务:

- 监控(Monitoring): Sentinel 会不断地检查你的主服务器和从服务器是否运作正常。

- 提醒(Notification): 当被监控的某个 Redis 服务器出现问题时, Sentinel 可以通过 API 向管理员或者其他应用程序发送通知。

- 自动故障迁移(Automatic failover): 当一个主服务器不能正常工作时, Sentinel 会开始一次自动故障迁移操作, 它会将失效主服务器的其中一个从服务器升级为新的主服务器, 并让失效主服务器的其他从服务器改为复制新的主服务器; 当客户端试图连接失效的主服务器时, 集群也会向客户端返回新主服务器的地址, 使得集群可以使用新主服务器代替失效服务器。

环境与配置

环境说明

redis版本:3.2.11

ip:192.168.137.40

主:6379 ,sentinel:26379

从:6380 ,sentinel:26380

配置

当主Redis服务宕机了从Redis服务接替主成为新的主,宕机的主启动后自动变成了从,其实它和Mysql的双主模式是一样的互为主从;redis哨兵需要用到redis-sentinel程序和sentinel.conf配置文件。

mkdir -p /usr/local/redis

#主redis服务目录

mkdir -p /usr/local/redis/6379

#从redis服务目录

mkdir -p /usr/local/redis/6380

#集群配置目录

mkdir -p /usr/local/redis/redis_cluster

主配置

vim redis_6379.conf

daemonize yes

pidfile /usr/local/redis/6379/redis_6379.pid

port 6379

tcp-backlog 128

timeout 0

tcp-keepalive 0

loglevel notice

logfile ""

databases 16

save 900 1 ###save

save 300 10

save 60 10000

stop-writes-on-bgsave-error yes

rdbcompression yes

rdbchecksum yes

dbfilename dump.rdb ###dbfile

dir "/usr/local/redis/6379"

masterauth "123456"

requirepass "123456"

slave-serve-stale-data yes

slave-read-only yes

repl-diskless-sync no

repl-diskless-sync-delay 5

repl-disable-tcp-nodelay no

slave-priority 100

appendonly yes

appendfilename "appendonly.aof"

appendfsync everysec

no-appendfsync-on-rewrite no

auto-aof-rewrite-percentage 100

auto-aof-rewrite-min-size 64mb

aof-load-truncated yes

lua-time-limit 5000

slowlog-log-slower-than 10000

slowlog-max-len 128

latency-monitor-threshold 0

notify-keyspace-events ""

hash-max-ziplist-entries 512

hash-max-ziplist-value 64

list-max-ziplist-entries 512

list-max-ziplist-value 64

set-max-intset-entries 512

zset-max-ziplist-entries 128

zset-max-ziplist-value 64

hll-sparse-max-bytes 3000

activerehashing yes

client-output-buffer-limit normal 0 0 0

client-output-buffer-limit slave 256mb 64mb 60

client-output-buffer-limit pubsub 32mb 8mb 60

hz 10

aof-rewrite-incremental-fsync yes

slaveof 192.168.137.40 6379

vim sentinel_1.conf

群集文件配置

port 26379

dir "/usr/local/redis/redis_cluster"

# 守护进程模式

daemonize yes

# 指明日志文件名

logfile "/usr/local/redis/redis_cluster/sentinel_26379.log"

sentinel monitor mymaster 192.168.137.40 6379 2

sentinel down-after-milliseconds mymaster 5000

sentinel failover-timeout mymaster 18000

sentinel auth-pass mymaster 123456

sentinel monitor mymaster 192.168.137.40 6379 2第一行配置表示 Sentinel(哨兵)进程去监视一个名为 mymaster 的主服务器,这个主服务器的 IP 地址为 192.168.137.40 , 端口号为 6379,而将这个主服务器判断为失效至少需要 2个 Sentinel(哨兵)进程的同意。

down-after-milliseconds 指明尝试多少毫秒无反应,哨兵认为其失联。

failover-timeout实现主从切换,完成故障转移的所需要的最大时间值。若Sentinel(哨兵)进程在该配置值内未能完成故障转移的操作(即故障时master/slave自动切换),则认为本次故障转移操作失败。

从配置

vim redis_6380.conf

daemonize yes

pidfile "/usr/local/redis/6380/redis_6380.pid"

port 6380

tcp-backlog 128

timeout 0

tcp-keepalive 0

loglevel notice

logfile ""

databases 16

save 900 1

save 300 10

save 60 10000

stop-writes-on-bgsave-error yes

rdbcompression yes

rdbchecksum yes

dbfilename "dump.rdb"

dir "/usr/local/redis/6380"

masterauth "123456"

requirepass "123456"

slave-serve-stale-data yes

slave-read-only yes

repl-diskless-sync no

repl-diskless-sync-delay 5

repl-disable-tcp-nodelay no

slave-priority 100

appendonly yes

appendfilename "appendonly.aof"

appendfsync everysec

no-appendfsync-on-rewrite no

auto-aof-rewrite-percentage 100

auto-aof-rewrite-min-size 64mb

aof-load-truncated yes

lua-time-limit 5000

slowlog-log-slower-than 10000

slowlog-max-len 128

latency-monitor-threshold 0

notify-keyspace-events ""

hash-max-ziplist-entries 512

hash-max-ziplist-value 64

list-max-ziplist-entries 512

list-max-ziplist-value 64

set-max-intset-entries 512

zset-max-ziplist-entries 128

zset-max-ziplist-value 64

hll-sparse-max-bytes 3000

activerehashing yes

client-output-buffer-limit normal 0 0 0

client-output-buffer-limit slave 256mb 64mb 60

client-output-buffer-limit pubsub 32mb 8mb 60

hz 10

aof-rewrite-incremental-fsync yes

vim sentinel_2.conf

#sentinel端口

port 26380

#工作路径,注意路径不要和主重复

dir "/usr/local/redis_cluster"

# 守护进程模式

daemonize yes

# 指明日志文件名

logfile "/usr/local/redis_cluster/sentinel_26380.log"

#哨兵监控的master,主从配置一样,sentinel monitor <master-name> <ip> <redis-port> <quorum>

sentinel monitor mymaster 192.168.137.40 6379 2

# master或slave多长时间(默认30秒)不能使用后标记为s_down状态。

sentinel down-after-milliseconds mymaster 5000

#若sentinel在该配置值内未能完成failover操作(即故障时master/slave自动切换),则认为本次failover失败。

sentinel failover-timeout mymaster 18000

#设置master和slaves验证密码

sentinel auth-pass mymaster 123456

注意: 1.应用程序连接到哨兵端口,通过指定不同的master名称连接到具体的主副本。 2.哨兵配置文件中只需要配置主从复制中的主副本ip和端口即可,当主从进行切换时哨兵会自动修改哨兵配置文件中的主副本ip为新在主副本ip。 3.一个哨兵配置文件中可以同时配置监控多个主从复制。 4.单个哨兵就可以用来进行主从故障监控,但是如果只有一个sentinel进程,如果这个进程运行出错,或者是网络堵塞,那么将无法实现redis集群的主备切换(单点问题);<quorum>这个2代表投票数,当2个sentinel认为一个master已经不可用了以后,将会触发failover,才能真正认为该master已经不可用了。(sentinel集群中各个sentinel也有互相通信,通过gossip协议);所以合理的配置应该是同时启动多个哨兵进程,并且最好是在不同的服务器中启动。 5.注意mymaster的需要在整个网络环境都是唯一的,哨兵之间会自动通过mastername去建立关联关系只要网络环境是相通的。

启动redis

主从、哨兵都要启动

# 启动Redis服务器进程

./redis-server ../redis.conf

# 启动哨兵进程

./redis-sentinel ../sentinel.conf

注意启动的顺序。首先是主机的Redis服务进程,然后启动从机的服务进程,最后启动哨兵的服务进程。

故障切换流程

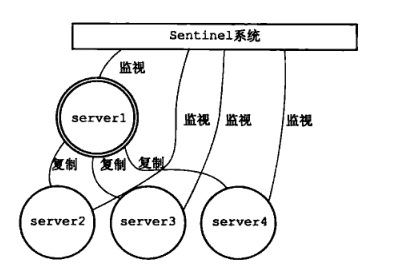

Sentinel(哨兵)是Redis 的高可用性解决方案:由一个或多个Sentinel 实例 组成的Sentinel 系统可以监视任意多个主服务器,以及这些主服务器属下的所有从服务器,并在被监视的主服务器进入下线状态时,自动将下线主服务器属下的某个从服务器升级为新的主服务器。

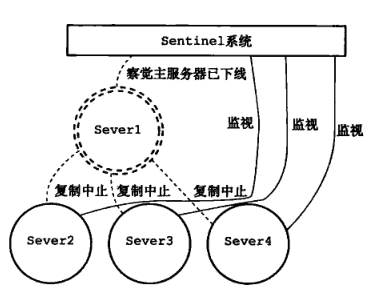

在Server1 掉线后:

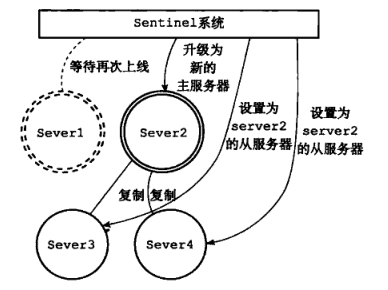

升级Server2 为新的主服务器:

集群模式

原理

redis cluster在设计的时候,就考虑到了去中心化,去中间件,也就是说,集群中的每个节点都是平等的关系,都是对等的,每个节点都保存各自的数据和整个集群的状态。每个节点都和其他所有节点连接,而且这些连接保持活跃,这样就保证了我们只需要连接集群中的任意一个节点,就可以获取到其他节点的数据。

Redis 集群没有并使用传统的一致性哈希来分配数据,而是采用另外一种叫做哈希槽 (hash slot)的方式来分配的。redis cluster 默认分配了 16384 个slot,当我们set一个key 时,会用CRC16算法来取模得到所属的slot,然后将这个key 分到哈希槽区间的节点上,具体算法就是:CRC16(key) % 16384。所以我们在测试的时候看到set 和 get 的时候,直接跳转到了7000端口的节点。

Redis 集群会把数据存在一个 master 节点,然后在这个 master 和其对应的salve 之间进行数据同步。当读取数据时,也根据一致性哈希算法到对应的 master 节点获取数据。只有当一个master 挂掉之后,才会启动一个对应的 salve 节点,充当 master 。

需要注意的是:必须要3个或以上的主节点,否则在创建集群时会失败,并且当存活的主节点数小于总节点数的一半时,整个集群就无法提供服务了。

关键配置

集群配置项

port 7000 //端口7000,7002,7003

bind 本机ip //默认ip为127.0.0.1 需要改为其他节点机器可访问的ip 否则创建集群时无法访问对应的端口,无法创建集群

daemonize yes //redis后台运行

pidfile /var/run/redis_7000.pid //pidfile文件对应7000,7001,7002

cluster-enabled yes //开启集群 把注释#去掉

cluster-config-file nodes_7000.conf //集群的配置 配置文件首次启动自动生成 7000,7001,7002

cluster-node-timeout 15000 //请求超时 默认15秒,可自行设置

appendonly yes //aof日志开启 有需要就开启,它会每次写操作都记录一条日志

创建集群

Redis 官方提供了 redis-trib.rb 这个工具,就在解压目录的 src 目录中,第三步中已将它复制到 /usr/local/bin 目录中,可以直接在命令行中使用了。使用下面这个命令即可完成安装。

redis-trib.rb create --replicas 1 192.168.31.245:7000 192.168.31.245:7001 192.168.31.245:7002 192.168.31.210:7003 192.168.31.210:7004 192.168.31.210:7005

6台集群

Redis持久化数据和缓存怎么做扩容

Redis中数据存储模式有2种:cache-only,persistence;

- cache-only即只做为“缓存”服务,不持久数据,数据在服务终止后将消失,此模式下也将不存在“数据恢复”的手段,是一种安全性低/效率高/容易扩展的方式;

- persistence即为内存中的数据持久备份到磁盘文件,在服务重启后可以恢复,此模式下数据相对安全。

对于persistence持久化存储,Redis提供了两种持久化方法:

- Redis DataBase(简称RDB)

- Append-only file (简称AOF)

Redis持久化是如何工作的? 什么是持久化?简单来讲就是将数据放到断电后数据不会丢失的设备中,也就是我们通常理解的硬盘上。 首先我们来看一下数据库在进行写操作时到底做了哪些事,主要有下面五个过程:

- 客户端向服务端发送写操作(数据在客户端的内存中)。

- 数据库服务端接收到写请求的数据(数据在服务端的内存中)。

- 服务端调用write这个系统调用,将数据往磁盘上写(数据在系统内存的缓冲区中)。

- 操作系统将缓冲区中的数据转移到磁盘控制器上(数据在磁盘缓存中)。

- 磁盘控制器将数据写到磁盘的物理介质中(数据真正落到磁盘上)。

故障分析 写操作大致有上面5个流程,下面我们结合上面的5个流程看一下各种级别的故障:

- 当Redis数据库系统故障时,这时候系统内核还是完好的。那么此时只要我们执行完了第3步,那么数据就是安全的,因为后续操作系统会来完成后面几步,保证数据最终会落到磁盘上。

- 当系统断电时,这时候上面5项中提到的所有缓存都会失效,并且数据库和操作系统都会停止工作。所以只有当数据在完成第5步后,才能保证在断电后数据不丢失。

通过上面5步的了解,可能我们会希望搞清下面一些问题:

- Redis数据库多长时间调用一次write,将数据写到内核缓冲区?

- 内核多长时间会将系统缓冲区中的数据写到磁盘控制器?

- 磁盘控制器又在什么时候把缓存中的数据写到物理介质上?

对于第一个问题,通常数据库层面会进行全面控制。

而对第二个问题,操作系统有其默认的策略,但是我们也可以通过POSIX API提供的fsync系列命令强制操作系统将数据从内核区写到磁盘控制器上。

对于第三个问题,好像数据库已经无法触及,但实际上,大多数情况下磁盘缓存是被设置关闭的,或者是只开启为读缓存,也就是说写操作不会进行缓存,直接写到磁盘。

数据损坏

所谓数据损坏,就是数据无法恢复,上面我们讲的都是如何保证数据是确实写到磁盘上去,但是写到磁盘上可能并不意味着数据不会损坏。比如我们可能一次写请求会进行两次不同的写操作,当意外发生时,可能会导致一次写操作安全完成,但是另一次还没有进行。如果数据库的数据文件结构组织不合理,可能就会导致数据完全不能恢复的状况出现。 这里通常也有三种策略来组织数据,以防止数据文件损坏到无法恢复的情况:

- 第一种是最粗糙的处理,就是不通过数据的组织形式保证数据的可恢复性。而是通过配置数据同步备份的方式,在数据文件损坏后通过数据备份来进行恢复。实际上MongoDB在不开启操作日志,通过配置Replica Sets时就是这种情况。

- 另一种是在上面基础上添加一个操作日志,每次操作时记一下操作的行为,这样我们可以通过操作日志来进行数据恢复。因为操作日志是顺序追加的方式写的,所以不会出现操作日志也无法恢复的情况。这也类似于MongoDB开启了操作日志的情况。

- 更保险的做法是数据库不进行旧数据的修改,只是以追加方式去完成写操作,这样数据本身就是一份日志,这样就永远不会出现数据无法恢复的情况了。实际上CouchDB就是此做法的优秀范例。

Redis提供了RDB持久化和AOF持久化

RDB持久化

RDB概述

RDB是在某个时间点将数据写入一个临时文件,持久化结束后,用这个临时文件替换上次持久化的文件,达到数据恢复。 优点:使用单独子进程来进行持久化,主进程不会进行任何IO操作,保证了redis的高性能 缺点:RDB是间隔一段时间进行持久化,如果持久化之间redis发生故障,会发生数据丢失。所以这种方式更适合数据要求不严谨的时候

这里说的这个执行数据写入到临时文件的时间点是可以通过配置来自己确定的,通过配置redis在n秒内如果超过m个key被修改这执行一次RDB操作。这个操作就类似于在这个时间点来保存一次Redis的所有数据,一次快照数据。所有这个持久化方法也通常叫做snapshots。

RDB默认开启,redis.conf中的具体配置参数如下;

#dbfilename:持久化数据存储在本地的文件

dbfilename dump.rdb

#dir:持久化数据存储在本地的路径,如果是在/redis/redis-3.0.6/src下启动的redis-cli,则数据会存储在当前src目录下

dir ./

##snapshot触发的时机,save <seconds> <changes>

##如下为900秒后,至少有一个变更操作,才会snapshot

##对于此值的设置,需要谨慎,评估系统的变更操作密集程度

##可以通过“save “””来关闭snapshot功能

#save时间,以下分别表示更改了1个key时间隔900s进行持久化存储;更改了10个key300s进行存储;更改10000个key60s进行存储。

save 900 1

save 300 10

save 60 10000

##当snapshot时出现错误无法继续时,是否阻塞客户端“变更操作”,“错误”可能因为磁盘已满/磁盘故障/OS级别异常等

stop-writes-on-bgsave-error yes

##是否启用rdb文件压缩,默认为“yes”,压缩往往意味着“额外的cpu消耗”,同时也意味这较小的文件尺寸以及较短的网络传输时间

rdbcompression yes

snapshot触发的时机,是有“间隔时间”和“变更次数”共同决定,同时符合2个条件才会触发snapshot,否则“变更次数”会被继续累加到下一个“间隔时间”上。snapshot过程中并不阻塞客户端请求。snapshot首先将数据写入临时文件,当成功结束后,将临时文件重名为dump.rdb。

使用RDB恢复数据: RDB文件的载入工作是在服务器启动时自动执行的,并没有专门的命令。但是由于AOF的优先级更高,因此当AOF开启时,Redis会优先载入AOF文件来恢复数据;只有当AOF关闭时,才会在Redis服务器启动时检测RDB文件,并自动载入。服务器载入RDB文件期间处于阻塞状态,直到载入完成为止。

Redis载入RDB文件时,会对RDB文件进行校验,如果文件损坏,则日志中会打印错误,Redis启动失败。

客户端使用命令进行手动持久化save存储:

./redis-cli -h ip -p port save

./redis-cli -h ip -p port bgsave

一个是在前台进行存储,一个是在后台进行存储。我的client就在server这台服务器上,所以不需要连其他机器,直接./redis-cli bgsave。由于redis是用一个主线程来处理所有 client的请求,这种方式会阻塞所有client请求。所以不推荐使用。另一点需要注意的是,每次快照持久化都是将内存数据完整写入到磁盘一次。如果数据量大的话,而且写操作比较多,必然会引起大量的磁盘io操作,可能会严重影响性能。

Redis Bgsave 命令用于在后台异步保存当前数据库的数据到磁盘。

BGSAVE 命令执行之后立即返回 OK ,然后 Redis fork 出一个新子进程,原来的 Redis 进程(父进程)继续处理客户端请求,而子进程则负责将数据保存到磁盘,然后退出。

其他自动触发机制: 除了save m n 以外和手动调用命令外,还有一些其他情况会触发bgsave:

在主从复制场景下,如果从节点执行全量复制操作,则主节点会执行bgsave命令,并将rdb文件发送给从节点

执行shutdown命令时,自动执行rdb持久化

详细原理参见:https://blog.youkuaiyun.com/canot/article/details/52886923

RDB常用配置总结

下面是RDB常用的配置项,以及默认值:

save m n:bgsave自动触发的条件;如果没有save m n配置,相当于自动的RDB持久化关闭,不过此时仍可以通过其他方式触发

stop-writes-on-bgsave-error yes:当bgsave出现错误时,Redis是否停止执行写命令;设置为yes,则当硬盘出现问题时,可以及时发现,避免数据的大量丢失;设置为no,则Redis无视bgsave的错误继续执行写命令,当对Redis服务器的系统(尤其是硬盘)使用了监控时,该选项考虑设置为no

rdbcompression yes:是否开启RDB文件压缩。Redis默认采用LZF算法对RDB文件进行压缩。虽然压缩耗时,但是可以大大减小RDB文件的体积,因此压缩默认开启;可以通过命令关闭

rdbchecksum yes:是否开启RDB文件的校验,在写入文件和读取文件时都起作用;关闭checksum在写入文件和启动文件时大约能带来10%的性能提升,但是数据损坏时无法发现

dbfilename dump.rdb:RDB文件名

dir ./:RDB文件和AOF文件所在目录

AOF持久化

Append-only file,将“操作 + 数据”以格式化指令的方式追加到操作日志文件的尾部,在append操作返回后(已经写入到文件或者即将写入),才进行实际的数据变更,“日志文件”保存了历史所有的操作过程;当server需要数据恢复时,可以直接replay此日志文件,即可还原所有的操作过程。AOF相对可靠,它和mysql中bin.log、apache.log、zookeeper中txn-log简直异曲同工。AOF文件内容是字符串,非常容易阅读和解析。

优点:

- 可以保持更高的数据完整性,如果设置追加file的时间是1s,如果redis发生故障,最多会丢失1s的数据;

- 且如果日志写入不完整支持redis-check-aof来进行日志修复;

- AOF文件没被rewrite之前(文件过大时会对命令进行合并重写),可以删除其中的某些命令(比如误操作的flushall)。

缺点:

AOF文件比RDB文件大,且恢复速度慢。

我们可以简单的认为AOF就是日志文件,此文件只会记录“变更操作”(例如:set/del等),如果server中持续的大量变更操作,将会导致AOF文件非常的庞大,意味着server失效后,数据恢复的过程将会很长;事实上,一条数据经过多次变更,将会产生多条AOF记录,其实只要保存当前的状态,历史的操作记录是可以抛弃的;因为AOF持久化模式还伴生了“AOF rewrite”。 AOF的特性决定了它相对比较安全,如果你期望数据更少的丢失,那么可以采用AOF模式。如果AOF文件正在被写入时突然server失效,有可能导致文件的最后一次记录是不完整,你可以通过手工或者程序的方式去检测并修正不完整的记录,以便通过aof文件恢复能够正常;同时需要提醒,如果你的redis持久化手段中有aof,那么在server故障失效后再次启动前,需要检测aof文件的完整性。

AOF默认关闭,开启方法,修改配置文件redis.conf: appendonly yes

##此选项为aof功能的开关,默认为“no”,可以通过“yes”来开启aof功能

##只有在“yes”下,aof重写/文件同步等特性才会生效

appendonly yes

##指定aof文件名称

appendfilename appendonly.aof

##指定aof操作中文件同步策略,有三个合法值:always,everysec,no,默认为everysec

appendfsync everysec

##在aof-rewrite期间,appendfsync是否暂缓文件同步,"no"表示“不暂缓”,“yes”表示“暂缓”,默认为“no”

no-appendfsync-on-rewrite no

##aof文件rewrite触发的最小文件尺寸(mb,gb),只有大于此aof文件大于此尺寸是才会触发rewrite,默认“64mb”,建议“512mb”

auto-aof-rewrite-min-size 64mb

##相对于“上一次”rewrite,本次rewrite触发时aof文件应该增长的百分比。

##每一次rewrite之后,redis都会记录下此时“新aof”文件的大小(例如A),那么当aof文件增长到A*(1 + p)之后

##触发下一次rewrite,每一次aof记录的添加,都会检测当前aof文件的尺寸。

auto-aof-rewrite-percentage 100

AOF是文件操作,对于变更操作比较密集的server,那么必将造成磁盘IO的负荷加重;此外linux对文件操作采取了“延迟写入”手段,即并非每次write操作都会触发实际磁盘操作,而是进入了buffer中,当buffer数据达到阀值时触发实际写入(也有其他时机),这是linux对文件系统的优化,但是这却有可能带来隐患,如果buffer没有刷新到磁盘,此时物理机器失效(比如断电),那么有可能导致最后一条或者多条aof记录的丢失。通过上述配置文件,可以得知redis提供了3中aof记录同步选项:

always:每一条aof记录都立即同步到文件,这是最安全的方式,也以为更多的磁盘操作和阻塞延迟,是IO开支较大。

everysec:每秒同步一次,性能和安全都比较中庸的方式,也是redis推荐的方式。如果遇到物理服务器故障,有可能导致最近一秒内aof记录丢失(可能为部分丢失)。

no:redis并不直接调用文件同步,而是交给操作系统来处理,操作系统可以根据buffer填充情况/通道空闲时间等择机触发同步;这是一种普通的文件操作方式。性能较好,在物理服务器故障时,数据丢失量会因OS配置有关。

其实,我们可以选择的太少,everysec是最佳的选择。如果你非常在意每个数据都极其可靠,建议你选择一款“关系性数据库”吧。 AOF文件会不断增大,它的大小直接影响“故障恢复”的时间,而且AOF文件中历史操作是可以丢弃的。AOF rewrite操作就是“压缩”AOF文件的过程,当然redis并没有采用“基于原aof文件”来重写的方式,而是采取了类似snapshot的方式:基于copy-on-write,全量遍历内存中数据,然后逐个序列到aof文件中。因此AOF rewrite能够正确反应当前内存数据的状态,这正是我们所需要的;rewrite过程中,对于新的变更操作将仍然被写入到原AOF文件中,同时这些新的变更操作也会被redis收集起来(buffer,copy-on-write方式下,最极端的可能是所有的key都在此期间被修改,将会耗费2倍内存),当内存数据被全部写入到新的aof文件之后,收集的新的变更操作也将会一并追加到新的aof文件中,此后将会重命名新的aof文件为appendonly.aof,此后所有的操作都将被写入新的aof文件。如果在rewrite过程中,出现故障,将不会影响原AOF文件的正常工作,只有当rewrite完成之后才会切换文件,因为rewrite过程是比较可靠的。

触发rewrite的时机可以通过配置文件来声明,同时redis中可以通过bgrewriteaof指令人工干预。

redis-cli -h ip -p port bgrewriteaof

因为rewrite操作/aof记录同步/snapshot都消耗磁盘IO,redis采取了“schedule”策略:无论是“人工干预”还是系统触发,snapshot和rewrite需要逐个被执行。 AOF rewrite过程并不阻塞客户端请求。系统会开启一个子进程来完成。

总结

AOF和RDB各有优缺点,这是有它们各自的特点所决定:

1)AOF更加安全,可以将数据更加及时的同步到文件中,但是AOF需要较多的磁盘IO开支,AOF文件尺寸较大,文件内容恢复数度相对较慢。 2)snapshot,安全性较差,它是“正常时期”数据备份以及master-slave数据同步的最佳手段,文件尺寸较小,恢复数度较快。

可以通过配置文件来指定它们中的一种,或者同时使用它们(不建议同时使用),或者全部禁用。

1)在架构良好的环境中,master通常使用AOF,slave使用snapshot,主要原因是master需要首先确保数据完整性,它作为数据备份的第一选择;slave提供只读服务(目前slave只能提供读取服务),它的主要目的就是快速响应客户端read请求;

2)如果你的redis运行在网络稳定性差/物理环境糟糕情况下,建议你master和slave均采取AOF,这个在master和slave角色切换时,可以减少“人工数据备份”/“人工引导数据恢复”的时间成本;

3)你的环境一切非常良好,且服务需要接收密集性的write操作,那么建议master采取snapshot,而slave采用AOF。

Redis常见性能问题和解决方案

1)Master最好不要做任何持久化工作,如RDB内存快照和AOF日志文件。

2)如果数据比较重要,某个Slave开启AOF备份数据,策略设置为每秒同步一次。

3)为了主从复制的速度和连接的稳定性,Master和Slave最好在同一个局域网内。

4)尽量避免在压力很大的主库上增加从库。

Redis使用案例

背景

视频直播间作为直播系统对外的表现形式,在整个系统中处于核心地位。通常除了视频直播窗口外,直播间还包含在线用户,礼物,评论,点赞,排行榜等信息。直播间消息,时效性高,互动性强,对系统时延有着非常高的要求,非常适合使用Redis等缓存服务来处理。

直播信息

实时排行信息

实时排行信息包含直播间在线用户列表,各种礼物排行榜,弹幕消息(可以理解为按消息维度的消息排行榜)等信息,适合使用Redis中的SortedSet结构进行存储。

例如,以unix timestamp+毫秒数为分值,记录user55的直播间增加的5条弹幕

redis> ZADD user55:_danmu 1523959031601166 message111111111111

(integer) 1

11.160.24.14:3003> ZADD user55:_danmu 1523959031601266 message222222222222

(integer) 1

11.160.24.14:3003> ZADD user55:_danmu 1523959088894232 message33333

(integer) 1

11.160.24.14:3003> ZADD user55:_danmu 1523959090390160 message444444

(integer) 1

11.160.24.14:3003> ZADD user55:_danmu 1523959092951218 message5555

(integer) 1

返回最新的3条弹幕信息:

redis> ZREVRANGEBYSCORE user55:_danmu +inf -inf LIMIT 0 3

1) "message5555"

2) "message444444"

3) "message33333"

返回指定时间段内的3条弹幕信息:

redis> ZREVRANGEBYSCORE user55:_danmu 1523959088894232 -inf LIMIT 0 3

1) "message33333"

2) "message222222222222"

3) "message111111111111"

计数类信息

计数类信息以用户维度为例,有未读消息数,关注数,粉丝数,经验值等等。这类消息适合以Redis中的Hash结构进行存储。

redis> HSET user:55 follower 5

(integer) 1

redis> HINCRBY user:55 follower 1 //关注数+1

(integer) 6

redis> HGETALL user:55

1) "follow"

2) "6"

时间线信息

时间线信息是以时间为维度的信息列表,典型的比如主播动态,新帖。这类信息排序方式是固定的时间顺序,可以考虑使用List或者SortedSet来存储。

redis> LPUSH user:55_recent_activitiy '{datetime:201804112010,type:publish,title:开播啦,content:加油}'

(integer) 1

redis> LPUSH user:55_recent_activitiy '{datetime:201804131910,type:publish,title:请假,content:抱歉,今天有事鸽一天}'

(integer) 2

redis> LRANGE user:55_recent_activitiy 0 10

1) "{datetime:201804131910,type:publish,title:\xe8\xaf\xb7\xe5\x81\x87\",content:\xe6\x8a\xb1\xe6\xad\x89\xef\xbc\x8c\xe4\xbb\x8a\xe5\xa4\xa9\xe6\x9c\x89\xe4\xba\x8b\xe9\xb8\xbd\xe4\xb8\x80\xe5\xa4\xa9}"

2) "{datetime:201804112010,type:publish,title:\xe5\xbc\x80\xe6\x92\xad\xe5\x95\xa6,content:\xe5\x8a\xa0\xe6\xb2\xb9}"

相关链接

Redis内存回收:LRU算法

https://www.cnblogs.com/WJ5888/p/4371647.html

面试中关于Redis的问题看这篇就够了

https://blog.youkuaiyun.com/qq_34337272/article/details/80012284

Redis命令集合

Redis中文网

http://www.redis.net.cn/tutorial/3524.html

jedis api

http://tool.oschina.net/uploads/apidocs/

一文轻松搞懂redis集群原理及搭建与使用

https://juejin.im/post/5ad54d76f265da23970759d3

Redis集群搭建以及简单使用

Redis与Memcached对比及Redis高级特性

Redis与Memcached对比及Redis高级特性

1489

1489

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?