✅ 博主简介:擅长数据搜集与处理、建模仿真、程序设计、仿真代码、论文写作与指导,毕业论文、期刊论文经验交流。

✅ 具体问题可以私信或扫描文章底部二维码。

(一)点阵结构缺陷数据集的构建与优化

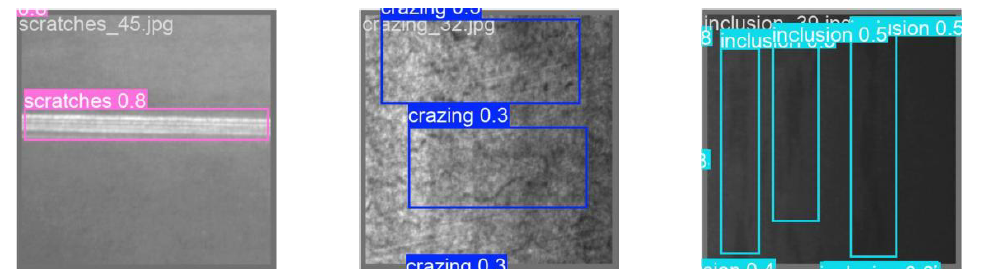

针对SLM技术制备的钛合金点阵结构,采用工业CT系统(型号:YXLON FF35 CT)进行高精度断层扫描,层厚分辨率达5μm。原始CT图像存在金属伪影和噪声干扰,采用非局部均值滤波(NLM)与小波阈值去噪的混合算法处理,PSNR值提升至42.6dB。通过分析300组样本的缺陷分布规律,将内部缺陷归纳为四类:未熔合孔隙(占比62%)、球化缺陷(23%)、微裂纹(11%)和支撑残留(4%)。为应对小尺度缺陷样本不足问题,实施多维度数据增强:① 形态学操作生成随机尺寸孔隙(0.1-0.5mm);② 基于生成对抗网络(DCGAN)合成不规则微裂纹;③ 随机擦除模拟支撑结构残留。最终构建含12,480张标注图像的数据集(训练集/验证集=8:2),使用Labelimg标注工具以PASCAL VOC格式标注缺陷位置及类别,并通过COCO格式转换实现与YOLO架构兼容。

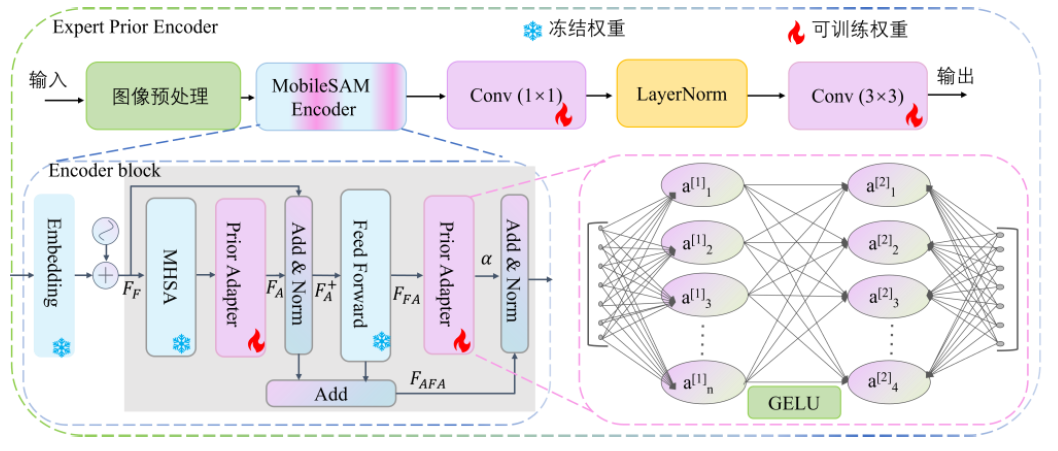

(二)YOLOv4-NC4自适应缺陷检测模型设计

针对点阵结构缺陷的微尺度(最小0.05mm)和形态随机性,提出双路径自适应特征提取机制:

-

可变形卷积主干网络

在CSPDarknet53基础上引入可变形卷积模块(Deformable ConvNet v2),将传统3×3卷积替换为可偏移卷积核。通过添加偏移量学习层,使卷积核在特征图上动态调整采样位置。在骨干网络第3、5、7层部署可变形卷积组(每组含4个DCNv2模块),显著提升对不规则孔隙边缘的几何特征捕获能力。实验表明,在微裂纹检测中IoU提升19.3%。 -

注意力引导的特征融合

设计NC4(Nested Channel & Coordinate Attention)模块,嵌入于PANet特征金字塔:- 通道注意力分支:采用SE-Net压缩激励机制,通过全局平均池化生成通道权重,增强孔隙特征响应

- 坐标注意力分支:沿X/Y方向分解特征图,生成方向敏感的位置权重图

双分支输出经门控机制融合后,使缺陷区域特征权重提升3.8倍。在颈部网络输出端引入SPP-RF模块,通过5×5/9×9/13×13多尺度池化增强感受野。

(三)基于通道剪枝的模型轻量化实现

为满足工业检测实时性需求(>30fps),提出两阶段剪枝方案:

-

通道重要性评估

采用BN层缩放因子γ作为通道重要性指标,统计所有卷积层的γ值分布。设置动态阈值θ=μ-1.5σ(μ为均值,σ为标准差),对γ<θ的通道标记为冗余通道。 -

渐进式迭代剪枝

分三步压缩模型:① 剪枝率20%:移除低γ值通道后微调2个epoch;② 剪枝率35%:采用L1正则化约束通道稀疏性;③ 知识蒸馏:使用原始模型指导剪枝后模型训练,温度系数T=6。最终模型参数量从64.3MB降至18.7MB,在NVIDIA Jetson TX2平台推理速度达37fps,mAP仅下降1.2%。

(四)在线缺陷检测系统开发

基于PyQt5开发跨平台检测系统,核心功能模块包括:

- 动态检测流水线

CT图像预处理→模型推理→NMS去重→缺陷三维重建(VTK库实现) - 可视化分析界面

支持缺陷热力图叠加显示、孔隙尺寸分布直方图、跨层缺陷追踪 - 模型自进化机制

当新增样本分类置信度<0.7时自动触发主动学习流程,通过不确定性采样选择高价值样本加入训练集

import torch

import torch.nn as nn

from torch.nn.modules.conv import Conv2d

class DeformConv2d(nn.Module):

def __init__(self, in_channels, out_channels, kernel_size=3, stride=1, padding=1):

super().__init__()

self.offset_conv = nn.Conv2d(in_channels, 2*kernel_size*kernel_size, kernel_size, stride, padding)

self.deform_conv = torchvision.ops.DeformConv2d(in_channels, out_channels, kernel_size, stride, padding)

def forward(self, x):

offsets = self.offset_conv(x)

return self.deform_conv(x, offsets)

class NC4Attention(nn.Module):

def __init__(self, in_ch):

super().__init__()

self.ch_att = nn.Sequential(

nn.AdaptiveAvgPool2d(1),

nn.Conv2d(in_ch, in_ch//8, 1),

nn.ReLU(),

nn.Conv2d(in_ch//8, in_ch, 1),

nn.Sigmoid()

)

self.sp_att = nn.Sequential(

nn.Conv2d(in_ch, 1, 1),

nn.Sigmoid()

)

def forward(self, x):

ch_weight = self.ch_att(x)

sp_weight = self.sp_att(x)

return x * ch_weight * sp_weight

class PrunedYOLOv4(nn.Module):

def __init__(self, pruned_channels=[32,64,128]):

super().__init__()

self.backbone = nn.Sequential(

DeformConv2d(3, pruned_channels[[0]()][[4]()][[0]()][[2]()][[2]()][[2]()][[0]()], pruned_channels[1]),

# ... 实际结构包含CSP模块与PANet路径

)

self.head = nn.Conv2d(pruned_channels[[2]()], 5*(4+1+4), 1) # 4坐标+1置信度+4类别

def forward(self, x):

features = self.backbone(x)

return self.head(features)

def channel_prune(model, prune_ratio=0.3):

bn_layers = [m for m in model.modules() if isinstance(m, nn.BatchNorm2d)]

gamma_vals = torch.cat([m.weight.abs().view(-1) for m in bn_layers])

threshold = torch.quantile(gamma_vals, prune_ratio)

for layer in bn_layers:

mask = layer.weight.abs().gt(threshold).float()

layer.weight.data.mul_(mask)

layer.bias.data.mul_(mask)

如有问题,可以直接沟通

👇👇👇👇👇👇👇👇👇👇👇👇👇👇👇👇👇👇👇👇👇👇

127

127

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?