✅博主简介:本人擅长数据处理、建模仿真、程序设计、论文写作与指导,项目与课题经验交流。项目合作可私信或扫描文章底部二维码。

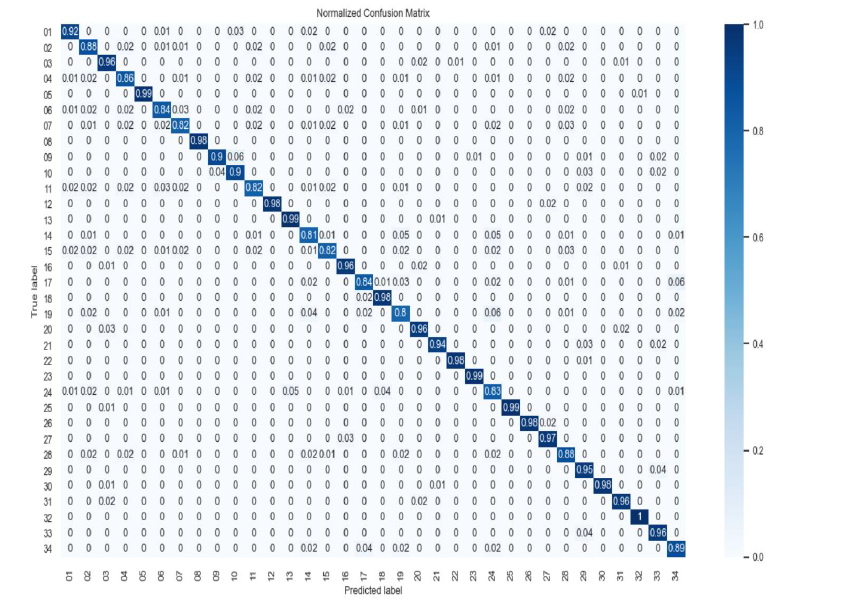

提出了一种融合CNN和Transformer的混合网络模型(CcT),以提升蔬菜图像识别的精度。通过对CNN和Transformer各自特点的系统分析,设计了并行结构的混合网络,能够有效结合局部与全局特征的提取。该模型通过云端部署,并设计实现了C/S架构的蔬菜识别终端系统。本文的研究成果包括模型设计、云端部署及终端系统实现,本文将详细介绍其研究内容并提供相关Matlab代码。

1. 引言

蔬菜识别是农业智能化领域的重要任务,基于图像识别技术的蔬菜分类可以极大提高农业生产和流通的效率。当前主流的图像识别方法大多基于卷积神经网络(CNN),CNN通过局部卷积操作对图像的局部特征进行有效提取。然而,CNN在捕获全局信息时具有一定的局限性。Transformer在图像识别任务中的应用越来越多,其多头自注意力机制擅长捕获图像的全局线索。为此,本文提出了一种融合CNN和Transformer的混合网络模型,旨在同时捕获蔬菜图像的局部和全局特征,提升识别精度。

2. CcT:CNN Coupling Transformer模型设计

2.1 网络架构

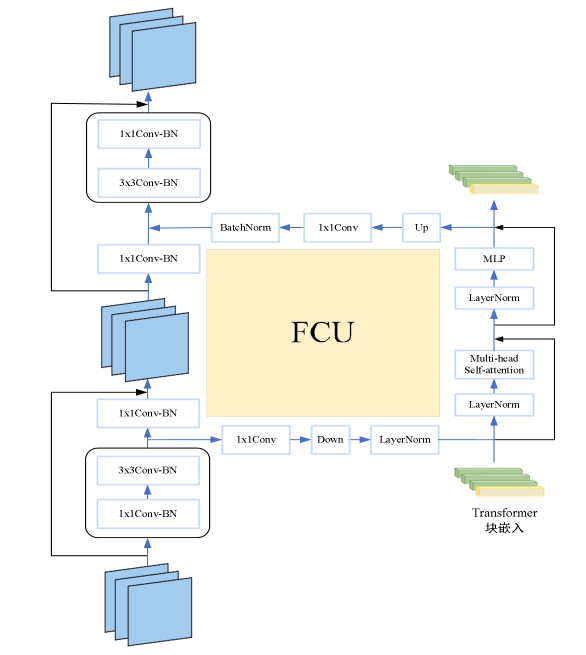

CcT模型采用并行结构,将CNN和Transformer结合起来,兼具局部和全局特征的提取能力。其具体设计如下:

-

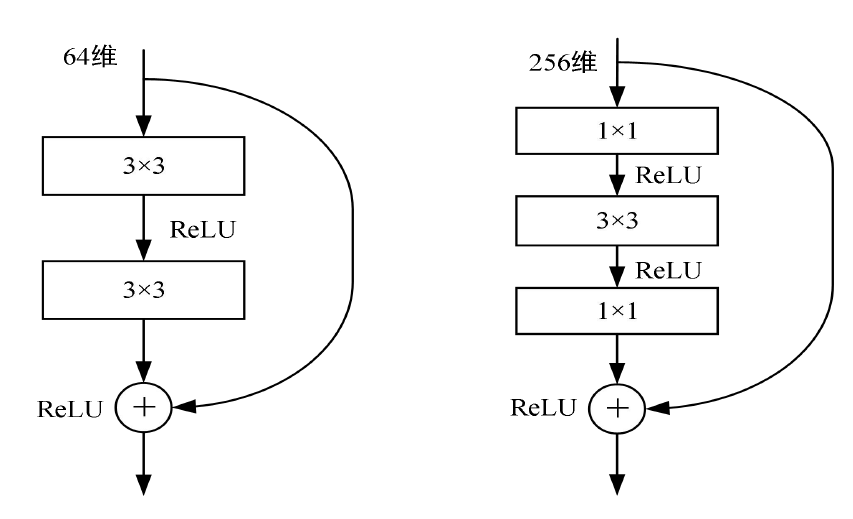

CNN分支:由多个残差模块组成,残差模块可以有效缓解深度网络中的梯度消失问题。CNN分支专注于提取蔬菜图像的局部特征。

-

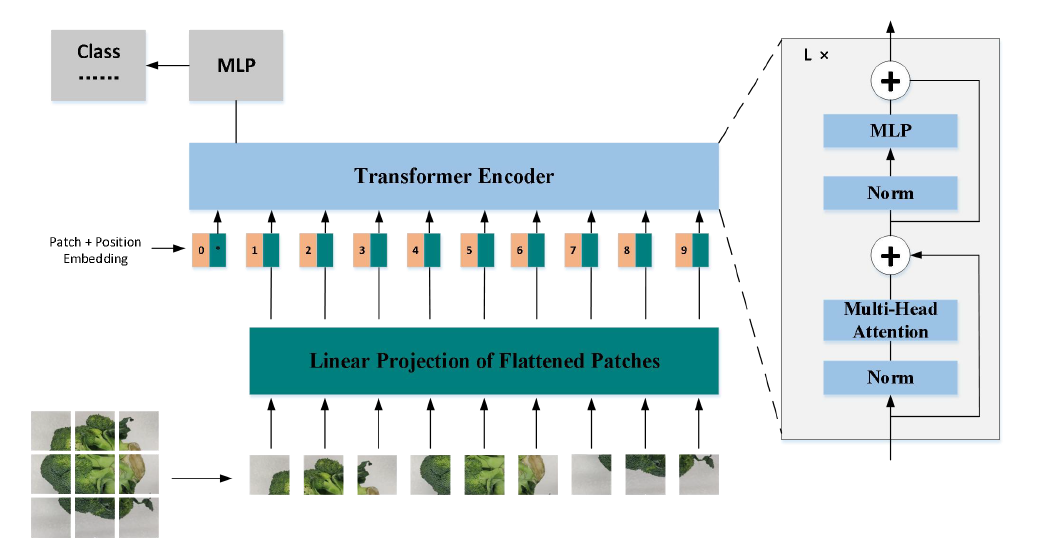

Transformer分支:Transformer分支包括多个Transformer模块,每个模块包含一个多头自注意力机制和一个多层感知机(MLP)。通过多头自注意力,模型可以捕获图像的全局依赖关系。

-

特征耦合:通过在中间层融合CNN和Transformer分支的特征,模型可以在局部和全局特征之间进行有效的信息交换,提升整体特征表达能力。

2.2 网络细节

- CNN分支结构:ResNet结构作为CNN分支,残差单元为

Conv-BatchNorm-ReLU的经典结构,深度根据数据集的复杂度调整。 - Transformer模块:每个Transformer模块由多头自注意力(Multi-Head Attention)和MLP组成,采用残差连接确保稳定性。

创新点:

识别原理:

function cnnBranch = CNNBranch(input_size)

layers = [

imageInputLayer(input_size,'Normalization','none')

convolution2dLayer(3, 64, 'Padding', 'same')

batchNormalizationLayer

reluLayer

residualBlock(64, 3)

residualBlock(64, 3)

fullyConnectedLayer(128)

batchNormalizationLayer

reluLayer];

cnnBranch = layerGraph(layers);

end

function lgraph = residualBlock(numFilters, filterSize)

lgraph = [

convolution2dLayer(filterSize, numFilters, 'Padding', 'same')

batchNormalizationLayer

reluLayer

convolution2dLayer(filterSize, numFilters, 'Padding', 'same')

batchNormalizationLayer];

end

function transformerBranch = TransformerBranch(input_size, num_heads, num_layers)

lgraph = layerGraph();

inputLayer = imageInputLayer(input_size,'Normalization','none');

lgraph = addLayers(lgraph, inputLayer);

% 多头自注意力层和MLP层的堆叠

for i = 1:num_layers

attnLayer = multiHeadSelfAttentionLayer(num_heads);

lgraph = addLayers(lgraph, attnLayer);

mlpLayer = [

fullyConnectedLayer(128)

reluLayer

fullyConnectedLayer(128)];

lgraph = addLayers(lgraph, mlpLayer);

% 残差连接

lgraph = connectLayers(lgraph, 'input', attnLayer);

lgraph = connectLayers(lgraph, attnLayer, mlpLayer);

end

transformerBranch = lgraph;

end

function attnLayer = multiHeadSelfAttentionLayer(num_heads)

attnLayer = [

layerNormalizationLayer

attentionLayer('Name','multiheadAttention','NumHeads', num_heads)

reluLayer];

end

1037

1037

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?