第一步:搭建基础环境(安装Ollama)

Ollama 是一个轻量级AI模型运行框架,支持多个开源模型,我们将用它来运行DeepSeek。

1. 下载 Ollama

-

访问 Ollama 官网

-

根据你的操作系统选择安装包(Windows 选择

.exe,Mac 选择.dmg)

-

下载完成后,按照提示进行安装:

-

Windows:双击安装包,一路“Next”即可

-

Mac:拖拽 Ollama 图标到

Applications文件夹

-

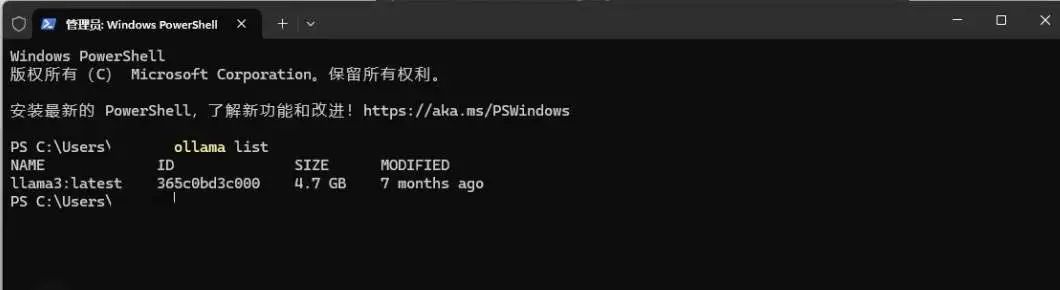

2. 验证安装 安装完成后,打开终端(Windows 按 Win + R 输入 cmd,Mac 直接打开 Terminal),输入:

ollama list如果终端显示 llama3 之类的模型名称,说明安装成功!

注意事项

-

确保系统已更新,避免兼容性问题

-

关闭杀毒软件,以防拦截安装

-

保持网络畅通,下载过程中可能需要 300MB 以上的数据

第二步:部署DeepSeek模型

DeepSeek 提供多个参数版本,我们建议:

-

普通用户:选择

8B版本,适合日常对话、写作等 -

高性能显卡用户(显存 16GB 以上):可选

16B版本,体验更强大性能

1. 获取并安装模型

-

打开 Ollama 模型库,搜索

deepseek-r1 -

复制对应版本的安装命令,并在终端运行:

ollama run deepseek-r1:8b(如果你选择 16B 版本,把 8b 替换为 16b)

首次运行时,系统会自动下载 5GB 左右的模型文件,耐心等待一下。

2. 测试模型是否正常运行 安装完成后,在终端输入:

说一句有趣的新年祝福如果模型成功回应,说明部署无误!

第三步:安装可视化界面(Chatbox AI)

终端交互虽然好用,但如果你更喜欢类似 ChatGPT 那样的可视化界面,可以安装 Chatbox AI。

1. 下载 Chatbox

-

访问 Chatbox 官网 下载对应系统的安装包

-

按照默认设置完成安装

2. 连接本地模型

-

打开 Chatbox,进入

⚙️ 设置 -

在

模型设置里选择:-

API 类型:Ollama API

-

模型名称:deepseek-r1:8b

-

-

点击

检查连接,如果状态正常,就可以开始愉快地使用啦!

3. 进阶设置(可选)

-

温度值:建议

0.3-0.7,数值越低,AI 回答越保守 -

最大生成长度:建议

2048 tokens,这样回答更丰富 -

连续对话模式:开启后,能让对话更加连贯

第四步:优化交互和性能

为了让AI跑得更顺畅,这里有几个小技巧:

-

关闭其他大型程序,避免占用过多内存

-

复杂问题分步提问,能提高模型的理解力

-

使用英文关键词,有时能提升响应速度

-

定期重启 Ollama,释放内存,让AI保持最佳状态

常见问题及解决方案

Q1:运行时提示显存不足? A:尝试使用 8B 版本,或升级显卡驱动。

Q2:AI 回答乱码? A:在 Chatbox 设置中切换编码为 UTF-8。

Q3:如何更新模型? A:在终端执行:

ollama pull deepseek-r1:8b

3543

3543

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?