1、构建环境

参考mmsegmentation使用说明:

创建虚拟环境

conda create -n mmsegmentation python=3.8

进入虚拟环境

conda activate mmsegmentation

安装torch/torchvision

conda install pytorch torchvision -c pytorch

安装mim

pip install -U openmim

安装mmcv-full ## 注意本地环境的cuda与mmcv-full的版本对应

mim install mmcv-full

linux安装有git+网络畅通,可以直接下载mmsegmentation

git clone -b [version] https://github.com/open-mmlab/mmsegmentation.git

or 没网的情况 则下载对应的.zip包进行解压

进入mmsegmentation

cd mmsegmentation

pip install -v -e. or python setup.py develop

如果缺陷包,可以安装requirement.txt里面的对应包

pip install -r requirement.txt

按照上述步骤可搭建完成mmsegmentation的conda基础环境

2、制作数据集

- 搭建labelme环境并标注数据

pip install labelme

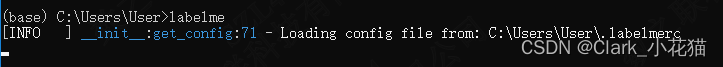

然后直接运行labelme

labelme

可以看到如下消息以及对应窗口

按照标记点的方式,标记出对应的object,并给与不同的label(盗个别人的美女图)

- 使用labelme源码中的labelme2voc.py进行数据转换

(1)新建labels.txt,并在其中添加你的类别,如下,我只有一个类别line ,默认需要添加__ignore__以及_background_两个默认类别

(2)准备如下源码

from __future__ import print_function

import argparse

import glob

import os

import os.path as osp

import sys

import imgviz

import numpy as np

import labelme

def main():

parser = argparse.ArgumentParser(

formatter_class=argparse.ArgumentDefaultsHelpFormatter

)

parser.add_argument("input_dir", help="input annotated directory")

parser.add_argument("output_dir", help="output dataset directory")

parser.add_argument("--labels", help="labels file", required=True)

parser.add_argument(

"--noviz", help="no visualizati

本文指导如何在Python环境中搭建mmsegmentation框架,包括创建虚拟环境、数据集标注、模型训练及测试,重点介绍了使用LabelMe工具、数据转换和配置调整。

本文指导如何在Python环境中搭建mmsegmentation框架,包括创建虚拟环境、数据集标注、模型训练及测试,重点介绍了使用LabelMe工具、数据转换和配置调整。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2376

2376