大家好,我是菜哥!

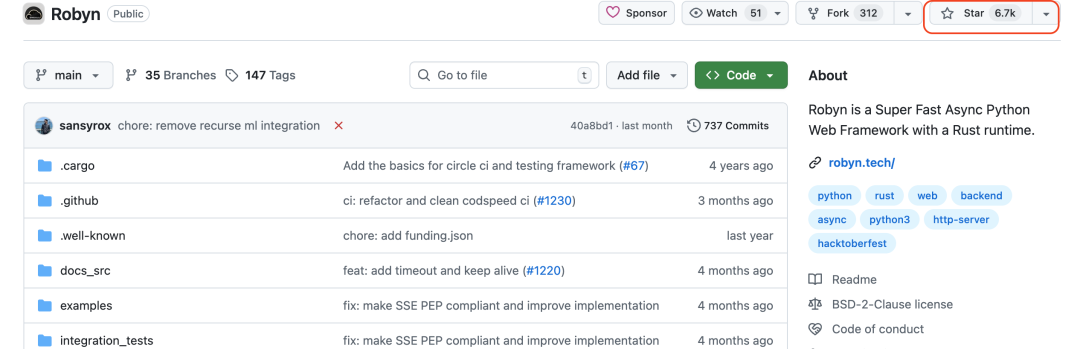

最近在GitHub上刷到一个有意思的项目——Robyn,一个用Rust写底层运行时的Python Web框架。看到官方介绍说性能比FastAPI快3倍,我这个做了20年Python开发的老程序员坐不住了,必须亲自测一测。

01.为什么会有Robyn?

说实话,Python在Web开发领域一直有个老毛病:慢。Django虽然功能全面,但性能一般;Flask轻量级但同步模型撑不住高并发;FastAPI已经算是性能派了,可面对Go、Rust这些原生高性能语言还是有差距。

Robyn的思路很聪明:既然Python慢,那就把最吃性能的HTTP服务器部分用Rust重写,开发者还是写熟悉的Python代码。这就好比给自行车装了个电动马达,骑起来省力多了。

02.实际上手体验

我在本地搭了个测试环境,写了三个最简单的Hello World服务,分别用Flask、FastAPI和Robyn实现。代码几乎一模一样,就是返回一个JSON响应。

安装Robyn很简单:

pip install robyn写法上跟Flask特别像,基本上看一眼就会:

from robyn import Robyn

app = Robyn(__file__)

@app.get("/")async def hello(): return {"message": "Hello World"}

app.start(port=8000)注意这里不需要uvicorn或者gunicorn,直接运行就行。这点对部署来说确实方便,少装一个依赖少一份风险。

性能测试数据

我用wrk压测工具跑了10万次请求,结果确实让人眼前一亮:

Flask(使用gunicorn 4 workers)

每秒请求数:约2800次

平均延迟:35ms

FastAPI(使用uvicorn)

每秒请求数:约5200次

平均延迟:19ms

Robyn

每秒请求数:约14500次

平均延迟:6.8ms

这个结果确实吓我一跳。Robyn比FastAPI快了将近3倍,比Flask快了5倍多。当然这是最简单的场景,实际项目中还要考虑数据库查询、业务逻辑等因素,但底层服务器的性能优势是实打实的。

03.一些实际问题

测完性能我也发现了些问题。首先是生态,Robyn现在的第三方库支持还比较有限。FastAPI有丰富的插件系统,各种数据库ORM、认证库都很成熟;Robyn很多东西得自己造轮子,或者想办法兼容现有库。

文档方面也还在完善中,碰到一些边缘场景得翻GitHub的issues找答案,不像Flask那样随便搜就能找到一堆解决方案。

如果你是个人项目或者小团队,尝鲜完全没问题;但如果是大公司的核心业务,用一个还在快速迭代的框架,运维和后期维护的成本需要考虑清楚。

如果果你觉得这篇文章有帮助,别忘了点赞、关注、收藏哟,你的支持是我原创的动力~

对了,如果你也对AI编程或者智能体感兴趣,我这边整理了一份开源的AI编程和智能体学习手册,爆肝10万字,价值699元。

关注下方👇🏻公众号,回复【智能体】获取学习手册

我是谁:

我是 菜哥,公众号菜鸟学Python主理人,全网 35 万粉丝的博主,2017年开始做公众号,从0做起做到31万粉丝,累计写了700多篇Python原创,副业变现百万。目前是Python领域的头部大号,AI时代来临,目前聚焦AI编程,coze,dify,n8n智能体开发,AI应用开发。

另外我们建了一个永久免费的AI编程相关资讯分享的星球,目前有2700人,如果你对这个赛道有星球,欢迎加入一起学习!

685

685

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?