在碎片化阅读充斥眼球的时代,越来越少的人会去关注每篇论文背后的探索和思考。

在这个栏目里,你会快速 get 每篇精选论文的亮点和痛点,时刻紧跟 AI 前沿成果。

点击本文底部的「阅读原文」即刻加入社区,查看更多最新论文推荐。

这是 PaperDaily 的第 126 篇文章

@paperweekly 推荐

#Knowledge Graph

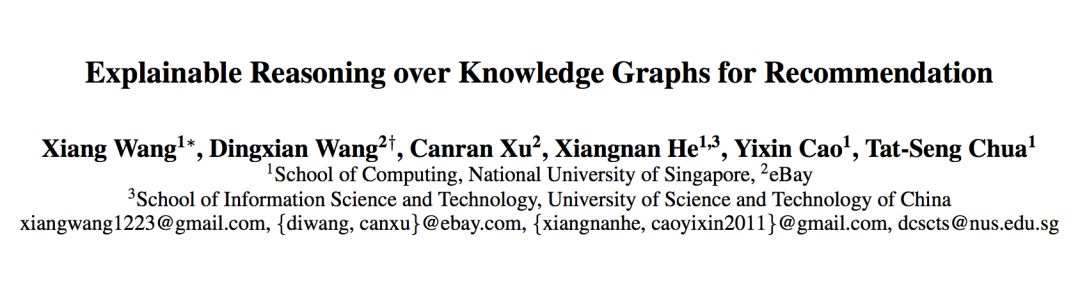

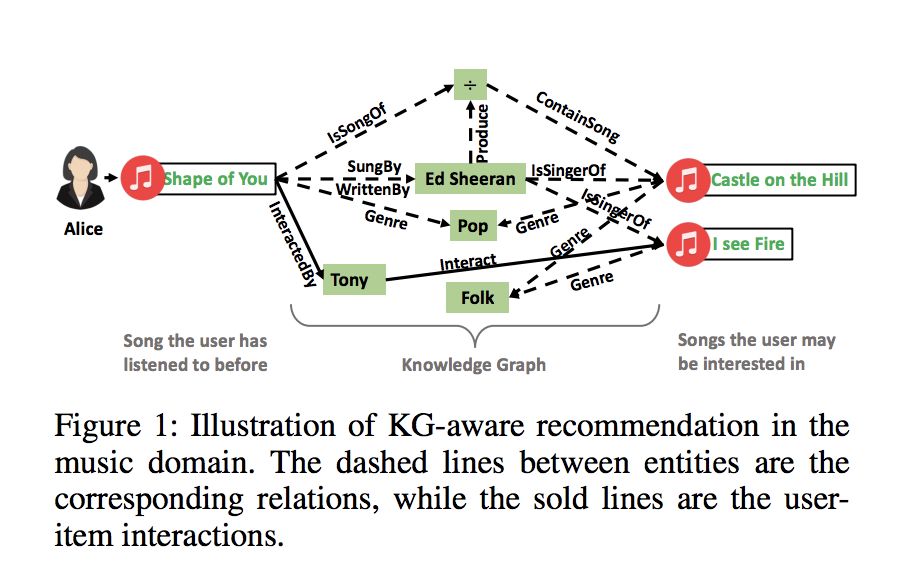

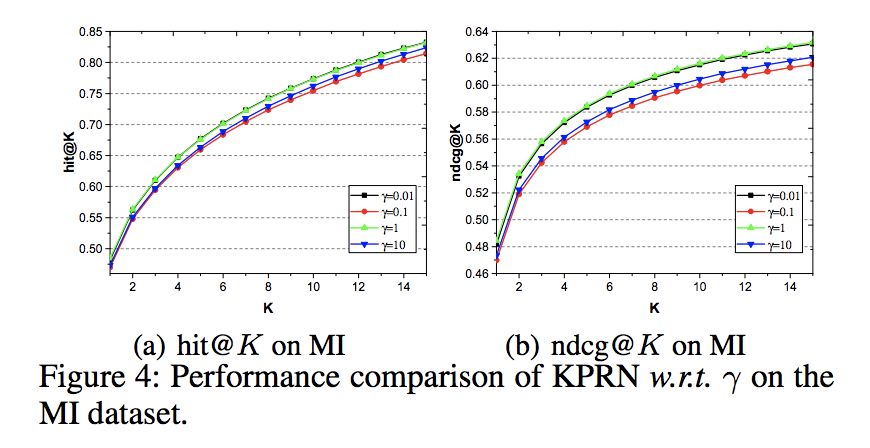

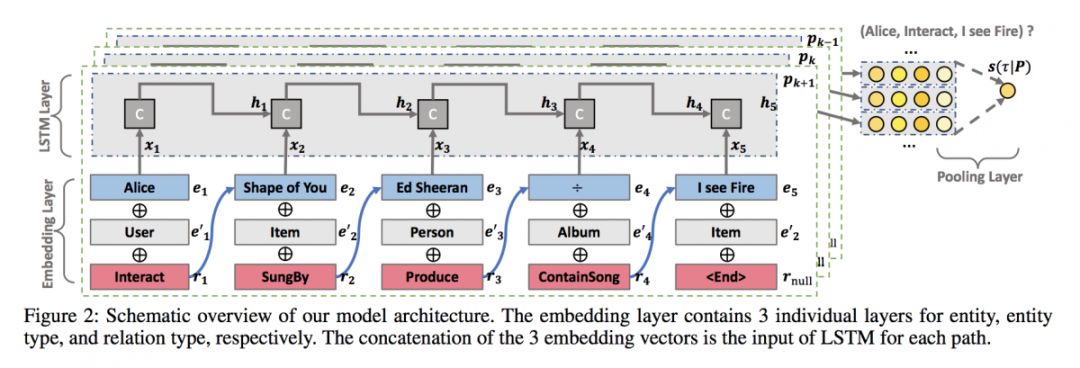

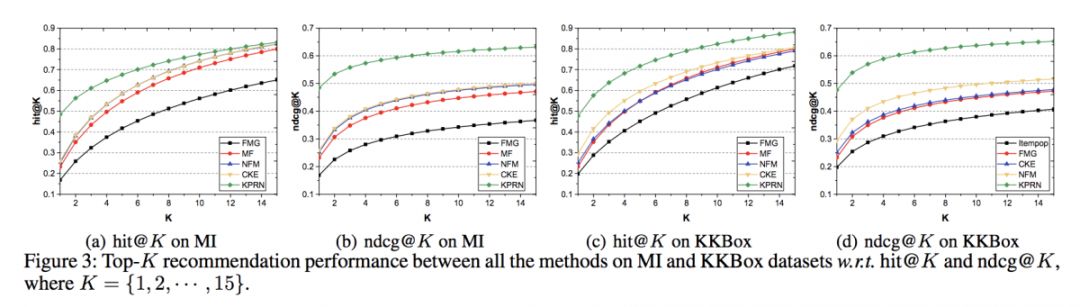

本文是新加坡国立大学和 eBay 发表于 AAAI 2019 的工作,论文提出了一种基于循环神经网络的推荐模型,对用户和物品之间的交互特征在知识图谱中存在的关联路径进行建模,为用户提供可解释性推荐。

该模型基于 LSTM 学习关联路径的表示,充分考虑了实体、关系间产生的序列依赖性,具备较强的推理能力。实验表明,本文模型在电影数据集 MI 和音乐数据集 KKBox 上取得了当前最优结果。

▲ 论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2644

@zkt18 推荐

#Sequence to Sequence Learning

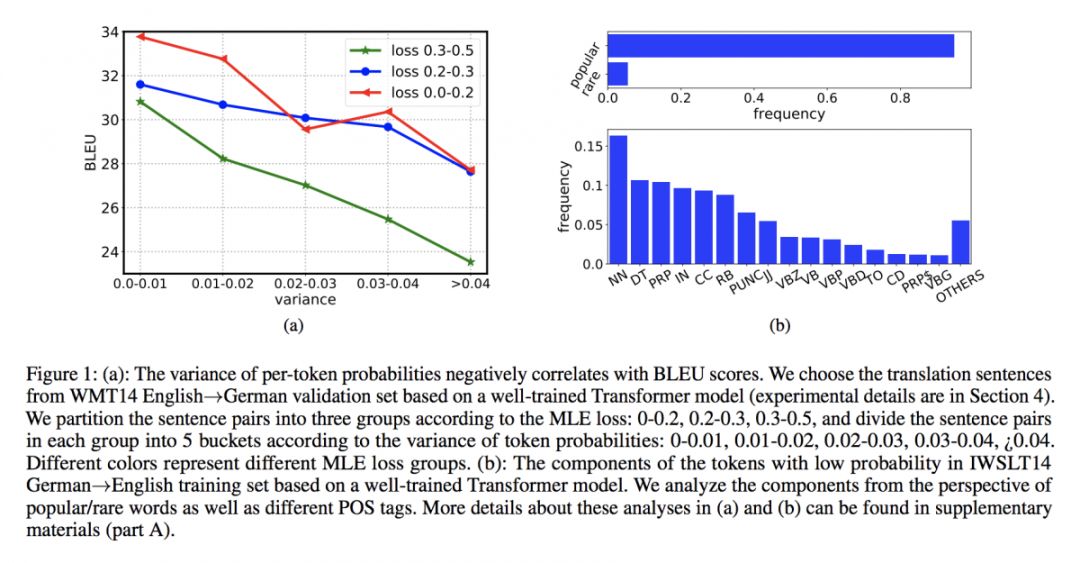

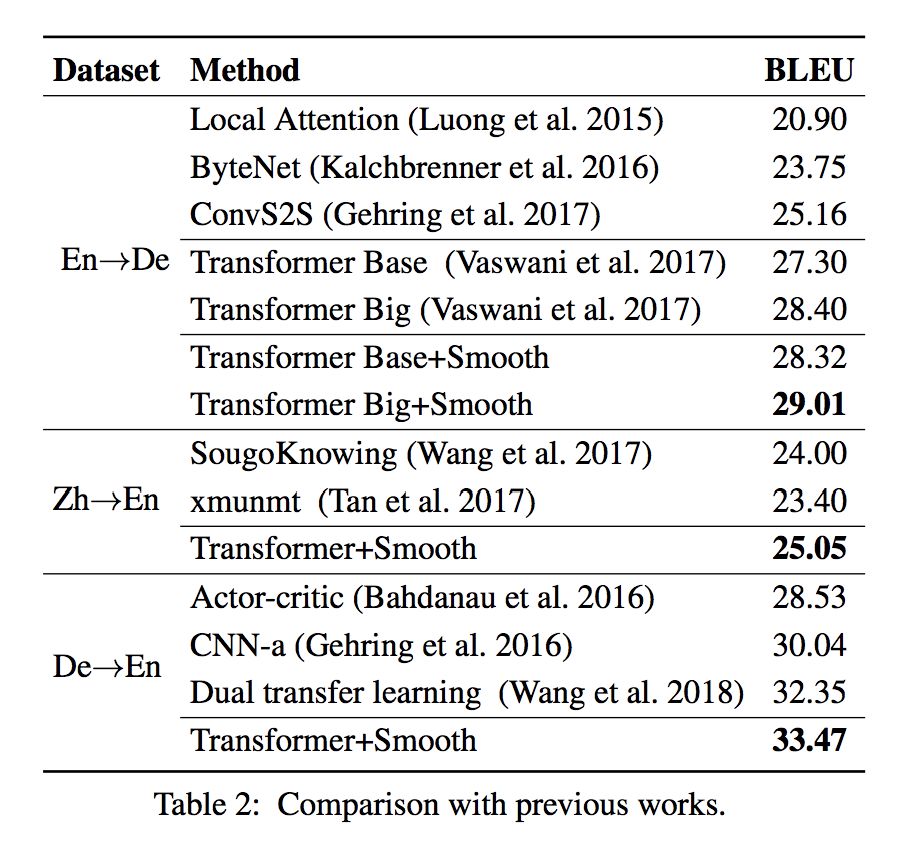

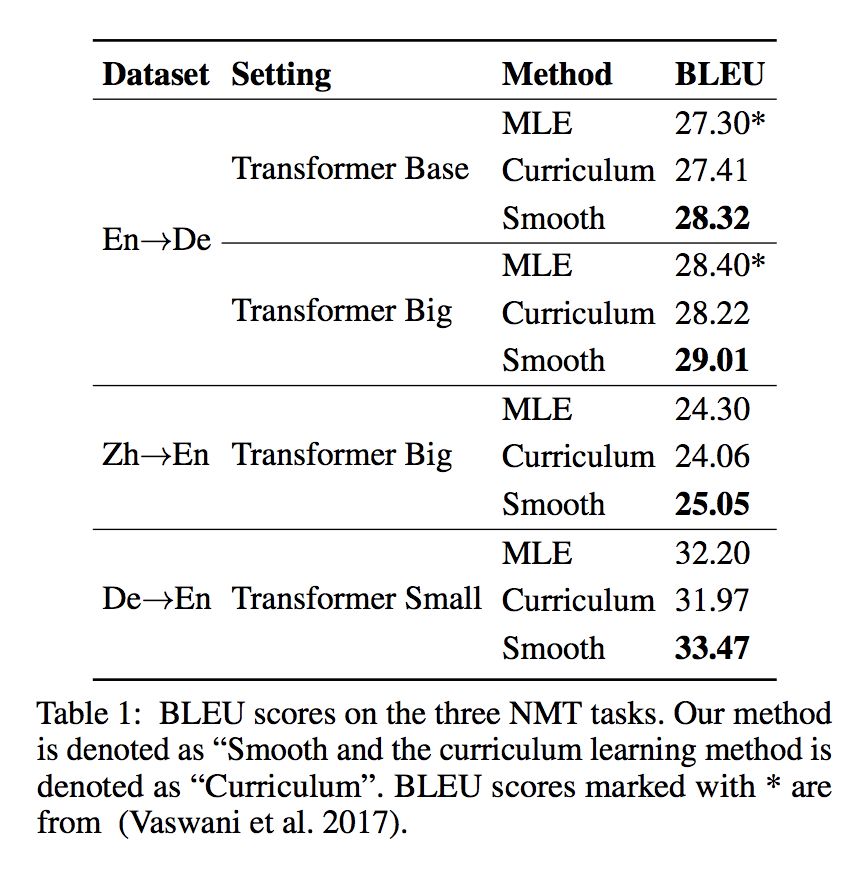

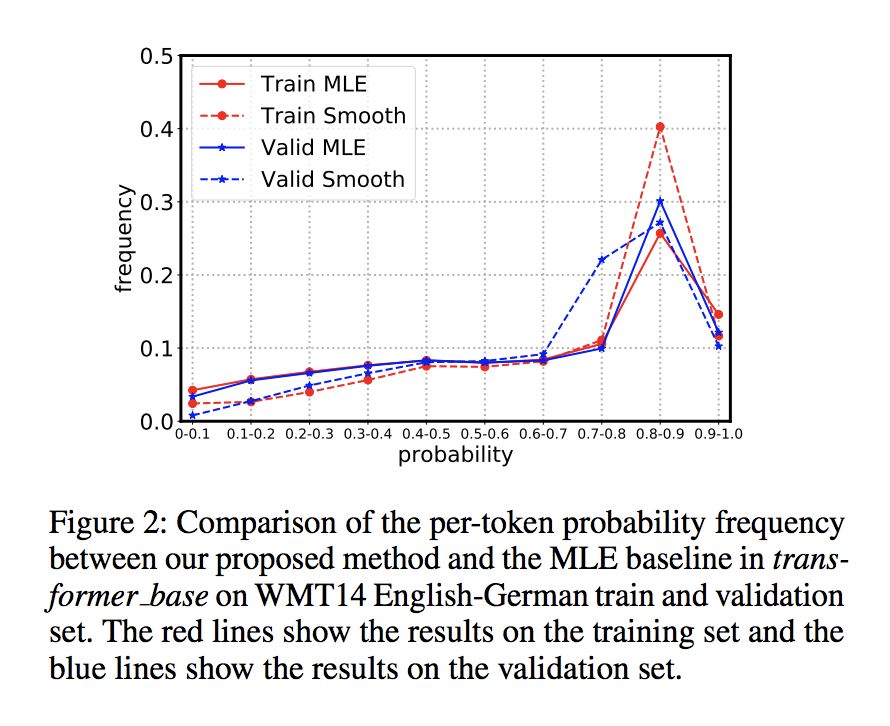

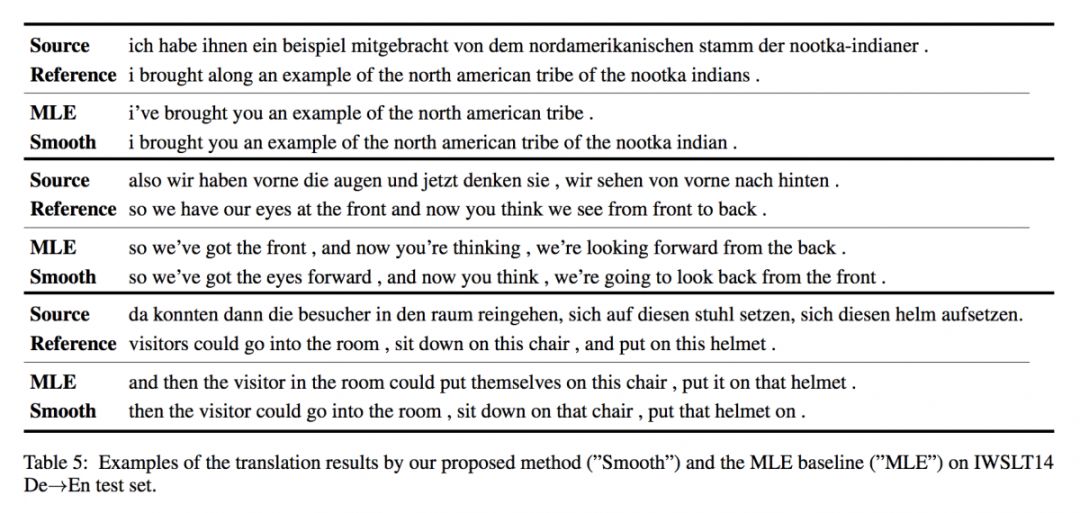

本文是北京大学和微软发表于 AAAI 2019 的工作。最大似然估计常被用作评估 Seq2Seq 生成序列的效果,根据实证研究,作者认为非平滑方法往往效果较差。

本文提出了一种句子正则化方法,为目标序列中的所有 token 输出平滑的预测概率。在三个神经机器翻译任务和一个文本摘要任务上的实验表明,本文效果超出传统MLE,每个token概率越平滑,BLEU分数越高。

▲ 论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2640

@zkt18 推荐

#Contextual Augmentation

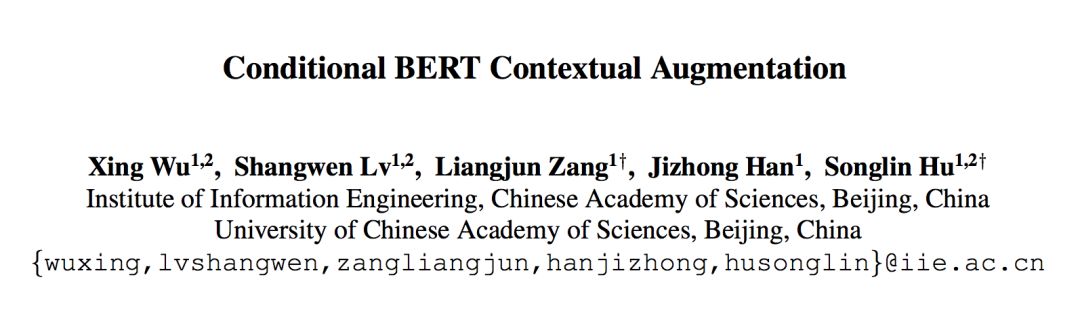

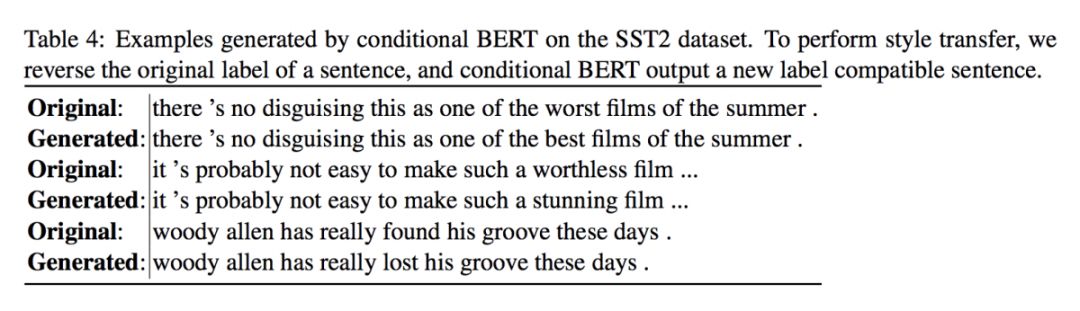

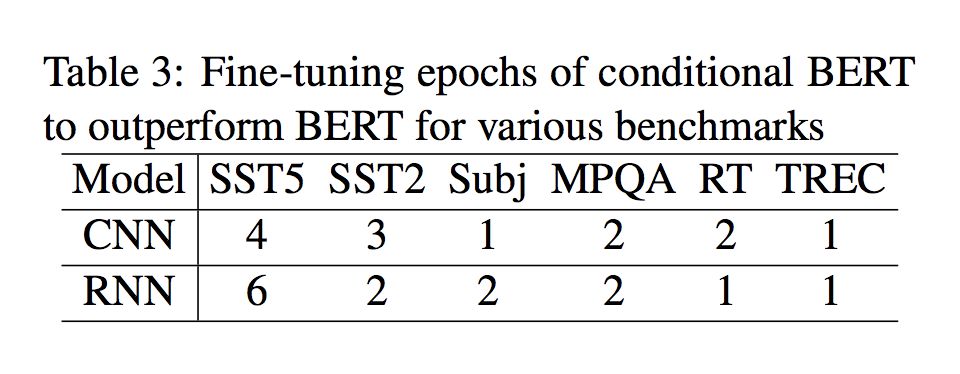

本文来自中国科学院大学。传统 GAN 与 VAE 生成句子在一致性与可读性方面难以保证质量,近年基于词语替换的方法取得了成功。

BERT 使用 Masked Language Model(MLM)任务来预训练,MLM 任务是利用上下文的填空任务(cloze)。这个任务和短文本的语境增强(Contextual Augmentation,使用语言模型来预测并替换句子中的部分词,生成新句子)任务非常贴近。

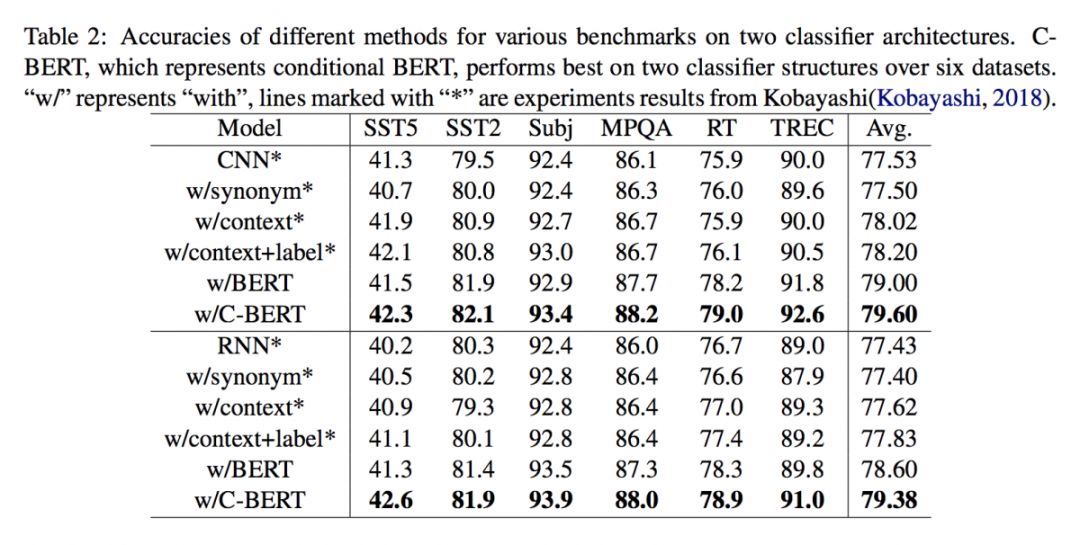

预训练好的 BERT 模型, 可以通过 MLM 任务来实现语境增强。对于有类别标签的短文本,为了使预测出的替换词和原标签兼容,本文提出一个 Conditional MLM 的 fine-tuning 任务。

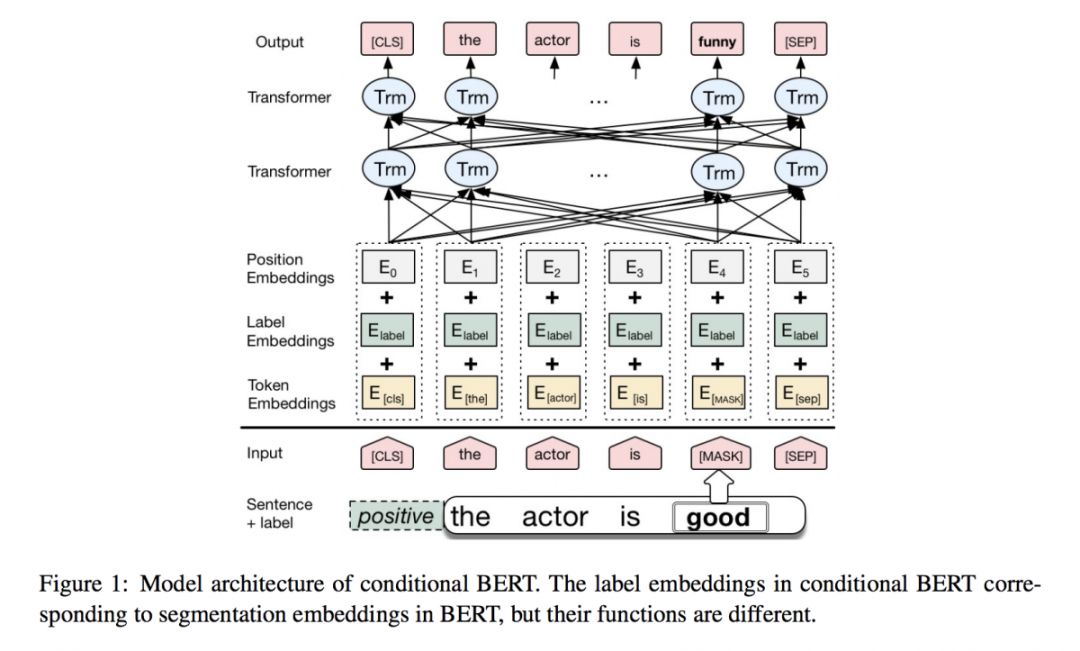

BERT 输入中的 Segmentation Embeddings 被替换成 Label Embeddings,在下游目标任务数据集上训练 Conditional MLM 任务,得到 Conditional BERT。将 Conditional BERT 应用于语境增强,对 6 个短文本分类数据集进行文本增强,都得到了分类效果的明显提升。

▲ 论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2655

@guohao916 推荐

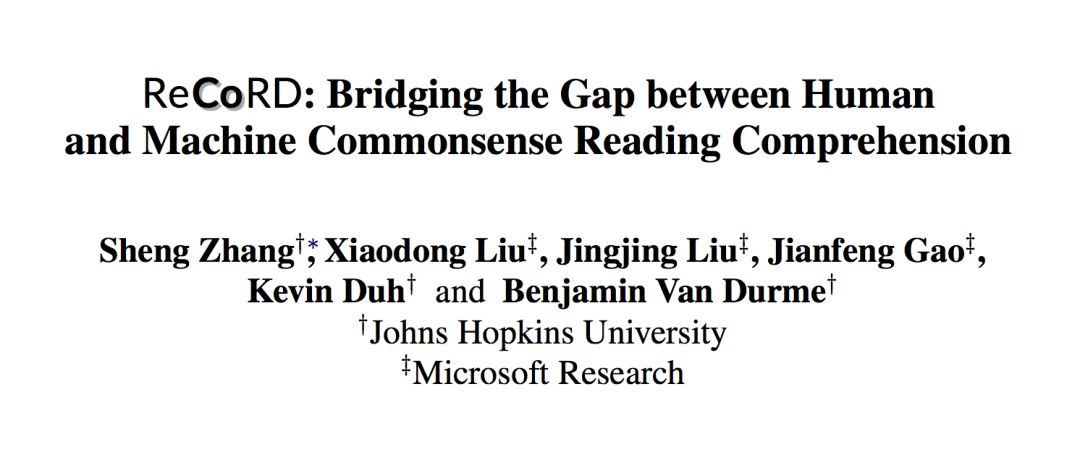

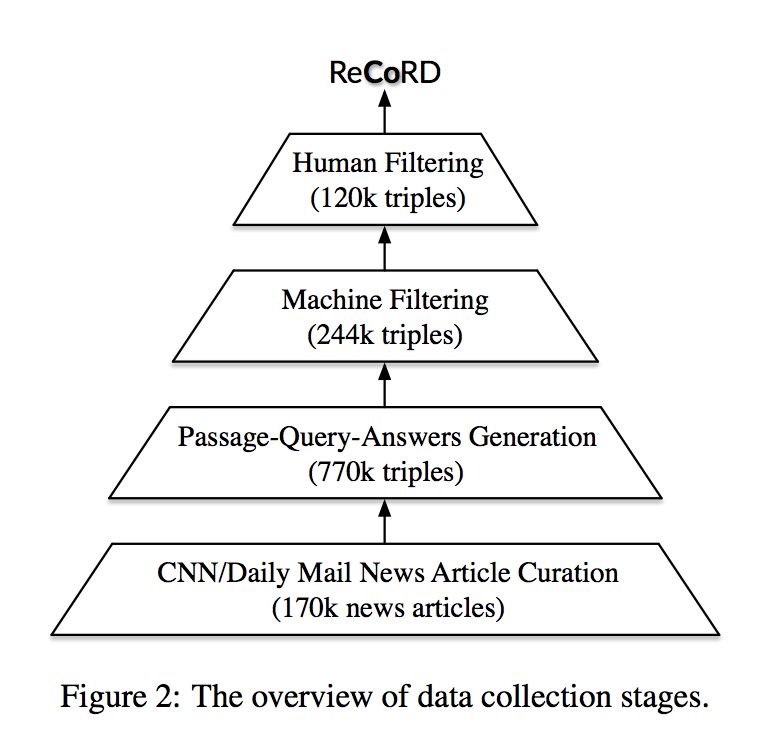

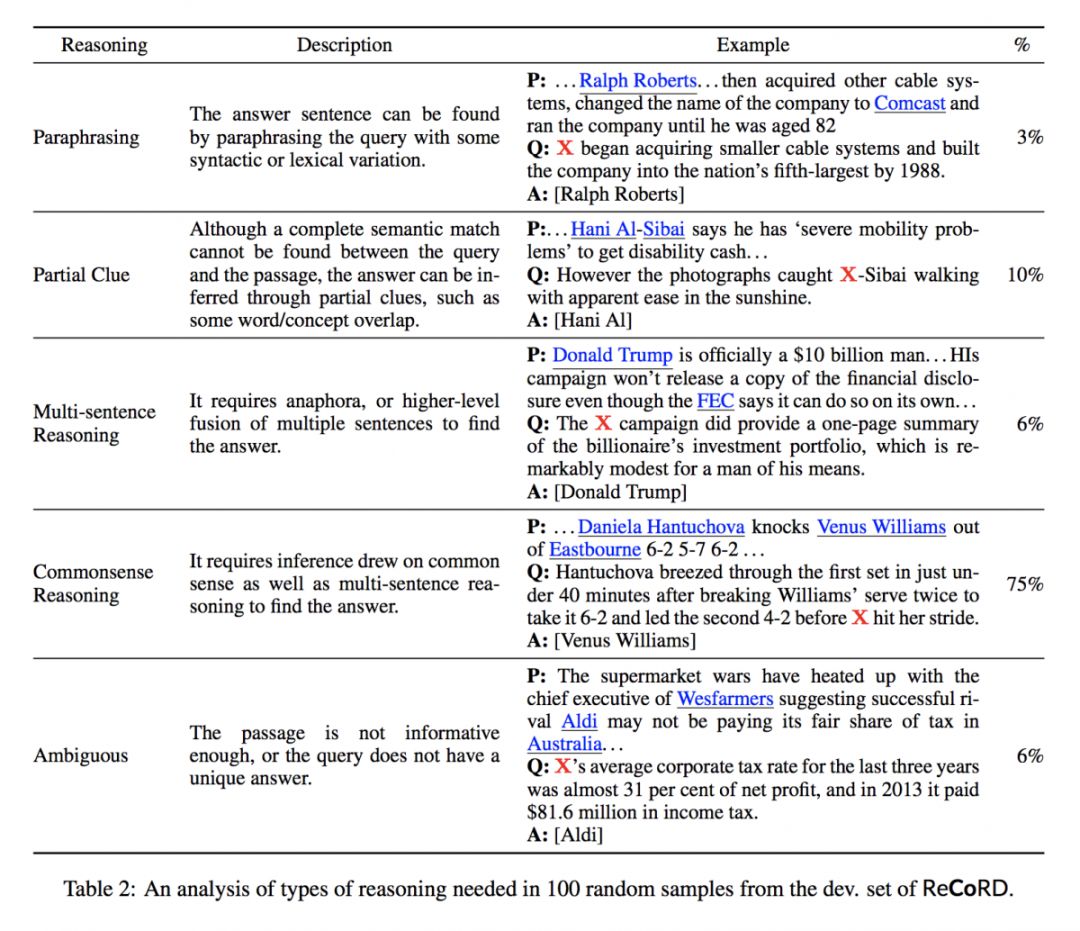

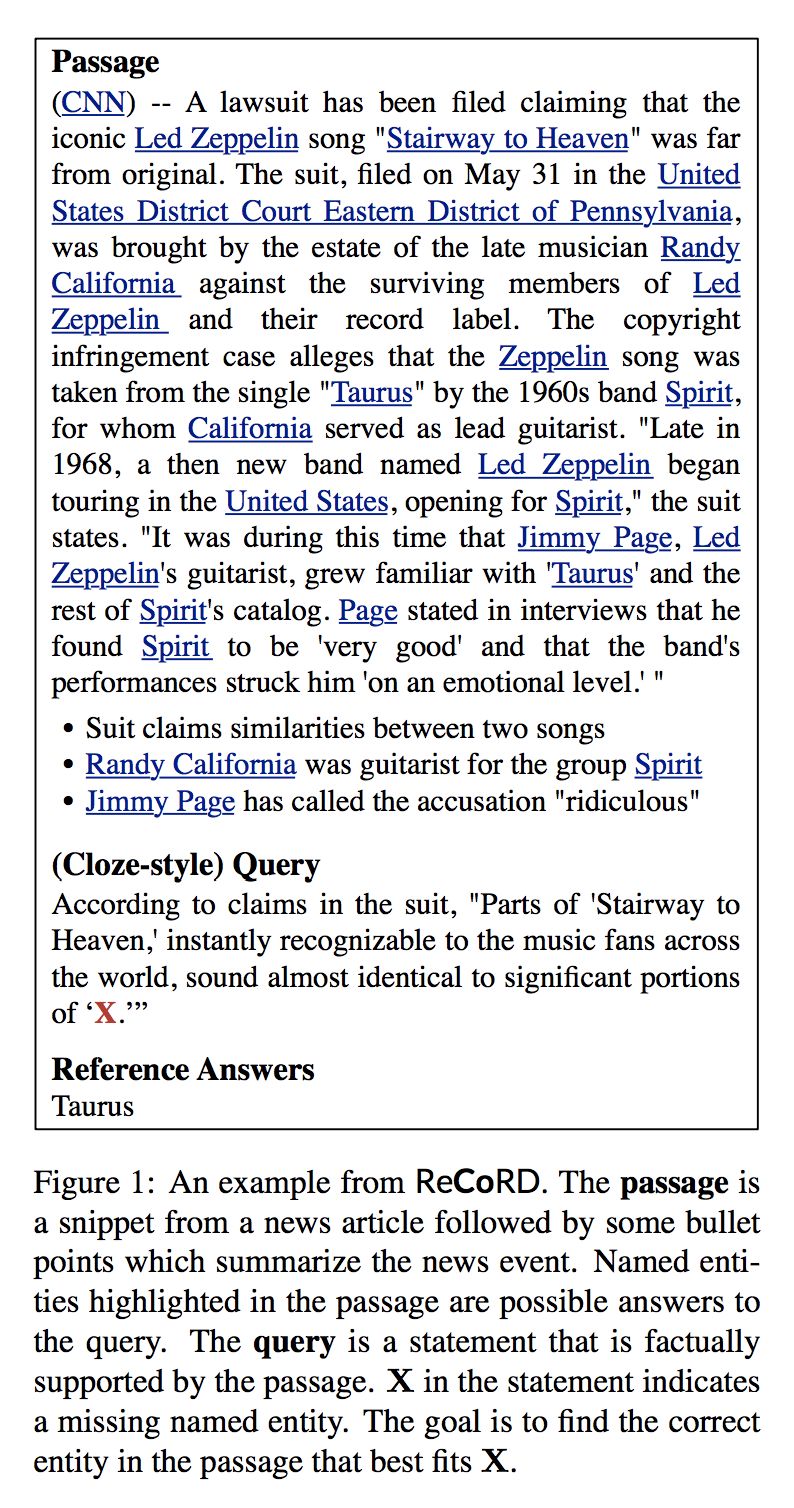

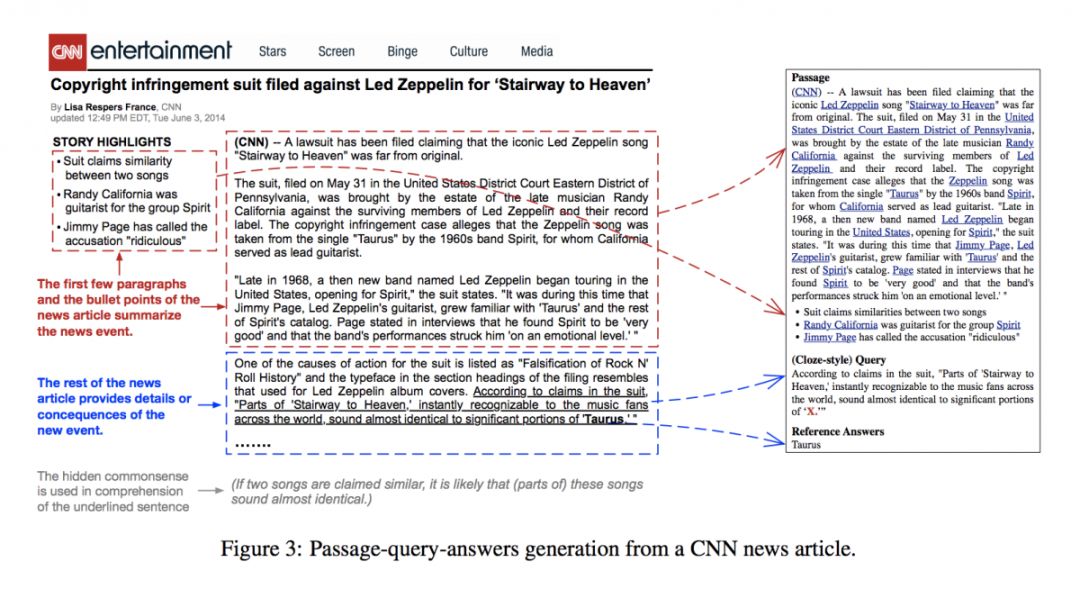

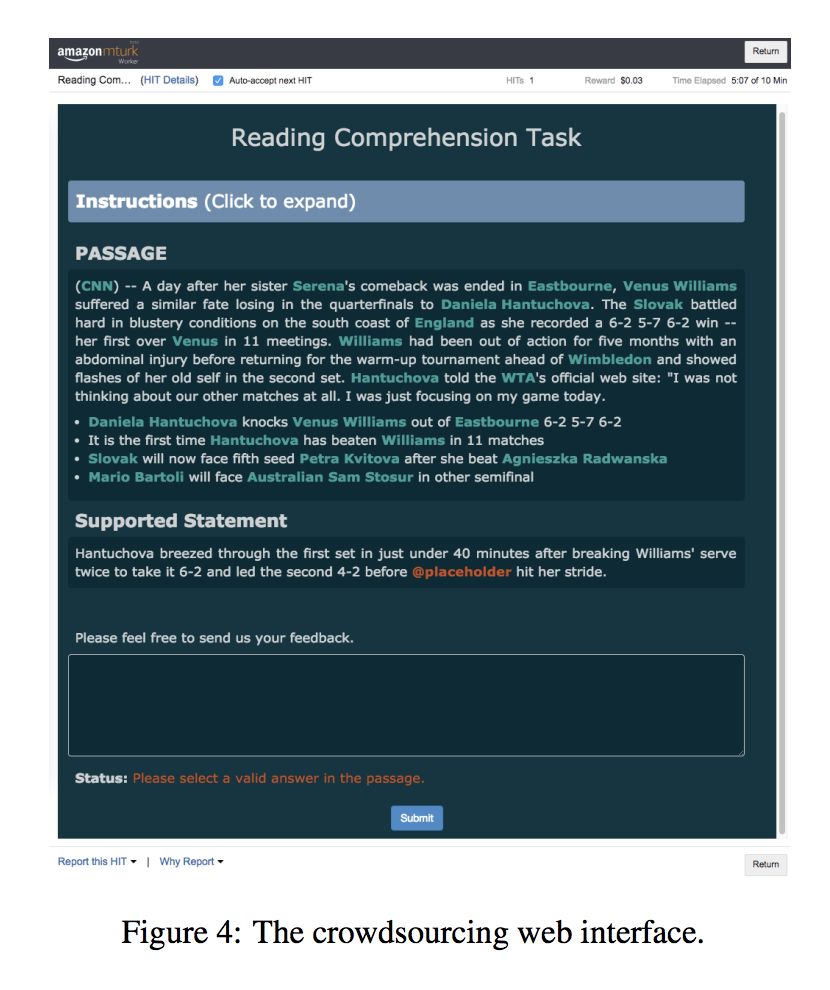

#Machine Reading Comprehension

本文来自约翰霍普金斯大学和微软,论文发布了一个带有常识性推理的机器阅读理解数据集。实验结果表明目前的最新阅读理解模型在该数据集上的结果显著弱于人工评估结果。ReCoRD 数据集为研究如何缩小人与机器之间对于常识推理的理解提供了机会。

▲ 论文模型:点击查看大图

论文链接

本文汇集了本周精选的AI论文推荐,涵盖NLP、CV和机器学习等领域。推荐论文包括基于知识图谱的推荐模型、Seq2Seq学习的句子正则化方法、BERT的语境增强应用、带有常识推理的机器阅读理解数据集等,为读者提供深入的学术洞察和最新的研究进展。

本文汇集了本周精选的AI论文推荐,涵盖NLP、CV和机器学习等领域。推荐论文包括基于知识图谱的推荐模型、Seq2Seq学习的句子正则化方法、BERT的语境增强应用、带有常识推理的机器阅读理解数据集等,为读者提供深入的学术洞察和最新的研究进展。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?