©PaperWeekly 原创 · 作者 | 苏剑林

单位 | 追一科技

研究方向 | NLP、神经网络

LLM 是“Large Language Model”的简写,目前一般指百亿参数以上的语言模型,主要面向文本生成任务。跟小尺度模型(10 亿或以内量级)的“百花齐放”不同,目前 LLM 的一个现状是 Decoder-only 架构的研究居多,像 OpenAI 一直坚持 Decoder-only 的 GPT 系列就不说了,即便是 Google 这样的并非全部押注在 Decoder-only 的公司,也确实投入了不少的精力去研究 Decoder-only 的模型,如 PaLM 就是其中之一。那么,为什么 Decoder-only 架构会成为 LLM 的主流选择呢?

知乎上也有同款问题《为什么现在的 LLM 都是 Decoder only 的架构?》[1],上面的回答大多数聚焦于 Decoder-only 在训练效率和工程实现上的优势,那么它有没有理论上的优势呢?本文试图从这个角度进行简单的分析。

统一视角

需要指出的是,笔者目前训练过的模型,最大也就是 10 亿级别的,所以从 LLM 的一般概念来看是没资格回答这个问题的,下面的内容只是笔者根据一些研究经验,从偏理论的角度强行回答一波。

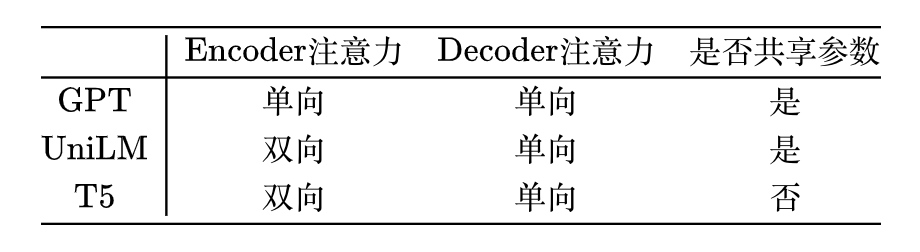

我们知道,一般的 NLP 任务都是根据给定的输入来预测输出,完全无条件的随机生成是很少的,换句话说,任何 NLP 任务都可以分解为“输入”跟“输出”两部分,我们可以把处理“输入”的模型叫做 Encoder,生成“输出”的模型叫做 Decoder,那么所有任务都可以从“Encoder-Decoder”的视角来理解,而不同模型之间的差距在于 Encoder、Decoder 的注意力模式以及是否共享参数:

这里的 GPT 就是 Decoder-only 的代表作;Uni

本文探讨Decoder-only架构成为LLM主流的原因,通过对比实验和理论分析,提出Decoder-only在训练效率、工程实现及理论上的优势。双向注意力可能因低秩问题导致表达能力下降,而在同等条件下,Decoder-only架构可能是最优选择。

本文探讨Decoder-only架构成为LLM主流的原因,通过对比实验和理论分析,提出Decoder-only在训练效率、工程实现及理论上的优势。双向注意力可能因低秩问题导致表达能力下降,而在同等条件下,Decoder-only架构可能是最优选择。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1390

1390

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?