系列博客目录

摘要

多模态基于方面的情感分析(MABSA)旨在从文本-图像对中提取方面并识别其情感。现有方法大多致力于将整个图像与对应的方面对齐。然而,图像的不同区域可能与同一句中的不同方面相关,将图像-方面对齐粗略地建立会引入噪声,从而影响基于方面的情感分析(即视觉噪声)。此外,特定方面的情感也可能受到其他方面描述的干扰(即文本噪声)。考虑到上述噪声,本文提出了一种面向方面的方法(AoM)来检测与方面相关的语义和情感信息。具体来说,设计了一个方面感知注意力模块,用以同时选择与方面语义相关的文本标记和图像块。为了准确地聚合情感信息,我们显式地将情感嵌入引入AoM,并使用图卷积网络来建模视觉-文本和文本-文本之间的交互。大量实验表明,AoM在性能上优于现有方法。源代码已公开发布在:https://github.com/SilyRab/AoM。

1 引言

作为情感分析领域中的一项重要且具有前景的任务,多模态基于方面的情感分析(MABSA)已受到越来越多的关注(Lv 等,2021;Ju 等,2021)。给定一张图像及其对应的文本,MABSA被定义为从图像-文本对中共同提取所有方面术语并预测其情感极性(Ju 等,2021)。在这种细粒度的多模态信息情感识别场景中,输入的图像-文本对通常是复杂的。

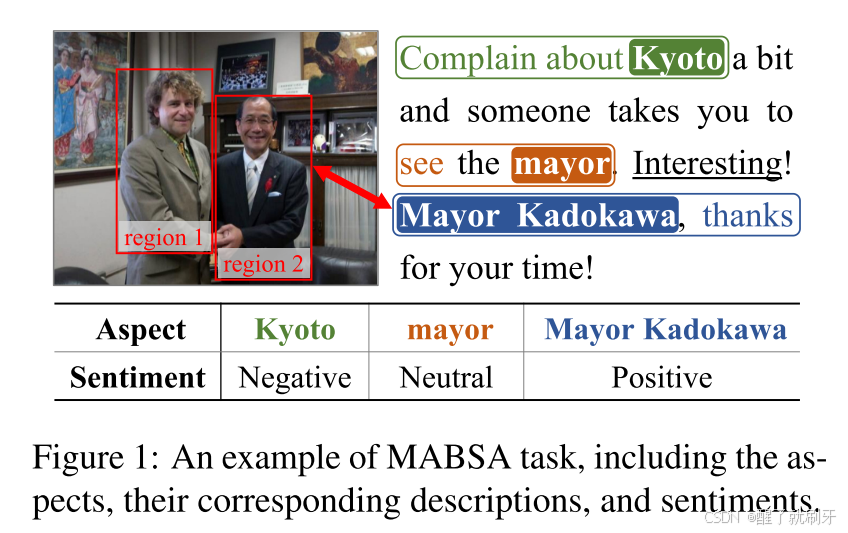

(1) 句子的语义较为复杂,这会导致不同方面之间的情感混淆。以图 1 为例,句子中有 3 个方面和 3 种不同的情感。“mayor”(市长)的情感容易受到关键词“Interesting”(有趣)的影响,而后者的情感是积极的。

(2) 图像包含大量详细信息,且视觉内容通常只与一个或几个方面相关。例如,如图 1 所示,红色框中的物体在分析“Mayor Kadokawa”(市长加藤川)的情感时比其他方面更为有用。复杂的输入大大增加了基于方面的情感识别的难度。

考虑到多模态输入,现有方法通常致力于关联视觉和文本内容(Ju 等,2021;Ling 等,2022;Yang 等,2022)。Ju 等(2021)利用图像-文本关系来评估视觉内容对方面情感的贡献,并基于此确定图像是否参与情感分析。Ling 等(2022)和 Yang 等(2022)将物体及其属性的视觉表示与相应的文本内容进行对齐。总的来说,这些方法直接将整个图像与文本内容关联起来。

直观来看,如果不将图像块与相应的方面对齐,粗略的图像-文本关联可能会引入与方面无关的视觉噪声,进而阻碍方面情感分析。此外,文本噪声也可能进一步影响性能,尤其是不同方面之间的混淆。

在本文中,我们提出了一种面向方面的方法(AoM),以减轻来自图像和文本的上述噪声。AoM能够从语义和情感两个角度检测与方面相关的信息。AoM包含两个关键模块:面向方面的注意力模块(A3M),用于语义细粒度的图像-文本对齐;以及面向方面的图卷积网络(AG-GCN),用于情感信息的聚合。在A3M中,我们首先提取与每个视觉和文本标记相关的方面特征。然后,根据它们与对应方面特征的相关性,计算与方面相关的标记表示。在AG-GCN中,我们首先显式地将情感嵌入添加到获取的视觉和文本标记表示中。接着,构建一个多模态加权关联矩阵,该矩阵包含方面到图像块的相似性和词到词的依赖关系。然后,我们使用图卷积网络根据构建的多模态矩阵来聚合情感信息。

贡献总结如下:

(1) 我们提出了一种面向方面的网络,以减轻复杂图像-文本交互中来自视觉和文本的噪声。

(2) 我们设计了一个面向方面的注意力模块和一个面向方面的图卷积网络,分别从语义和情感的角度有效地检测与方面相关的多模态内容。

(3) 在两个基准数据集(包括Twitter2015和Twitter2017)上的实验表明,我们的方法在整体上优于现有的最先进方法。

2 相关工作

在本节中,我们回顾了现有的基于方面的情感分析(ABSA)和多模态基于方面的情感分析(MABSA)方法。

2.1 基于方面的情感分析

近年来,基于方面的情感分析(ABSA)在文本领域引起了广泛关注,并取得了成熟的研究成果(Chen 和 Qian, 2020;Oh 等,2021;Xu 等,2020)。一方面,由于预训练语言模型BERT在许多自然语言处理任务中的出色表现,最近的大多数工作都基于BERT(Liang 等,2022a)。另一方面,一些近期的研究则专注于建模方面与其对应描述之间的依赖关系,利用图卷积网络(GCN)(Chen 等,2022;Liang 等,2022b,2020;Li 等,2021a;Pang 等,2021)或图注意力网络(GAT)(Yuan 等,2020)充分挖掘句子语法结构中的依赖关系。

2.2 多模态基于方面的情感分析

随着社交媒体中多模态用户帖子内容的丰富,研究人员发现图像在方面术语提取(Wu 等,2020a;Zhang 等,2018;Asgari-Chenaghlu 等,2021)和情感分析(Wu 等,2022;Zhang 等,2022;Li 等,2021b;Hazarika 等,2020;Cai 等,2019)中提供了重要的补充信息。因此,多模态基于方面的情感分析(MABSA)开始得到广泛研究。MABSA任务可以分为两个独立的子任务,即多模态方面术语提取(MATE)和多模态面向方面的情感分类(MASC)。前者在图像的提示下提取句子中的所有方面术语,后者则预测这些方面的情感极性。

Ju 等(2021)首次在统一框架中实现了MABSA,并设计了一个辅助的跨模态关系检测模块,用于控制视觉信息是否会在预测中被使用。为了捕捉跨模态对齐,Ling 等(2022)构建了一种基于BART的生成式多模态架构,用于视觉-语言预训练和下游MABSA任务。Yang 等(2022)通过一种技巧动态控制视觉信息对不同方面的贡献,即当纯文本预测结果的置信度较低时,会更多地考虑图像的贡献。

一方面,以上方法忽略了细粒度视觉块与相应方面的对齐,从而引入了与方面无关的视觉噪声。另一方面,这些方法未对方面描述的语法依赖关系和情感信息进行建模,而这在情感分析中被证明是非常重要的(Liang 等,2022a;Kalaivani 等,2022;Xu 等,2022)。

为了解决上述问题,我们提出了一种面向方面的模型,包含面向方面的注意力模块(Aspect-Aware Attention Module)和面向方面的图卷积网络(Aspect-Guided Graph Convolutional Network),它们分别通过细粒度的图像-文本对齐捕捉语义信息,并有效地聚合与方面相关的情感信息。

3. 方法论

3.2 面向方面的注意力模块(A3M)

由于BART编码器没有专门建模方面,我们创造性地设计了面向方面的注意力模块(A3M),旨在捕捉与方面相关的语义信息。为此,我们对目标物体的多模态信息进行对齐,并过滤掉图像中的语义噪声。

首先,由于方面通常是句子中的名词短语,我们使用NLP工具Spacy提取这些短语作为候选方面(CA)。然后,从BART编码器的隐藏状态H中,我们获得所有候选方面的特征,记为 H C A = { h 1 C A , . . . , h i C A , . . . , h l C A } H^{CA} = \{h^{CA}_1, ..., h^{CA}_i, ..., h^{CA}_l \} HCA={

h1CA,...,hiCA,...,hlCA},其中 l l l是句子中名词短语的数量。为了获取候选方面与原子特征之间的关系,我们实现了一种基于注意力的机制,指导候选方面的注意力分配。给定第t个隐藏特征 h t h_t ht,其在k个候选方面上的注意力分布 α t \alpha_t αt 通过以下方式获得:

Z t = tanh ( ( W C A H C A + b C A ) ⊕ ( W H h t + b H ) ) , (1) Z_t = \tanh((W_{CA} H^{CA} + b_{CA}) \oplus (W_H h_t + b_H)), \tag{1} Zt=tanh((WCAHC

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1515

1515

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?