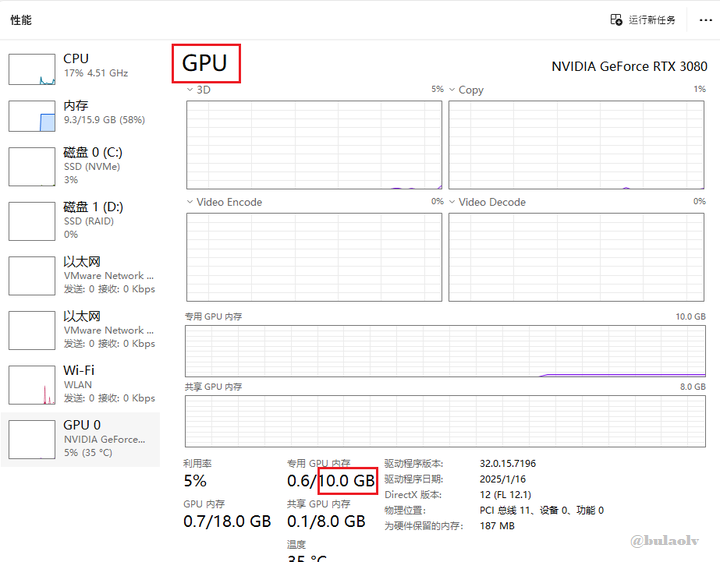

最近我成功在本地部署了DeepSeek-R1的8B模型,运行体验简直棒极了(我的显卡是10GB显存),所以一直担心跑不动14B语言模型。但实际测试下来,14B模型也没有太大压力,这让我非常惊喜!

如果你也对本地部署大语言模型感兴趣,不妨赶紧下载体验一下吧!之前我写过一篇关于基础软件和安装方法的文章,可以参考这篇文案:免费部署DeepSeek-R1本地模型教程

14B模型在文章下方(^^)获取

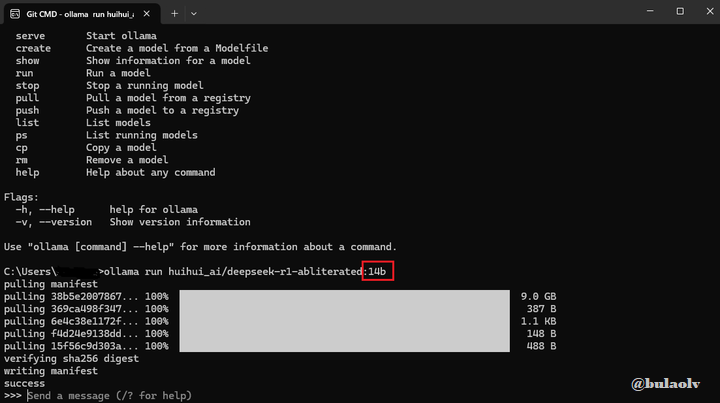

14b语言模型

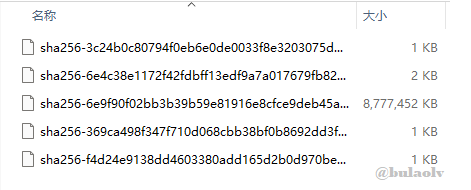

解压后有如下五个文件

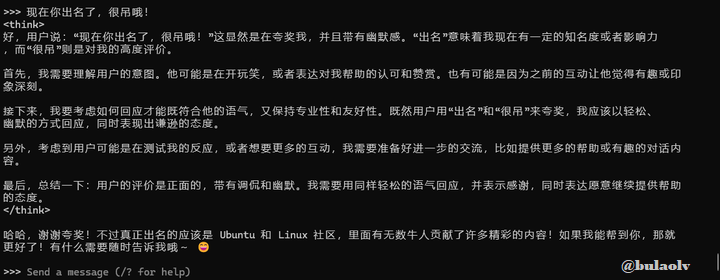

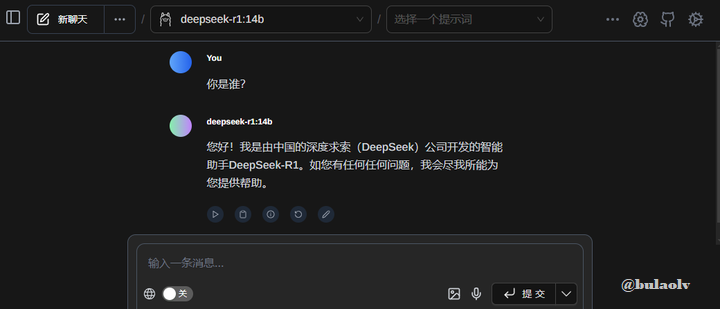

安装好后随意的测试了一下,响应速度很快

UI界面的随意对话

由于下载14B模型需要一些特殊方法,我已经提前帮大家下载打包好了,有需要的可以到夸克网盘获取哦:

链接:夸克网盘分享

文件名:blobs_14B.7z(8.2GB)

模型安装后会自动保存在如下本地文件夹内,你可以把获取的模型包解压后放到如下路径:

C:\Users\用户名\.ollama\models\blobs

※如果还没有.7z解压软件的话也可获取哦

链接:夸克网盘分享

文件名:7-Zip

--------------------------------------------------------

谢谢阅览,喜欢的话请支持一下吧❤️

10GB显存部署14B大模型体验

10GB显存部署14B大模型体验

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?