一、LVS是什么?存在的意义是什么?

1. LVS

- LVS 即 Linux Virtual Server ,Linux虚拟服务器 实际上相当于基于IP地址的虚拟化应用, 为基于IP地址和内容请求分发的负载均衡提出了一种高效的解决方法

- 企业中常用的一种群集技术

- 通过整合多台服务器,使用LVS来达到服务器高可用和负载均衡,并于同一个IP地址对外提供相同服务

- LVS现在已成为Linux内核的一部分,默认编译为ip_ vs模块,必要时能够自动调用。在CentOS 7系统中,以下操作可以手动加载ip_ vs模块,并查看当前系统中ip_ vs模块的版本信息。

2. 群集&&LVS存在的意义

- 互联网应用中,随着站点对硬件性能、响应速度、服务稳定性、数据可靠性等要求越来越高,单台服务器无法满足负载均衡及高可用的需求。

- 若使用单台性能强劲的机器,成本过高

- 所以可以使用多台相对廉价的普通服务器构建服务群集。通过LVS进行管理使用

- LVS主要作用是管理集群

3. ipvsadm工具

- 要使用LVS的能力,只需安装一个LVS的管理工具:ipvsadm

- LVS的结构主要分为两部分:

- 工作在内核空间的IPVS模块。LVS的能力实际上都是由IVPS模块实现。

- 工作在用户空间的ipvsadm管理工具。其作用是向用户提供一个命令接口,用于将配置的虚拟服务、真实服务等传给IPVS模块。

- ipvsadm作用及常用选项

二、群集分类

根据集群针对的目标差异,可分为三种

- 负载均衡群集

- 高可用群集

- 高性能计算群集

具体搭建部署 按实际应用场景

1. 负载均衡群集(LBC)

-

提高应用系统的响应能力、尽可能处理更多的访问请求、减少延迟为目标,获得高并发、高负载(LB)的整体性能。

-

LB的负载分配依赖于主节点的分流算法,将来自客户机的访问请求分担给多个服务器节点,从而缓解整个系统的负载。

2. 高可用集群(HAC)

-

提高应用系统的可靠性、尽可能地减少中断时间为目标,确保服务的连续性,达到高可用(HA) 的容错效果。

-

HA的工作方式包括双工和主从两种模式,双工即所有节点同时在线;主从则只有主节点在线,但当出现故障时从节点能自动切换为主节点。

-

例如:双工模式有:“双机热备”、主从模式有:“故障切换”

3. 高性能计算集群(HPC)

-

以提高应用系统的CPU运算速度、扩展硬件资源和分析能力为目标,获得相当于大型、超级计算机的高性能运算(HPC)能力。

-

高性能依赖于"分布式运算”、“并行计算” , 通过专用硬件和软件将多个服务器的CPU、内存等资源整合在一起,实现只有大型、超级计算机才具备的计算能力。

-

例如,“云计算”、“网格计算”等。

本文章主实验为负载均衡群集,下面即关于负载均衡群集详细介绍

三、负载均衡群集详细介绍

1. 负载均衡架构

基本主要架构按层分为:

- 负载调度器(Load Balancer或Director)

- 服务器池(Server Pool)

- 共享存储(Share Storage)

1.1 负载均衡调度器

- 访问整个群集系统的唯一入口, 对外使用所有服务器共有的VIP地址,也称为群集IP地址。

- 通常会配置主、备两台调度器实现热备份,当主调度器失效以后能够平滑替换至备用调度器,确保高可用性。

1.2 服务器池

- 群集所提供的应用服务、由服务器池承担,其中每个节点具有独立的RIP地址(真实IP),只处理调度器分发过来的客户机请求。

- 当某个节点暂时失效时,负载调度器的容错机制会将其隔离,等待错误排除以后再重新纳入服务器池。

1.3 共享存储服务器

- 为服务器池中的所有节点提供稳定、一致的文件存取服务, 确保整个群集的统一性共享存储可以使用NAS设备,或者提供NFS共享服务的专用服务器。

2. 负载均衡群集工作模式

- 地址转换(NAT模式)

- IP隧道 (TUN模式)

- 直接路由(DR模式)

2.1 NAT模式

- 网络地址转换 Network Address Translation,简称NAT模式

- 类似于防火墙的私有网络结构,负载调度器作为所有服务器节点的网关,即作为客户机的访问入口,也是各节点回应客户机的访问出口

- 服务器节点使用私有IP地址,与负载调度器位于同一个物理网络,安全性要优于其他两种方式

2.2 TUN模式

- IP隧道 IP Tunnel,简称TUN模式

- 采用开放式的网络结构,负载调度器仅作为客户机的访问入口,各节点通过各自的Internet连接直接回应客户机,而不再经过负载调度器

- 服务器节点分散在互联网中的不同位置,具有独立的公网IP地址,通过专用IP隧道与负载调度器相互通信

- 此模式相对成本过高 因为每个服务器节点都有自己的公网IP

2.3 DR模式

- 直接路由 Direct Routing,简称DR模式

- 采用半开放式的网络结构,与TUN模式的结构类似,但各节点并不是分散在各地,而是与调度器位于同一个物理网络

- 负载调度器与各节点服务器通过本地网络连接,不需要建立专用的IP隧道

3. LVS负载调度算法

- 与其他服务器架构调度算法大致相同

- 分为 : 轮询、加权轮询、最小链接、加权最小连接

3.1 轮询(RR)

- 将收到的访问请求按照顺序轮流分配给群集中的各节点(真实服务器) ,均等地对待每一台服务器 ,而不管服务器实际的连接数和系统负载

- 例如 来自客户端的第一个请求分发给第一个服务器,第二个请求分发给第二个服务器、第三个请求分给第三个、第四个请求再分给第一个 这样依次轮询的方式就是轮询

- 总结:在者有份,(分发数)公平对待

3.2 加权轮询(WRR)

- 根据调度器设置的权重值来分发请求,权重值高的节点优先获得任务,分配的请求数越多

- 保证性能强的服务器承担更多的访问流量

- 解决了轮询的不管服务器的实际负载的情况

- 总结:服务器的 能力越大 责任越大

3.3 最小链接(LC)

- 根据真实服务器已建立的连接数进行分配,将收到的访问请求优先分配给连接数最少的节点

- 总结:在一定程度上达到均衡,连接多的分配少,连接少的分配多

3.4 加权最小连接(WLC)

- 在服务器节点的性能差异较大时,可以为真实服务器自动调整权重

- 性能较高的节点将承担更大比例的活动连接负载

- 总结:同WRR的能力越大 责任越大 只不过是自动调整权重

四、LVS负载均衡集群-NAT模式 部署

集群架构

- 负载均衡服务器(LVS) 双网卡、RR策略、安装ipvsadm工具

- web服务器1 安装rpcbind、nfs-utils、httpd服务

- web服务器2 安装rpcbind、nfs-utils、httpd服务

- NFS共享存储服务器 安装rpcbind、nfs-utils服务

- 客户端(使用外网模拟真实客户端)

1. 部署共享存储服务器

实验前为了避免不必要的麻烦 先把所有机器防火墙关掉

systemctl stop firewalld.service

systemctl disable firewalld.service

setenforce 0

部署NFS服务

下载软件包

yum -y install nfs-utils rpcbind

开启服务

systemctl start rpcbind.service

systemctl start nfs.service

设置开机自启

systemctl enable nfs.service

systemctl enable rpcbind.service

创建共享目录,这里是为两个web服务器分别提供服务 所以创建两个目录

mkdir /opt/ccc

mkdir /opt/zzz

为共享目录赋权

chmod 777 /opt/ccc /opt/zzz

编辑文件 写入共享策略

vim /etc/exports

/usr/share *(ro,sync)

/opt/ccc 192.168.100.0/24(rw,sync)

/opt/zzz 192.168.100.0/24(rw,sync)

发布共享

exportfs -rv

前面不再演示

2. 部署两个web节点服务器

web1服务器

安装并开启http服务

yum install httpd -y

systemctl start httpd.service

systemctl enable httpd.service

安装nfs服务

yum -y install nfs-utils rpcbind

查看nfs共享

showmount -e 192.168.100.129

开启nfs服务

systemctl start rpcbind

systemctl enable rpcbind

挂载共享目录到 http默认首页目录 并写入内容

mount.nfs 192.168.100.129:/opt/ccc /var/www/html

echo 'this is ccc web!' > /var/www/html/index.html

web2服务器

安装并开启http服务

yum install httpd -y

systemctl start httpd.service

systemctl enable httpd.service

安装nfs服务

yum -y install nfs-utils rpcbind

查看nfs共享

showmount -e 192.168.100.129

开启nfs服务

systemctl start rpcbind

systemctl enable rpcbind

挂载共享目录到 http默认首页目录 并写入内容

mount.nfs 192.168.100.129:/opt/zzz /var/www/html

echo 'this is zzz web!' > /var/www/html/index.html

PS:因为用的是NAT模式 所以调度器和服务器之间都是同网段 也就是内网通信 所以不需要设置DNS 网卡里配置DNS的同学可以注释掉

3. 部署负载调度服务器(LVS)

因为NAT模式 客户端和调度器之间用公网通信 调度器与服务器池用内网通信 所以 调度服务器需要设置双网卡 并配置SNAT转发规则

vim /etc/sysctl.conf

net.ipv4.ip_forward = 1

或

echo '1' > /proc/sys/net/ipv4/ip_forward

sysctl -p

配置SNAT转发规则

iptables -t nat -F

iptables -F

iptables -t nat -A POSTROUTING -s 192.168.100.0/24 -o ens37 -j SNAT --to-source 12.0.0.1

加载LVS内核模块

modprobe ip_vs #加载 ip_vs模块

cat /proc/net/ip_vs #查看 ip_vs版本信息

安装ipvsadm 管理工具

yum -y install ipvsadm

启动服务前须保存负载分配策略

ipvsadm-save > /etc/sysconfig/ipvsadm

或

ipvsadm --save > /etc/sysconfig/ipvsadm

启动ipvsadm服务

systemctl start ipvsadm.service

配置负载分配策略(NAT模式只要在服务器上配置,节点服务器不需要特殊配置)

ipvsadm -C #清除原有策略

ipvsadm -A -t 12.0.0.1:80 -s rr

ipvsadm -a -t 12.0.0.1:80 -r 192.168.100.134:80 -m

ipvsadm -a -t 12.0.0.1:80 -r 192.168.100.135:80 -m

ipvsadm #启用策略

查看策略

ipvsadm -ln

保存策略

ipvsadm-save > /etc/sysconfig/ipvsadm

添加一块网卡

添加ip转发功能 配置SNAT

加载LVS内核模块

安装ipvsadm 管理工具>> 保存负载分配策略 >>启动服务

配置负载分配策略

4. 客户端测试

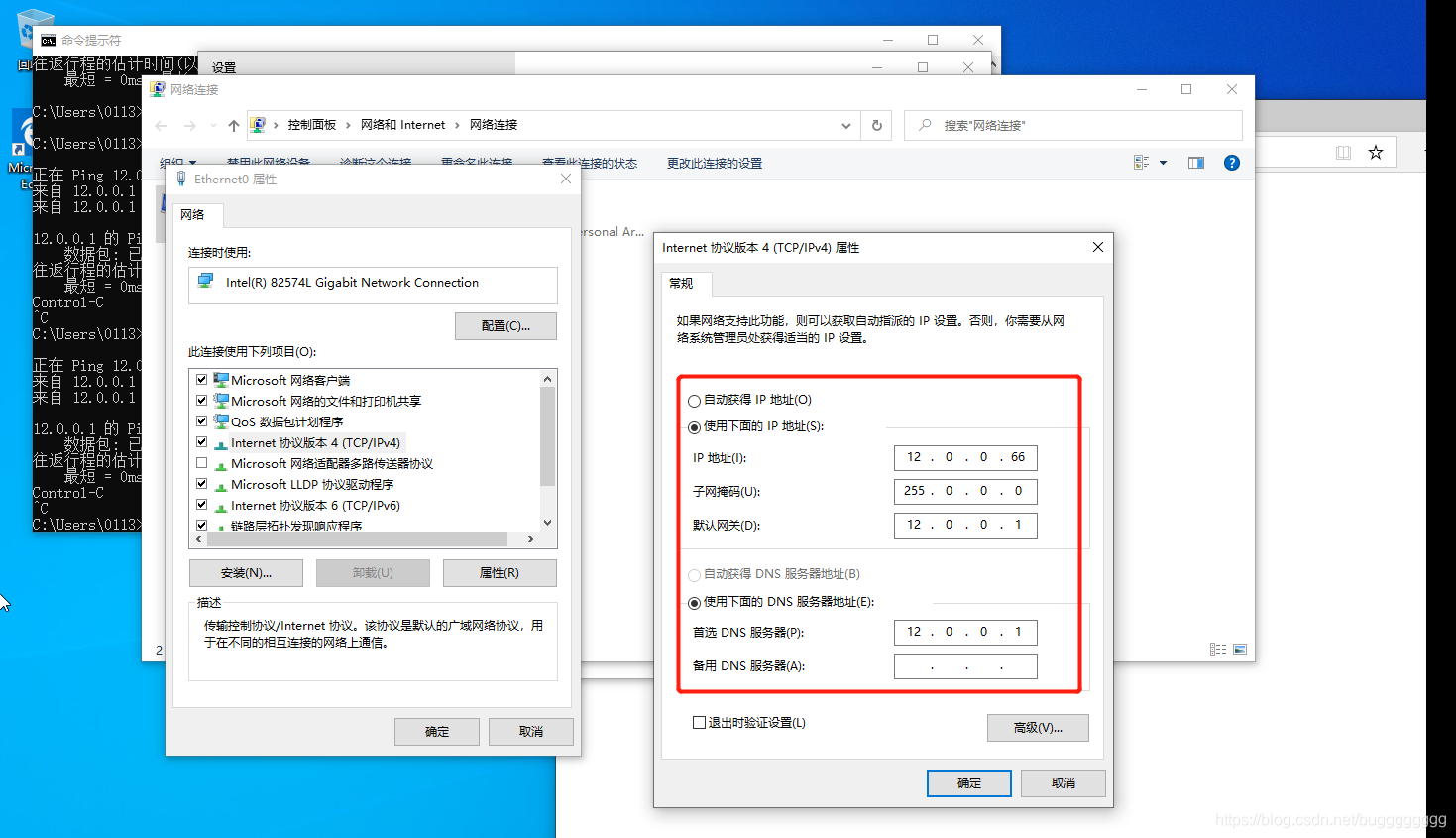

客户端的网络如下 网关要指定LVS服务器的外网IP

访问测试:

再次刷新 首页内容又变化了 说明提供服务的web服务器变了 也就是RR调度算法生效

本文介绍了LVS(Linux Virtual Server)及其在企业群集中的作用,重点讲解了负载均衡群集的工作模式,特别是NAT模式,以及轮询(RR)调度算法。通过NAT模式部署了一个包含负载调度服务器、web节点服务器和共享存储服务器的集群,并进行了客户端测试,验证了轮询策略的有效性。

本文介绍了LVS(Linux Virtual Server)及其在企业群集中的作用,重点讲解了负载均衡群集的工作模式,特别是NAT模式,以及轮询(RR)调度算法。通过NAT模式部署了一个包含负载调度服务器、web节点服务器和共享存储服务器的集群,并进行了客户端测试,验证了轮询策略的有效性。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?