关于mapreduce

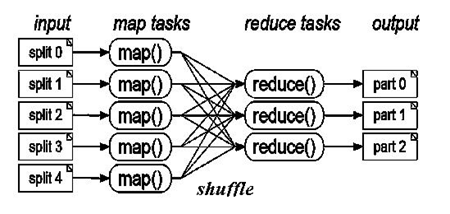

mapreduce很适合数据之间相关性较低且数据量庞大的情况,map操作将原始数据经过特定操作打散后输出,作为中间结果,hadoop通过shuffle操作对中间结果排序,之后,reduce操作接收中间结果并进行汇总操作,最后将结果输出到文件中,从这里也可以看到在hadoop中,hdfs是mapreduce的基石。可以用下面这幅图描述map和reduce的过程:

有人用这么一句话解释mapreduce:

We want to count all the books in the library. You count up shelf #1, I count up shelf #2. That's map. The more people we get, the faster it goes.

我们要数图书馆中的所有书。你数1号书架,我数2号书架。这就是“Map”。我们人越多,数书就更快。

Now we get together and add our individual counts. That's reduce.

现在我们到一起,把所有人的统计数加在一起。这就是“Reduce”。

From:http://www.cnblogs.com/vivounicorn/archive/2011/09/20/2182433.html

2491

2491

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?