文献题目:Rethinking Local Perception in Lightweight Vision Transformer(2023)

作者:Qihang Fan1,2

, Huaibo Huang2,3

, Jiyang Guan2,3

, Ran He2,3*

1Tsinghua University, China

2MAIS & CRIPAC, Institute of Automation, Chinese Academy of Sciences, China

3School of Artificial Intelligence, University of Chinese Academy of Sciences, China

摘要:

CloFormer利用上下文感知的局部增强,探索了全局共享权重(在普通卷积操作中常用)与注意力机制中的特定于标记的上下文感知权重之间的关系。为了捕捉高频局部信息,CloFormer引入了一种称为AttnConv的模块,其结合了卷积操作和注意力机制的风格。AttnConv使用共享权重聚合局部信息,并使用精心设计的上下文感知权重增强局部特征。在CloFormer中,AttnConv和使用池化来减少FLOPs的普通注意力机制的组合使模型能够感知高频和低频信息。该研究在图像分类、目标检测和语义分割等任务上进行了广泛的实验,结果表明CloFormer的优越性。

CloFormer的创新点总结如下:

1. 引入AttnConv卷积操作:CloFormer引入了一种名为AttnConv的新型卷积操作,其采用了注意力机制的风格。AttnConv充分利用了共享和上下文感知权重以进行局部感知。此外,它采用了一种比普通局部自注意力更强的非线性方法,增强了上下文感知权重的生成能力。

2. 双分支架构:CloFormer采用了双分支架构,其中一个分支使用AttnConv捕获高频信息,而另一个分支使用带有下采样的普通注意力捕获低频信息。这种双分支结构使CloFormer能够同时捕获高频和低频信息,提升了其整体感知能力。

3. 卓越性能:对图像分类、目标检测和语义分割等领域进行了广泛实验,结果表明CloFormer的性能卓越。值得注意的是,CloFormer在ImageNet1k数据集上仅使用4.2M参数和0.6G FLOPs就达到了77.0%的准确率,远远超过了其他具有相近模型大小和FLOPs的先进模型。

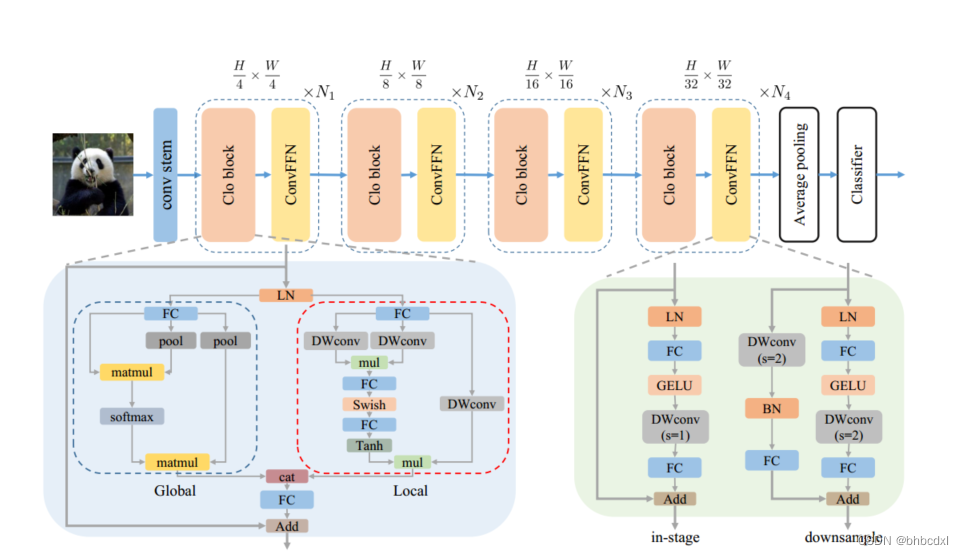

CloFormer由Clo block和ConvFFN串联构成。本地分支中的所有深度卷积的步幅均为 1。

三、方法

3.1.1整体架构

CloFormer 有四个阶段,包括 Clo 块、ConvFFN 和卷积干。我们首先将输入图像通过卷积茎来获得标记。茎由四个卷积组成,每个卷积的步长分别为 2、2、1 和 1。随后,令牌经过 Clo 块和 ConvFFN 的四个阶段来提取层次特征。最后,我们利用全局平均池化和全连接层来生成预测.

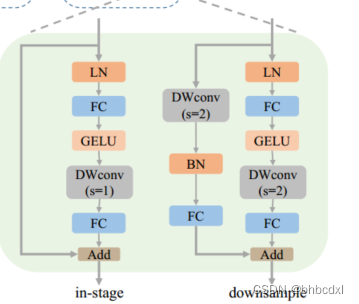

ConvFFN ConvFFN可以直接在内部执行降采样操作,而无需引入PatchMerge模块。CloFormer采用了两种类型的ConvFFN。第一种是阶段内的ConvFFN,它直接利用跳过连接。另一种是连接两个阶段的ConvFFN。在这种类型的ConvFFN的跳过连接中,利用了DWconv和全连接层,分别用于对输入进行降采样和上调维度。(GELU??? DWconv)

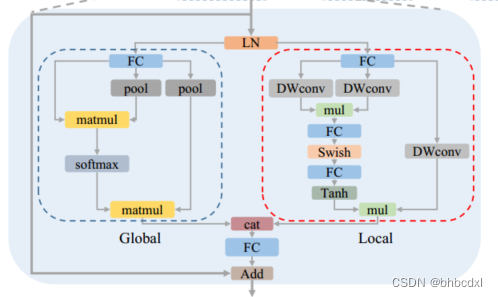

Clo block

每个Clo块由一个本地分支和一个全局分支组成。

如图2所示,我们首先对 K 和 V 进行下采样,然后对 Q、K 和 V 执行标准注意过程以提取低频全局信息:

![]()

除此之外,文中采用自己提出的 AttnConv 作为本地分支

3.2AttnConv

全局分支的模式有效地减少了注意力所需的 FLOP 数量,并且还产生了全局感受野。然而,虽然它有效地捕获低频全局信息,但处理高频局部信息的能力不足。

为了解决这个限制,我们使用 AttnConv 作为解决方案。

AttnConv中,应用与标准注意力相同的线性变换来获得 Q、K 和 V :

基于上面产生的QKV:

对于V,使用简单的深度卷积(DWconv)来聚合局部信息。 DWconv 的权重是全局共享的:

![]()

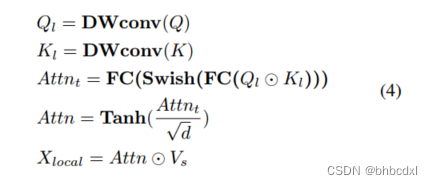

Context-aware Local Enhancement.将 V 的本地信息与共享权重集成后,结合 Q 和 K 来生成上下文感知权重.具体来说,我们首先使用两个 DWconv 分别聚合 Q 和 K 的局部信息.然后,计算 Q 和 K 的 Hadamard 乘积,并对结果进行一系列变换,以获得 -1 和 1 之间的上下文感知权重

整体流程可以概括如下:

为token通道数,⊙表示Hardmard乘积

(非线性的增强指采用tanh swish)

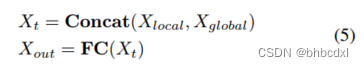

与全局分支机构融合

3.3.本地感知的不同方式

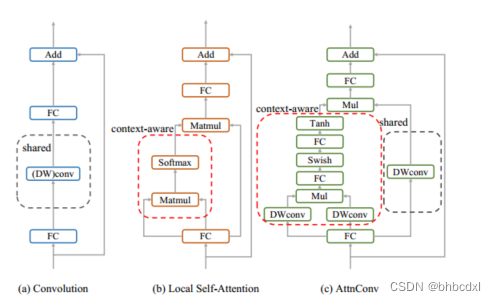

传统的残差块仅依靠卷积算子来收集高频局部信息。如图 3(a) 所示,对于每个标记,卷积算子使用卷积核中的权重对其相邻标记执行加权和。

局部自注意力。与卷积相反,如图 3(b) 所示,局部自注意力使每个标记能够通过标记特定的权重从其相邻标记收集信息。这种方法利用上下文感知权重来提取高频局部表示,其中不同位置的标记计算与相邻标记的相似度分数,并根据相似度分数收集信息

AttnConv。我们在图 3(c) 中描述了 AttnConv。通过线性变换得到Q、K、V后,我们首先使用共享权重(DWconv)对V进行信息聚合。之后,我们使用比传统注意力更强的非线性方法来生成上下文感知权重。然后我们使用这些权重来增强局部特征。在我们的 AttnConv 中,我们利用共享权重和上下文感知权重。

四、实验(略)

没有检索到标题

没有检索到标题

CloFormer提出了一种创新的卷积操作AttnConv,结合全局共享权重和注意力机制,以捕捉高频和低频信息。实验结果显示,CloFormer在多个任务上表现出色,如在ImageNet1k上的77.0%准确率仅用4.2M参数和0.6GFLOPs。

CloFormer提出了一种创新的卷积操作AttnConv,结合全局共享权重和注意力机制,以捕捉高频和低频信息。实验结果显示,CloFormer在多个任务上表现出色,如在ImageNet1k上的77.0%准确率仅用4.2M参数和0.6GFLOPs。

600

600