论文地址:https://arxiv.org/abs/1901.09891

官方代码:https://github.com/tau-yihouxiang/WS_DAN

别人复现的Pytorch版代码1:https://github.com/GuYuc/WS-DAN.PyTorch

别人复现的Pytorch版代码2:https://github.com/wvinzh/WS_DAN_PyTorch

代码讲解:https://codeleading.com/article/15516429831/

好的文章:点击进入

好的文章:点击进入

好的文章:点击进入

好的文章:点击进入

See Better Before Looking Closer: Weakly Supervised Data Augmentation Network for Fine-Grained Visual Classification(看得更清楚再看得更近:用于细粒度视觉分类的弱监督数据增强网络)

前言

之前存在的问题:

通常采用数据增强来增加训练数据量,防止过拟合,提高深度模型的性能。然而,在实际应用中,随机数据增强(如随机图像裁剪)的效率很低,并且可能引入许多不受控制的背景噪声。

在本文中,我们提出弱监督数据增强网络(WS-DAN)来探索数据增强的潜力。

具体做法:

- 对于每个训练图像,我们首先通过弱监督学习生成注意图来表示对象的判别部分。

- 接下来,我们在这些注意图的指导下增强图像,包括注意裁剪和注意下降。

WS-DAN从两个方面提高了分类精度。

- 在第一阶段,由于提取了更多有区别的部分的特征,图像的清晰度会提高。

- 在第二阶段,注意区域提供了物体的准确位置,保证了我们的模型能够更近距离地观察物体,进一步提高了性能。

本文的贡献有以下几点:

- 为了提高数据增强的效率,我们在注意图的基础上提出了注意引导数据增强,包括注意裁剪和注意下降。注意裁剪是随机裁剪和调整注意部分的大小,以增强局部特征的表示。注意下降是随机地从图像中删除一个注意区域,以鼓励模型从多个可区分的部分中提取特征。

网络框架

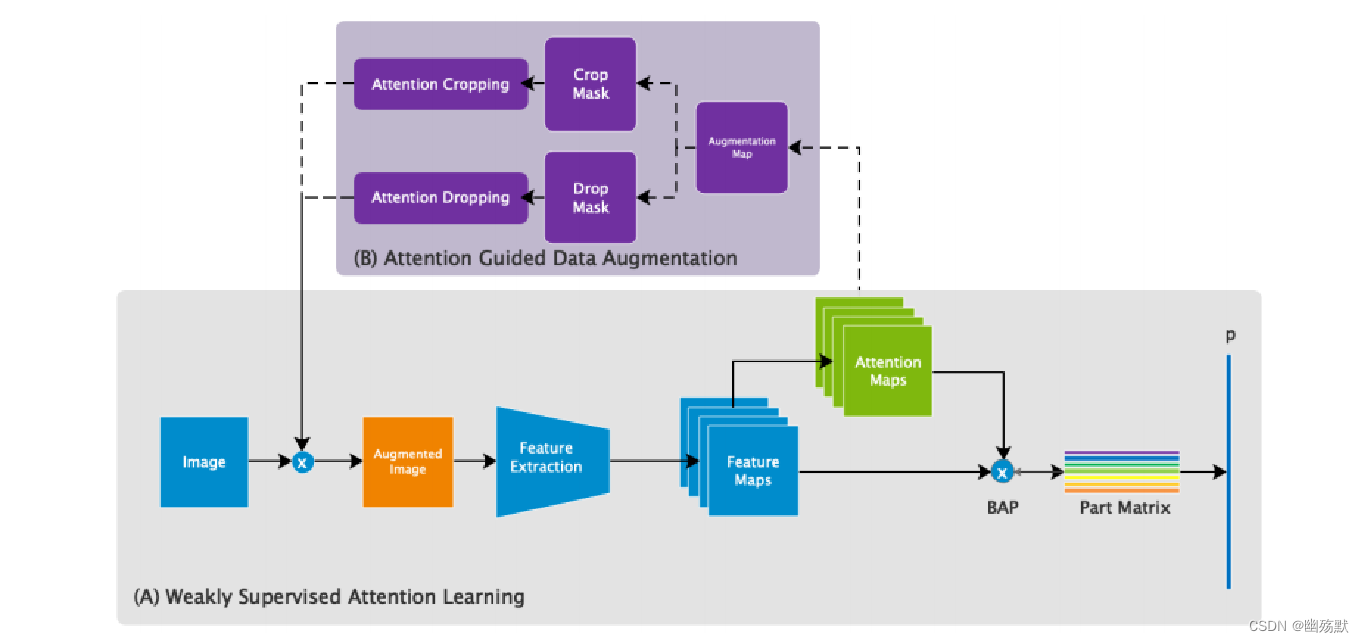

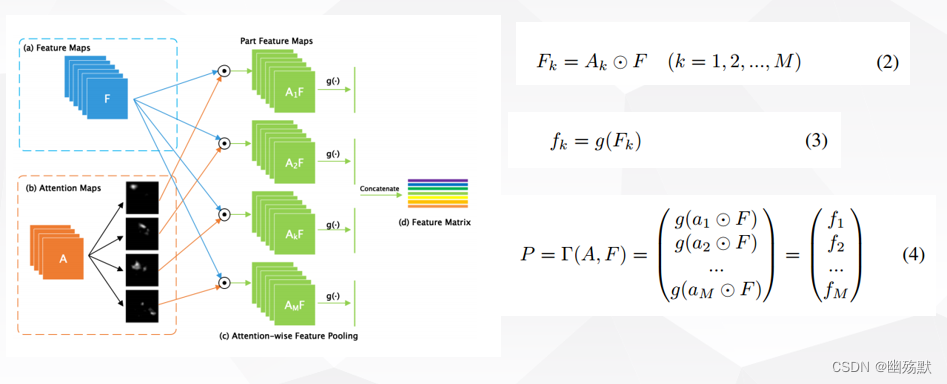

训练阶段的框架图如下所示:

训练的时候是随机抽了一张attention map

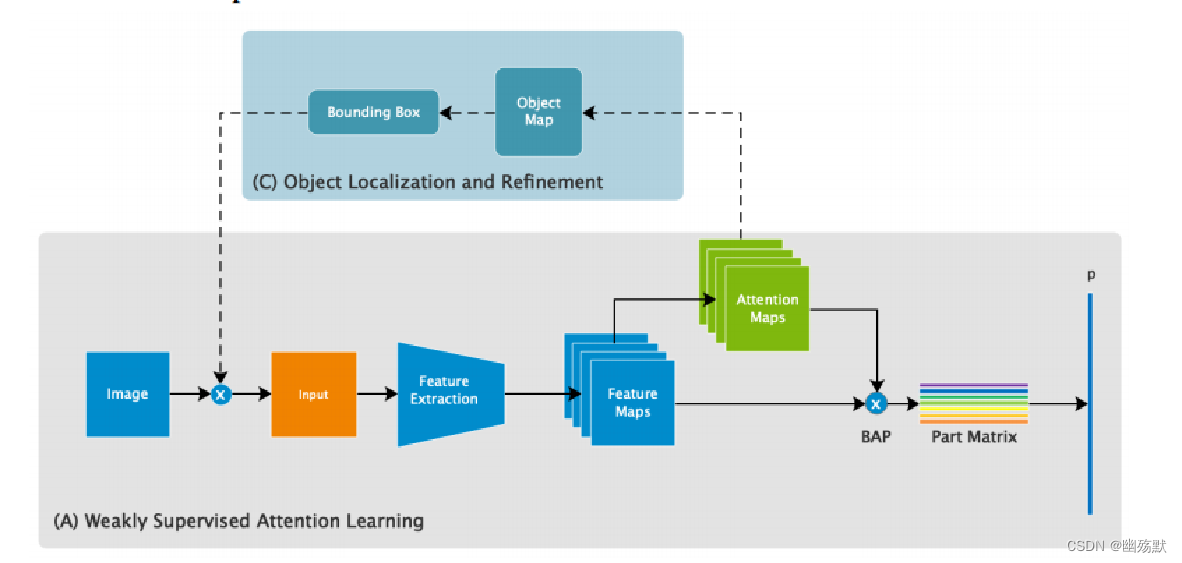

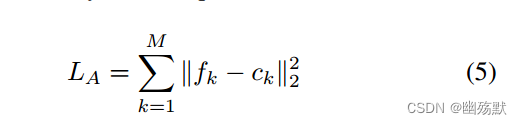

测试阶段的网络架构如下图所示:

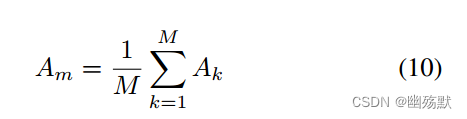

测试的时候是attention map求了个均值,这样做的目的是为了测试的稳定性。

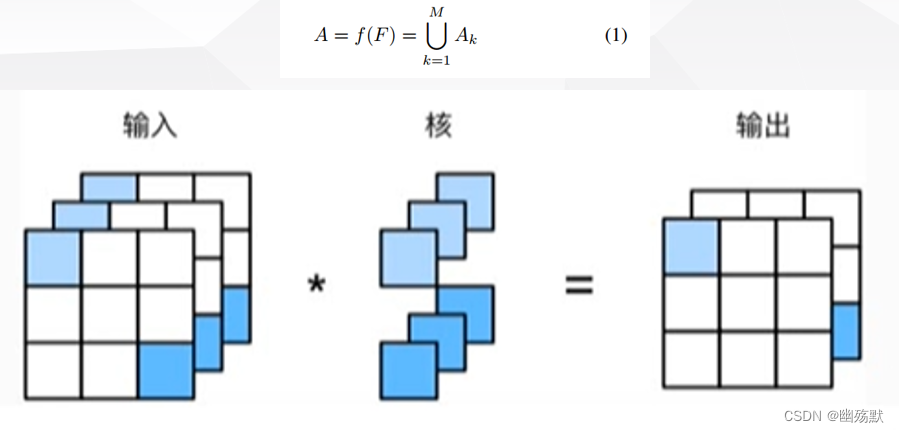

feature maps是一个H×W×C的三维张量,其中H和W分别表示特征图的高度和宽度,C表示特征图的通道数。每个通道都对应着一个特定的特征,例如边缘、纹理、颜色等。因此,特征图中的每个像素都代表着一个局部特征。

在WS-DAN中,每一层的注意力图都代表着不同的物体部位或者纹理特征。例如,在CUB-200-2011数据集中,WS-DAN使用了15个注意力图来表示不同的鸟类部位,例如头部、翅膀、尾巴等。这些注意力图可以用于指导数据增强,从而提高分类的准确性。

部分特征图是通过元素巧妙地将每个注意图与特征图相乘来生成的。

对于每个细粒度的类别,我们期望注意图Ak 可以表示相同的第 k 个对象的部分。部分特征 fk 将接近全局特征中心ck ,其中ck是部分的特征中心。由于第k个目标的部分被从图像中剔除,这将鼓励网络提出其他可判别的部分,这意味着该目标也可以被更好地看到。

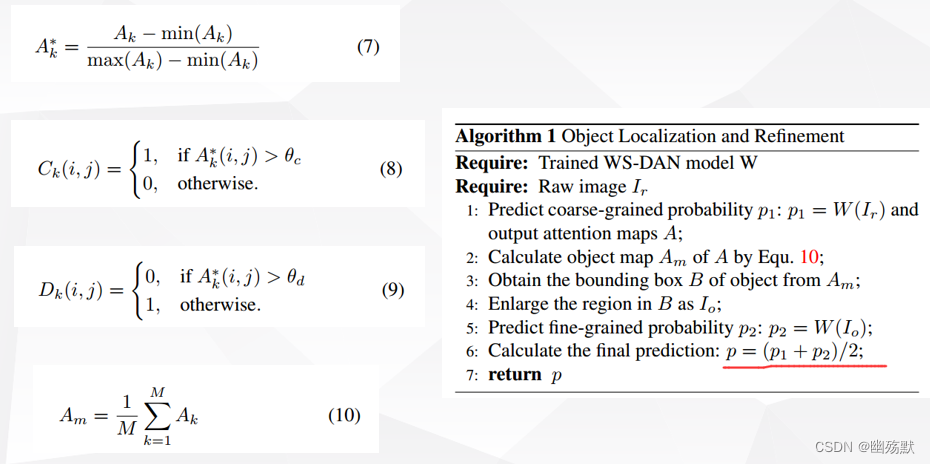

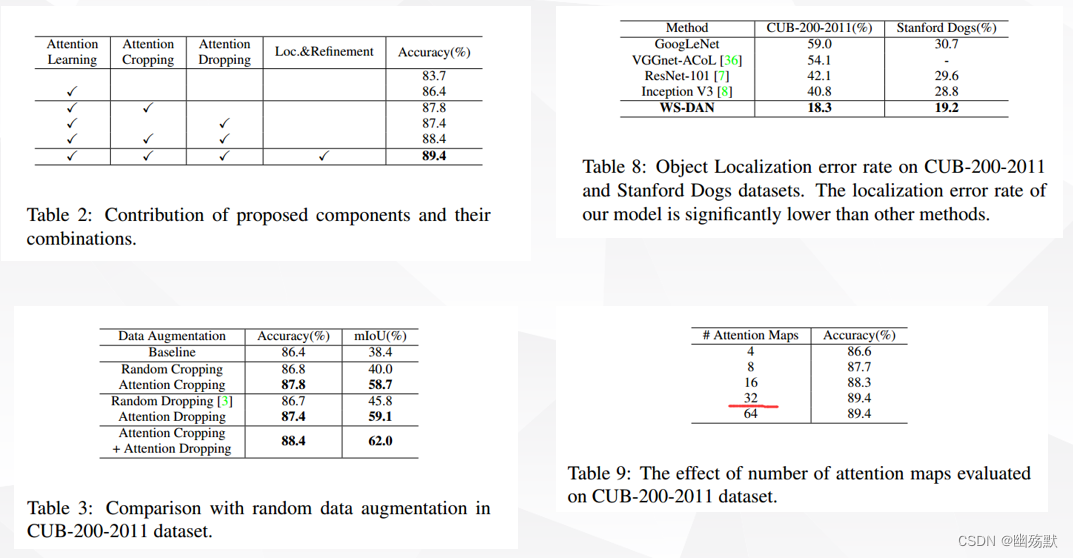

消融实验

本文提出了一种弱监督数据增强网络(WS-DAN),通过生成注意图来指导数据增强,解决随机数据增强的效率低下和背景噪声问题。WS-DAN通过注意裁剪和注意下降提高图像清晰度和模型性能。训练和测试阶段的网络架构详述,并通过消融实验验证其有效性。

本文提出了一种弱监督数据增强网络(WS-DAN),通过生成注意图来指导数据增强,解决随机数据增强的效率低下和背景噪声问题。WS-DAN通过注意裁剪和注意下降提高图像清晰度和模型性能。训练和测试阶段的网络架构详述,并通过消融实验验证其有效性。

6713

6713

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?