交叉熵损失函数Cross-entropy loss及比较

交叉熵和Sigmoid

sigmoid一般在神经网络中作为激活函数,交叉熵作为损失函数。

但是交叉熵可以由sigmoid推导而来。

交叉熵和对数损失函数

两者本质上没有差别。

交叉熵和极大似然函数

联系:交叉熵可由极大似然函数在伯努利分布的条件下推导出来,最小化交叉熵函数的本质就是对数似然函数的最大化。

区别:交叉熵函数使用来描述模型预测值和真实值的差距大小,越大代表越不相近;似然函数是衡量在某个参数下,整体的估计和真实的情况一样的概率,越大代表越相近。

交叉熵和平方差损失函数

交叉熵损失函数当误差大的时候,权重更新快;当误差小的时候,权重更新慢。

而平方差损失函数更新权重受导数的影响,导数在z取大部分值时会很小,几乎平坦,导致w和b更新非常慢。

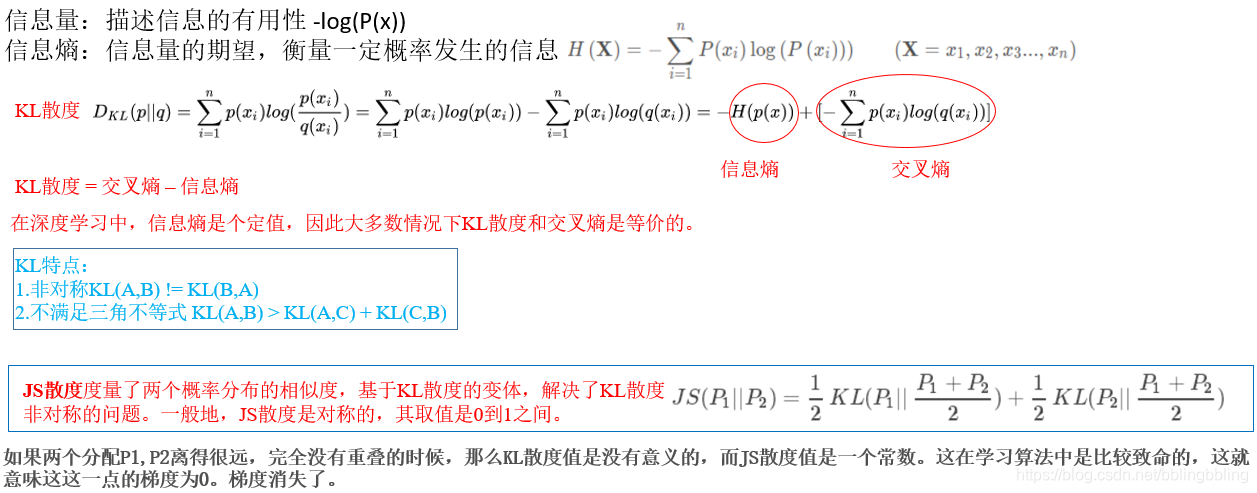

交叉熵和KL散度、JS散度

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?