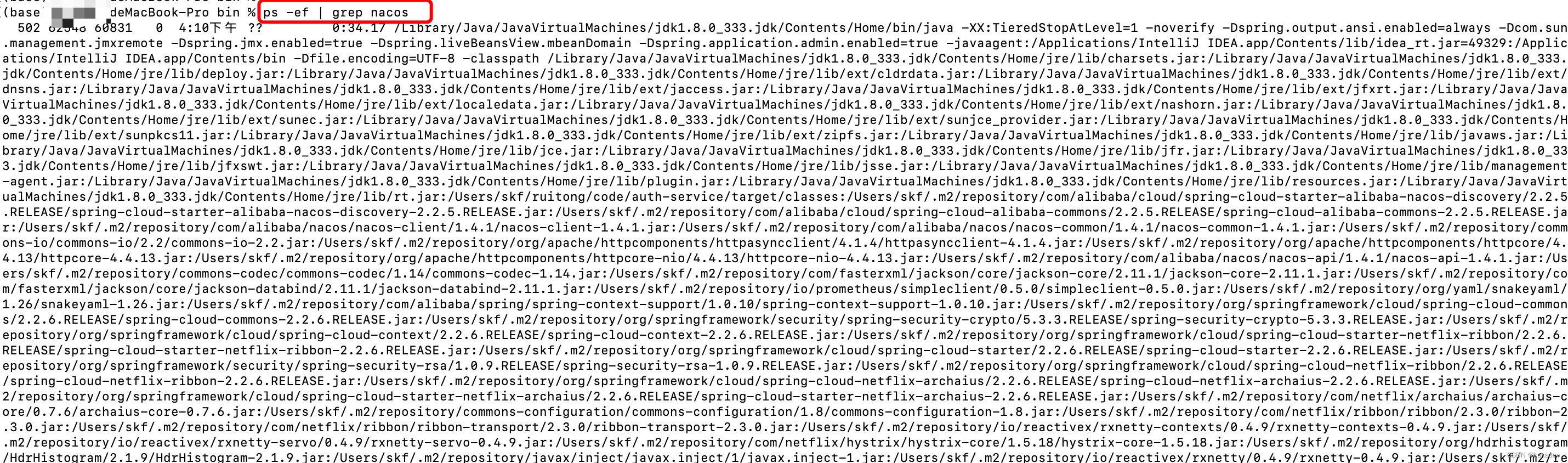

例如这种的一大片,不易读。

有两种办法。

1,使用setterm命令

在Linux中,您可以使用setterm命令来禁止或恢复终端的自动换行功能。

要禁止终端的自动换行功能,可以使用以下命令:

vbnetCopy code

setterm -linewrap off

要恢复终端的自动换行功能,可以使用以下命令:

csharpCopy code

setterm -linewrap on

请注意,这些命令将会影响整个终端会话,包括所有后续执行的命令的输出。如果您只想在当前命令的输出中禁止或恢复自动换行功能,可以使用命令本身提供的选项或管道输出到less命令并手动滚动查看输出结果。例如:

bashCopy code

ls -l | less -S

这将使用ls -l命令的输出结果,并通过管道将其传递给less命令。-S选项将禁用less命令的自动换行功能,因此您可以手动滚动查看输出结果。

2,tput命令

如果您的Linux系统上没有setterm命令,则可以尝试使用tput命令来禁用或启用终端的自动换行功能。

要禁用自动换行功能,请使用以下命令:

Copy code

tput rmam

要恢复自动换行功能,请使用以下命令:

Copy code

tput smam

同样地,这些命令将影响整个终端会话,包括所有后续执行的命令的输出。

如果您只想在当前命令的输出中禁用或恢复自动换行功能,可以将命令输出重定向到文件中,然后使用less命令手动滚动查看文件内容,例如:

luaCopy code

ls -l > output.txt less -S output.txt

这将使用ls -l命令的输出结果,并将其重定向到output.txt文件中。然后,您可以使用less命令打开文件并手动滚动查看输出结果。-S选项将禁用less命令的自动换行功能。

文章介绍了在Linux环境中如何使用setterm和tput命令来控制终端的自动换行功能。用户可以通过这两个命令禁止或恢复自动换行,或者在特定命令输出中进行调整,如通过管道传递给less命令以手动滚动查看。这对于处理长行输出或保持终端整洁非常有用。

文章介绍了在Linux环境中如何使用setterm和tput命令来控制终端的自动换行功能。用户可以通过这两个命令禁止或恢复自动换行,或者在特定命令输出中进行调整,如通过管道传递给less命令以手动滚动查看。这对于处理长行输出或保持终端整洁非常有用。

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?