需要应用于数据的最重要的转换之一是特征缩放(feature scaling)。除了少数例外,当输入的数字属性有非常不同的尺度时,机器学习算法表现不佳。

有两种常见的方法可以使所有属性具有相同的缩放:最小-最大缩放和标准化。

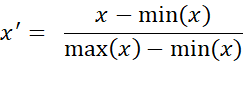

最小最大缩放(Min-max scaling):

许多人称之为归一化(normalization),是最简单的特征缩放方法。数值被移动和重新缩放,使其最终的范围限制在0到1范围内。我们通过减去最小值,再除以最大值减去最小值来实现。

Scikit-Learn为此提供了一个名为MinMaxScaler的转换器。它有一个feature_range超参数,如果出于某种原因,您不想要0-1,它允许您更改范围。

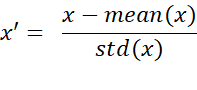

标准化(standardization):

首先它减去平均值(因此标准化值的平均值总是零),然后除以标准差,这样得到的分布就有单位方差。与最小最大缩放不同,标准化不会将值限定在一个特定的范围内,这对于一些算法来说可能是个问题(例如,神经网络通常期望输入值在0到1之间)。然而,标准化受离群值的影响要小得多。

Scikit-Learn提供了一个称为Standardscaler的转换器,用于标准化。

903

903

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?