学习目标:

在短时间内编写一个可以爬取我们需要资源的简单爬虫脚本

需要准备的环境与资源:

1、 搭建 python 开发环境(本人的环境是PyCharm Community Edition 2020.2.3 x64此软件免费且方便,可以满足大部分python开发需求,这不还有很多第三方库吗?)

2、 掌握 一定的python基本语法

等不了了,tmd还不快上车?!:

所谓python爬虫从入门到入狱,首先我们第一步要了解爬虫是不是都合法呢?放心!咱层次还很浅,大鱼们犯不着跑到浅水吃咱,不过倒是有很多案例,同学们可以在网上搜索一下。总的来说还是安全上网吧。

学习离不开实践咱们就以最基础的开始吧:

想要抓取网页,我们得让“爬虫”知道这个网页到底在哪里,下面我们将使用urllib下载URL

import urllib.request

reponse = urllib.request.urlopen('http://ww.baidu.com')

print(reponse.read().decode('utf-8'))

这是一个简单网页获取程序的代码

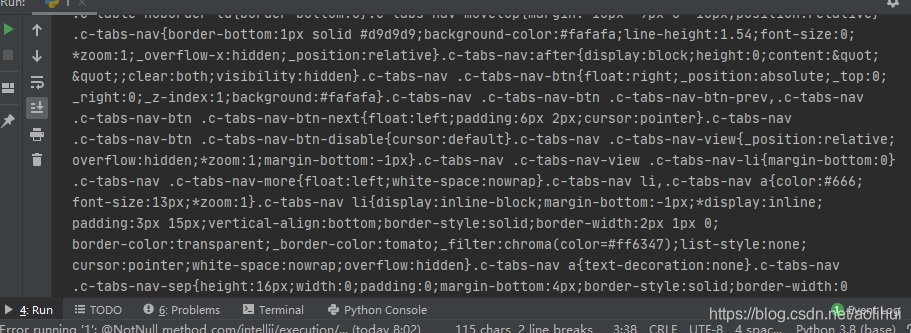

你们会看到这样的结果,家人们可以先敲着练练手

有的同学一个会遇见一些困难其中之一便是urllib库的无定义,这怎么解决呢。你可以下载Anaconda3这是一个python的第三方库软件,里面附带了很多的科学计算的第三方库,但很多同学不会下载在此我附带了链接各各位家人Anaconda3密码:1135

其次是编写错误这在下就没有办法了,您耗子喂汁吧!!!!不会多打几遍吗?

这只是基础你们还有很多要学,明白吗?

我们的目标是做大做强,共创辉煌。

好了我们今天其实已经完成任务了,但是你就不能多学一点吗?

别走!!!!你要学的我这还有

import bs4 import BeautifulSoup

# 网页解析

import re

# 正则表达式,进行文字的匹配

import urllib.request, urllib.error

# 指定url,获取网页数据

import xlwt

# 进行excel操作

import sqlite3

# 进行sqlite数据库操作

这是我们做大做强需要引用的库

import bs4

# 网页解析

import re

# 正则表达式,进行文字的匹配

import urllib.request, urllib.error

# 指定url,获取网页数据

import xlwt

# 进行excel操作

import sqlite3

# 进行sqlite数据库操作

def main():

baseurl = "http://movie.douban.com/top250?start="

#1.爬取网页

datalist = getData(baseurl)

savepath = ".\\豆瓣电影top250.xls"

#保存数据

saveData(savepath)

#爬取网页

def getData(baseurl):

datalist= []

# 2.逐一解析数据

return datalist

def saveData(savepath):

print(',....')

if __name__ == '__main__':

main()

好了好了今天就到这

161

161

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?