本文介绍清华大学等机构提出的统一策略梯度估计器(UPGE)框架,首次从理论层面统一了监督微调(SFT)与强化学习(RL)两种大模型后训练方法。基于此设计的混合后训练算法(HPT)能根据模型性能自适应切换学习策略,在数学推理任务上超越现有方法7个百分点。研究证明SFT与RL本质上是同一优化目标在不同条件下的体现,为LLM后训练提供了理论基础和实用方案。

前排提示,文末有大模型AGI-优快云独家资料包哦!

引言

在大语言模型(LLM)能力持续突破的背景下,提升其在数学推理、复杂问题解决等长逻辑链任务上的表现,是学术界与工业界的核心议题。目前,主流的后训练(Post-Training)方法分为两类:

- 监督微调(Supervised Fine-Tuning, SFT):基于人类编写的高质量示范答案进行模仿学习。此方法收敛稳定,但模型易过拟合于示范数据分布,泛化能力受限。

- 强化学习(Reinforcement Learning, RL):通过与环境交互并根据奖励信号进行策略优化。此方法具备探索更优解的潜力,但训练过程通常不稳定,且在奖励稀疏时学习效率低下。

将SFT与RL相结合是一个符合直觉的优化方向。然而,现有的混合方法多采用对二者损失函数进行简单加权求和的方式,缺乏坚实的理论基础来解释其内在关联。SFT与RL的优化目标在根本上是互补还是冲突?这一问题尚待解答。

击下方卡片,关注“AI前沿速递”公众号

各种重磅干货,第一时间送达

论文:Towards a Unified View of Large Language Model Post-Training

链接:https://arxiv.org/abs/2509.04419

本文介绍一篇由清华大学等机构合作完成的论文,该工作首次从理论层面统一了SFT与RL的优化目标。论文提出了统一策略梯度估计器(Unified Policy Gradient Estimator, UPGE),并基于此设计了一种混合后训练算法(Hybrid Post-Training, HPT)。HPT能根据模型的实时性能表现,自适应地选择学习策略。实验结果表明,HPT在多个数学推理基准上取得了超越现有最佳方法的性能,并验证了其对不同模型规模的有效性。

这项工作不仅是一次技术实践的成功,更提供了一个深刻的理论视角:SFT与RL并非相互独立,而是可以被视为同一优化目标在不同条件下的具体实现。

背景与动机:现有方法的局限与理论空白

监督微调(SFT)与强化学习(RL)的内在局限

- SFT:作为一种模仿学习,SFT使模型能快速掌握特定任务的解决范式。其主要缺陷是泛化能力不足,模型倾向于复现训练数据中见过的模式,对分布外(Out-of-Distribution)问题的处理能力较差。

- RL:作为一种试错学习,RL通过奖励驱动的探索来发现新的、可能更优的策略。其挑战在于训练的稳定性和效率,特别是在模型初始能力较弱时,难以获得正向奖励信号,导致学习过程停滞或收敛至次优策略。

现有混合方法的理论不足

已有的混合方法(如LUFFY, SRFT)通过静态权重或基于熵等指标的启发式规则来组合SFT与RL损失。尽管这些方法在实践中取得了一定的效果,但它们未能从根本上回答以下问题:

- 两种异构的损失函数为何可以线性组合?

- 最优的混合策略应如何确定?

- SFT与RL是否指向一个共同的优化目标?

论文指出,只有在梯度层面建立统一框架,才能从根本上理解和分析这些方法的内在联系与差异。

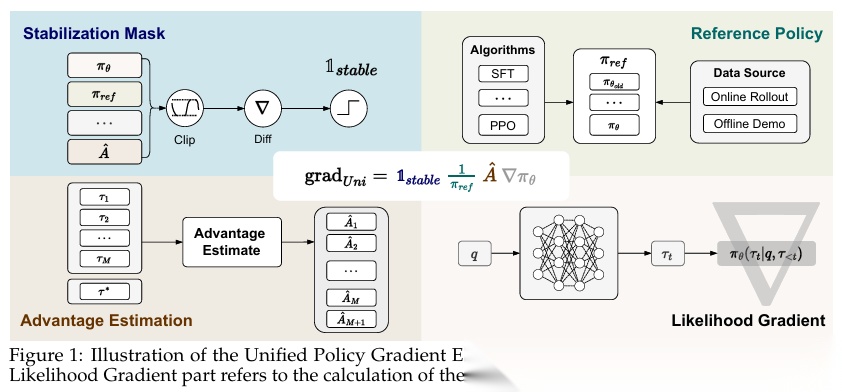

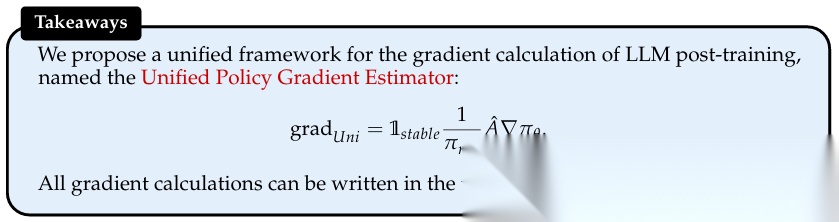

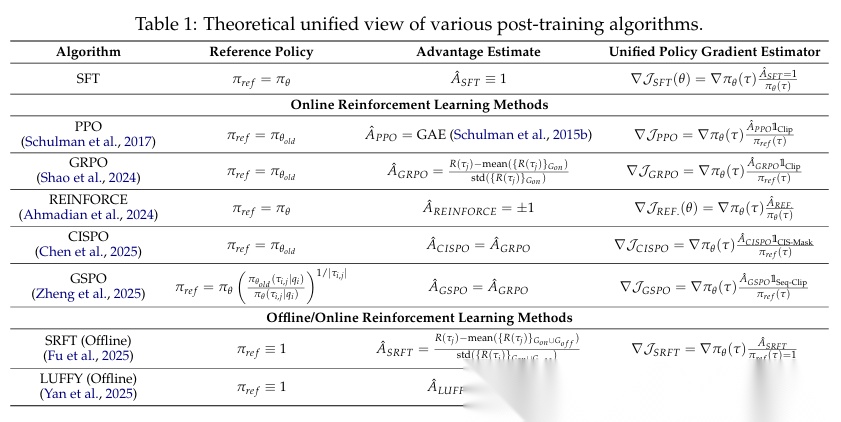

核心理论:统一策略梯度估计器(UPGE)

UPGE的通用形式

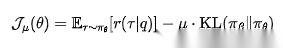

论文提出了一个能够涵盖SDE、RL及混合方法的统一策略梯度形式:

这个公式可以理解为:梯度 = 稳定性控制 × 重要性权重 × 优势信号 × 策略更新方向。

核心组件分析

- 稳定性掩码 (M(τ))

- 功能:控制策略更新的步长,防止因梯度更新过大而导致的模型性能崩溃。

- 示例:PPO算法中的

clip操作即为一种典型的稳定性掩码。

- 参考策略分母 (Q(a|s))

- 功能:对不同token的梯度进行加权,调整其在更新中的重要性。

- 示例:SFT使用当前策略

π(a|s),倾向于放大低概率token的梯度;PPO使用旧策略π_old(a|s)以限制更新幅度。

- 优势估计 (A(τ))

- 功能:评估一个生成序列相对于基线(Baseline)的优劣程度。

- 示例:SFT中,所有示范样本的优势值

A(τ)可视为1;RL中通常采用归一化的奖励值,如GRPO中基于组内排序的优势。

- 似然梯度 (∇θ log π(a|s))

- 功能:策略梯度方法的基础,负责将计算出的梯度信号反向传播至模型参数。所有方法共享此项。

从共同优化目标推导UPGE

本文的核心理论贡献在于证明了SFT与RL均可被视为对同一个联合目标函数的优化: 该目标函数包含两项:

该目标函数包含两项:

- 第一项是期望奖励最大化(RL的目标);

- 第二项是与示范策略的KL散度最小化(SFT的目标)。

通过对该联合目标进行梯度推导并应用重要性采样,即可导出UPGE的通用形式。这揭示了SFT与RL本质上是同一优化目标在不同数据分布假设和侧重点下的具体体现。

梯度分量与偏差-方差权衡

不同算法对UPGE四个组件的选择,反映了其在**偏差(Bias)与方差(Variance)**之间的权衡:

- SFT:依赖于固定的示范数据,具有低方差和高偏差。

- 在线RL:依赖于模型自身的采样,具有低偏差和高方差。

- PPO等算法:通过引入

clip等机制降低方差,但可能以引入一定偏差为代价。

UPGE框架的价值在于提供了一个模块化的分析工具,允许研究者根据具体任务的需求,通过组合不同组件来设计具有特定偏差-方差特性的新算法。

算法实现:混合后训练(HPT)

基于UPGE理论,论文设计了HPT算法,其核心是一种基于模型自身性能反馈的自适应训练策略。

动态切换机制

- 对每个训练样本,模型生成

k个候选输出。 - 根据外部反馈(如执行结果)计算这

k个输出的正确率r。 - 依据正确率

r与预设阈值r_0的关系,动态选择损失函数:

其中为指示函数。

自适应损失策略

- 当

r ≤ r_0时(模型表现不佳),系统判定模型尚未掌握解决该问题的基本能力,此时采用**SFT损失 (L_SFT)**,强制模型学习高质量的示范答案。 - 当

r > r_0时(模型表现良好),系统认为模型已具备基础能力,此时切换至**RL损失 (L_RL)**,鼓励其通过探索寻找更多或更优的解法。

在实现中,L_RL采用包含clip和优势归一化的Dr. GRPO损失,L_SFT为标准的交叉熵损失。

实验验证与分析

实验设置

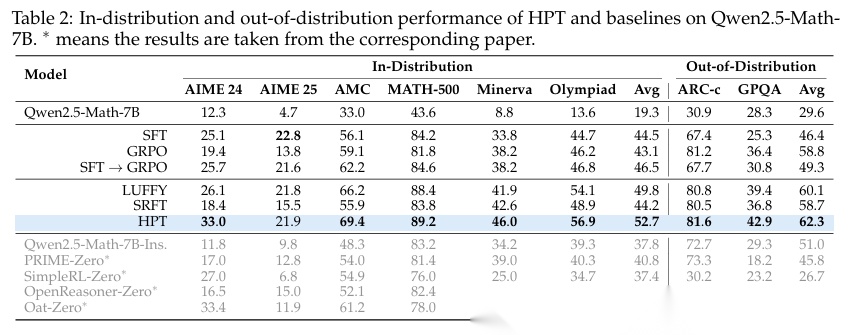

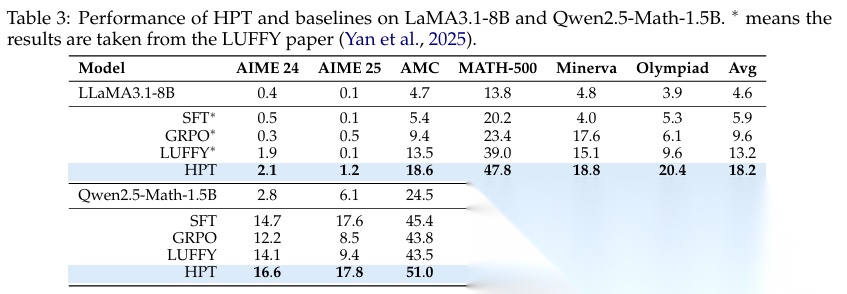

- 模型:覆盖Qwen2.5-Math-1.5B/7B、LLaMA3.1-8B等不同规模。

- 基准:包括AIME、MATH等6个数学推理数据集,以及ARC-c、GPQA两个分布外泛化测试集。

- 基线方法:SFT、GRPO(RL)、LUFFY(Offline RL)、SRFT(Hybrid)等。

主要实验结果

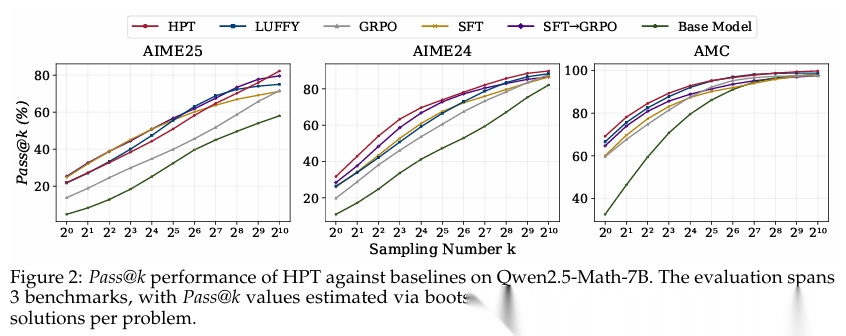

实验数据显示,在几乎所有测试的模型和基准上,HPT均取得了当前最佳(SOTA)性能。特别是在分布外泛化测试集上,HPT的优势尤为突出。例如,在Qwen2.5-Math-7B模型上,HPT在AIME 2024基准上的性能比最强的基线方法高出7个百分点。

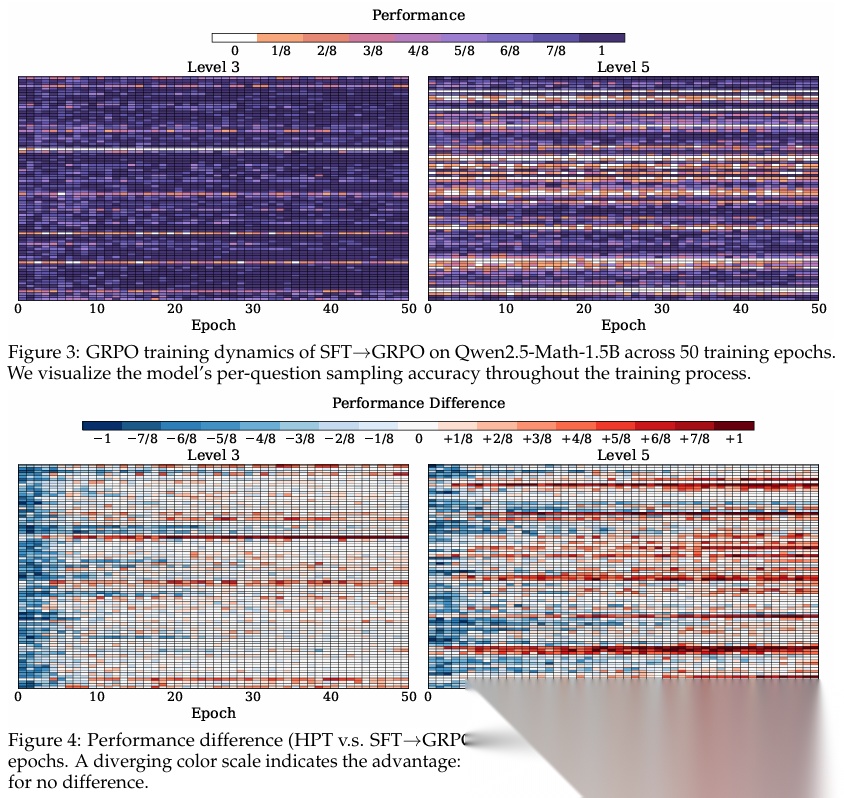

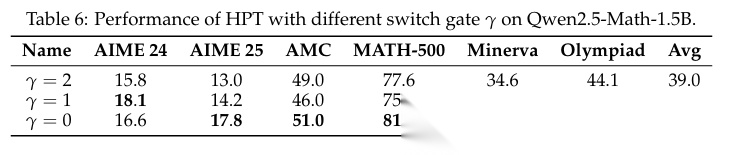

训练动态分析

- 探索与利用的平衡:HPT在提升最佳性能(pass@1)的同时,其多样性指标(pass@1024)也显著高于纯RL方法,表明该算法有效平衡了利用(exploitation)与探索(exploration)。

- 知识的习得与保留:分析表明(见表4),HPT能有效解决更多高难度问题(红色数字),并且不会遗忘已掌握的知识(绿色数字稳定),展现了稳健的学习动态。

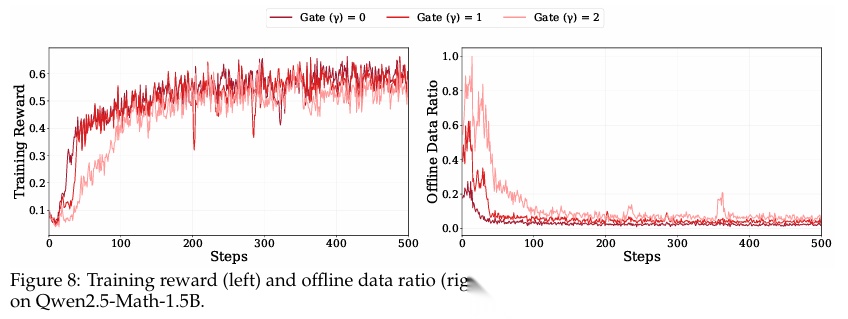

消融实验

- 离线RL与SFT的作用:实验对比发现,在后训练阶段,直接使用SFT的效果优于复杂的离线RL算法(LUFFY)。这说明高质量的示范数据是极其关键的。

- 切换阈值

r_0的影响:r_0 = 0(即仅在模型完全无法正确解答时才使用SFT)的设置取得了最佳效果。这表明应尽早引入RL进行探索,过度依赖SFT会限制模型的性能上限。

讨论与结论

统一视角的理论意义

UPGE框架首次将SFT、在线RL和离线RL等方法的梯度形式统一起来,揭示了它们作为同一联合目标梯度估计器的内在共通性。这为未来设计和分析LLM后训练算法提供了一个坚实的理论基础。

HPT算法的有效性与适应性

HPT的成功验证了自适应训练策略的有效性。其设计优势在于:

- 无需手动配置混合权重,算法根据模型性能自动调整。

- 良好的模型规模扩展性。

- 符合学习认知规律:在模型能力弱时强化模仿学习,在能力强时鼓励探索创新。

结论

本论文通过统一理论框架和创新的算法设计,为解决SFT与RL在LLM后训练中的融合问题提供了系统性方案。UPGE为理解和比较不同方法提供了共同的语言,而HPT则展示了如何基于性能反馈机制实现模仿与探索的动态平衡。未来的研究方向可包括:探索更精细的梯度组件组合策略、将该框架扩展至多模态任务,以及对偏差-方差权衡进行更深入的理论分析。

读者福利:倘若大家对大模型感兴趣,那么这套大模型学习资料一定对你有用。

针对0基础小白:

如果你是零基础小白,快速入门大模型是可行的。

大模型学习流程较短,学习内容全面,需要理论与实践结合

学习计划和方向能根据资料进行归纳总结

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

这里我们能提供零基础学习书籍和视频。作为最快捷也是最有效的方式之一,跟着老师的思路,由浅入深,从理论到实操,其实大模型并不难。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

176

176

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?