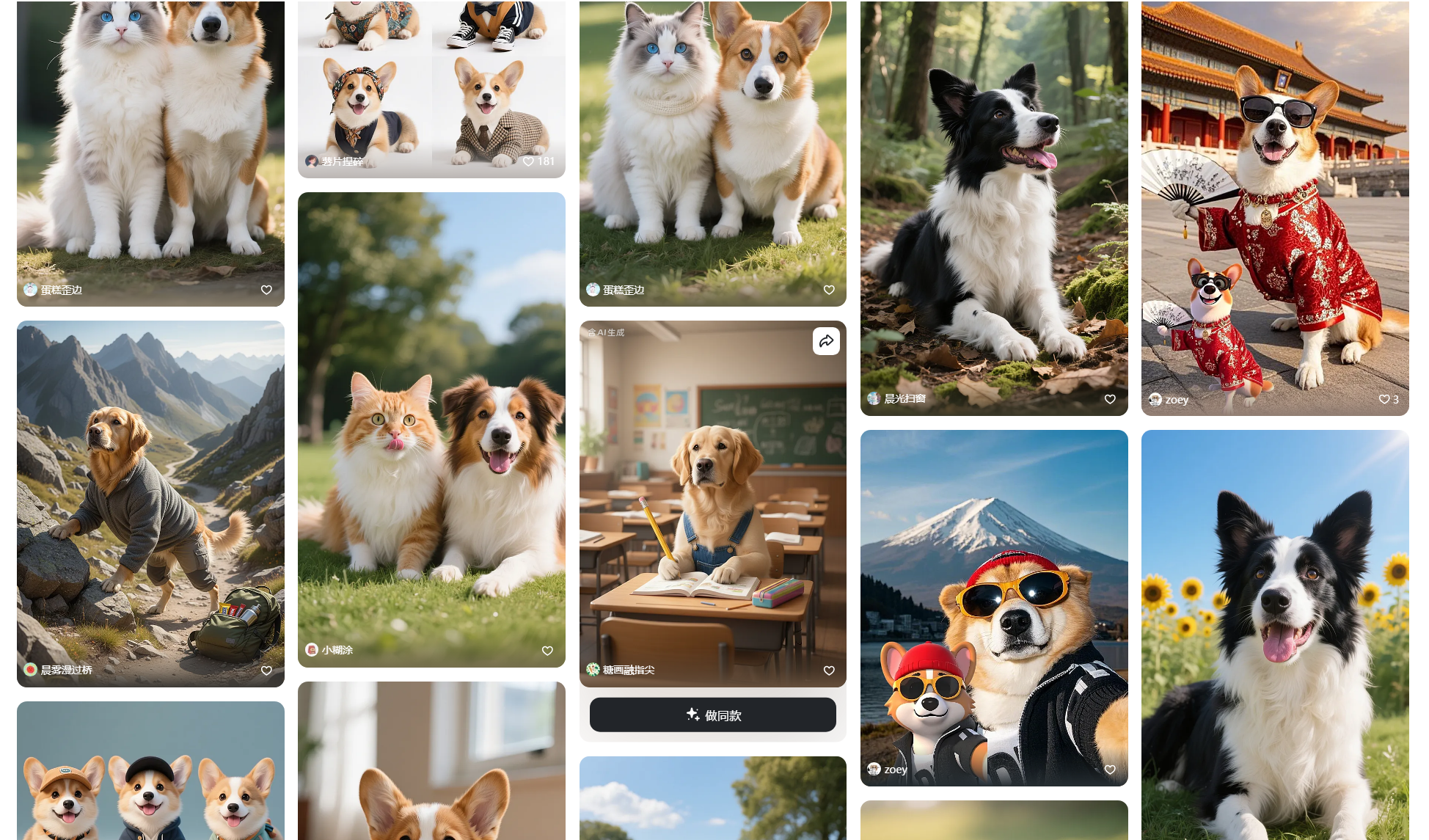

不久前,社交媒体上掀起了一股名为“宠物真人照”的创作热潮。用户们纷纷上传自家猫咪或狗狗的照片,通过AI工具一键生成风格各异、惟妙惟肖的拟人化形象。这些作品时而化身为甜美的二次元少女,时而变身为英姿飒爽的古代将军,其惊人的创造力和高质量的图像输出,让无数网友叹为观止。这并非简单的“一键P图”或滤镜应用,其背后是一套复杂而精密的生成式AI技术栈的协同工作。本文将浅析这些刷屏级宠物真人照的诞生原理,揭开AI生成拟人化图片技术的神秘面纱。

基石技术:扩散模型(Diffusion Models)的演进

要理解宠物拟人化的实现方式,首先必须了解其底层核心技术——扩散模型(Diffusion Models)。目前扩散模型已经成为高质量图像生成领域的绝对主流,其代表模型如Stable Diffusion系列、Midjourney V7以及谷歌的Imagen 3等,都在不断刷新着生成图像的逼真度与艺术性上限。

扩散模型的基本原理可以通俗地理解为一个“先污染,后治理”的过程:

- 前向过程(加噪):模型从一张清晰的真实图像开始,在数十到数千个步骤中,逐步向图像中添加微量的高斯噪声,直到图像最终变成一片纯粹的、无意义的随机噪声。这个过程是固定的、可计算的。

- 反向过程(去噪):这是生成图像的关键。模型学习如何逆转上述过程,即从一张完全随机的噪声图像开始,在同样多的步骤中,逐步地、精细地去除噪声,最终“雕琢”出一张清晰、具体、符合特定要求的全新图像。

AI的“创造力”正体现在这个反向去噪的过程中。它并非简单地还原某张原始图片,而是根据我们给出的“指导”(通常是文本提示词,即Prompt),在去噪的每一步都朝着目标方向进行微调。例如,当我们输入“一只猫”时,模型就会在去噪过程中,将噪声逐渐塑造成符合“猫”这个概念的像素结构。这种从混沌到有序的生成方式,赋予了AI极大的自由度,能够创造出自然界中从未存在过的图像,这正是“宠物拟人化”得以实现的技术基础。

“拟人化”的关键:多模态融合与精细化控制

仅仅依靠基础的扩散模型和简单的文本提示词(如“一个可爱的女孩”)是无法生成与原宠物高度相关的拟人形象的。要实现“神似”,即让生成的虚拟人物在气质、神态、配色甚至特征上都与原宠物保持高度一致,就必须引入更先进的多模态控制技术。当前主流的实现方案,是一个以ControlNet和IP-Adapter为核心的协同控制框架。

第一步:特征提取与语义对齐 - ControlNet与IP-Adapter的协同

这是实现“形神兼备”的第一道关卡,也是最核心的技术环节。AI需要从原始宠物照片中提取出关键信息,并将其作为生成过程中的“强约束”和“软参考”。

ControlNet:骨架与结构的精准复刻

ControlNet(控制网络)是一种革命性的技术,它允许我们从输入图像中提取特定的空间信息(如轮廓、姿态、深度、分割图等),并将其作为额外的控制条件,精确地指导扩散模型的生成过程。在宠物拟人化任务中,它主要扮演以下角色:

- 姿态迁移:通过OpenPose或类似的人体/动物姿态估计算法,ControlNet可以分析出宠物在照片中的身体姿态,例如是蜷缩、站立还是跳跃。然后,它会将这个姿态“骨架”应用到生成的人类角色上,确保生成的虚拟人物与宠物拥有相似的动态或静态姿势。一只慵懒躺倒的猫,通过姿态迁移,可以生成一个同样姿态闲适、侧卧在沙发上的少女,从而在构图和动态上实现第一层“相似”。

- 构图锁定:除了姿态,ControlNet还可以使用Canny边缘检测或线稿提取模型,来锁定原图的整体构图和主体轮廓。这保证了即使物种发生了变化,生成图像的主体位置、大小和与环境的互动关系也能得到保留。

简单来说,ControlNet解决了“画成什么样”的问题,它提供了一个不可撼动的结构性蓝图,确保AI的创作不会天马行空,而是在一个预设的框架内进行。

IP-Adapter:气质与风格的灵魂注入

如果说ControlNet负责“骨相”,那么IP-Adapter(Image Prompt Adapter)则负责“皮相”与“神韵”。IP-Adapter是一种轻量级的适配器模型,它能高效地从一张或多张参考图像中提取出高维度的视觉特征,并将其作为一种特殊的“图像提示”,注入到扩散模型的生成过程中。

在我们的场景中,IP-Adapter会分析原始宠物照片,但它关注的不是姿态或轮廓,而是更抽象的元素:

- 色彩与纹理:它会捕捉宠物毛发的颜色、渐变、斑纹等特征。一只橘猫的照片,经过IP-Adapter处理后,会让生成的角色倾向于拥有橘色或金色的头发、暖色调的衣物,甚至脸上可能出现类似雀斑的可爱点缀。

- 神态与氛围:这是IP-Adapter最神奇的地方。它能捕捉到一些难以用语言描述的感觉,比如一只猫咪高冷、慵懒的眼神,或是一只金毛犬阳光、治愈的微笑。这些抽象的气质信息会被编码,并影响生成人物的面部表情和整体氛围,实现从宠物到人的神态迁移。

ControlNet和IP-Adapter的协同工作,构成了一个强大的控制矩阵。前者保证了结构上的一致性,后者则赋予了作品灵魂和细节上的关联性,二者结合,使得AI在生成一个全新的人类角色的同时,能够最大程度地保留原宠物的核心辨识度。

第二步:风格迁移与概念融合 - LoRA与Dreambooth的定制化力量

有了结构和气质的约束,我们还需要为作品定义一个具体的艺术风格。这就是LoRA(Low-Rank Adaptation)等微调技术大显身手的舞台。

LoRA是一种高效的微调技术,它允许开发者或艺术家在不改变庞大基础模型(如Stable Diffusion)主体权重的前提下,通过训练一个极小的“补丁”模型,来向基础模型中注入新的概念或画风。在宠物拟人化应用中,用户通常可以选择各种预先训练好的LoRA模型,来实现风格的快速切换:

- 画风LoRA:例如,“二次元动漫风格LoRA”、“迪士尼公主风格LoRA”、“赛博朋克写实LoRA”等。加载这些模型后,AI在生成图像时就会严格遵循该LoRA所定义的艺术规范,无论是线条处理、色彩饱和度还是光影效果,都会向特定风格靠拢。

- 角色或服装LoRA:更进一步,还可以使用特定的角色概念LoRA,比如“古代将军铠甲LoRA”或“魔法少女服饰LoRA”,让生成的角色不仅风格统一,还穿上了特定的服装,扮演起特定的角色。

而对于追求极致个性化的专业用户或工作室,他们可能会使用像Dreambooth这样的技术,用自己宠物的多张照片训练一个专属的“概念模型”,让AI彻底“认识”这只独一无二的宠物。这样生成的拟人化角色,其相似度会达到一个前所未有的高度。

从宠物照片到“真人”:一个完整的技术工作流拆解

现在,我们可以将上述所有技术模块串联起来,描绘出一幅完整的“宠物拟人化”生成流程图:

- 输入与预处理:用户上传一张宠物照片。系统后台首先对这张照片进行多维度分析。一个姿态识别模型提取出宠物的骨骼关键点,生成ControlNet所需的姿态控制图;同时,一个边缘检测模型生成轮廓图。另一方面,IP-Adapter模块则“端详”整张图片,将其色彩、纹理和神韵编码成一个特征向量。

- 提示词(Prompt)工程:用户输入基础的文本提示,如“一个美丽的女孩,杰作,最高画质,8K”。系统会自动将这些文本与从IP-Adapter提取的图像提示,以及用户选择的风格(背后是加载了相应的LoRA模型)进行整合,形成一个复杂的多模态指令集。

- 引导生成:扩散模型开始从随机噪声中启动去噪过程。在每一步迭代中,它的行为都会受到来自多个方面的“约束”和“引导”:

- 文本提示告诉它要画一个“女孩”。

- ControlNet用姿态图和轮廓图强制它生成的女孩必须保持和宠物一样的姿势和构图。

- IP-Adapter的特征向量不断“提醒”它,这个女孩的头发应该是金色的,眼神要带点慵懒,整体色调要温暖。

- LoRA模型则确保整个画面的艺术风格是“二次元”的。

- 后期处理与优化:在生成一张初步的图像后,通常还会经过一些自动化后期处理步骤。例如,使用像ESRGAN这样的超分辨率模型,将图像放大并增强细节;使用像CodeFormer或GFPGAN这样的面部修复模型,优化生成人物的面部细节,使其更加清晰和自然。最终,一张高质量的“宠物真人照”便诞生了。

技术挑战与未来展望

尽管当前的技术已经取得了令人惊艳的成果,但在通往完美“拟人化”的道路上,仍存在一些挑战:

- “神似”而非“形似”的瓶颈:目前的技术更擅长复刻颜色、姿态等具体特征,但对于宠物独特的“性格”或“灵魂”的捕捉仍处于初级阶段。如何让AI理解一只狗的“憨厚忠诚”并将其转化为人物表情和气质,是更高层次的语义理解难题。

- 跨物种特征映射的逻辑一致性:如何合乎逻辑地处理那些人类没有的动物特征?比如,猫的胡须、狗的耷拉耳朵、兔子的长耳朵等。目前多数模型会选择忽略或以配饰(如兽耳发卡)的形式体现,但更深度的、符合生物学和美学逻辑的“概念融合”仍有待探索。

展望未来,随着多模态大模型能力的持续增强,我们可以预见一个更加智能和富有创造力的“万物拟人”时代。未来的技术或许能够生成动态的拟人化视频,甚至根据一张宠物照片直接生成可交互的3D虚拟形象。创作过程也将变得更加互动化,用户可能不再是简单地选择风格,而是可以通过自然语言与AI对话,共同“设计”和“塑造”最终的拟人化角色。从刷屏的“宠物真人照”开始,我们正一窥生成式AI在个性化、情感化内容创作领域的巨大潜力,而这,仅仅是一个开始。

1512

1512

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?