1.Application of Deep Reinforcement Learning in Mobie Robot Path Planning

- 传统RL方法依赖于人工提取特征,本文在强化学习的基础上加入深度Q网络(a Deep Q Network)。通过深度Q网络训练状态函数,并输出每个动作相对应的Q。

- 深度Q网络模型:

状态:从环境中采集的原始RGB图像。

动作:机器人可能的移动,即前后左右。

- a Deep Q Network(DQN):

融合深度学习和强化学习。

深度学习:负责表示马尔科夫决策过程的状态。

强化学习:负责把控学习方向。

DQN 算法的主要做法是 Experience Replay(经验回放机制),其将系统探索环境得到的数据储存起来,然后随机采样样本更新深度神经网络的参数。

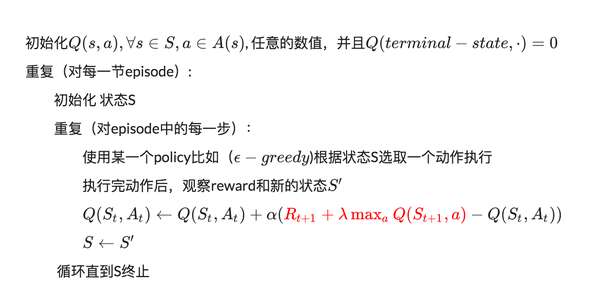

- Q-Learning:

reward值矩阵R,矩阵Q,状态s(图节点),行为a(图中边)。

随机选取状态s和行为a,使用矩阵R,更新矩阵Q。多次计算,最终得到矩阵Q,根据Q即可计算最优路径。

本文介绍了一种结合深度Q网络与强化学习的方法应用于移动机器人的路径规划。通过利用深度Q网络来处理原始RGB图像作为状态输入,并输出对应的动作Q值,实现了无需人工特征提取的过程。该方法采用经验回放机制来提高学习效率。

本文介绍了一种结合深度Q网络与强化学习的方法应用于移动机器人的路径规划。通过利用深度Q网络来处理原始RGB图像作为状态输入,并输出对应的动作Q值,实现了无需人工特征提取的过程。该方法采用经验回放机制来提高学习效率。

7627

7627

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?