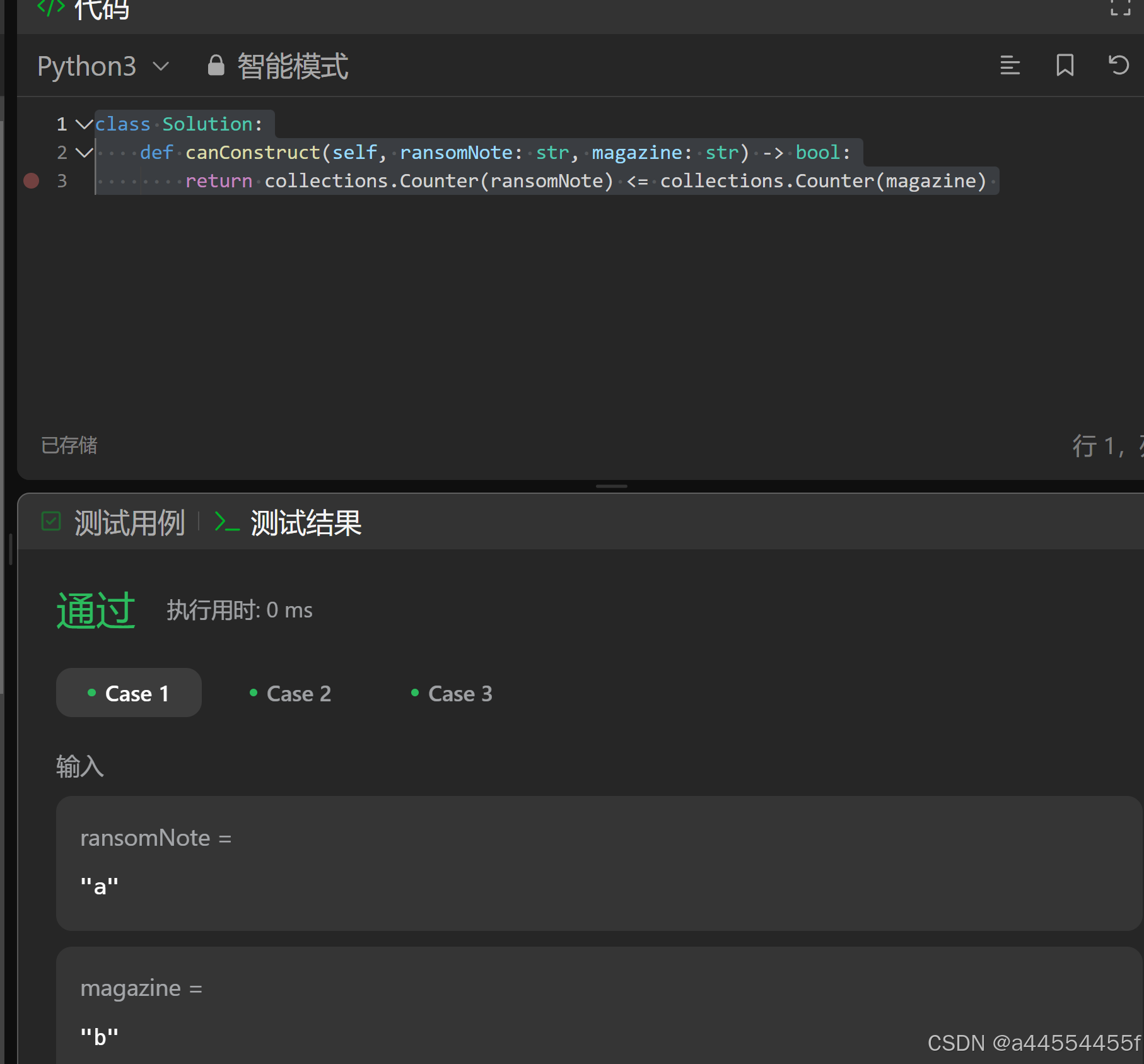

class Solution:

def canConstruct(self, ransomNote: str, magazine: str) -> bool:

return collections.Counter(ransomNote) <= collections.Counter(magazine)

debug:

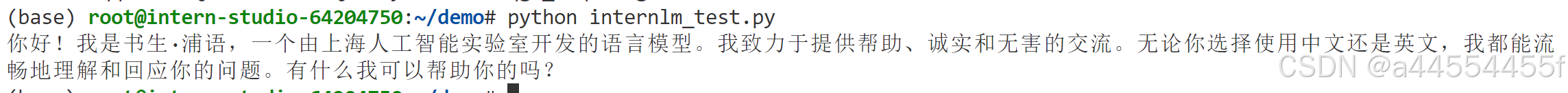

from openai import OpenAI

import json

def internlm_gen(prompt, client):

'''

LLM生成函数

Param prompt: prompt string

Param client: OpenAI client

'''

response = client.chat.completions.create(

model="internlm2.5-latest",

messages=[{"role": "user", "content": prompt}],

stream=False

)

content = response.choices[0].message.content

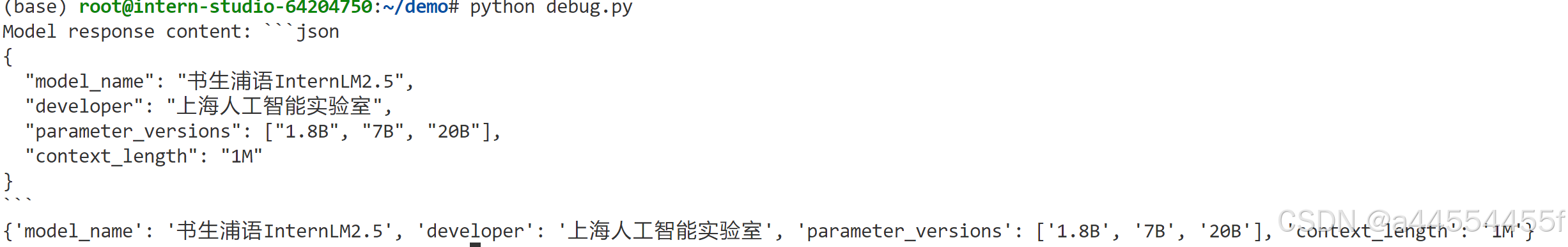

print(f"Model response content: {content}") # 打印返回的内容

# 去除多余的反引号和换行符

cleaned_content = content.strip("```json\n").strip("```")

# 尝试解析响应内容

try:

res_json = json.loads(cleaned_content) # 解析清理后的 JSON 字符串

print(res_json)

except json.JSONDecodeError as e:

print(f"JSON 解析失败: {e}")

api_key =

client = OpenAI(base_url="https://internlm-chat.intern-ai.org.cn/puyu/api/v1/", api_key=api_key)

content = """

书生浦语InternLM2.5是上海人工智能实验室于2024年7月推出的新一代大语言模型,提供1.8B、7B和20B三种参数版本,以适应不同需求。

该模型在复杂场景下的推理能力得到全面增强,支持1M超长上下文,能自主进行互联网搜索并整合信息。

"""

prompt = f"""

请帮我从以下`内的这段模型介绍文字中提取关于该模型的信息,要求包含模型名字、开发机构、提供参数版本、上下文长度四个内容,以json格式返回。

{content}

"""

res = internlm_gen(prompt, client)

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?